Introducción

Finalmente, en esta serie de entradas, veremos temas selectos de álgebra lineal y su aplicación a la resolución de problemas. Primero, hablaremos de sistemas de ecuaciones lineales. Luego, hablaremos de evaluación de determinantes. Después, veremos teoría de formas cuadráticas y matrices positivas. Finalmente, estudiaremos dos teoremas muy versátiles: el teorema de factorización $PJQ$ y el teorema de Cayley-Hamilton.

Como lo hemos hecho hasta ahora, frecuentemente no daremos las demostraciones para los resultados principales. Además, asumiremos conocimientos básicos de álgebra lineal. También, asumiremos que todos los espacios vectoriales y matrices con los que trabajaremos son sobre los reales o complejos, pero varios resultados se valen más en general.

Para cubrir los temas de álgebra lineal de manera sistemática, te recomendamos seguir un libro como el Essential Linear Algebra de Titu Andreescu, o el Linear Algebra de Friedberg, Insel y Spence. Mucho del material también lo puedes consultar en las notas de curso que tenemos disponibles en el blog.

Sistemas de ecuaciones lineales

Una ecuación lineal en $n$ incógnitas en $\mathbb{R}$ consiste en fijar reales $a_1,\ldots,a_n, b$ y determinar los valores de las variables $x_1,\ldots,x_n$ tales que $$a_1x_1+a_2x_2+\ldots+a_nx_n=b.$$

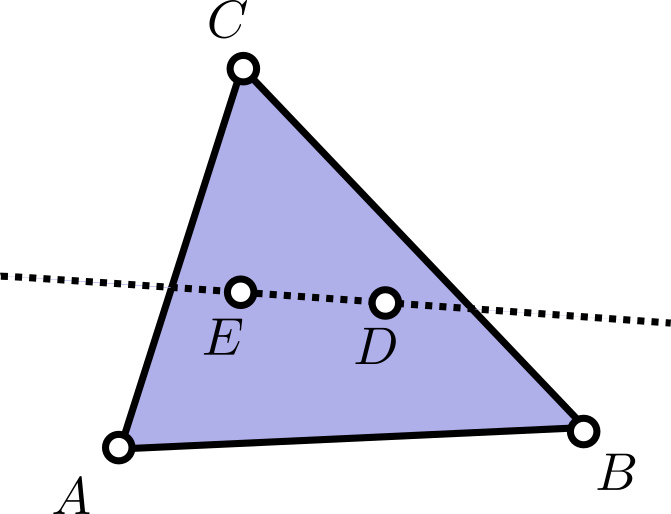

Si $a_1,\ldots,a_n$ no son todos cero, los puntos $(x_1,\ldots,x_n)$ en $\mathbb{R}^n$ que son solución a la ecuación definen un hiperplano en $\mathbb{R}^n$.

Un sistema de ecuaciones lineales con $m$ ecuaciones y $n$ variables consiste en fijar, para $i$ en $\{1,\ldots,m\}$ y $j$ en $\{1,\ldots,n\}$ a reales $a_{ij}$ y $b_i$, y determinar los valores de las variables $x_1,\ldots,x_n$ que simultáneamente satisfacen todas las $m$ ecuaciones

$$\begin{cases}

a_{11}x_1+ a_{12}x_2+\ldots + a_{1n}x_n = b_1\\

a_{21}x_1+a_{22}x_2+\ldots+a_{2n}x_n = b_2\\

\quad \quad \vdots\\

a_{m1}x_1+a_{m2}x_2+\ldots+a_{mn}x_n = b_m.

\end{cases}$$

Este sistema de ecuaciones se puede reescribir en términos matriciales de manera muy sencilla. Si $A$ es la matriz de $m\times n$ de entradas $[a_{ij}]$, $X$ es el vector de variables $(x_1,\ldots,x_n)$ y $b$ es el vector de reales $b_1,\ldots,b_m$, entonces el sistema de ecuaciones anterior se reescribe simplemente como $$AX=b.$$

Sistemas de ecuaciones lineales con mucha simetría

En algunos sistemas de ecuaciones hay mucha simetría, y no es necesario introducir técnicas avanzadas de álgebra lineal para resolverlos. Veamos el siguiente ejemplo.

Problema. Resuelve el sistema de ecuaciones

$$\begin{cases}

7a+2b+2c+2d+2e= -2020\\

2a+7b+2c+2d+2e=-1010\\

2a+2b+7c+2d+2e=0\\

2a+2b+2c+7d+2e=1010\\

2a+2b+2c+2d+7e=2020.

\end{cases}$$

Sugerencia pre-solución. Trabaja hacia atrás, suponiendo que el sistema tiene una solución. A partir de ahí, puedes usar las cinco ecuaciones y combinarlas con sumas o restas para obtener información.

Solución. Al sumar las cinco ecuaciones, obtenemos que $$15(a+b+c+d+e)=0,$$ de donde $2(a+b+c+d+e)=0$. Restando esta igualdad a cada una de las ecuaciones del sistema original, obtenemos que

$$\begin{cases}

5a= -2020\\

5b=-1010\\

5c=0\\

5d=1010\\

5e=2020.

\end{cases}$$

De aquí, si el sistema tiene alguna solución, debe suceder que

\begin{align*}

a&=\frac{-2020}{5}=-404\\

b&=\frac{-2020}{5}=-202\\

c&=\frac{-2020}{5}= 0\\

d&=\frac{-2020}{5}=202\\

e&=\frac{-2020}{5}=404.

\end{align*}

Como estamos trabajando hacia atrás, esta es sólo una condición necesaria para la solución. Sin embargo, una verificación sencilla muestra que también es una condición suficiente.

$\square$

Sistemas de ecuaciones de n x n y regla de Cramer

Si tenemos un sistema de $n$ variables y $n$ incógnitas, entonces es de la forma $$AX=b$$ con una matriz $A$ cuadrada de $n\times n$. Dos resultados importantes para sistemas de este tipo son el teorema de existencia y unicidad, y las fórmulas de Cramer.

Teorema (existencia y unicidad de soluciones). Si $A$ es una matriz cuadrada invertible de $n\times n$ y $b$ es un vector de $n$ entradas, entonces el sistema lineal de ecuaciones $$AX=b$$ tiene una solución única y está dada por $X=A^{-1}b$.

El teorema anterior requiere saber determinar si una matriz es invertible o no. Hay varias formas de hacer esto:

- Una matriz cuadrada es invertible si y sólo si su determinante no es cero. Más adelante hablaremos de varias técnicas para evaluar determinantes.

- Una matriz cuadrada es invertible si y sólo si al aplicar reducción gaussiana, se llega a la identidad.

- También ,para mostrar que una matriz es invertible, se puede mostrar que cumple alguna de las equivalencias de invertibilidad.

Problema. Demuestra que el sistema lineal de ecuaciones

$$\begin{cases}

147a+85b+210c+483d+133e= 7\\

91a+245b+226c+273d+154e=77\\

-119a+903b+217c+220d+168e=777\\

189a+154b-210c-203d-108e=7777\\

229a+224b+266c-133d+98e=77777.

\end{cases}$$

tiene una solución única.

Sugerencia pre-solución. Reduce el problema a mostrar que cierta matriz es invertible. Para ello, usa alguno de los métodos mencionados. Luego, para simplificar mucho el problema, necesitarás un argumento de aritmética modular. Para elegir en qué módulo trabajar, busca un patrón en las entradas de la matriz.

Solución. Primero, notemos que el problema es equivalente a demostrar que la matriz

$$A=\begin{pmatrix}

147 & 85 & 210 & 483 & 133\\

91 & 245 & 226 & 273 & 154\\

-119 & 903 & 217 & 220 & 168\\

189 & 154 & -210 & -203 & -108 \\

229 & 224 & 266 & -133 & 98

\end{pmatrix}$$

es invertible. Mostraremos que su determinante no es $0$. Pero no calcularemos todo el determinante, pues esto es complicado.

Notemos que como $A$ es una matriz de entradas enteras, entonces su determinante (que es suma de productos de entradas), también es entero. Además, como trabajar en aritmética modular respeta sumas y productos, para encontrar el residuo de $\det(A)$ al dividirse entre $7$ se puede primero reducir las entradas de $A$ módulo $7$, y luego hacer la cuenta de determinante.

Al reducir las entradas módulo $7$, tenemos la matriz

$$B=\begin{pmatrix}

0 & 1 & 0 & 0 & 0 \\

0&0 & 2 & 0 & 0\\

0 & 0 & 0 & 3 & 0\\

0&0 & 0 & 0 & 4 \\

5& 0 & 0 & 0 & 0

\end{pmatrix}.$$

El determinante de la matriz $B$ es $-(1\cdot 2 \cdot 3 \cdot 4 \cdot 5)=-120$. Así,

\begin{align*}

\det(A) & \equiv \det(B)\\

&=-120\\

&\equiv 6 \pmod 7.

\end{align*}

Concluimos que $\det(A)$ es un entero que no es divisible entre $7$, por lo cual no puede ser cero. Así, $A$ es invertible.

$\square$

Por supuesto, en cualquier otro módulo podemos hacer la equivalencia y simplificar las cuentas. Pero $7$ es particularmente útil para el problema anterior pues se simplifican casi todas las entradas, y además funciona para dar un residuo no cero.

Ahora veremos otra herramienta importante para resolver problemas de ecuaciones lineales: las fórmulas de Cramer.

Teorema (fórmulas de Cramer). Sea $A$ una matriz invertible de $n\times n$ con entradas reales y $b=(b_1,\ldots,b_n)$ un vector de reales. Entonces el sistema lineal de ecuaciones $AX=b$ tiene una única solución $X=(x_1,\ldots,x_n)$ dada por $$x_i=\frac{\det A_i}{\det A},$$ en donde $A_i$ es la matriz obtenida al reemplazar la $i$-ésima columna de $A$ por el vector columna $b$.

En realidad este método no es tan útil en términos prácticos, pues requiere que se evalúen muchos determinantes, y esto no suele ser sencillo. Sin embargo, las fórmulas de Cramer tienen varias consecuencias teóricas importantes.

Problema. Muestra que una matriz invertible $A$ de $n\times n$ con entradas enteras cumple que su inversa también tiene entradas enteras si y sólo si el determinante de la matriz es $1$ ó $-1$.

Sugerencia pre-solución. Para uno de los lados necesitarás las fórmulas de Cramer, y para el otro necesitarás que el determinante es multiplicativo.

Solución. El determinante de una matriz con entradas enteras es un número entero. Si la inversa de $A$ tiene entradas enteras, entonces su determinante es un entero. Usando que el determinante es multiplicativo, tendríamos que $$\det(A)\cdot \det(A^{-1}) = \det (I) = 1.$$ La única forma en la que dos enteros tengan producto $1$ es si ambos son $1$ o si ambos son $-1$. Esto muestra una de las implicaciones.

Ahora, supongamos que $A$ tiene determinante $\pm 1$. Si tenemos una matriz $B$ de columnas $C_1,\ldots,C_n$, entonces para $j$ en $\{1,\ldots,n\}$ la $j$-ésima columna de $AB$ es $AC_j$. De este modo, si $D_1,\ldots, D_n$ son las columnas de $A^{-1}$, se debe cumplir para cada $j$ en $\{1,\ldots,n\}$ que $$AD_j= e_j,$$ en donde $e_j$ es el $j$-ésimo elemento de la base canónica. Para cada $j$ fija, esto es un sistema de ecuaciones.

Por las fórmulas de Cramer, la $i$-ésima entrada de $C_j$, que es la entrada $x_{ij}$ de la matriz $A^{-1}$, está dada por $$x_{ij}=\frac{\det(A_{ij})}{\det(A)}=\pm \det(A_{ij}),$$ donde $A_{ij}$ es la matriz obtenida de colocar al vector $e_j$ en la $i$-ésima columna de $A$.

La matriz $A_{ij}$ tiene entradas enteras, así que $x_{ij}=\pm \det(A_{ij})$ es un número entero. Así, $A^{-1}$ es una matriz de entradas enteras.

$\square$

Sistemas de ecuaciones de m x n y teorema de Rouché-Capelli

Hasta aquí, sólo hemos hablando de sistemas de ecuaciones que tienen matrices cuadradas asociadas. También, sólo hemos hablado de los casos en los que no hay solución, o bien en los que cuando la hay es única. Los sistemas de ecuaciones lineales en general tienen comportamientos más interesantes. El siguiente resultado caracteriza de manera elegante todo lo que puede pasar.

Teorema (Rouché-Capelli). Sea $A$ una matriz de $m\times n$ con entradas reales, $(b_1,\ldots,b_m)$ un vector de reales y $(x_1,\ldots,x_n)$ un vector de incógnitas. Supongamos que $A$ tiene rango $r$. Entonces:

- El sistema $AX=b$ tiene al menos una solución $X_0$ si y sólo si el rango de la matriz de $m\times (n+1)$ obtenida de colocar el vector $b$ como columna al final de la matriz $A$ también tiene rango $r$.

- El conjunto solución del sistema $AX=(0,0,\ldots,0)$ es un subespacio vectorial $\mathcal{S}$ de $\mathbb{R}^n$ de dimensión $n-r$.

- Toda solución al sistema $AX=b$ se obtiene de sumar $X_0$ y un elemento de $\mathcal{S}$.

Problema. Encuentra todos los polinomios $p(x)$ con coeficientes reales y de grado a lo más $3$ tales que $p(2)=3$ y $p(3)=2$.

Sugerencia pre-solución. Usa notación efectiva, eligiendo variables para cada uno de los coeficientes de $p(x)$. Luego, enuncia cada hipótesis como una ecuación.

Solución. Tomemos $p(x)=ax^3+bx^2+cx+d$. La hipótesis implica que

$$\begin{cases}

8a+4b+2c+d=p(2)= 3\\

27a+9b+3c+d=p(3)=2.

\end{cases}$$

El rango de la matriz $$\begin{pmatrix} 8 & 4 & 2 & 1\\ 27 & 9 & 3 & 1\end{pmatrix}$$ es a lo más $2$, pues tiene $2$ renglones. Pero es al menos $2$, pues los dos vectores columna $(2,3)$ y $(1,1)$ son linealmente independientes. Exactamente el mismo argumento muestra que la matriz aumentada $$\begin{pmatrix} 8 & 4 & 2 & 1 & 3\\ 27 & 9 & 3 & 1 & 2\end{pmatrix}$$ es de rango $2$. Por el primer punto del teorema de Rouché-Capelli, este sistema tiene solución.

Para encontrar esta solución de manera práctica, fijamos reales $a$ y $b$ y notamos que ahora

$$\begin{cases}

2c+d= 3-8a-4b\\

3c+d=2-27a-9b

\end{cases}$$

es un sistema en $2$ variables, y como $$\det\begin{pmatrix} 2 & 1\\ 3 & 1\end{pmatrix}=-1,$$ tiene una única solución para $c$ y $d$. Al hacer las cuentas, o usar fórmulas de Cramer, obtenemos que

\begin{align*}

c&=-1-19a-5b\\

d&=5+30a+6b.

\end{align*}

Así, concluimos que los polinomios $p(x)$ solución consisten de elegir cualesquiera reales $a$ y $b$ y tomar $$p(x)=ax^3+bx^2-(1+19a+5b)x+(5+20a+6b).$$

$\square$

Por supuesto, para usar este teorema es necesario conocer el rango de la matriz $A$. En el problema tuvimos la suerte de que eso es sencillo. Hablaremos más adelante de varias técnicas para encontrar el rango de matrices.

Más problemas

Puedes encontrar más problemas de sistemas de ecuaciones lineales en el Capítulo 3 y en la Sección 7.6 del libro Essential Linear Algebra de Titu Andreescu.