Introducción

En las entradas anteriores demostramos que para cualquier matriz nilpotente existe (y es única) una matriz similar muy sencilla, hecha por lo que llamamos bloques de Jordan de eigenvalor cero. Lo que haremos ahora es mostrar una versión análoga de este resultado para una familia mucho más grande de matrices. De hecho, en cierto sentido tendremos un resultado análogo para todas las matrices.

Pensando en ello, lo que haremos en esta entrada es lo siguiente. Primero, generalizaremos nuestra noción de bloques de Jordan para contemplar cualquier eigenvalor. Estudiaremos un poco de los bloques de Jordan. Luego, enunciaremos el teorema que esperamos probar. Finalmente, daremos el primer paso hacia su demostración. En la siguiente entrada terminaremos la demostración y hablaremos de aspectos prácticos para encontrar formas canónicas de Jordan.

Enunciado del teorema de la forma canónica de Jordan

A continuación definimos a los bloques de Jordan para cualquier eigenvalor y tamaño.

Definición. Sea $F$ un campo. El bloque de Jordan de eigenvalor $\lambda$ y tamaño $k$ es la matriz $J_{\lambda,k}$ en $M_k(F)$ cuyas entradas son todas $\lambda$, a excepción de las que están inmediatamente arriba de la diagonal superior, las cuales son unos. En símbolos, $J_{\lambda,k}=[a_{ij}]$ con $$a_{ij}=\begin{cases} 1 & \text{si $j=i+1$}\\ \lambda & \text{si $i=j$} \\ 0 & \text{en otro caso.} \end{cases}$$

También podemos expresarlo de la siguiente manera:

$$J_{\lambda,k}=\begin{pmatrix} \lambda & 1 & 0 & \cdots & 0 & 0 \\ 0 & \lambda & 1 & \cdots & 0 & 0 \\ 0 & 0 & \lambda & \cdots & 0 & 0 \\ & \vdots & & \ddots & & \vdots \\ 0 & 0 & 0 & \cdots & \lambda & 1 \\ 0 & 0 & 0 & \cdots & 0 & \lambda \end{pmatrix},$$ en donde estamos pensando que la matriz es de $k\times k$.

Una última manera en la que nos convendrá pensar a $J_{\lambda,k}$ es en términos de los bloques de Jordan de eigenvalor cero: $J_{\lambda,k}=\lambda I_k + J_{0,k}$.

Definición. Una matriz de bloques de Jordan en $M_n(F)$ es una matriz diagonal por bloques en la que cada bloque en la diagonal es un bloque de Jordan.

Lo que nos gustaría demostrar es el siguiente resultado. En él, piensa en $\leq$ como algún orden total fijo de $F$ (para $\mathbb{R}$ es el orden usual, pero otros campos no necesariamente tienen un orden natural asociado).

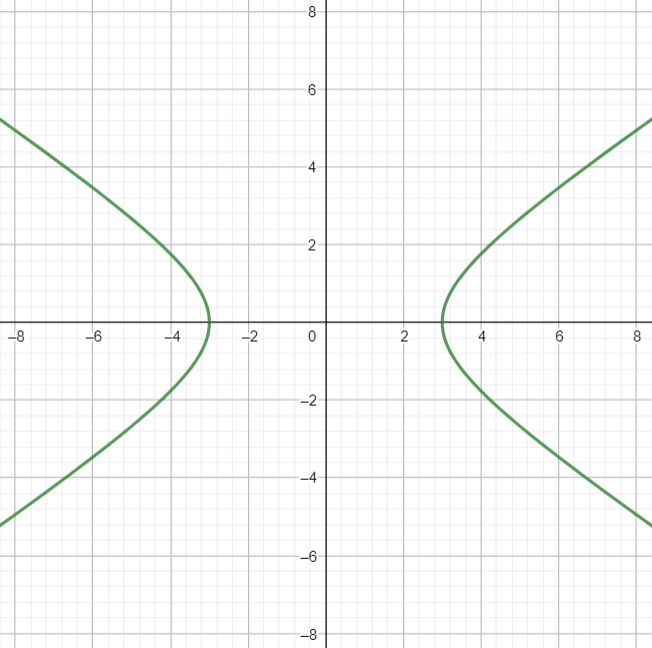

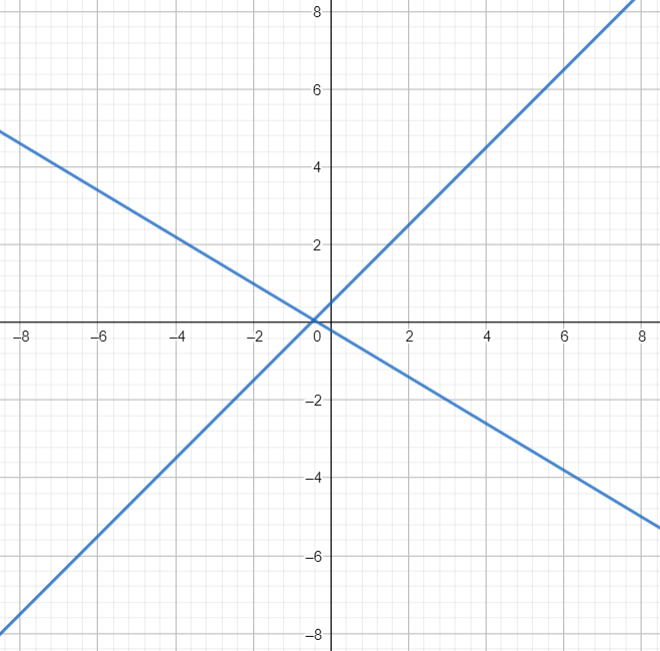

Teorema. Sea $V$ un espacio vectorial de dimensión finita $n$ sobre el campo $F$ y $T:V\to V$ una transformación lineal tal que $\chi_T(X)$ se divide sobre $F$. Entonces, existen únicos valores $\lambda_1\leq \ldots \leq \lambda_n$ en $F$ y únicos enteros $k_1,\ldots,k_d$ tales que \begin{align*} &k_1+k_2+\ldots+k_d = n,\\ &k_1\leq k_2 \leq \ldots \leq k_d,\end{align*} para los cuales existe una base de $V$ en la cual $T$ tiene como forma matricial a la siguiente matriz de bloques de Jordan:

$$\begin{pmatrix} J_{\lambda_1,k_1} & 0 & \cdots & 0 \\ 0 & J_{\lambda_2,k_2} & \cdots & 0 \\ \vdots & & \ddots & \vdots \\ 0 & 0 & \cdots & J_{\lambda_d,k_d}\end{pmatrix}.$$

Por supuesto, este teorema también tiene una versión matricial, la cuál tendrás que pensar cómo escribir.

Un teorema de descomposición de kernels

Ya tenemos uno de los ingredientes que necesitamos para dar la demostración de la existencia de la forma canónica de Jordan: su existencia para las transformaciones nilpotentes. Otro de los ingredientes que usaremos es el teorema de Cayley-Hamilton. El tercer ingrediente es un resultado de descoposición de kernels de transformaciones evaluadas en polinomios.

Proposición. Sea $V$ un espacio vectorial sobre $F$. Sea $T:V\to V$ una transformación lineal. Y sean $P_1(X),\ldots,P_r(X)$ polinomios en $F[x]$ cuyo máximo común divisor de cualesquiera dos de ellos es el polinomio $1$. Entonces, $$\ker((P_1P_2\cdots P_r)(T))=\bigoplus_{i=1}^r \ker(P_i(T)).$$

Demostración. Para cada $i\in \{1,2,\ldots,r\}$ consideraremos a $Q_i(X)$ como el polinomio que se obtiene de multiplicar a todos los polinomios dados, excepto $P_i(X)$. Y por comodidad, escribiremos $P(X)=(P_1\cdots P_r)(X)$. Notemos que entonces $P(X)=(Q_iP_i)(X)$ para cualquier $i\in\{1,2,\ldots,r\}$.

Primero probaremos un resultado polinomial auxiliar. Veremos que $Q_1(X),\ldots,Q_r(X)$ tienen como máximo común divisor al polinomio $1$. En caso de no ser así, un polinomio $D(X)$ no constante dividiría a todos ellos. Sin pérdida de generalidad, $D$ es irreducible (tomando, por ejemplo $D(X)$ de grado mínimo con esta propiedad). Como $D(X)$ es irreducible y divide a $Q_r(X)$, entonces debe dividir a alguno de los factores de $Q_r(X)$, que sin pérdida de generalidad (por ejemplo, reetiquetando), es $P_1(X)$. Pero $D(X)$ también divide a $Q_1(X)$, así que debe dividir a alguno de sus factores $P_2(X),\ldots,P_r(X)$, sin pérdida de generalidad a $P_2(X)$. Pero entonces $D(X)$ divide a $P_1(X)$ y $P_2(X)$, lo cual contradice las hipótesis. Así, $Q_1(X),\ldots,Q_r(X)$ tienen como máximo común divisor al polinomio $1$. Por el lema de Bézout para polinomios (ver tarea moral), existen entonces polinomios $R_1(X),\ldots,R_r(X)$ tales que

\begin{equation}

\label{eq:bezout}(R_1Q_1 + R_2Q_2 + \ldots + R_rQ_r)(X)=1.

\end{equation}

Estamos listos para pasar a los argumentos de álgebra lineal. Veamos primero que cualquier elemento en la suma de la derecha está en el kernel de $P(T)$. Tomemos $v=v_1+\ldots+v_r$ con $v_i\in \ker(P_i(T))$. Al aplicar $P$ obtenemos

\begin{align*}

P(v)&=P(v_1)+\ldots+P(v_r)\\

&=Q_1(P_1(v_1))+\ldots+Q_r(P_r(v_r))\\

&=0+\ldots+0=0.

\end{align*}

Esto muestra que $v\in \ker(P(T))$, de donde se obtiene la primera contención que nos interesa.

Veamos ahora la segunda contención, que $\ker(P(T))=\bigoplus_{i=1}^r \ker(P_i(T))$. Tomemos $v\in \ker(P(T))$. Al aplicar \eqref{eq:bezout} en $T$ y evaluar en $v$ obtenemos que

\begin{align*}

v&=\text{Id}(v)=(1)(T)(v)\\

&=(R_1Q_1 + R_2Q_2 + \ldots + R_rQ_r)(T)(v)\\

&=(R_1Q_1)(T)(v)+\ldots+(R_rQ_r)(T)(v).

\end{align*}

Pero esto justo expresa a $v$ como elemento de $\ker(P_i(T))$ pues para cada $i$ tenemos

\begin{align*}

P_i(T)((R_iQ_i)(T)(v))&=(P_iR_i Q_i )(T)(v)\\

&=(R_i Q_i P_i)(T)(v)\\

&=R_i(T)P(T)(v)\\

&=R_i(0)=0,

\end{align*}

de modo que expresamos a $v$ como suma de vectores en $\ker(P_1(T)),\ldots,\ker(P_r(T))$.

Ya demostramos la igualdad de conjuntos, pero recordemos que en la igualdad de suma directa hay otra cosa que hay que probar: que el cero tiene una forma única de expresarse como suma de elementos de cada subespacio (aquella en donde cada elemento es cero). Supongamos entonces que $$0=v_1+\ldots+v_r$$ con $v_i\in \ker(P_i(T))$ para cada $i$. Si aplicamos $Q_i$ en esta igualdad, como tiene todos los factores $P_j$ con $j\neq i$ obtenemos $$0=Q_i(0)=Q_i(v_i).$$

Por otro lado, al aplicar nuevamente \eqref{eq:bezout} en $T$ y evaluar en $v_i$

\begin{align*}

v_i&=\text{Id}(v_i)=(1)(T)(v_i)\\

&=(R_1Q_1 + R_2Q_2 + \ldots + R_rQ_r)(T)(v_i)\\

&=(R_1Q_1)(T)(v_1)+\ldots+(R_rQ_r)(T)(v_i)\\

&=(R_iQ_i)(T)(v_i)\\

&=0.

\end{align*}

De esta forma, en efecto tenemos que los espacios están en posición de suma directa, que era lo último que nos faltaba verificar.

$\square$

Existencia de la forma canónica de Jordan

Estamos listos para demostrar la existencia de la forma canónica de Jordan. Supongamos que $V$ es un espacio vectorial de dimensión finita $n$ sobre $F$ y que $T:V\to V$ es una transformación lineal cuyo polinomio característico se divide en $F[x]$. Sabemos entonces que es de la siguiente forma:

$$\chi_T(X)=(X-\lambda_1)^{m_1}(X-\lambda_2)^{m_2}\cdots(X-\lambda_r)^{m_r},$$

donde $\lambda_1,\ldots,\lambda_r$ son eigenvalores distintos de $T$ y $m_1,\ldots,m_r$ son las multiplicidades algebraicas respectivas de estos eigenvalores como raíces de $\chi_T(X)$.

Por el teorema de Cayley-Hamilton, sabemos que $\chi_T(T)=0$, de modo que $\ker(\chi_T(T))=V$. Por la proposición de descomposición de la sección anterior aplicada a los polinomios $P_i(X)=(X-\lambda_i)^{m_i}$ (verifica que son primos relativos dos a dos) para $i\in\{1,\ldots,r\}$ tenemos entonces que $$V=\bigoplus_{i=1}^r \ker((T-\lambda_i \text{id})^{m_i}).$$

Pero, ¿cómo es la transformación $T-\lambda_i \text{id}$ restringida a cada $\ker((T-\lambda_i \text{id})^{m_i})$? ¡Es nilpotente! Precisamente por construcción, $(T-\lambda_i \text{id})^{m_i}$ se anula totalmente en este kernel. Así, por la existencia de la forma canónica de Jordan para matrices nilpotentes, hay una base $\beta_i$ para cada $\ker((T-\lambda_i \text{id})^{m_i})$ tal que $T-\lambda_i \text{id}$ restringida a ese kernel tiene como forma matricial una matriz $J_i$ de bloques de Jordan de eigenvalor cero. Pero entonces $T$ (restringida a dicho kernel) tiene como forma matricial a $J_i+\lambda_i I_{m_i}$, que es una matriz de bloques de Jordan de eigenvalor $\lambda$.

Con esto terminamos: como $V$ es la suma directa de todos esos kernel, la unión de bases $\beta_1,\ldots,\beta_r$ es una base para la cual $T$ tiene como forma matricial a una matriz de bloques de Jordan.

$\square$

Más adelante…

Hemos demostrado la existencia de la forma canónica de Jordan, pero aún nos falta demostrar su unicidad. Además de esto, también necesitaremos un mejor procedimiento para encontrarla. Haremos eso en la siguiente entrada.

Tarea moral

- Enuncia el teorema de la forma canónica de Jordan versión matrices.

- Investiga más sobre el lema de Bézout para polinomios y cómo se demuestra. Después de esto, expresa al polinomio $1$ como combinación lineal de los polinomios $x^2-1, x^3+1, x^2+5x+4$.

- Verifica que los polinomios $P_i(X)=(X-\lambda_i)^{k_i}$ de la demostración de la existencia de la forma canónica de Jordan cumplen las hipótesis de la proposición de descomposición de kernels.

- Sea $F$ un campo y $r,s$ elementos en $F$. Sea $n$ un entero. Demuestra que los bloques de Jordan $J_{r,n}$ y $J_{s,n}$ en $M_n(F)$ conmutan.

- Siguiendo las ideas de la demostración de existencia, encuentra la forma canónica de Jordan de la matriz $$\begin{pmatrix} 1 & 1 & 1 & 1 \\ 0 & 1 & 1 & 1 \\ 0 & 0 & 2 & 2 \\ 0 & 0 & 0 & 2 \end{pmatrix}.$$

Entradas relacionadas

- Ir a Álgebra Lineal II

- Entrada anterior del curso: Unicidad de la forma canónica de Jordan para nilpotentes

- Siguiente entrada del curso: Unicidad de la forma canónica de Jordan

Agradecimientos

Trabajo realizado con el apoyo del Programa UNAM-DGAPA-PAPIME PE109323 «Hacia una modalidad a distancia de la Licenciatura en Matemáticas de la FC-UNAM – Etapa 3»