Introducción

En la entrada pasada hablamos del concepto de divisibilidad en los números enteros. Enunciamos y demostramos varias de sus propiedades. La noción de divisibilidad da lugar a muchos otros conceptos importantes dentro de la teoría de los números enteros, como el máximo común divisor, el mínimo común múltiplo y los números primos. Así mismo, la noción de divisibilidad está fuertemente ligada con los ideales en los enteros.

En esta entrada hablaremos de este último concepto a detalle. Es una entrada un poco técnica, pero nos ayudará para asentar las bases necesarias para poder hablar de los máximos comunes divisores y los mínimos comunes múltiplos con comodidad un poco más adelante.

Ideales en los enteros y una equivalencia

Los ideales son ciertas estructuras importantes en matemáticas. En el caso particular de los números enteros, tenemos la siguiente definición.

Definición. Un ideal de $\mathbb{Z}$ es un subconjunto $I$ de $\mathbb{Z}$ que cumple las siguientes dos propiedades:

- No es vacío.

- Es cerrado bajo restas, es decir, si $a$ y $b$ están en $I$, entonces $a-b$ también.

Veamos un ejemplo sencillo. Diremos que un número entero es par si es múltiplo de $2$ y que es impar si no es múltiplo de dos.

Ejemplo. El conjunto de todos los números pares son un ideal de $\mathbb{Z}$. Este conjunto claramente no es vacío, pues adentro de él está, por ejemplo, el $2$. Además, si tenemos que dos números $a$ y $b$ son pares, entonces por definición podemos encontrar enteros $k$ y $l$ tales que $a=2k$ y $b=2l$, de modo que $$a-b=2k-2l=2(k-l),$$ lo cual nos dice que $a-b$ también es par.

$\triangle$

Como veremos un poco más adelante, el ejemplo anterior se puede generalizar. Antes de ver esto, veremos una caracterización un poco distinta de lo que significa ser un ideal.

Proposición. Un subconjunto $I$ de $\mathbb{Z}$ es un ideal si y sólo si cumple las siguientes tres propiedades:

- No es vacío.

- Es cerrado bajo sumas, es decir, si $a$ y $b$ están en $I$, entonces $a+b$ también.

- Es absorbente, es decir, si $a$ está en $I$ y $b$ está en $\mathbb{Z}$, entonces $ab$ también está en $I$.

Demostración. Primero veremos que si $I$ es un ideal, entonces cumple las tres propiedades anteriores. Luego veremos que si $I$ cumple las tres propiedades anteriores, entonces es un idea.

Supongamos que $I$ es un ideal. Por definición, no es vacío, que es lo primero que queríamos ver. Veamos ahora que es cerrado bajo sumas. Supongamos que $a$ y $b$ están en $I$. Como $I$ es cerrado bajo restas y $b-b=0$, obtenemos que $b$ está en $I$. Usando nuevamente que $b$ es cerrado bajo restas para $0$ y $b$, obtenemos que $0-b=-b$ también está en $I$. Usando una última vez la cerradura de la resta, obtenemos ahora que $a+b=a-(-b)$ está en $I$, como queríamos.

La tercera propiedad la demostraremos primero para los $b\geq 0$ por inducción. Si $b=0$, debemos ver que $0\cdot a=0$ está en $I$. Esto es cierto pues en el párrafo anterior ya vimos por qué $0$ está en $I$. Supongamos ahora que para cierta $b$ fija se tiene que $ab$ está en $I$. Por la cerradura de la suma obtenemos que $$ab+a=ab+a\cdot 1=a(b+1)$$ también está en $I$, como queríamos. Aquí usamos que $1$ es identidad multiplicativa, la distributividad, la hipótesis inductiva y la cerradura de la suma.

Nos falta ver qué pasa con los $b<0$. Sin embargo, si $b<0$, tenemos que $a(-b)$ sí está en $I$ (pues $-b>0$). Así, por la cerradura de la resta tenemos que $0-a(-b)=ab$ está en $I$.

Apenas llevamos la mitad de la demostración, pues vimos que la definición de ideal implica las tres propiedades que se mencionan. Pero el regreso es más sencillo. Supongamos que un conjunto $I$ cumple las tres propiedades mencionadas. Como cumple la primera, entonces no es vacío. Ahora vemos que es cerrado bajo restas. Tomemos $a$ y $b$ en $I$. Como cumple la segunda propiedad, tenemos que $(-1)b=-b$ está en $I$. Como cumple la cerradura de la suma, tenemos que $a+(-b)=a-b$ está en $I$. Así, $I$ es cerrado bajo restas.

$\square$

La ventaja del resultado anterior es que nos permitirá pensar a los ideales de una o de otra forma, de acuerdo a lo que sea más conveniente para nuestros fines más adelante.

Clasificación de ideales

Veamos la generalización de nuestro ejemplo de números pares e impares.

Definición. Sea $n$ un entero. Al conjunto de todos los múltiplos de $n$ lo denotaremos por $n\mathbb{Z}$ y lo llamaremos el conjunto de los múltiplos de $n$, es decir:

$n\mathbb{Z}=\{nm: m\in \mathbb{Z}\}.$

Proposición. Si $n$ es cualquier entero, entonces $n\mathbb{Z}$ es un ideal de $\mathbb{Z}$.

Demostración. Claramente $n\mathbb{Z}$ no es vacío pues, por ejemplo, $0=0\cdot n$ está en $n\mathbb{Z}$. La demostración de la cerradura de la resta se sigue de un corolario de la entrada anterior. Si $a,b$ están en $n\mathbb{Z}$, entonces ambos son divisibles entre $n$, así que su resta $a-b$ también. Así, $a-b$ está en $n\mathbb{Z}$.

$\square$

El ejemplo anterior de hecho da todos los posibles ideales que existen en $\mathbb{Z}$. El siguiente teorema enuncia esto con precisión.

Teorema. Un conjunto $I$ de $\mathbb{Z}$ es un ideal si y sólo si existe un entero no negativo $n$ tal que $I=n\mathbb{Z}$.

Demostración. Tomemos $I$ un ideal de $\mathbb{Z}$. Existe la posibilidad de que $I=\{0\}$, pues en efecto este es un ideal: es no vacío (pues tiene a $0$) y es cerrado bajo restas (pues sólo hay que verificar que $0-0=0$ está en I). Si este es el caso, entonces $I=0\mathbb{Z}$, como queríamos. Así, a partir de ahora supondremos que $I$ no es este conjunto. Veremos que $I$ tiene por lo menos un elemento positivo.

Sea $a\in I$ cualquier elemento que no sea $0$. Si $a$ es positivo, entonces ya lo logramos. Si $a$ es negativo, entonces notamos que $0=a-a$ está en $I$, y que entonces $-a=0-a$ está en $I$. Pero entonces $-a$ es un número positivo en $I$.

Debido a esto, por el principio del buen orden podemos tomar al menor entero positivo $n$ que está en $I$. Afirmamos que $I=n\mathbb{Z}$. Por la caracterización de ideales que dimos en la sección anterior, todos los múltiplos de $n$ están en $I$, así que $I\supseteq n\mathbb{Z}$.

Veamos que $I\subseteq n\mathbb{Z}$ procediendo por contradicción. Supongamos que este no es el caso, y que entonces existe un $m\in I$ que no sea múltiplo de $n$. Por el algoritmo de la división, podemos escribir $m=qn+r$ con $0<r<n$. Como $m$ está en $I$ y $qn$ está en $I$, tendríamos entonces que $m-qn=r$ está en $I$. ¡Pero esto es una contradicción! Tendríamos que $r$ está en $I$ y que $0<r<n$, lo cual contradice que $n$ era el menor entero positivo en $I$ que tomamos con el principio del buen orden. Esta contradicción sólo puede evitarse si $m$ es múltiplo de $n$, como queríamos.

$\square$

Un teorema como el anterior se conoce como un teorema de clasificación pues nos está diciendo cómo son todas las posibles estructuras que definimos a partir de un criterio fácil de enunciar.

Ideal generado por dos elementos

Dado un conjunto de números enteros $S$, podríamos preguntarnos por el ideal más chiquito que contenga a $S$. Un ejemplo sencillo es tomar $S$ con sólo un elemento, digamos $S=\{n\}$. En este caso, es fácil convencerse de que el ideal más pequeño que contiene a $S$ es precisamente $n\mathbb{Z}$ (ve los problemas de la tarea moral).

Un caso un poco más interesante es, ¿qué sucede si tenemos dos elementos?

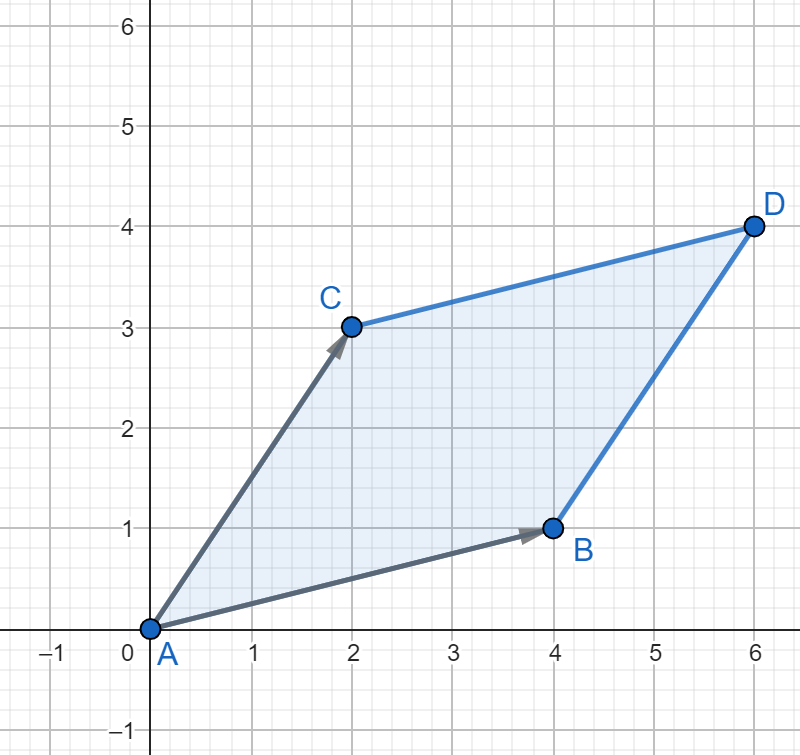

Ejemplo. ¿Cuál será el menor ideal posible $I$ que tiene a los números $13$ y $9$? Empecemos a jugar un poco con la propiedad de la cerradura de la resta. Como $13$ y $9$ están, entonces también está $4=13-9$. Como $9$ y $4$ están, entonces también está $5=9-4$. Así mismo, debe estar $1=5-4$. Pero aquí ya llegamos a algo especial: que el $1$ está. Recordemos los ideales también cumplen que una vez que está un número, están todos sus múltiplos. Así, $1\mathbb{Z}$ está contenido en $I$. Pero entonces $I=1\mathbb{Z}=\mathbb{Z}$.

$\square$

No siempre obtenemos $\mathbb{Z}$ como respuesta. Para un ejemplo en donde se obtiene $2\mathbb{Z}$, ve los problemas de la tarea moral. En la siguiente entrada hablaremos con más detalle de la respuesta, pero por el momento probaremos lo siguiente.

Proposición. Si $a$ y $b$ son enteros, entonces:

- El conjunto $M=\{ra+sb: r,s\in \mathbb{Z}\}$ es un ideal de $\mathbb{Z}$ que tiene a $a$ y a $b$.

- Si $I$ es un ideal de $\mathbb{Z}$ que tiene a $a$ y a $b$, entonces $M\subseteq I$.

En otras palabras, «$M$ es el ideal más pequeño (en contención) que tiene a $a$ y a $b$».

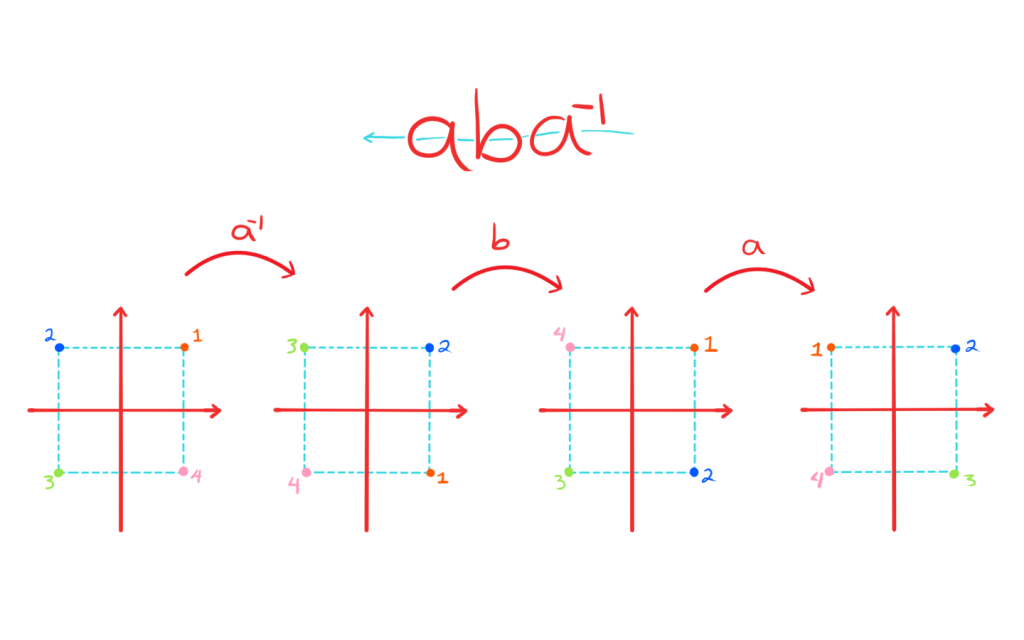

Demostración. Veamos primero que $M$ en efecto es un ideal. Para ello, notemos que no es vacío pues, por ejemplo, $0=0\cdot a+0\cdot b$ está en $M$. Además, es cerrado bajo restas pues si tenemos dos elementos en $M$, son de la forma $ra+sb$ y $ka+lb$, y su resta es $$(ra+sb)-(ka+lb)=(r-k)a+(s-l)b,$$ que vuelve a estar en $M$ pues $r-k$ y $s-l$ son enteros. Además, $a=1\cdot a+ 0\cdot b$, lo que muestra que $a$ está en $M$ y $b=0\cdot a + 1 \cdot b$, lo que muestra que $b$ está en $M$ también. Con esto demostramos el primer punto.

Para el segundo punto, supongamos que $a$ está en $I$ y que $b$ está en $I$ también. Como $I$ es idea, tiene a todos los múltiplos de $a$ y los de $b$, es decir, a todos los números de la forma $ra$ y $sb$. Como es ideal, también es cerrado bajo sumas, así que tiene todas las formas de números de este estilo. En particular, tiene a todos los números de la forma $ra+sb$ (variando $r$ y $s$), es decir, a todos los elementos de $I$, como queríamos.

$\square$

Quizás notaste algo raro. El conjunto $M$ es un ideal, pero se ve un poco distinto de los que obtuvimos con nuestra caracterización de la sección anterior. Parece más bien que «está hecho por dos enteros» en vez de estar hecho sólo por uno. Esto no es problema. Nuestra caracterización nos dice que debe existir un entero $d$ tal que $M=d\mathbb{Z}$. Esto nos llevará en la siguiente entrada a estudiar el máximo común divisor.

Intersección de ideales

Los ideales de $\mathbb{Z}$ son subconjuntos, así que podemos aplicarles operaciones de conjuntos. ¿Qué sucede si intersectamos dos ideales? La siguiente operación nos dice que

Proposición. Si $I$ y $J$ son ideales de $\mathbb{Z}$, entonces $I\cap J$ también.

Demostración. La demostración es sencilla. Como $I$ y $J$ son ideales, se puede ver que ambos tienen al $0$, y que por lo tanto su intersección también. Ahora veamos que $I\cap J$ es cerrada bajo restas. Si $a$ y $b$ están en $I\cap J$, entonces $a$ y $b$ están en $I$. Como $I$ es cerrado bajo restas, $a-b$ está en $I$. Análogamente, está en $J$. Así, $a-b$ está en $I\cap J$, como queríamos.

$\square$

Este resultado motivará nuestro estudio del mínimo común múltiplo un poco más adelante.

Más adelante…

Esta fue una entrada un poco técnica, pero ahora ya conocemos a los ideales en los enteros, algunas de sus propiedades y hasta los caracterizamos. La idea de tomar el ideal generado por dos elementos nos llevará a estudiar en la siguiente entrada el concepto de máximo común divisor. Y luego, la idea de intersectar ideales nos llevará en un par de entradas a explorar la noción de mínimo común múltiplo.

Tarea moral

A continuación hay algunos ejercicios para que practiques los conceptos vistos en esta entrada. Te será de mucha utilidad intentarlos para entender más la teoría vista.

- Imagina que sabes que un ideal tiene al número $6$. Esto forza a que también tenga a $6-6=0$. Así, esto forza a que también tenga el $0-6=-6$. Sigue así sucesivamente, jugando con todas las nuevas restas que deben quedarse dentro del ideal. ¿Cuál es el menor ideal que puede tener al $6$?

- Repite lo anterior, pero ahora suponiendo que tu ideal tiene a los números $10$ y $12$. ¿Qué números puedes obtener si repetidamente puedes hacer restas? ¿Quién sería el menor ideal que tiene a ambos números?

- Sean $I_1,\ldots,I_k$ ideales de $\mathbb{N}$. Demuestra que $I_1\cap I_2 \cap \ldots \cap I_k$ también es un idea. Como sugerencia, usa inducción.

- Toma a los ideales $6\mathbb{Z}$ y $8\mathbb{Z}$. Por el resultado de la entrada, tenemos que su intersección $A$ también es un ideal. Intenta averiguar y demostrar quién es el $k$ tal que $A=k\mathbb{Z}$.

- ¿Es cierto que la unión de dos ideales siempre es un ideal? Si es falso, encuentra contraejemplos. Si es verdadero, da una demostración. Si es muy fácil, ¿puedes decir exactamente para qué enteros $m$ y $n$ sucede que $m\mathbb{Z}\cup n\mathbb{Z}$ sí es un ideal?

Entradas relacionadas

Agradecimientos

Trabajo realizado con el apoyo del Programa UNAM-DGAPA-PAPIME PE104522 «Hacia una modalidad a distancia de la Licenciatura en Matemáticas de la FC-UNAM – Etapa 2»