Introducción

Hemos llegado a la cima del curso. En estas últimas entradas probaremos uno de los teoremas más bellos en álgebra lineal: el teorema espectral para matrices simétricas reales. También hablaremos de varias de las consecuencias que tiene.

Hay dos formas equivalentes de enunciar el teorema.

Teorema. Sea $V$ un espacio euclideano y $T:V\to V$ una transformación simétrica. Entonces, existe una base ortonormal de $V$ que consiste de eigenvectores de $T$.

Teorema. Sea $A$ una matriz simétrica en $\mathbb{R}^n$. Entonces, existe una matriz ortogonal $P$ y una matriz diagonal $D$, ambas en $\mathbb{R}^n$, tales que $$A=P^{-1}DP.$$

Para hablar de la demostración y de las consecuencias del teorema espectral para matrices simétricas reales, necesitaremos usar teoría de todas las unidades del curso. En particular, usaremos las siguientes definiciones:

- Una matriz $A$ en $M_n(F)$ es simétrica si es igual a su transpuesta.

- Una matriz $A$ en $M_n(F)$ es ortogonal si es invertible y $A^{-1}= {^tA}$.

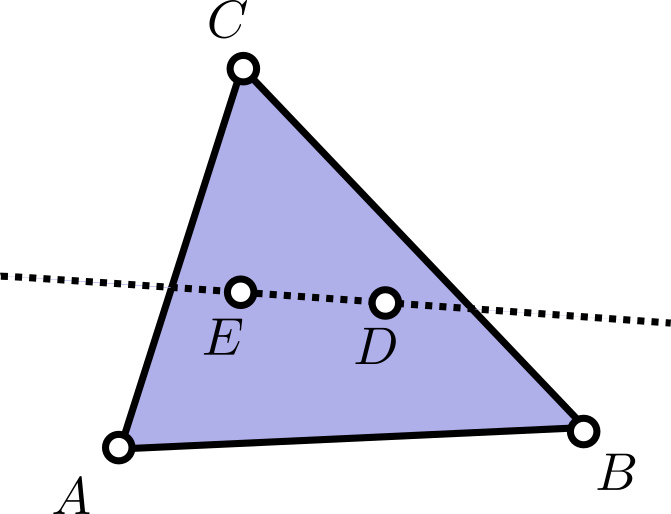

- Si $T:V\to V$ es una transformación lineal de un espacio vectorial $V$ a sí mismo y $W$ es un subespacio de $V$, entonces decimos que $W$ es estable bajo $T$ si $T(W)\subseteq W$.

- Un producto interior es una forma bilineal simétrica y positiva definida.

- Un espacio Euclideano es un espacio vectorial de dimensión finita con un producto interior.

- Si $W$ es un subespacio de un espacio Euclideano $V$, entonces $W^\bot$ es el conjunto de todos los vectores que de $V$ que son ortogonales a todos los vectores de $W$.

- Una matriz $A$ en $M_n(F)$ es diagonalizable si existen matrices $P$ y $D$ en $M_n(F)$ con $P$ invertible, $D$ diagonal y tales que $A=P^{-1}DP$.

Y los siguientes resultados principales:

- Los eigenvalores de una matriz en $M_n(F)$ son las raíces de su polinomio característico que estén en $F$.

- Una matriz «brinca a la otra entrada» de un producto interior transponiéndose. Formalmente, para cualquier matriz $A$ en $M_n(R)$ y vectores $u,v$ en $\mathbb{R}^n$, se tiene que $$\langle {^tA}u,v \rangle= \langle u, {A} v\rangle.$$

- Todo espacio Euclideano tiene una base ortonormal que se puede encontrar mediante el proceso de Gram-Schmidt.

En esta entrada enunciaremos tres resultados auxiliares de interés propio. A partir de estos resultados, la demostración del teorema espectral para matrices simétricas reales y la equivalencia entre ambas versiones será mucho más limpia.

Los eigenvalores de matrices simétricas reales

El polinomio característico de una matriz $A$ en $M_n(\mathbb{R})$ tiene coeficientes reales. Por el teorema fundamental del álgebra, debe tener exactamente $n$ raíces en $\mathbb{C}$, contando multiplicidades. Si alguna de estas raíces $r$ no es real, entonces $A$ no puede ser diagonalizable en $M_n(\mathbb{R})$. La razón es que $A$ sería similar a una matriz diagonal $D$, y los eigenvalores de las matrices diagonales (incluso triangulares) son las entradas de la diagonal principal. Como $A$ y $D$ comparten eigenvalores (por ser similares), entonces $r$ tendría que ser una entrada de $D$, pero entonces $D$ ya no sería una matriz de entradas reales.

Lo primero que veremos es que las matrices simétricas reales «superan esta dificultad para poder diagonalizarse». Esta va a ser nuestra primer herramienta para demostrar el teorema espectral.

Teorema. Sea $A$ una matriz simétrica en $M_n(\mathbb{R})$ y $\lambda$ una raíz del polinomio característico de $A$. Entonces, $\lambda$ es un número real.

Demostración. El polinomio característico de $A$ es un polinomio con coeficientes reales, así que por el teorema fundamental del álgebra se tiene que $\lambda$ debe ser un número en $\mathbb{C}$. Así, podemos escribirlo de la forma $\lambda = a+ib$, con $a$ y $b$ números reales. Lo que mostraremos es que $b=0$.

Se tiene que $\lambda$ es un eigenvalor de $A$ vista como matriz en $M_n(\mathbb{C})$, y por lo tanto le corresponde un eigenvector $U$ en $\mathbb{C}^n$, es decir, un $U\neq 0$ tal que $$AU=\lambda U.$$ Este vector $U$ lo podemos separar en partes reales e imaginarias con vectores $V$ y $W$ en $\mathbb{R}^n$ tales que $$U=V+iW.$$

En estos términos,

\begin{align*}

AU&=A(V+iW)=AV+iAW \quad\text{y}\\

\lambda U &= (a+ib)(V+iW)\\

&=(aV-bW) + i (aW+bV),

\end{align*}

de modo que igualando partes reales e imaginarias en la expresión $AU=\lambda U$ tenemos que

\begin{align*}

AV&=aV-bW\quad\text{y}\\

AW&=aW+bV.

\end{align*}

Como $A$ es simétrica, tenemos que

\begin{equation}

\langle AV,W \rangle=\langle {^tA}V,W \rangle= \langle V, AW\rangle.

\end{equation}

Estudiemos las expresiones en los extremos, reemplazando los valores de $AV$ y $AW$ que encontramos arriba y usando la bilinealidad del producto interior. Se tiene que

\begin{align*}

\langle AV,W \rangle &= \langle aV-bW,W \rangle\\

&=a\langle V,W \rangle – b \langle W,W \rangle\\

&=a \langle V,W \rangle – b \norm{W}^2,

\end{align*}

y que

\begin{align*}

\langle V,AW \rangle &= \langle V,aW+bV \rangle\\

&=a\langle V,W \rangle + b \langle V,V \rangle\\

&=a \langle V,W \rangle + b \norm{V}^2.

\end{align*}

Substituyendo estos valores en la expresión (1), obtenemos la igualdad

$$a \langle V,W \rangle – b \norm{W}^2 = a \langle V,W \rangle + b \norm{V}^2,$$

que se simplifica a $$b(\norm{V}^2+\norm{W}^2)=0.$$

Estamos listos para dar el argumento final. Como $U=V+iW$ es un eigenvector, entonces no es nulo, de modo que no es posible que $V$ y $W$ sean ambos el vector $0$ de $\mathbb{R}^n$. Como el producto interior es positivo definido, entonces alguna de las normas $\norm{V}$ o $\norm{W}$ no es cero, de modo que $$\norm{V}^2+\norm{W}^2\neq 0.$$

Concluimos que $b=0$, y por lo tanto que $\lambda$ es un número real.

$\square$

La demostración anterior es ejemplo de un truco que se usa mucho en las matemáticas. Aunque un problema o un teorema no hablen de los números complejos en su enunciado, se puede introducir a $\mathbb{C}$ para usar sus propiedades y trabajar ahí. Luego, se regresa lo obtenido al contexto real. Aquí en el blog hay otra entrada en donde damos más ejemplos de «brincar a los complejos».

Un resultado auxiliar de transformaciones simétricas

A continuación damos la segunda herramienta que necesitaremos para probar el teorema espectral. Recuerda que si $V$ es un espacio Euclideano y $T:V\to V$ es una transformación lineal, entonces decimos que $T$ es simétrica si para todo par de vectores $u$ y $v$ en $V$ se tiene que $$\langle T(u),v\rangle = \langle u, T(v) \rangle.$$ Enunciamos el resultado en términos de transformaciones, pero también es válido para las matrices simétricas asociadas.

Teorema. Sea $V$ un espacio Eucideano y $T:V\to V$ una transformación lineal simétrica. Sea $W$ un subespacio de $V$ estable bajo $T$. Entonces:

- $W^\bot$ también es estable bajo $T$ y

- Las restricciones de $T$ a $W$ y a $W^\bot$ son transformaciones lineales simétricas en esos espacios.

Demostración. Para el primer punto, lo que tenemos que mostrar es que si $w$ pertenece a $W^\bot$, entonces $T(w)$ también, es decir, que $T(w)$ es ortogonal a todo vector $v$ en $W$.

Tomemos entonces un vector $v$ en $W$. Como $W$ es estable bajo $T$, tenemos que $T(v)$ está en $W$, de modo que $\langle w, T(v) \rangle =0$. Como $T$ es simétrica, tenemos entonces que $$\langle T(w),v \rangle = \langle w, T(v) \rangle = 0.$$ Esto es lo que queríamos probar.

Para la segunda parte, si $T_1$ es la restricción de $T_1$ a $W$ y tomamos vectores $u$ y $v$ en $W$, tenemos que

\begin{align*}

\langle T_1(u), v \rangle &= \langle T(u), v \rangle\\

&=\langle u, T(v) \rangle \\

&=\langle u, T_1(v) \rangle,

\end{align*}

lo cual muestra que $T_1$ es simétrica. La prueba para $W^\bot $ es análoga y queda como tarea moral.

$\square$

Matrices diagonalizables y bases ortonormales de eigenvectores

El tercer y último resultado enuncia una equivalencia entre que una matriz en $M_n(F)$ sea diagonalizable, y que exista una base especial para $F^n$. Es lo que usaremos para probar la equivalencia entre ambas formulaciones del teorema espectral para matrices simétricas reales.

Teorema. Sea $A$ una matriz en $M_n(F)$. Las siguientes dos afirmaciones son equivalentes:

- $A$ es diagonalizable, es decir, existen matrices $P$ y $D$ en $M_n(F)$, con $P$ invertible y $D$ diagonal tales que $A=P^{-1}DP.$

- Existe una base para $F^n$ que consiste de eigenvectores de $A$.

Demostración. Antes de comenzar la demostración, recordemos que si tenemos una matriz $B$ en $M_n(F)$ de vectores columna $$C_1,\ldots,C_n,$$ entonces los vectores columna del producto $AB$ son $$AC_1,\ldots AC_n.$$ Además, si $D$ es una matriz diagonal en $M_n(F)$ con entradas en la diagonal $d_1,\ldots,d_n$, entonces los vectores columna de $BD$ son $$d_1C_1,\ldots,d_nC_n.$$

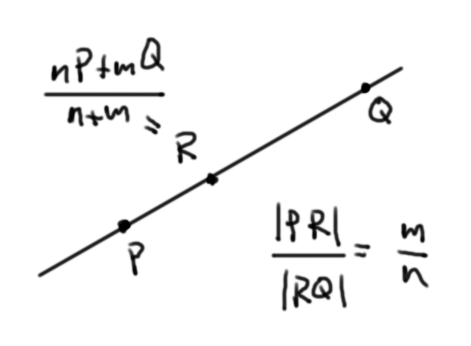

Comencemos la prueba del teorema. Supongamos que $A$ es diagonalizable y tomemos matrices $P$ y $D$ en $M_n(F)$ con $P$ invertible y $D$ diagonal de entradas $d_1,\ldots,d_n$, tales que $A=P^{-1}DP$. Afirmamos que los vectores columna $C_1,\ldots,C_n$ de $P^{-1}$ forman una base de $F^n$ que consiste de eigenvectores de $A$.

Por un lado, como son los vectores columna de una matriz invertible, entonces son linealmente independientes. En total son $n$, como la dimensión de $F^n$. Esto prueba que son una base.

De $A=P^{-1}DP$ obtenemos la igualdad $AP^{-1}=P^{-1}D$. Por las observaciones al inicio de la prueba, tenemos al igualar columnas que para cada $j=1,\ldots,n$ se cumple $$AC_j = d_j C_j.$$ Como $C_j$ forma parte de un conjunto linealmente independiente, no es el vector $0$. Así, $C_j$ es un eigenvector de $A$ con eigenvalor $d_j$. Con esto terminamos una de las implicaciones.

Supongamos ahora que existe una base de $F^n$ que consiste de eigenvectores $C_1,\ldots,C_n$ de $A$. Para cada $j=1,\ldots,n$, llamemos $\lambda_j$ al eigenvalor correspondiente a $C_j$, y llamemos $D$ a la matriz diagonal con entradas $\lambda_1,\ldots,\lambda_n$.

Como $C_1,\ldots,C_n$ son vectores linealmente independientes, la matriz $B$ cuyas columnas son $C_1,\ldots, C_n$ es invertible. Además, por las observaciones al inicio de la prueba, se tiene que la columna $j$ de la matriz$AB$ es $AC_j$ y la columna $j$ de la matriz $BD$ es $\lambda_j C_j$. Entonces, por construcción, estas matrices son iguales columna a columna, y por lo tanto lo son iguales. De esta forma, tenemos que $AB=BD$, o bien, reescribiendo esta igualdad, que $$A=BDB^{-1}.$$ Así, la matriz invertible $P=B^{-1}$ y la matriz diagonal $D$ diagonalizan a $A$.

$\square$

Las matrices simétricas reales serán todavía más especiales que simplemente las matrices diagonalizables. Lo que asegura el teorema espectral es que podremos encontrar no sólo una base de eigenvectores, sino que además podemos garantizar que esta base sea ortonormal. En términos de diagonalización, la matriz $P$ no sólo será invertible, sino que además será ortogonal.

Más adelante…

En esta entrada enunciamos dos formas del teorema espectral y hablamos de algunas consecuencias que tiene. Además, repasamos un poco de la teoría que hemos visto a lo largo del curso y vimos cómo nos ayuda a entender mejor este teorema.

En la siguiente entrada, que es la última del curso, demostraremos las dos formas del teorema espectral que enunciamos en esta entrada y haremos un pequeño comentario sobre qué hay más allá del teorema espectral en el álgebra lineal.

Tarea moral

A continuación hay algunos ejercicios para que practiques los conceptos vistos en esta entrada. Te será de mucha utilidad intentarlos para entender más la teoría vista.

- Encuentra un ejemplo de una matriz simétrica en $M_n(\mathbb{C})$ cuyos eigenvalores no sean reales.

- En el contexto del segundo teorema, muestra que la restricción de $T$ a $W^\bot$ es simétrica.

- Realiza la demostración de que si $A$ y $B$ son matrices en $M_n(F)$ y los vectores columna de $B$ son $C_1,\ldots,C_n$, entonces los vectores columna de $AB$ son $AC_1,\ldots,AC_n$. También, prueba que si $D$ es diagonal de entradas $d_1,\ldots,d_n$, entonces las columnas de $BD$ son $d_1C_1,\ldots,d_nC_n$.

- Encuentra una matriz $A$ con entradas reales similar a la matriz $$\begin{pmatrix} 1 & 0 & 0 \\ 0 & 5 & 0 \\ 0 & 0 & -3 \end{pmatrix},$$ tal que ninguna de sus entradas sea igual a $0$. Encuentra una base ortogonal de eigenvectores de $A$ para $\mathbb{R}^3$.

- Diagonaliza la matriz $$\begin{pmatrix}-2 & 0 & 0 & 0\\0 & 2 & 0 & 0\\ \frac{19}{7} & \frac{30}{7} & \frac{65}{7} & \frac{24}{7}\\ \frac{6}{7} & – \frac{20}{7} & – \frac{48}{7} & – \frac{23}{7}\end{pmatrix}.$$

Entradas relacionadas

- Ir a Álgebra Lineal I

- Entrada anterior del curso: Problemas de eigenvalores, eigenvectores y polinomio característico

- Siguiente entrada del curso: Teorema espectral para matrices simétricas reales

Agradecimientos

Trabajo realizado con el apoyo del Programa UNAM-DGAPA-PAPIME PE104721 «Hacia una modalidad a distancia de la Licenciatura en Matemáticas de la FC-UNAM»