Introducción

La entrada anterior vimos que una función analítica puede ser representada mediante una expansión en serie de Taylor o en serie de Laurent, dependiendo de la función y su dominio de analicidad. En esta entrada veremos que este hecho es de suma importancia ya que nos permite clasificar a los ceros y a las singularidades de una función analítica, en particular nos centraremos en las singulares aisladas que como veremos pueden clasificarse completamente en tres tipos: singularidades removibles, polos y singularidades esenciales.

Recordemos que un polinomio complejo $p(z)$ es una función entera. Más aún, sabemos que una raíz de $p$ es un número $z_0\in\mathbb{C}$ tal que $p(z_0)=0$. En este punto nos interesa generalizar esta idea para cualquier función analítica en algún dominio del plano complejo.

Definición 43.1. (Cero de una función analítica.)

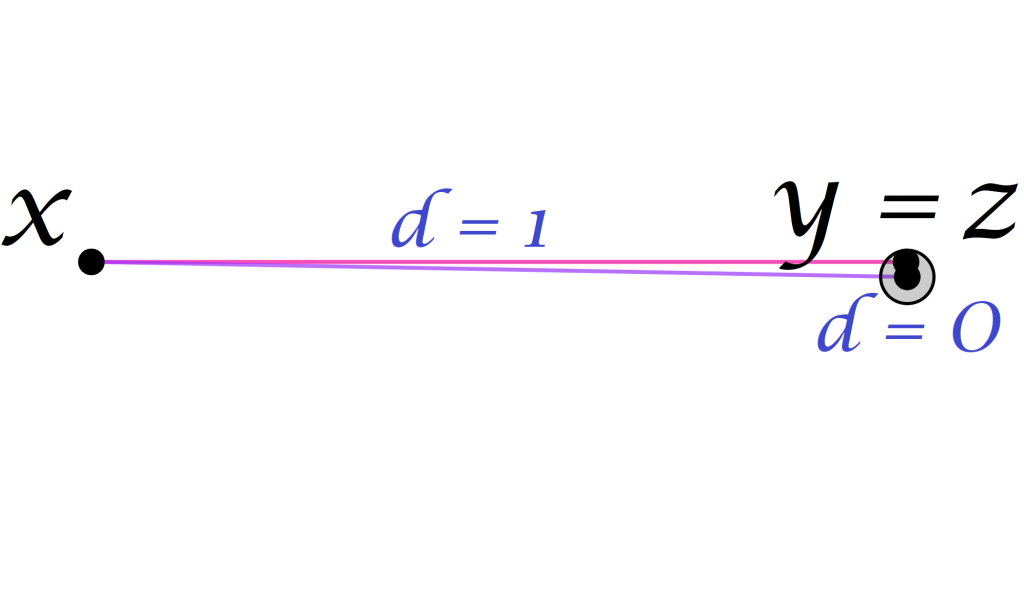

Sean $D\subset\mathbb{C}$ un dominio y $f:D\to\mathbb{C}$ una función analítica en $D$. Un cero de $f$ es un punto $z_0\in D$ tal que $f(z_0) = 0$.

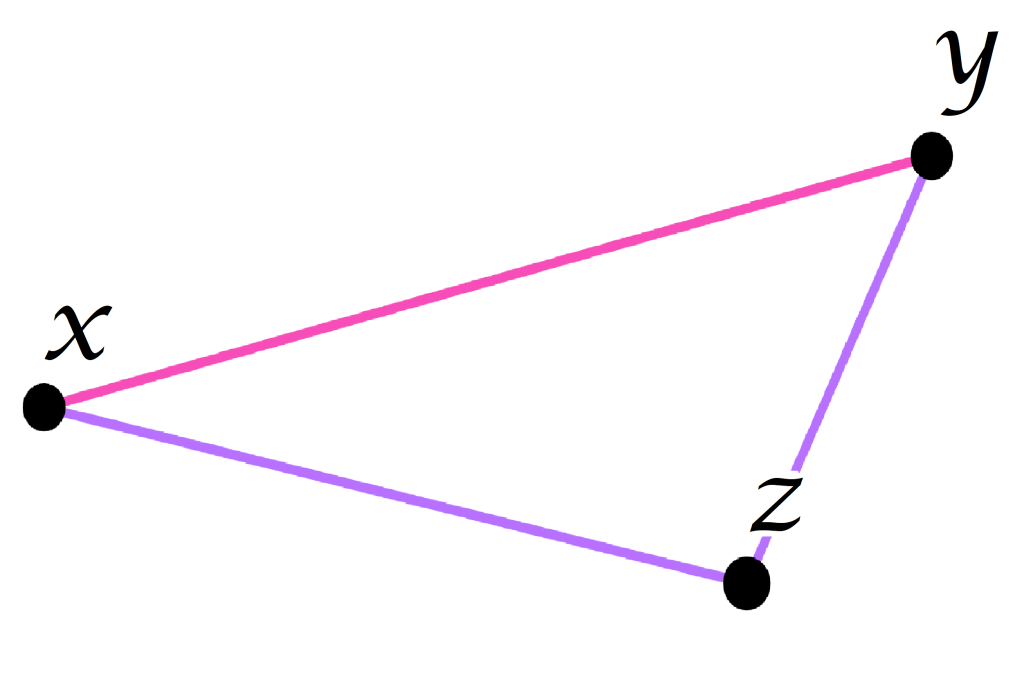

Definición 43.2. (Cero de orden $m$ y cero aislado de una función analítica.)

Sean $D\subset\mathbb{C}$ un dominio, $f:D\to\mathbb{C}$ una función analítica en $D$ y $m\in \mathbb{N}^{+}$. Un punto $z_0\in D$ es un cero de orden $m$ o un cero de multiplicidad $m$ de $f$ si existe una función analítica $g:B(z_0,R)\subset D \to \mathbb{C}$, con $R>0$, tal $g(z_0) \neq 0$ y:

\begin{equation*}

f(z) = (z-z_0)^m g(z),\quad \forall z\in B(z_0,R).

\end{equation*}

Si $m=1$, se dice que $z_0$ es un cero simple de $f$. Más aún, el cero $z_0\in D$ se dice que es aislado si existe un disco abierto de $z_0$ en $D$ tal que $z_0$ es el único cero de $f$ en dicho disco.

Observación 43.1.

De acuerdo con el teorema de Taylor, para $B(z_0,R)\subset D$ tenemos que:

\begin{equation*}

f(z) = \sum_{n=0}^\infty c_n(z-z_0)^n, \quad \forall z\in B(z_0,R),

\end{equation*}donde $c_n = \dfrac{f^{(n)}(z_0)}{n!}$.

Es claro que al considerar la expansión en serie de Taylor de la función analítica $f$, alrededor de $z_0 \in D$, el punto $z_0$ es un cero de $f$. Entonces $c_0 = f(z_0) = 0$. Sin embargo, pueden suceder dos casos.

- Todos los otros coeficientes $c_n$ de la serie también son cero. En tal caso $f(z)=0$ para todo $z \in B(z_0,R)$.

- Existe $m\geq 1$ tal que:

\begin{equation*}

c_0 = c_1 = \cdots = c_{m-1} =0 \quad \text{y} \quad c_m \neq 0,

\end{equation*}es decir:

\begin{equation*}

f(z_0) = f'(z_0) = \cdots = f^{(m-1)}(z_0) =0 \quad \text{y} \quad f^{(m)}(z_0) \neq 0.

\end{equation*}En tal caso, para todo $z\in B(z_0,R)$ tenemos que:

\begin{align*}

f(z) & = \sum_{n=m}^\infty c_n(z-z_0)^n\\

& = \sum_{n=0}^\infty c_{n+m}(z-z_0)^{n+m}\\

& = (z-z_0)^{m}\sum_{n=0}^\infty c_{n+m}(z-z_0)^{n}\\

& = (z-z_0)^{m} g(z),

\end{align*}donde $g(z) = \displaystyle\sum_{n=0}^\infty c_{n+m}(z-z_0)^{n}$, con $c_{n+m} = \dfrac{f^{(n+m)}(z_0)}{(n+m)!}$, es una función analítica en $B(z_0,R)$, corolario 39.1, tal que $g(z_0) = c_m \neq 0$.

Como $g$ es continua en $z_0$, para $\varepsilon=|c_m|/2>0$ existe $r>0$ tal que si $z\in B(z_0,r)$, entonces:

\begin{equation*}

|g(z) – c_m| = |g(z) – g(z_0)|<\frac{|c_m|}{2}.

\end{equation*}Por lo que si $g(z)=0$ para $z\in B(z_0,r)$ tenemos que:

\begin{equation*}

|0 – c_m| = |c_m|<\frac{|c_m|}{2},

\end{equation*}lo cual claramente es una contradicción, por lo que existe $r>0$ tal que $g(z)\neq 0$ para todo $z\in B(z_0,r)\subset D$.

Proposición 43.1.

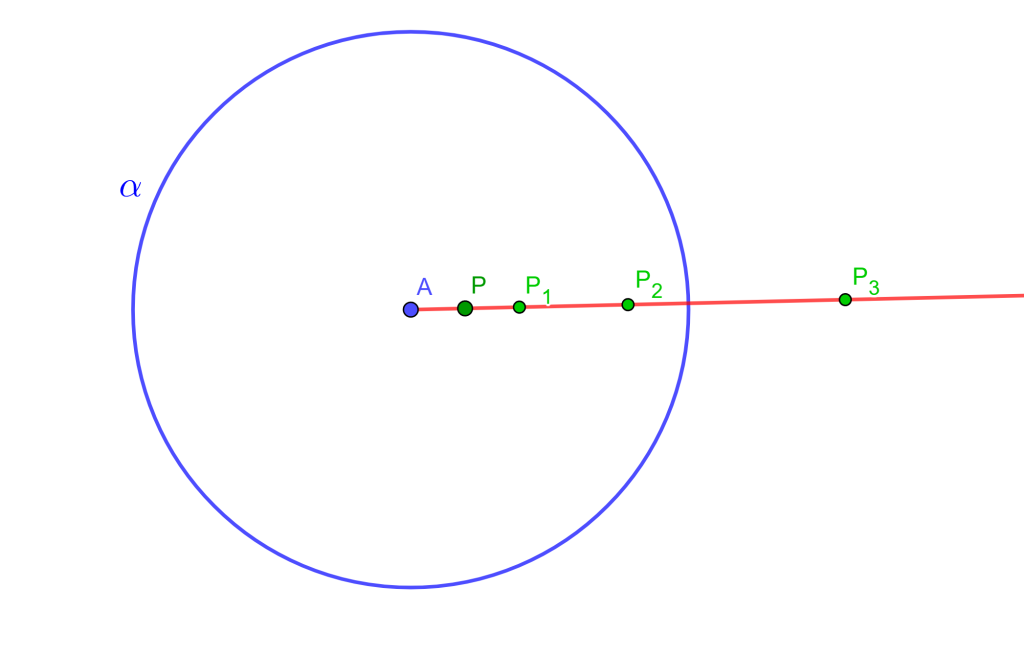

Sean $D\subset\mathbb{C}$ un dominio, $f:D\to\mathbb{C}$ una función analítica en $D$ y $z_0\in D$ tal que $f(z_0)=0$. Entonces se cumple una de las siguientes condiciones.

- $f(z) = 0$ en algún disco abierto de $z_0$ contenido en $D$.

- $z_0$ es un cero aislado de $f$.

Más aún, si se cumple la condición (2) entonces existen $m\in\mathbb{N}^+$, $r>0$ y una función analítica:

\begin{equation*}

g:B(z_0,r)\to\mathbb{C},

\end{equation*}tal que $g(z)\neq 0$ para todo $z\in B(z_0,r)$ y:

\begin{equation*}

f(z)=(z-z_0)^m g(z), \quad \forall z\in B(z_0,r).

\end{equation*}

En consecuencia, $z_0$ es un cero de orden $m$ y se cumple que:

\begin{equation*}

f(z_0) = f'(z_0) = \cdots = f^{(m-1)}(z_0) =0 \quad \text{y} \quad f^{(m)}(z_0) \neq 0.

\end{equation*}

Demostración. Se sigue de la observación 43.1.

$\blacksquare$

Ejemplo 43.1.

Determinemos el orden $m\geq 1$ del cero $z_0 =0$ de la función $f(z) = \operatorname{sen}(z)$.

Solución. Es claro que $0$ es un cero de $f$. Sabemos que el orden de dicho cero está dado por la primera derivada distinta de $0$ en $z_0 = 0$. En este caso tenemos que $f'(z) = \operatorname{cos}(z)$ y $f'(z_0) = f'(0) = \operatorname{cos}(0)=1\neq 0$, por lo que $z_0 = 0$ es un cero simple de $f$.

Por el ejemplo 42.5 tenemos que:

\begin{equation*}

f(z) = \operatorname{sen}(z) = z g(z),

\end{equation*}donde:

\begin{equation*}

g(z):= \sum_{n=0}^{\infty} \frac{(-1)^{n}z^{2n}}{(2n+1)!},

\end{equation*}la cual es una función entera, corolario 39.1, tal que $g(0)=1 \neq 0$ y para $z\neq 0$ tenemos que $g(z) = \dfrac{\operatorname{sen}(z)}{z}$ la cual es también una función entera, por lo que existe $r>0$ tal que $g(z)\neq 0$ para todo $z\in B(0,r)$, es decir, $z_0 = 0$ es un cero aislado.

Ejemplo 43.2.

Encontremos la multiplicidad del cero $z_0 = 0$ de la función $f(z)=e^{z}-z-1$.

Solución. Claramente $z_0=0$ es un cero de $f$. Dado que:

\begin{align*}

f'(z) & = e^{z}-1 \quad \Longrightarrow f'(0) =0,\\

f^{(2)}(z) & = e^{z} \quad \Longrightarrow f'(0) =1\neq 0,

\end{align*}tenemos que $z_0=0$ es un cero de multiplicidad $2$ de $f$.

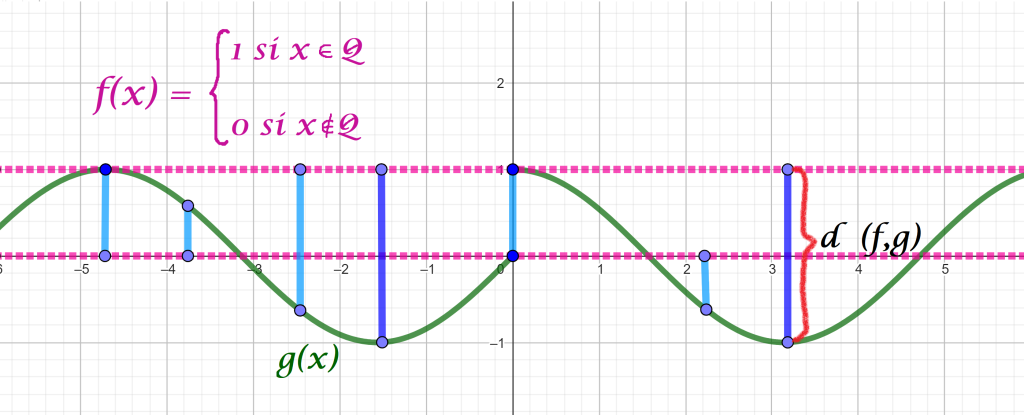

Por la definición 16.3, sabemos que para un dominio $D\subset\mathbb{C}$ y una función $f:D\to\mathbb{C}$, se dice que $z_0\in D$ es una singularidad de $f$ si la función $f$ no es analítica en $z_0$, pero es analítica en algún punto de cada disco abierto $B(z_0,R)$ contenido en $D$. Por ejemplo para las funciones $(e^{z}-1)z^{-1}$, $z^{-4}$ y $e^{1/z}$ es claro que $z_0=0$ es una singularidad ya que en dicho punto cada función no está definida y por tanto no es analítica, pero cada función es analítica para todo $z\neq 0$. Una pregunta interesante que podemos plantearnos es ¿existe alguna diferencia entre la singularidad $z_0=0$ de dichas funciones? Veamos que dicha singularidad es de distinta naturaleza para cada función.

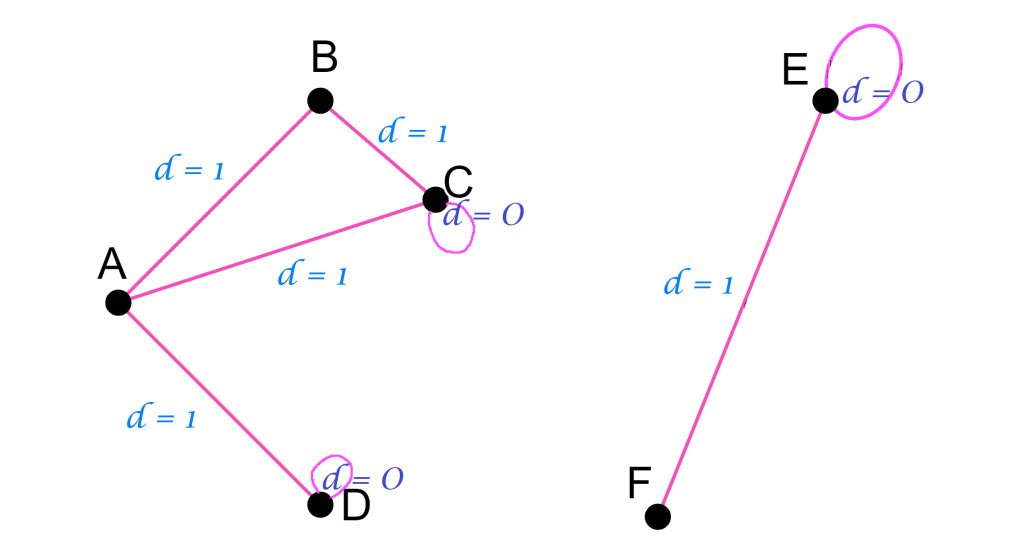

Definición 43.3. (Singularidad aislada: removible, polo y esencial.)

Sean $D\subset\mathbb{C}$ un dominio, $z_0\in D$ y $f:D\to\mathbb{C}$ una función. Si $f$ no es analítica en $z_0$, pero existe $R>0$ tal que el disco abierto perforado $B^*(z_0,R)$ está contenido en $D$ y $f$ es analítica en $B^*(z_0,R)$, entonces se dice que $z_0$ es una singularidad aislada de $f$. Si $z_0$ es una singularidad aislada de $f$, entonces se tienen los siguientes tipos de singularidades aisladas.

- Si existe una función $g:B(z_0,R)\to\mathbb{C}$ analítica en $B(z_0,R)$, tal que $f=g$ en $B^*(z_0,R)=A(z_0,0,R)$, entonces $z_0$ es llamada una singularidad removible de $f$.

- Si $\lim\limits_{z\to z_0} |f(z)| = \infty$, entonces $z_0$ es llamado un polo de $f$.

- Si $z_0$ no es removible ni un polo, entonces se dice que $z_0$ es una singularidad esencial de $f$.

Ejemplo 43.3.

Consideremos a la función $f:\mathbb{C}\setminus\{0\} \to \mathbb{C}$ dada por:

\begin{equation*}

f(z) = \frac{e^z-1}{z}.

\end{equation*}

Veamos que $z_0 = 0$ es una sigularidad removible de $f$.

Solución. Claramente $f$ es analítica en $\mathbb{C}\setminus\{0\}$, por lo que $z_0 = 0$ es una singularidad aislada de $f$. Sabemos que:

\begin{equation*}

e^z = \sum_{n=0}^\infty \frac{z^n}{n!}, \quad \forall z\in \mathbb{C},

\end{equation*}por lo que:

\begin{equation*}

e^z – 1 = \sum_{n=1}^\infty \frac{z^n}{n!}, \quad \forall z\in \mathbb{C}.

\end{equation*}

Entonces, definimos a la función $g:\mathbb{C}\to\mathbb{C}$ como:

\begin{equation*}

g(z):= \sum_{n=0}^\infty \frac{z^n}{(n+1)!},

\end{equation*}la cual es entera, corolario 39.1, ya que la serie que la define converge para todo $z\in\mathbb{C}$.

Para $z\neq 0$ tenemos que:

\begin{equation*}

f(z) = \frac{e^z-1}{z} = \frac{1}{z} \sum_{n=1}^\infty \frac{z^n}{n!} = \sum_{n=1}^\infty \frac{z^{n-1}}{n!} = \sum_{n=0}^\infty \frac{z^n}{(n+1)!} = g(z),

\end{equation*}por lo que $z_0 = 0$ es una singularidad removible de $f$.

Ejemplo 43.4.

Definimos a la función $f:\mathbb{C}\setminus\{0\} \to \mathbb{C}$ como:

\begin{equation*}

f(z) := \frac{1}{z^4}.

\end{equation*}

Veamos que $z_0 = 0$ es un polo de $f$.

Solución. Como $f$ es una función racional, entonces es analítica en $\mathbb{C}\setminus\{0\}$, por lo que $z_0 = 0$ es una singularidad aislada de $f$.

Dado que:

\begin{equation*}

\lim_{z\to 0} |f(z)| = \lim_{z\to 0} \left|\frac{1}{z^4}\right| = \infty,

\end{equation*}entonces $z_0 = 0$ es un polo de $f$.

Ejemplo 43.5.

Consideremos a la función $f:\mathbb{C}\setminus\{0\} \to \mathbb{C}$ dada por:

\begin{equation*}

f(z) = e^{1/z}.

\end{equation*}

Veamos que $z_0 = 0$ es una sigularidad esencial de $f$.

Solución. Es claro que $f$ es analítica en $\mathbb{C}\setminus\{0\}$, ya que en $0$ la función no es continua, por lo que $z_0 = 0$ es una singularidad aislada de $f$.

Para verificar el resultado, basta probar que $z_0 = 0$ no es una singularidad removible ni tampoco un polo.

Sea $z=x\in\mathbb{R}$. Notemos que:

\begin{equation*}

\lim_{z\to 0^+} |f(z)| = \lim_{x\to 0^+} \left|e^{1/x}\right| = \lim_{x\to 0^+} e^{1/x} = \infty,

\end{equation*}por lo que $z_0 = 0$ no puede ser una singularidad removible de $f$.

Por otra parte, para $z=x\in\mathbb{R}$, tenemos que:

\begin{equation*}

\lim_{z\to 0^-} |f(z)| = \lim_{x\to 0^-} \left|e^{1/x}\right| = \lim_{x\to 0^-} e^{1/x} = 0,

\end{equation*}por lo que $z_0 = 0$ no puede ser un polo de $f$.

Por lo tanto, $z_0 = 0$ es una singularidad esencial de $f$.

Observación 43.2.

De acuerdo con la definición 43.3, es claro que las funciones con singularidades aisladas tienen una expansión en serie de Laurent, ya que el disco abierto perforado $B^*(z_0,R)$, con $R>0$, es igual al anillo abierto $=A(z_0,0,R)$, por lo que podemos caracterizar a los tres tipos de singularidades aisladas definidos previamente, mediante una serie de Laurent.

Por el teorema de Laurent, tenemos que una función $f:A(z_0,0,R) \to \mathbb{C}$, con $R>0$, analítica en el anillo abierto $A(z_0,0,R)$ se puede represantar como:

\begin{equation*}

f(z) = \sum_{n=1}^\infty \frac{c_{-n}}{\left(z-z_0\right)^{n}} + \sum_{n=0}^\infty c_n \left(z-z_0\right)^n, \quad \forall z\in A(z_0,0,R).

\end{equation*}

Entonces, tenemos los siguientes casos:

- $c_{-n} =0$, para todo $n\in\mathbb{N}^+$.

En tal caso tenemos que:

\begin{equation*}

f(z) = \sum_{n=0}^\infty c_n \left(z-z_0\right)^n, \quad 0<|z-z_0|<R.

\end{equation*}Si definimos a la función $g:B(z_0,R) \to \mathbb{C}$ como:

\begin{equation*}

g(z) := \sum_{n=0}^\infty c_n \left(z-z_0\right)^n,

\end{equation*}por el corolario 39.1 tenemos que $g$ es analítica en el disco abierto $B(z_0,R)$ y para todo $z\in A(z_0,0,R)$ se cumple que $f=g$, por lo que en este caso se tiene que $z_0$ es una singularidad removible.

- Si existe $m\in\mathbb{N}^+$ tal que $c_{-m} \neq 0$ y $c_{-n} = 0$ para todo $n>m$.

En tal caso, para $0<|z-z_0|<R$ tenemos que:

\begin{align*}

f(z) & = \frac{c_{-m}}{(z-z_0)^m} + \cdots + \frac{c_{-1}}{z-z_0} + \sum_{n=0}^\infty c_n \left(z-z_0\right)^n\\

& = \frac{1}{(z-z_0)^m}\left[c_{-m} + \cdots + c_{-1}(z-z_0)^{m-1} + \sum_{n=0}^\infty c_n \left(z-z_0\right)^{n+m}\right]\\

& = \frac{h(z)}{(z-z_0)^m},

\end{align*}donde $h(z):= c_{-m} + \cdots + c_{-1}(z-z_0)^{m-1} + \sum_{n=0}^\infty c_n \left(z-z_0\right)^{n+m}$ es una función analítica, corolario 39.1, en $B^*(z_0,R)$, tal que $c_{-m} = h(z_0) \neq 0$.

Entonces:

\begin{equation*}

\lim\limits_{z\to z_0} |f(z)| = \lim\limits_{z\to z_0} \left| \frac{h(z)}{(z-z_0)^m} \right| = \lim\limits_{z\to z_0} \frac{|h(z)|}{|z-z_0|^m} = \infty,

\end{equation*}es decir, en este caso $z_0$ es un polo. En particular se dice que $z_0$ es un polo de orden $m\geq 1$, lo cual justificaremos más adelante.

- Si un número infinito de coeficientes de la parte principal de la serie de Laurent cumplen que $c_{-n} \neq 0$, entonces $z_0$ no es una singularidad removible ni un polo, es decir, en tal caso $z_0$ es una singularidad esencial.

Podemos caracterizar a las singularidades removibles como sigue.

Proposición 43.2.

Si $f$ es una función analítica en un disco abierto perforado $B^*(z_0, R)$, con $R>0$, entonces las siguientes condiciones son equivalentes.

- $z_0$ es una singularidad removible de $f$.

- $f(z) = \displaystyle \sum_{n=0}^\infty c_n \left(z-z_0\right)^n$ para $0<|z-z_0|<R$.

- $\lim\limits_{z\to z_0} f(z)$ existe y es finito.

- $\lim\limits_{z\to z_0} |f(z)|$ existe y es finito.

- Existen $M>0$ y $r>0$ tales que $|f(z)|<M$ para todo $z\in B^*(z_0,r)$.

- $\lim\limits_{z\to z_0} (z-z_0)f(z)=0$.

Demostración. Dadas las hipótesis tenemos que $(1) \Rightarrow (2)$ se sigue de la observación 43.2(1).

$(2) \Rightarrow (3)$ es una consecuencia de la continuidad de una serie de potencias, proposición 30.1.

$(3) \Rightarrow (4)$ se sigue de la continuidad de la función $g(z)=|z|$.

$(4) \Rightarrow (5)$ es una consecuencia de la definición de límite.

$(5) \Rightarrow (6)$ se sigue del teorema de comparación, proposición 14.4.

$(6) \Rightarrow (1)$ Supongamos que $\lim\limits_{z\to z_0} (z-z_0)f(z)=0$. Definimos a la función $g:B(z_0,R)\to\mathbb{C}$ como:

\begin{equation*}

g(z):= \left\{ \begin{array}{lcc} (z-z_0)^2 f(z) & \text{si} & z \neq z_0, \\ \\ 0 & \text{si} & z = z_0. \end{array} \right.

\end{equation*}

Claramente $g$ es analítica en $B^*(z_0,R)$. Tenemos que:

\begin{equation*}

g'(z_0) = \lim_{z \to z_0} \frac{g(z)-g(z_0)}{z-z_0} = \lim_{z \to z_0} \frac{(z-z_0)^2 f(z)}{z-z_0} = \lim\limits_{z\to z_0} (z-z_0)f(z)=0,

\end{equation*}por lo que $g$ es analítica en $B(z_0,R)$. Por el teorema de Taylor tenemos que:

\begin{equation*}

g(z) = \sum_{n=0}^\infty c_n \left(z-z_0\right)^n, \quad \forall z\in B(z_0,R).

\end{equation*}

Notemos que $c_0 = g(z_0) = 0$ y $c_1 = g'(z_0) = 0$, por lo que:

\begin{equation*}

g(z) = \sum_{n=2}^\infty c_n \left(z-z_0\right)^n = (z-z_0)^2\sum_{n=0}^\infty c_{n+2} \left(z-z_0\right)^n.

\end{equation*}

De donde:

\begin{equation*}

f(z) = \sum_{n=0}^\infty c_{n+2} \left(z-z_0\right)^n, \quad \forall z\in B^*(z_0,R).

\end{equation*}

Entonces $f=g$ en $B^*(z_0,R)$, por lo que $z_0$ es una singularidad removible de $f$.

$\blacksquare$

Corolario 43.1.

Si cualquier coeficiente $c_{-n} \neq 0$, con $n\in\mathbb{N}^+$, entonces $f$ no es acotada en ningún disco abierto con centro en $z_0$.

Demostración. Como existe $k\in\mathbb{N}^{+}$ tal que $c_{-k} \neq 0$, entonces $z_0$ no es una singularidad removible de $f$, lo cual implica que $f$ no sea acotada en ningún disco abierto.

$\blacksquare$

Ejemplo 43.6.

Veamos que las siguientes funciones tienen una singularidad removible en los puntos dados.

a) $f(z) = \dfrac{\operatorname{sen}(z)}{z}$ en $z_0 = 0$.

b) $f(z) = \dfrac{e^{z-1} – 1}{z-1}$ en $z_0 = 1$.

Solución.

a) Tenemos que:

\begin{equation*}

\lim\limits_{z\to z_0} (z-z_0)f(z) = \lim\limits_{z\to 0} (z-0) \dfrac{\operatorname{sen}(z)}{z} = \lim\limits_{z\to 0} \operatorname{sen}(z) = 0,

\end{equation*}por lo que $f$ tiene una singularidad removible en $z_0=0$.

b) Notemos que:

\begin{equation*}

\lim\limits_{z\to z_0} (z-z_0)f(z) = \lim\limits_{z\to 1} (z-1) \dfrac{e^{z-1} – 1}{z-1} = \lim\limits_{z\to 0} e^{z-1} – 1 = 0.

\end{equation*}

Entonces en $z_0=1$ la función $f$ tiene una singularidad removible.

Procedemos a caracterizar a un polo de una función analítica $f$.

Proposición 43.3.

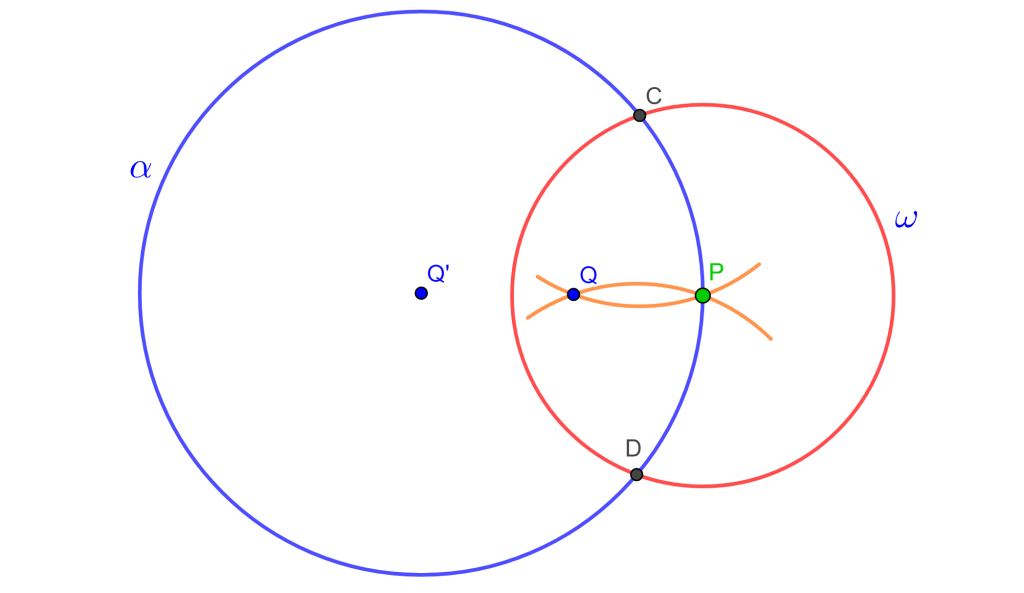

Sea $f$ una función analítica en un disco abierto perforado $B^*(z_0,R)$. Entonces $z_0$ es un polo de $f$ si y solo si $z_0$ no es una singularidad removible y existe $m\in\mathbb{N}^+$ tal que $\lim\limits_{z\to z_0} (z-z_0)^{m+1} f(z)=0$.

Demostración. Dadas las hipótesis, es claro que $z_0$ es una singularidad aislada de $f$ en $B^*(z_0,R)$.

$\Rightarrow)$ Supongamos que $z_0$ es un polo de $f$. Dado que $\lim\limits_{z\to z_0} |f(z)|=\infty$, entonces, proposición 43.2(4), $z_0$ no es una singularidad removible de $f$. Más aún, podemos encontrar $r>0$ tal que $f(z)\neq 0$ para todo $z\in B^*(z_0,r)$. Por lo tanto, la función $1/f$ es analítica en $B^*(z_0,r)$ y se cumple que:

\begin{equation*}

\lim_{z\to z_0} \frac{1}{f(z)} = 0 \quad \Longrightarrow \quad \lim_{z\to z_0} \frac{z-z_0}{f(z)} = 0,

\end{equation*}por lo que, proposición 43.2(6), $1/f$ tiene una singularidad removible en $z_0$. Entonces, la función:

\begin{equation*}

g:B(z_0,r) \to \mathbb{C},

\end{equation*}dada por:

\begin{equation*}

g(z) := \left\{ \begin{array}{lcc} \dfrac{1}{f(z)} & \text{si} & 0 < |z – z_0| < r, \\ \\ 0 & \text{si} & z = z_0, \end{array} \right. \tag{43.1}

\end{equation*}es analítica en $B(z_0,r)$.

Por la proposición 43.1(2) existen $m\in\mathbb{N}^+$ y $h:B(z_0,r) \to \mathbb{C}$ analítica tales que $g(z) = (z-z_0)^m h(z)$ y $h(z)\neq 0$ para todo $z\in B(z_0,r)$. Entonces:

\begin{equation*}

\lim_{z\to z_0} (z-z_0)^{m+1} f(z) = \lim_{z\to z_0} \frac{(z-z_0)^{m+1}}{g(z)} = \lim_{z\to z_0} \frac{z-z_0}{h(z)} = 0.

\end{equation*}

$(\Leftarrow$ Supongamos que $z_0$ no es una singularidad removible de $f$ y que $\lim\limits_{z\to z_0} (z-z_0)^{m+1} f(z) =0$ para algún $m\in\mathbb{N}^+$. Elegimos al menor número natural $m$ con esta propiedad. Sea $h(z):=(z-z_0)^m f(z)$, entonces $\lim\limits_{z\to z_0} h(z)=0$, por lo que, proposición 43.2(6), $z_0$ es una singularidad removible de $h$. Por lo tanto, existe $g:B(z_0,R)\to\mathbb{C}$ analítica tal que $h=g$ en $B^*(z_0,R)$. Notemos que si $m=0$, entonces $z_0$ es una singularidad removible de $f$, lo cual no es posible, entonces $m\geq 1$. Dado que elegimos a $m$ como el menor natural que cumple la hipótesis y $m-1\geq 0$ es menor que $m$, entonces:

\begin{equation*}

0 \neq \lim_{z\to z_0} (z-z_0)^{(m-1)+1} f(z) = \lim_{z\to z_0} (z-z_0)^{m} f(z) = \lim_{z\to z_0} h(z) = \lim_{z\to z_0} g(z) = g(z_0).

\end{equation*}

Por lo tanto, $g$ es una función analítica en $B(z_0,R)$ tal que $g(z_0)\neq 0$, $m\leq 1$ y:

\begin{equation*}

f(z) = \frac{g(z)}{(z-z_0)^m}, \quad \forall z\in B^*(z_0,R).

\end{equation*}

Entonces:

\begin{equation*}

\lim_{z\to z_0} |f(z)| = \lim_{z\to z_0} \left|\frac{h(z)}{(z-z_0)^m}\right| = \lim_{z\to z_0} \left|\frac{g(z)}{(z-z_0)^m}\right| = |g(z_0)| \lim_{z\to z_0} \frac{1}{|z-z_0|^m} = \infty,

\end{equation*}es decir, $z_0$ es un polo de $f$.

$\blacksquare$

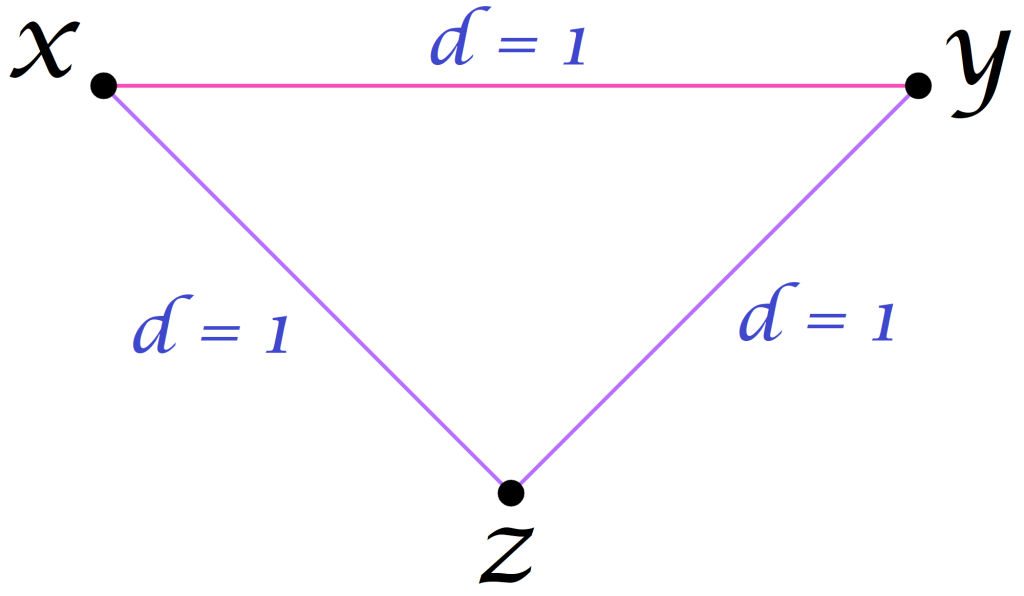

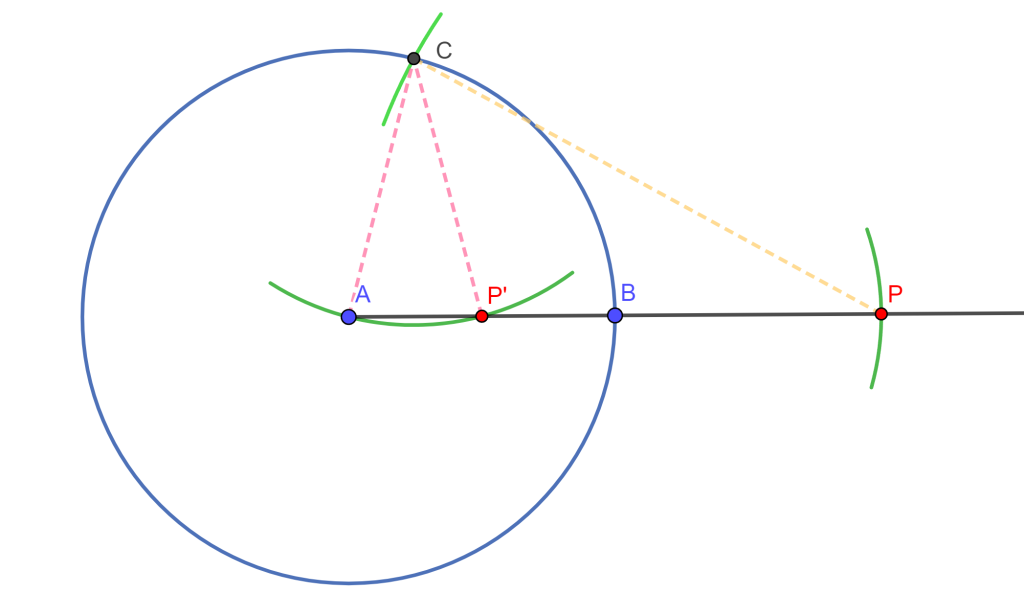

Corolario 43.2.

Sea $f$ una función analítica en un disco abierto perforado $B^*(z_0,R)$. Entonces $z_0$ es un polo de $f$ si y solo si existen $r>0$, $m\in\mathbb{N}^+$ y $g:B(z_0,r)\to\mathbb{C}$ analítica tal que $g(z_0) \neq 0$ y:

\begin{equation*}

f(z) = \frac{g(z)}{(z-z_0)^m}, \quad \forall z\in B^*(z_0,r).

\end{equation*}

Si $z_0$ es un polo de $f$, entonces $m$ es único.

Demostración. Dadas las hipótesis, solo basta probar la unicidad de $m$. Supongamos que existen $m_1, m_2 \in \mathbb{N}^+$ y $g_1, g_2:B(z_0,R)\to\mathbb{C}$ analíticas tales que $g_i(z_0) \neq 0$, para $i=1,2$ y se cumple que:

\begin{equation*}

f(z) = \frac{g_1(z)}{(z-z_0)^{m_1}} = \frac{g_2(z)}{(z-z_0)^{m_2}}, \quad \forall z\in B^*(z_0,r).

\end{equation*}

Sin pérdida de generalidad supongamos que $m_2>m_1$. Entonces:

\begin{equation*}

g_2(z) = g_1(z)(z-z_0)^{m_2 – m_1}.

\end{equation*}

Notemos que si $z=z_0$, entonces $g_2(z_0) = 0$, lo cual es una contradicción, por lo que $m$ es único.

$\blacksquare$

Definición 43.4. (Orden o multiplicidad de un polo.)

Sea $z_0$ un polo de una función analítica $f$ en $B^*(z_0,R)$. Se define al orden del polo de $f$ en $z_0$ como el entero positivo $m$ del corolario 43.1.

Considerando lo anterior, podemos establecer una caracterización más completa de los polos de una función analítica.

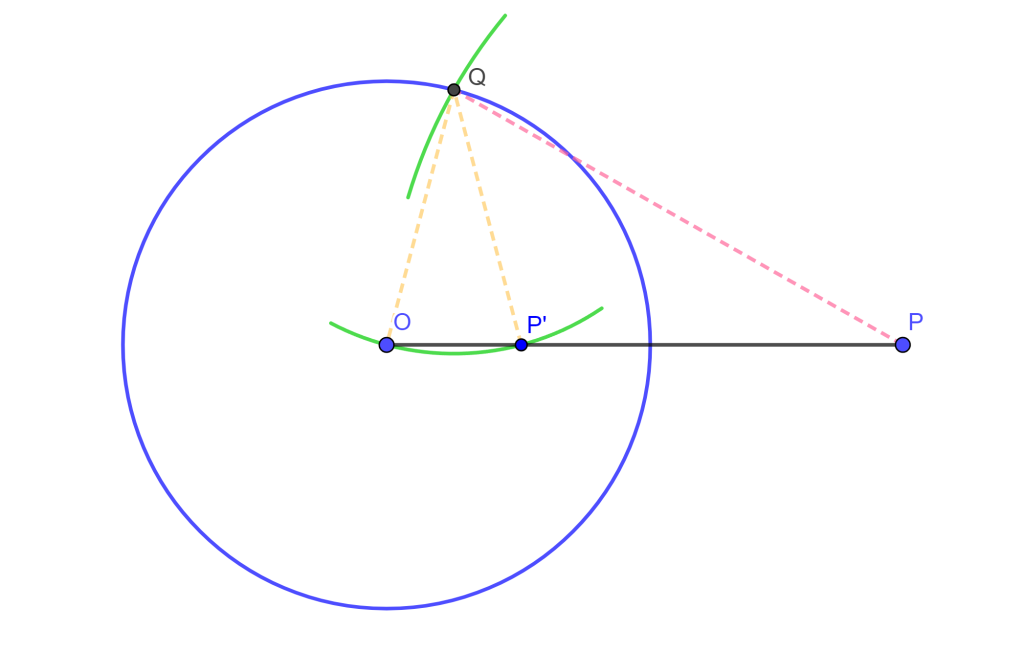

Proposición 43.3.

Si $f$ es una función analítica en un disco abierto perforado $B^*(z_0, R)$, con $R>0$, y $m \in \mathbb{N}^{+}$, entonces las siguientes condiciones son equivalentes.

- $z_0$ es un polo de $f$ de orden $m\geq 1$.

- Existen $r>0$ y $g:B(z_0,r) \to \mathbb{C}$ analítica tal que $g(z_0)\neq 0$ y:

\begin{equation*}

f(z) = \frac{g(z)}{(z-z_0)^m}, \quad \forall z\in B^*(z_0,r).

\end{equation*}

- $\lim\limits_{z\to z_0} (z-z_0)^m f(z)$ existe y es distinto de $0$.

- Existen $M>0$ y $\rho>0$ tales que $|(z-z_0)^m f(z)|<M$ para todo $z\in B^*(z_0,\rho)$.

- $\lim\limits_{z\to z_0} (z-z_0)^{m+1}f(z)=0$.

- En la expansión en serie de Laurent de $f$ se tiene que $c_{-n} = 0$ para todo $n>m$, es decir:

\begin{equation*}

f(z) = \frac{c_{-m}}{(z-z_0)^m} + \cdots + \frac{c_{-1}}{z-z_0} + \sum_{n=0}^\infty c_n \left(z-z_0\right)^n, \quad 0<|z-z_0|<R.

\end{equation*}

Demostración. Dadas las hipótesis tenemos que $(1) \Rightarrow (2)$ se sigue de la definición 43.4 y el corolario 43.2.

$(2) \Rightarrow (3)$ si suponemos válida (2), entonces $g(z) = (z-z_0)^m f(z)$, en $B^*(z_0,r)$. Como $g$ es analítica en $B(z_0,r)$ y $g(z_0) \neq 0$, entonces:

\begin{equation*}

0 \neq g(z_0) = \lim_{z\to z_0} g(z) = \lim_{z\to z_0} (z-z_0)^m f(z).

\end{equation*}

$(3) \Rightarrow (4)$ es una consecuencia de la definición de límite.

$(4) \Rightarrow (5)$ se sigue del teorema de comparación, proposición 14.4.

$(5) \Rightarrow (6)$ si suponemos que $\lim\limits_{z\to z_0} (z-z_0)^{m+1}f(z)=0$, entonces de la proposición 43.2(6) se sigue que la función $h(z):=(z-z_0)^{m}f(z)$, para $z\in B^*(z_0,R)$, tiene una singularidad removible en $z_0$, por lo que:

\begin{equation*}

(z-z_0)^{m}f(z) = h(z) = \sum_{n=0}^\infty c_n \left(z-z_0\right)^n, \quad 0<|z-z_0|<R,

\end{equation*}de donde, para $0<|z-z_0|<R$, se tiene que:

\begin{align*}

f(z) & = \sum_{n=0}^\infty c_n \left(z-z_0\right)^{n-m}\\

& = \frac{c_0}{(z-z_0)^m} + \cdots + \frac{c_{m-1}}{z-z_0} + \sum_{n=m}^\infty c_n \left(z-z_0\right)^{n}\\

& = \frac{c_0}{(z-z_0)^m} + \cdots + \frac{c_{m-1}}{z-z_0} + \sum_{n=0}^\infty c_{n+m} \left(z-z_0\right)^{n}.

\end{align*}

Entonces de la unicidad de la expansión en serie de Laurent de $f$ en $B^*(z_0,R)$, concluimos que $c_{-n} = 0$ para todo $n>m$.

$(6) \Rightarrow (1)$ se sigue de la observación 43.2(2).

$\blacksquare$

Ejemplo 43.7.

Determinemos el orden del polo $z_0=0$ de la función $f$ dada.

a) $f(z) = \operatorname{sen}(z) z^{-3}$.

b) $f(z) = (z \operatorname{sen}(z))^{-1}$.

Solución.

a) El orden del polo $z_0 =0$ es $2$ ya que para $z\neq 0$ se tiene que:

\begin{equation*}

f(z) = \frac{\operatorname{sen}(z)}{z^3} = \frac{1}{z^3} \sum_{n=0}^{\infty} \frac{(-1)^{n}z^{2n+1}}{(2n+1)!} = \sum_{n=0}^{\infty} \frac{(-1)^{n}z^{2n-2}}{(2n+1)!} = \frac{1}{z^2} – \frac{1}{3!} + \frac{z^2}{5!} – \cdots,

\end{equation*}y la menor potencia de $z$ con coeficiente distinto de $0$ es $-2$.

b) Tenemos que:

\begin{equation*}

\lim_{z \to z_0} z^2 f(z) = \lim_{z \to z_0} z^2 \frac{1}{z \operatorname{sen}(z)} = \lim_{z \to z_0} \frac{z}{\operatorname{sen}(z)} = 1 \neq 0,

\end{equation*}por lo que el orden del polo $z_0 = 0$ de $f$ es $2$.

Finalmente, como es de imaginarse, las singularidades aisladas más complicadas de caracterizar son las esenciales. Como muestra de esta complejidad mencionaremos los siguientes resultados.

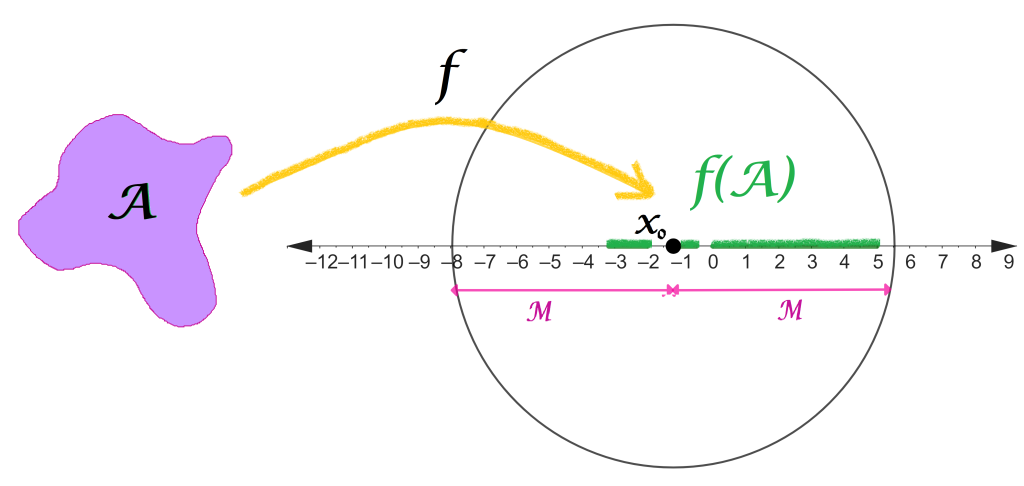

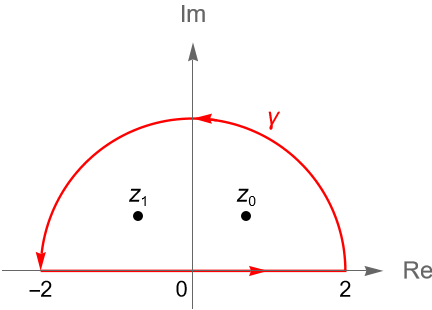

Teorema 43.1. (Teorema de Casorati-Weierstrass.)

Sea $f$ una función analítica en el disco abierto perforado $B^*(z_0, R)$, con $z_0\in\mathbb{C}$ fijo y $R>0$. Entonces, $z_0$ es una singularidad esencial de $f$ si y solo si se cumplen las siguientes dos condiciones.

- Existe una sucesión de números complejos $\{ z_n\}_{n\geq 1}$ en $B^*(z_0, R)$ tal que $\lim\limits_{n \to \infty} z_n = z_0$ y $\lim\limits_{n \to \infty} |f(z_n)| = \infty$.

- Para cualquier $w\in\mathbb{C}$, existe una sucesión de números complejos $\{ z_n\}_{n\geq 1}$ en $B^*(z_0, R)$, la cual depende de $w$, tal que $\lim\limits_{n \to \infty} z_n = z_0$ y $\lim\limits_{n \to \infty} f(z_n) = w$.

Se puede consultar una prueba de este resultado en Complex Analysis with Applications de Nakhlé H. Asmar y Loukas Grafakos.

Corolario 43.3. (Casorati-Weierstrass.)

Sea $z_0$ una singularidad esencial de $f$ y sea $E_r$ el conjunto de valores que toma $f$ en el disco abierto perforado $B^*(z_0,r)$, con $r>0$. Entonces $\overline{E}_r = \mathbb{C}$, es decir, $E_r$ es denso en $\mathbb{C}$.

Demostración. Dadas las hipótesis, basta probar que para cualquier $w\in \mathbb{C}$ y todo $\varepsilon>0$ existe $z\in B^*(z_0,r)$ tal que $|f(z)-w|<\varepsilon$.

Procedemos por contradicción. Supongamos que existen $w\in \mathbb{C}$ y $\varepsilon>0$ tales que para todo $z\in B^*(z_0,r)$ se cumple que:

\begin{equation*}

|f(z) – w| \geq \varepsilon.

\end{equation*}

Definimos a la función $g: B^*(z_0,r) \to \mathbb{C}$ como:

\begin{equation*}

g(z) := \frac{1}{f(z) – w}.

\end{equation*}

Notemos que:

\begin{equation*}

|g(z)| = \left| \frac{1}{f(z) – w} \right| \leq \frac{1}{\varepsilon}, \quad \forall z\in B^*(z_0,r),

\end{equation*}es decir, $g$ es acotada en $B^*(z_0,r)$. De la proposición 43.2(5) se sigue que $g$ tiene una singularidad removible en $z_0$, por lo que:

\begin{equation*}

0 = \lim_{z\to z_0} (z-z_0) g(z) = \lim_{z\to z_0} \frac{z-z_0}{f(z) – w} = 0.

\end{equation*}

Entonces:

\begin{equation*}

\lim_{z\to z_0} \left| \frac{f(z) – w}{z-z_0}\right| = \infty,

\end{equation*}es decir, la función $h(z):=\dfrac{f(z) – w}{z-z_0}$ tiene un polo en $z_0$. Por la proposición 43.3 tenemos que $z_0$ no es una singularidad removible de $h$ y existe $m\in\mathbb{N}^+$ tal que:

\begin{equation*}

0 = \lim_{z\to z_0} (z-z_0)^{m+1} h(z) = \lim_{z\to z_0} (z-z_0)^{m+1} \frac{f(z) – w}{z-z_0} = \lim_{z\to z_0} (z-z_0)^{m} [f(z) – w],

\end{equation*}de donde:

\begin{equation*}

\lim_{z\to z_0} (z-z_0)^{m+1} [f(z) – w] = 0.

\end{equation*}Por lo tanto, la función $f(z) – w$ tiene una singularidad removible en $z_0$ o un polo en $z_0$, lo cual implica que lo mismo se cumple para $f(z)$, lo cual contradice la hipótesis.

$\blacksquare$

El teorema 43.1 tiene la siguiente generalización, el cual es un resultado más fuerte. Se puede consultar una prueba del mismo en Function of One Complex Variable de John B. Conway.

Teorema 43.2 (Teorema grande de Picard.)

Si $f$ es una función analítica en el disco abierto perforado $B^*(z_0,R)$, con $R>0$, y $z_0$ es una singularidad esencial de $f$, entonces $f$ toma en $B^*(z_0,R)$ cualquier valor complejo finito, a excepción, posiblemente, de uno.

Podemos extender las definiciones de cero y singularidades para punto al infinito. Si $f$ es analítica en una vecindad de $\infty$, definición 14.3, es decir, $f$ es analítica para todo $|z|>R$, entonces $f(1/z)$ es analítica en el anillo $A(0,0,1/R)$, por lo que $0$ es una singularidad aislada de dicha función.

Definición 43.5. (Singularidades aisladas en $\infty$.)

Sea $f$ una función analítica para todo $|z|>R$. Entonces $f$ tiene:

- una singularidad removible en $\infty$ si $f(1/z)$ tiene una singularidad removible en $0$;

- un polo de orden $m$ si $f(1/z)$ tiene un polo de orden $m$ en $0$;

- una singularidad esencial en $\infty$ si $f(1/z)$ tiene singularidad esencial en $0$.

Cuando $f$ tiene una singularidad removible en $\infty$, entonces el $\lim\limits_{z \to \infty} f(z)$ existe. Mientras que si el $\lim\limits_{z \to \infty} f(z) = 0$, decimos que $f$ tiene un {\bf cero} en $\infty$.

Ejemplo 43.8.

La función $f(z)=\dfrac{z}{z^2+1}$ tiene un cero en $\infty$, ya que:

\begin{equation*}

\lim\limits_{z \to \infty} f(z) = \lim\limits_{z \to \infty} \dfrac{z}{z^2+1} = \lim\limits_{z \to \infty} \dfrac{\dfrac{1}{z}}{1 + \dfrac{1}{z^2}} = 0.

\end{equation*}

Mientras que la función $f(z)=\dfrac{z^2}{z^2+1}$ tiene una singularidad removible en $\infty$, ya que:

\begin{equation*}

\lim\limits_{z \to 0} (z-0)f\left(\frac{1}{z}\right) = \lim\limits_{z \to 0} z \dfrac{\dfrac{1}{z^2}}{\dfrac{1}{z^2}+1} = \lim\limits_{z \to 0} \dfrac{\dfrac{1}{z}}{\dfrac{1}{z^2}+1} = 0.

\end{equation*}

Notemos que:

\begin{equation*}

\lim\limits_{z \to 0} f\left(\frac{1}{z}\right) = \lim\limits_{z \to 0} \dfrac{\dfrac{1}{z^2}}{\dfrac{1}{z^2}+1} = \lim\limits_{z \to 0} \dfrac{1}{1+z^2} = 1,

\end{equation*}

por lo que, proposición 14.5(2), se tiene que:

\begin{equation*}

\lim\limits_{z \to \infty} f(z) = 1.

\end{equation*}

Por otra parte, la función $f(z)=z^5$ tiene un polo de orden $5$ en $\infty$ ya que:

\begin{equation*}

\lim\limits_{z \to 0} (z-0)^5 f\left(\frac{1}{z}\right) = \lim\limits_{z \to 0} z^5 \left(\frac{1}{z^5}\right) = \lim\limits_{z \to 0} 1 = 1 \neq 0.

\end{equation*}

Por último, se deja como ejercicio al lector verificar que la función $f(z) = ze^{-z}$ tiene una singularidad esencial en $\infty$.

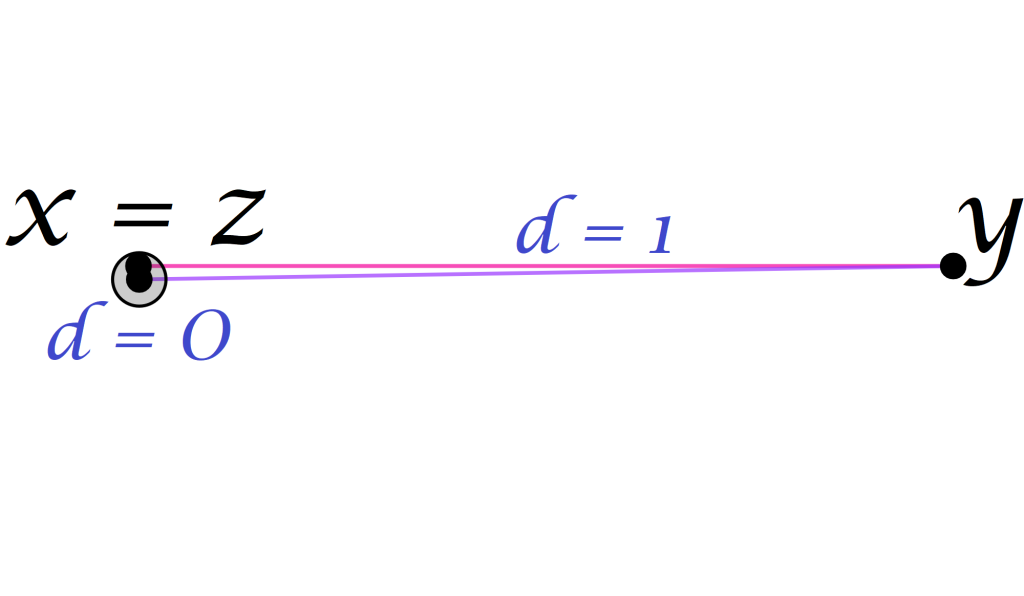

Definición 43.6. (Función meroforma.)

Sean $D\subset\mathbb{C}$ un dominio y $f : D \to \mathbb{C}$ una función analítica en $D$. Se dice que $f$ es meromorfa si y solo si sus únicas singularidades aisladas son removibles o polos.

Ejemplo 43.9.

La función $f(z) = \dfrac{1}{z}$ es analítica en $\mathbb{C}\setminus\{0\}$ y $0$ es un polo de $f$, por lo que $f$ es meromorfa.

Por otra parte, la función $f(z) = \dfrac{1}{\operatorname{sen}(z)}$ es analítica en $\mathbb{C}\setminus\{n\pi : n\in\mathbb{Z}\}$ y para cada $n\in\mathbb{Z}$ el punto $n\pi$ es un polo de $f$, entonces $f$ es meromorfa.

Tarea moral

- Determina los ceros aislados de cada función y en cada caso obtén el orden de cada cero.

a) $f(z) = (1-z^2)\operatorname{sen}(z)$.

b) $f(z) = z^3(e^z-1)$.

c) $f(z) = \dfrac{z(z-1)^2}{z^2+2z-1}$.

d) $f(z) = \operatorname{senh}(z)$.

- Obtén el orden del cero $z_0 = 0$ de cada una de las siguientes funciones.

a) $f(z) = z\operatorname{Log}(1+z)$.

b) $f(z) = \operatorname{tan}(z)$.

c) $f(z) = 1-\dfrac{z^2}{2}-\operatorname{cos}(z)$.

d) $f(z) = z-\operatorname{sen}(z)$.

- Clasifica las singularidades aisladas de cada una de las siguientes funciones. No consideres el caso en $\infty$.

a) $f(z) = \dfrac{1-z^2}{\operatorname{sen}(z)} + \dfrac{z-1}{z+1}$.

b) $f(z) =\dfrac{z}{e^z -1}$.

c) $f(z) = \dfrac{z \operatorname{sen}(z)}{\operatorname{cos}(z)-1}$.

d) $f(z) = z\operatorname{sen}\left(\dfrac{1}{z}\right)$.

- Determina si las siguientes funciones tienen una singularidad removible en $\infty$ y algún cero en $\infty$.

a) $f(z) = \dfrac{1}{z+1}$.

b) $f(z) =\dfrac{z}{e^z -1}$.

c) $f(z) = e^z -\operatorname{cos}\left(\dfrac{1}{z}\right)$.

d) $f(z) =\dfrac{z^2-1}{z^2+2z+3i}$.

- Muestra que:

a) si $f$ tiene un cero de orden $m\geq 1$ en $z_0$ y $g$ tiene un cero de orden $k\geq 1$ en $z_0$, entonces $fg$ tiene un cero de orden $m+k$ en $z_0$;

b) si $f$ tiene un polo de orden $m\geq 1$ en $z_0$ y $g$ tiene un cero de orden $k\geq 1$ en $z_0$, entonces $fg$ tiene un polo de orden $m-k$ en $z_0$, si $m>k$, un cero de orden $k-m$ si $k>m$ y una singularidad removible en $z_0$ si $m=k$;

c) si $f$ tiene una singularidad removible en $z_0$ y $g$ es una función analítica en $z_0$, entonces $fg$ tiene una singularidad removible en $z_0$.

- Prueba que una función $f$ tiene un polo de orden $m\geq 1$ en $z_0$ si y solo si la función $1/f$ tiene una singularidad removible en $z_0$.

- Muestra que si una función $f$ tiene un cero de orden $m\geq 1$ en $z_0$, entonces la función $1/f$ tiene un polo de orden $m\geq 1$ en $z_0$.

- Prueba que si una función $f$ tiene un polo de orden $m\geq 1$ en $z_0$ y se define a $1/f(z_0) = 0$, entonces la función $1/f$ tiene un cero de orden $m\geq 1$ en $z_0$.

Más adelante…

En esta entrada hemos establecido una clasificación de los ceros y las singularidades de una función analítica. Probamos algunos resultados que nos permiten caracterizar a dichos puntos y en particular identificarlos. Como vimos, estos puntos son de interés pues nos permiten comprender mejor el comportamiento de las funciones analíticas.

La siguiente entrada es la última de este curso. En ella abordaremos el Teorema del Residuo y veremos que la clasificación de las distintas singularidades de una función analítica nos facilitará el cálculo de residuos.

Entradas relacionadas