Introducción

Uno de los momentos del curso de Álgebra Lineal I en el que se da un brinco de abstracción es cuando se introduce el espacio dual. En ese momento, empiezan a aparecer objetos que tratamos simultáneamente como funciones y como vectores: las formas lineales. De repente puede volverse muy difícil trasladar incluso conceptos muy sencillos (como el de suma vectorial, o el de independencia lineal) a este contexto. En esta entrada intentaremos dejar esto mucho más claro.

Igualdad de funciones

Para hablar del dual de un espacio vectorial $V$ sobre un campo $F$, necesitamos hablar de las funciones $l:V\to F$. Antes de cualquier cosa, debemos de ponernos de acuerdo en algo crucial. ¿Cuándo dos funciones son iguales?

Definición. Dos funciones $f:A\to B$ y $g:C\to D$ son iguales si y sólo si pasan las siguientes tres cosas:

- $A=C$, es decir, tienen el mismo dominio.

- $B=D$, es decir, tienen el mismo codominio

- $f(a)=g(a)$ para todo $a\in A$, es decir, tienen la misma regla de asignación.

Los dos primeros puntos son importantes. El tercer punto es crucial, y justo es lo que nos permitirá trabajar y decir cosas acerca de las funciones. Implica dos cosas:

- Que si queremos demostrar la igualdad de dos funciones, en parte necesitamos demostrar que se da la igualdad de las evaluaciones para todos los elementos del conjunto.

- Que si ya nos dan la igualdad de las funciones, entonces nos están dando muchísima información, pues nos están diciendo la igualdad de todas las evaluaciones posibles.

Veamos algunos ejemplos.

Ejemplo 1. Tomemos las funciones $f:\mathbb{R}^2\to \mathbb{R}$ y $g:\mathbb{R}^2\to\mathbb{R}$ con las reglas de asignación $f(x,y)=2x+3y$ y $g(x,y)=6x-y$. ¿Son iguales? Los primeros dos puntos en la definición de igualdad se cumplen, pues tienen el mismo dominio y codominio. Entonces, debemos estudiar si tienen la misma regla de asignación.

Al evaluar en $(1,1)$ obtenemos que $f(1,1)=2+3=5$ y que $g(1,1)=6-1=5$. Al evaluar en $(2,2)$ obtenemos que $f(2,2)=4+6=10$ y que $g(2,2)=12-2=10$. Hasta aquí parecería que todo va bien, pero dos ejemplos no son suficientes para garantizar que $f=g$. Necesitaríamos la igualdad en todos los valores del dominio, es decir, en todas las parejas $(x,y)$.

Al evaluar en $(2,0)$ obtenemos que $f(2,0)=4+0=4$ y que $g(2,0)=12-0=12$. Los valores de las funciones fueron distintos, así que las funciones son distintas.

$\triangle$

Ejemplo 2. Imagina que $A$ y $B$ son dos números tales que las dos funciones $f:\mathbb{R}^2\to \mathbb{R}$ y $g:\mathbb{R}^2\to\mathbb{R}$ con las siguientes reglas de asignación son iguales:

\begin{align*}

f(x,y)&=2x-5y+A\\

g(x,y)&=Bx-5y+3.

\end{align*}

¿Cuáles tendrían que ser los valores de $A$ y $B$? Por supuesto, una exploración «a simple vista» sugiere que tendríamos que poner $B=2$ y $A=3$. Pero, ¿cómo vemos formalmente esto? ¿Cómo nos aseguramos de que sea la única posibilidad? Lo que tenemos que hacer es usar nuestra definición de igualdad de funciones. Para ello, podemos utilizar los valores $(x,y)$ que nosotros queremos pues la igualdad de funciones garantiza la igualdad en todas las evaluaciones. Así, podemos ponernos creativos y proponer $(3,5)$ para obtener que:

\begin{align*}

f(3,5)&=6-25+A=-19+A\\

g(3,5)&=3B-25+3=3B-22.

\end{align*}

Como las funciones son iguales, debe pasar que $f(3,5)=g(3,5)$, por lo que $-19+A=3B-22$. ¿Esto es suficiente para saber quién es $A$ y $B$? Todavía no, aún hay muchas posibilidades. Propongamos entonces otro valor de $(x,y)$ para evaluar. Veamos qué sucede con $(-2,1)$. Obtenemos:

\begin{align*}

f(-2,1)&=-4-5+A=-9+A\\

g(-2,1)&=-2B-5+3=-2B-2.

\end{align*}

Ahora tenemos más información de $A$ y $B$. Sabemos que $-9+A=-2B-2$. Reordenando ambas cosas que hemos obtenido hasta ahora, tenemos el siguiente sistema de ecuaciones:

\begin{align*}

A-3B=-3\\

A+2B=7.

\end{align*}

Restando la primera de la segunda obtenemos $5B=10$, de donde $B=2$. Sustituyendo en la segunda obtenemos $A+4=7$, de donde $A=3$, justo como queríamos.

$\triangle$

En el ejemplo anterior pudimos haber sido más astutos y evitarnos el sistema de ecuaciones. Recordemos que la igualdad $f(x,y)=g(x,y)$ se tiene para todas todas las parejas $(x,y)$, así que nos conviene usar parejas que 1) Sean sencillas de usar y 2) Nos den suficiente información.

Ejemplo 3. En el ejemplo anterior hicimos un par de sustituciones que finalmente sí nos llevaron a los valores que queríamos. Pero hay «mejores» sustituciones. Si hubiéramos usado la pareja $(0,0)$ obtendríamos inmediatemente $A$ pues: $$A=0-0+A=f(0,0)=g(0,0)=0-0+3=3,$$ de donde $A=3$. Ya sabiendo $A$, pudimos usar la pareja $(1,0)$ para obtener $$B+3=B-0+3=g(1,0)=2-0+3=5.$$ De aquí se obtiene nuevamente $B=2$.

$\triangle$

Veamos un último ejemplo, en el que es imposible encontrar un valor fijo que haga que dos funciones que nos dan sean iguales.

Ejemplo 4. Veamos que es imposible encontrar un número real $A$ para el cual las dos funciones $f:\mathbb{R}^2\to\mathbb{R}$ y $g:\mathbb{R}^2\to \mathbb{R}$ con las siguientes reglas de asignación sean iguales:

\begin{align*}

f(x,y)&=x^2+Ay^2\\

g(x,y)&=Axy.

\end{align*}

Imaginemos, de momento, que esto sí es posible. Entonces, tendríamos la igualdad de funciones y por lo tanto tendríamos la igualdad para todas las evaluaciones. Evaluando en $(1,0)$ obtendríamos que $$0=A\cdot 1 \cdot 0 = g(1,0)=f(1,0)=1^2+A\cdot 0^2=1.$$ Esto nos lleva a la contradicción $0=1$, lo cual muestra que ningún valor de $A$ podría funcionar.

$\triangle$

La forma lineal cero

Otra noción básica, pero que es importante de entender, es la noción de la forma lineal cero.

Definición. Sea $V$ un espacio vectorial sobre un campo $F$. Sea $0$ el neutro aditivo del campo $F$. La forma lineal cero es la función $L_0:V\to F$ que manda a cualquier vector $v$ de $V$ a $0$, es decir, cuya regla de asignación es $L_0(v)=0$ para todo $v$ en $V$.

En álgebra lineal rápidamente nos queremos deshacer de notación estorbosa, pues muchas cosas son claras a partir del contexto. Pero esto tiene el problema de introducir ambigüedades que pueden ser confusas para alguien que apenas está comenzando a estudiar la materia. Lo que prácticamente siempre se hace es que a la forma lineal cero le llamamos simplemente $0$, y dejamos que el contexto nos diga si nos estamos refiriendo al neutro aditivo de $F$, o a la forma lineal cero $L_0$.

En esta entrada intentaremos apegarnos a llamar a la forma lineal cero siempre como $L_0$, pero toma en cuenta que muy probablemente más adelante te la encuentres simplemente como un $0$. Combinemos esta noción con la de igualdad.

Ejemplo. ¿Cómo tienen que ser los valores de $A$, $B$ y $C$ para que la función $l:\mathbb{R}^3\to \mathbb{R}$ con la siguiente regla de asignación sea igual a la forma lineal cero $L_0$? $$f(x,y,z)=(A+1)x+(B+C)y+(A-C)z$$

Debemos aprovechar la definición de igualdad de funciones: sabemos que la igualdad se da para las ternas que nosotros queramos. Evaluando en $(1,0,0)$ obtenemos $$A+1 = f(1,0,0)=L_0(1,0,0)=0.$$

Aquí a la derecha estamos usando que la forma lineal cero siempre es igual a cero. De manera similar, evaluando en $(0,1,0)$ y $(0,0,1)$ respectivamente obtenemos que \begin{align*}B+C&=f(0,1,0)=L_0(0,0,0)=0\\A-C&=f(0,0,1)=L_0(0,0,0)=0.\end{align*}

Ya tenemos información suficiente para encontrar $A$, $B$ y $C$. De la primer ecuación que obtuvimos, se tiene $A=-1$. De la tercera se tiene $C=A=-1$ y de la segunda se tiene $B=-C=1$.

Pero, ¡momento! Estos valores de $A$, $B$, $C$ funcionan para las tres ternas que dimos. ¿Funcionarán para cualquier otra terna? Si elegimos $A=-1$, $B=1$ y $C=-1$ entonces tendríamos $$f(x,y,z)=0\cdot x + 0\cdot y + 0\cdot z.$$ En efecto, sin importar qué valores de $(x,y,z)$ pongamos, la expresión anterior dará cero. Así, se daría la igualdad de reglas de correspondencia entre $f$ y $L_0$ y como tienen el mismo dominio y codominio concluiríamos que $f=L_0$.

$\triangle$

Suma y producto escalar de formas lineales

Otro aspecto que puede causar confusión es la suma de funciones y el producto escalar. En la duda, siempre hay que regresar a la definición. Enunciaremos los conceptos para formas lineales. Pero en realidad podemos definir la suma de funciones de manera similar siempre que el codominio sea un lugar en donde «se puede sumar». Similarmente, podríamos definir el producto escalar de un elemento con una función siempre que sepamos cómo multiplicar a ese elemento con cada elemento del codominio.

Definición. Sea $V$ un espacio vectorial sobre un campo $F$. Sean $l:V\to F$ y $m:V\to F$ formas lineales. Definimos la suma de $l$ con $m$, a la cual denotaremos por $l+m$, como la función $l+m:V\to F$ con la siguiente regla de asignación:$$(l+m)(v)=l(v)+m(v),$$ para cualquier $v$ en $V$.

De nuevo nos estamos enfrentando a un posible problema de ambigüedad de símbolos: por un lado estamos usando $+$ para referirnos a la suma en el campo $F$ y por otro lado para referirnos a la suma de funciones que acabamos de definir.

Definición. Sea $V$ un espacio vectorial sobre un campo $F$. Sea $l:V\to F$ una forma lineal y sea $r$ un elemento de $F$. Definimos el producto escalar de $r$ con $F$, al cual denotaremos por $r\cdot l$ como la función $r\cdot l:V\to F$ con la siguiente regla de asignación:$$(r\cdot l)(v)=r\cdot (l(v))$$ para cualquier $v$ en $V$.

Así, estamos usando tanto la suma en $F$ como el producto en $F$ para definir una nueva suma de funciones y un nuevo producto entre un real y una función. En el caso del producto escalar, como con muchos otros productos, usualmente quitamos el punto central y ponemos $rl$ en vez de $r\cdot l$.

Ejemplo. Tomemos las funciones $f:\mathbb{R}^3\to \mathbb{R}$ y $g:\mathbb{R}^3\to \mathbb{R}$ con las siguientes reglas de asignación:

\begin{align*}

f(x,y,z)&=2x-y+z\\

g(x,y,z)&=3x+y-5z.

\end{align*}

Mostraremos que la función $3f+(-2)g$ es igual a la función $h:\mathbb{R}^3\to \mathbb{R}$ con regla de asignación $h(x,y,z)=-5y+13z$. Lo haremos con todo el detalle posible. Primero, notamos que las dos funciones tienen dominio $\mathbb{R}^3$ y codominio $\mathbb{R}$ así que nos podemos enfocar en la regla de asignación. Debemos ver que ambas coinciden para todas las ternas $(x,y,z)$ en $\mathbb{R}^3$. Tomemos entonces una de estas ternas $(x,y,z)$.

Por definición de producto escalar de funciones, tenemos que $$(3f)(x,y,z)=3(f(x,y,z))=3(2x-y+z)=6x-3y+3z.$$. Aquí estamos usando la distributividad en los reales. Por definición de producto escalar de funciones, tenemos que $$ ((-2)g)(x,y,z)=(-2)(g(x,y,z))=(-2)(3x+y-5z)=-6x-2y+10z.$$ Una vez más estamos usando distributividad. Luego, por definición de suma de funciones obtenemos que

\begin{align*}

(3f+(-2)g)(x,y,z)&=(3f)(x,y,z)+(-2g)(x,y,z)\\

&= (6x-3y+3z)+(-6x-2y+10z)\\

& = -5y+13z\\

&= h(x,y,z).

\end{align*}

$\square$

Usualmente tomamos atajos para seguir simplificando la notación. Por ello, típicamente a veces vemos escrito todo lo anterior simplemente como: $$3(2x-y+z)-2(2x+y-5z)=-5y+13z.$$ De hecho esto es muy práctico, pues se puede mostrar que las funciones «sí podemos operarlas como si fueran expresiones en $x$, $y$, $z$ y usáramos las reglas usuales». Así, podemos «trabajar simbólicamente» y concluir rápidamente que $$(x+y)+(3x+2z)-3(x+y-z)$$ en verdad tiene la misma regla de asignación que $-2y+5z$.

Ahora sí, ¿quién es el espacio dual?

Si tenemos un espacio vectorial $V$ sobre un campo $F$ podemos construirnos otro espacio vectorial con otro conjunto base y otras operaciones que no son las del espacio original. Una forma de hacer esto es construir el espacio dual, al que llamaremos $V^\ast$. Los elementos de $V^\ast$ son las formas lineales de $V$, es decir, funciones lineales con dominio $V$ y codominio $F$. Debemos acostumbrarnos a pensar simultáneamente a un elemento de $V^\ast$ tanto como un vector (de $V^\ast$) como una función (de $V$ a $F$).

Para verdaderamente pensar a $V^\ast$ como un espacio vectorial, debemos establecer algunas cosas especiales:

- La suma vectorial de $V^\ast$ será la suma de funciones que platicamos en la sección anterior.

- El producto escalar vectorial de $V^\ast$ será el producto escalar que platicamos en la sección anterior.

- El neutro aditivo vectorial de $V^\ast$ será la forma lineal $L_0$, y se puede verificar que en efecto $l+L_0=l$ para cualquier forma lineal $l$.

Por supuesto, típicamente a la suma vectorial le llamaremos simplemente «suma» y al producto escalar vectorial simplemente «producto escalar». Aquí estamos haciendo énfasis en lo de «vectorial» sólo para darnos cuenta de que nuestras operaciones de funciones se transformaron en operaciones para el espacio vectorial que estamos definiendo.

El espacio dual cumple muchas propiedades bonitas, pero ahorita no nos enfocaremos en enunciarlas y demostrarlas. Esto se puede encontrar en la página del curso de Álgebra Lineal I en el blog. Lo que sí haremos es irnos a los básicos y entender cómo se verían algunas definiciones básicas de álgebra lineal en términos de lo que hemos discutido hasta ahora.

Combinaciones lineales de formas lineales

Para hablar de las nociones de álgebra lineal para formas lineales, hay que pensarlas como vectores y como funciones. ¿Qué sería una combinación lineal de las formas lineales $l_1,\ldots,l_r$ del espacio vectorial, digamos, $\mathbb{R}^n$. Debemos tomar elementos $\alpha_1,\ldots,\alpha_r$ en $\mathbb{R}$ y construir la función $\ell=\alpha_1l_1+\ldots+\alpha_rl_r$. Aquí estamos usando la suma vectorial y el producto escalar vectorial que quedamos que serían la suma como funciones y el producto escalar como funciones. Así, obtenemos un elemento $\ell$ que por un lado es un vector del espacio dual, y por otro es una función $\ell:\mathbb{R}^n\to \mathbb{R}$. ¿Cuál es la regla de asignación? Es precisamente la dada por las definiciones de suma y producto escalar para funciones. Para ser muy precisos, se puede mostrar inductivamente que su regla de asignación es:

\begin{align*}

(\alpha_1l_1+&\ldots+\alpha_rl_r)(x_1,\ldots,x_n)=\\

&\alpha_1(l_1(x_1,\ldots,x_n))+\ldots+\alpha_r(l_r(x_1,\ldots,x_n)).

\end{align*}

Entendiendo esto, ahora sí podemos preguntarnos si una forma lineal es combinación lineal de otras.

Ejemplo. La forma lineal $h:\mathbb{R}^2\to\mathbb{R}$ con regla de asignación $h(x,y)=2x-y$ es combinación lineal de las formas lineales $f(x,y):\mathbb{R}^2\to\mathbb{R}$ y $g(x,y):\mathbb{R}^2\to\mathbb{R}$ con reglas de asignación

\begin{align*}

f(x,y)&=x+y\\

g(x,y)&=x-y.

\end{align*}

En efecto, tenemos que es igual a la combinación lineal $\frac{1}{2}f + \frac{3}{2} g$, pues su regla de asignación es:

$$\left(\frac{1}{2}f + \frac{3}{2} g\right)(x,y)=\left(\frac{x+y}{2}\right)+\left(\frac{3x-3y}{2}\right)=2x-y,$$

que es justo la regla de asignación de $h$. Así, $h=\frac{1}{2}f+\frac{3}{2}g$.

$\triangle$

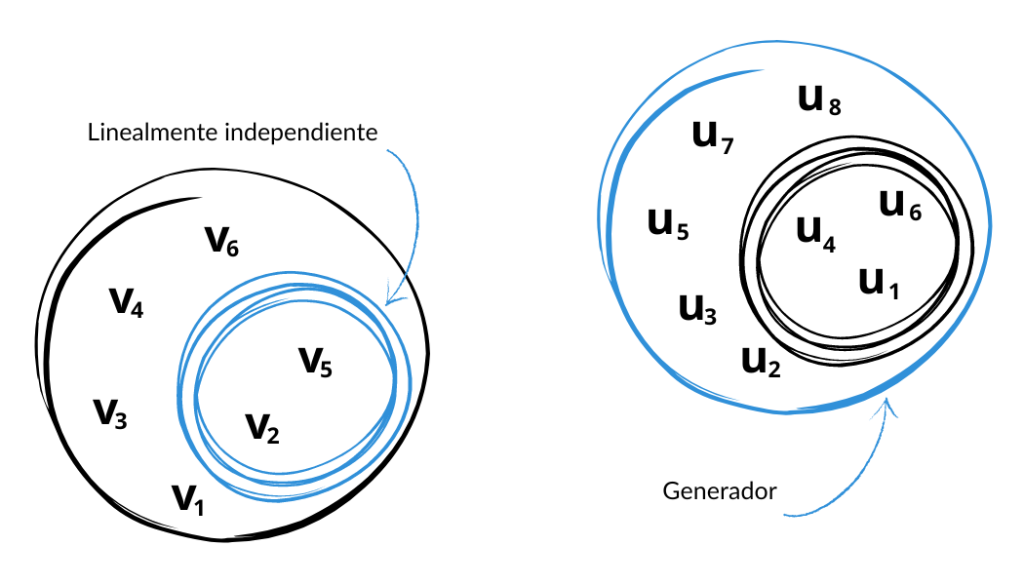

Independencia lineal de formas lineales

Veamos un ejemplo más de cómo entender nociones de álgebra lineal cuando hablamos de formas lineales (o funciones en general). ¿Cómo sería el concepto de independencia lineal para formas lineales $l_1,\ldots,l_r$? A partir de una combinación lineal de ellas igualada a la forma lineal cero $L_0$, debemos mostrar que todos los coeficientes son iguales a cero. Es decir, a partir de $$\alpha_1l_1+\ldots+\alpha_rl_r=L_0,$$ debemos mostrar que $\alpha_1=\ldots=\alpha_r=0.$$ Usualmente el truco en estas situaciones es que ya nos están dando una igualdad de funciones. Entonces, podemos evaluar en los valores que nosotros queramos de ambos lados de la igualdad pues funciones iguales tienen todas sus evaluaciones iguales. Esto se parece a los ejemplos de la sección de igualdad de funciones.

Ejemplo. Vamos a demostrar que las formas lineales de $\mathbb{R}^4$ dadas por $f(w,x,y,z)=4w+2x+z$, $g(w,x,y,z)=4w+2z+y$, $h(w,x,y,z)=4w+2y+x$, $k(w,x,y,z)=w+x+y+z$ son linealmente independientes. Tomemos una combinación lineal de ellas igualda a cero (¡recordemos que en este espacio vectorial el cero es la forma lineal $L_0$!):

$$Af+Bg+Ch+Dk=L_0.$$

Debemos demostrar que $A=B=C=D=0$. ¿Cómo hacemos esto? Lo que haremos es evaluar: pondremos valores convenientes de $(w,x,y,z)$ en la igualdad anterior para obtener información de $A$, $B$, $C$, $D$. Poniendo $(1,0,0,0)$ obtenemos que:

\begin{align*}

0&=L_0(1,0,0,0)\\

&= (Af+Bg+Ch+Dk)\\

&=Af(1,0,0,0)+ Bg(1,0,0,0) +Ch(1,0,0,0) +Dk(1,0,0,0) \\

&=4A + 4B + 4C + D.

\end{align*}

Así, $4A+4B+4C+D=0$. Usando esta ecuación y las evaluaciones $(0,1,0,0)$, $(0,0,1,0)$ y $(0,0,0,1)$, obtenemos todo lo siguiente:

\begin{align*}

4A+4B+4C+D&=0\\

2A+C+D&=0\\

B+2C+D&=0\\

A+2B+D&=0.

\end{align*}

De aquí se puede mostrar (como puedes verificar como ejercicio) que la única solución posible es $A=B=C=D=0$. De este modo, las formas lineales $f,g,h,k$ son linealmente independientes.

$\square$

Más adelante

Esta es más una entrada auxiliar que una entrada que forma parte del flujo de la teoría principal. Sin embargo, espero que te haya servido para dejar más claros los conceptos de cuándo tenemos formas lineales iguales, cómo se operan, cuándo varias formas lineales son linealmente independientes, etc.

Tarea moral…

- Verifica que para cualquier forma lineal $l:\mathbb{R}^n\to \mathbb{R}$ y la forma lineal cero $L_0:\mathbb{R}^n\to\mathbb{R}$ en efecto se tiene que $l+L_0=l$. Usa las definiciones de la forma lineal cero, de la igualdad de funciones y de la suma de funciones.

- Verifica que $V^\ast$ con las operaciones de suma, producto escalar y el neutro aditivo que dimos en efecto es un espacio vectorial. ¿Cómo tendrían que ser los inversos aditivos?

- Considera las formas lineales $f:\mathbb{R}^3\to \mathbb{R}$ y $g:\mathbb{R}^3 \to \mathbb{R}$ dadas por $f(x,y,z)=x+3y+z$ y $g(x,y,z)=-x+5y-z$.

- Demuestra que es imposible encontrar reales $A$ y $B$ ambos distintos de cero tales que $Af+Bg$ sea la forma lineal cero.

- Encuentra reales $A$ y $B$ tales que $Af+Bg$ sea la forma lineal $h:\mathbb{R}^3\to \mathbb{R}$ con regla de asignación $h(x,y,z) = -x + 21 – z$.

- Demuestra que es imposible encontrar reales $A$ y $B$ tales que $Af+Bg$ sea la forma lineal $j:\mathbb{R}^3\to \mathbb{R}$ con regla de asignación $j(x,y,z)= -2x + 4y -3z$.

- ¿Será posible encontrar reales $A$ y $B$ tales que $Af+Bg$ sea la forma lineal $k:\mathbb{R}^3\to \mathbb{R}$ con regla de asignación $k(x,y,z)=5x+5y+5z$?

- Para cada uno de los siguientes casos, determina si las formas lineales son linealmente independientes:

- $f(x,y)=5x+3y$, $g(x,y)=x-3y$.

- $f(x,y,z)=5x+2y-z$, $g(x,y,z)=z$, $h(x,y,z)=x-y-z$.

- $f(w,x,y,z)=w+y$, $g(w,x,y,z)=3x-2z$, $h(w,x,y,z)=x+y+z$, $k=(w,x,y,z)=w+2x-3z$.

- Considera el espacio vectorial de polinomios con coeficientes reales $\mathbb{R}[x]$. Considera la función $\text{ev}_k:\mathbb{R}[x]\to \mathbb{R}$ que a cada polinomio lo manda a su evaluación en $k$, es decir, con regla de asignación $\text{ev}_k(p)=p(k)$.

- Demuestra que cualquier $\text{ev}_k$ es una forma lineal.

- Sean $k_1,\ldots,k_r$ reales distintos. Muestra que $\text{ev}_{k_1},\ldots,\text{ev}_{k_r}$ son formas lineales linealmente independientes.

Entradas relacionadas