Introducción

En esta entrada explicaremos cómo podemos estudiar espacios y subespacios vectoriales a partir de conjuntos más pequeños que guardan la información más relevante de ellos. A estos conjuntos les llamaremos generadores. Además estudiaremos el concepto de independencia lineal. A grandes rasgos podemos decir que un conjunto es linealmente independiente cuando no tiene «elementos redundantes» que se pueden obtener a partir de otros en el conjunto. En ambos casos, nos basaremos fuertemente en el concepto de combinaciones lineales que ya discutimos anteriormente.

Conjuntos generadores

El inciso (1) de la siguiente definición ya lo mencionamos parcialmente en una entrada anterior, para un conjunto finito de vectores. Aquí lo enunciamos de modo que también aplique para conjuntos posiblemente infinitos.

Definición. Sea $V$ un espacio vectorial sobre $F$ y $S$ un subconjunto de $V$.

- El subespacio generado por $S$ es el subconjunto de $V$ que consiste de todas las combinaciones lineales $c_1v_1+c_2v_2+\dots + c_nv_n$, donde $v_1,v_2,\dots,v_n$ es un subconjunto finito de $S$ y $c_1,c_2, \dots , c_n$ son escalares en $F$. Al subespacio generado de $S$ lo denotamos por $\text{span}(S)$. A menudo nos referiremos al subespacio generado de $S$ simplemente como «el generado de $S$».

- b) Decimos que $S$ es un conjunto generador de $V$ si $\text{span}(S)=V$.

En otras palabras, un subconjunto $S$ de $V$ es generador cuando cualquier elemento de $V$ se puede escribir como una combinación lineal de elementos de $S$.

Ejemplos.

- Considera el espacio vectorial $\mathbb{R}^3$ y el conjunto

\begin{align*}

e_1=\begin{pmatrix}

1\\

0\\

0\end{pmatrix}, \hspace{2mm} e_2=\begin{pmatrix}

0\\

1\\

0\end{pmatrix}, \hspace{2mm} e_3=\begin{pmatrix}

0\\

0\\

1\end{pmatrix}.

\end{align*}

Entonces $e_1,e_2,e_3$ forma un conjunto generador de $\mathbb{R}^3$, pues cada vector $X=\begin{pmatrix}

x\\

y\\

z\end{pmatrix}$ se puede escribir como $X=xe_1+ye_2+ze_3$. Sin embargo, el conjunto conformado por únicamente $e_2$ y $e_3$ no es generador pues, por ejemplo, el vector $(1,1,1)$ no puede ser escrito como combinación lineal de ellos.

- Sea $\mathbb{R}_n[x]$ el espacio de los polinomios con coeficientes reales y de grado a los más $n$. La familia $1,x,\dots, x^n$ es un conjunto generador.

- Considera el espacio $M_{m,n}(F)$. Sea $E_{ij}$ la matriz cuya entrada $(i,j)$ es $1$ y todas sus demás entradas son $0$. Entonces la familia $(E_{ij})_{1\leq i\leq m, 1\leq j \leq n}$ es un conjunto generador de $V$, pues cada matriz $A=[a_{ij}]$ puede ser escrita como

\begin{align*}

A=\displaystyle\sum_{i=1}^m \displaystyle\sum_{j=1}^n a_{ij}E_{ij}.

\end{align*}

Este ejemplo lo discutimos anteriormente, cuando hablamos de matrices y sus operaciones.

- Para dar un ejemplo donde un conjunto generador consiste de una cantidad infinita de elementos, considera el espacio $\mathbb{R}[x]$ de polinomios. En este caso, el conjunto $\{x^i: i \geq 0\}$ de todas las potencias de $x$ es un conjunto generador. Seria imposible tener un conjunto generador finito para $\mathbb{R}[x]$ pues si ese conjunto es $S$ y el grado máximo de un polinomio en $S$ es $M$, entonces no podremos obtener al polinomio $x^{M+1}$ como combinación lineal de elementos de $S$.

$\triangle$

Reducción gaussiana y conjuntos generadores

Cuando estamos en el espacio vectorial $F^n$, la reducción gaussiana también resulta muy útil a la hora de estudiar el subespacio generado por los ciertos vectores $v_1,v_2,\dots, v_k$. Considera la matriz $A\in M_{k,n}(F)$ obtenida por poner como vectores fila a $v_1,v_2,\dots, v_k$ en la base canónica de $F^n$ . Hacer operaciones elementales sobre los renglones de $A$ no altera el subespacio generado por sus renglones, de manera que $\text{span}(v_1,\dots, v_k)$ es precisamente el subespacio generado los renglones de $A_{red}$. Esto nos da una manera más sencilla de entender a $\text{span}(v_1, \dots, v_k)$.

Ejemplo. Considera los vectores $v_1=(1,2,6),\hspace{2mm} v_2=(-1,3,2), \hspace{2mm}v_3=(0,5,8)$ en $\mathbb{R}^3$. Queremos encontrar una manera sencilla de expresar $V=\text{span}(v_1,v_2,v_3)$.

Considera la matriz

\begin{align*}

A=\begin{pmatrix}

1 & 2 & 6\\

-1 & 3 & 2\\

0 & 5 & 8\end{pmatrix}.

\end{align*}

Aplicando el algortimo de reducción gaussiana (manualmente o con una calculadora online) llegamos a que

\begin{align*}

A_{red}=\begin{pmatrix}

1 & 0 & \frac{14}{5}\\

0 & 1 & \frac{8}{5}\\

0 & 0 & 0\end{pmatrix}.

\end{align*}

De manera que

\begin{align*}

V=\text{span}\left(\left(1,0,\frac{14}{5}\right),\left(0,1,\frac{8}{5}\right)\right).

\end{align*}

Siendo más explícitos todavía, $V$ es entonces el conjunto de vectores de $\mathbb{R}^3$ de la forma $$a\left(1,0,\frac{14}{5}\right)+b\left(0,1,\frac{8}{5}\right)=\left(a,b,\frac{14a+8b}{5}\right).$$

$\triangle$

Independencia lineal

Sean $V$ un espacio vectorial sobre un campo $F$, $v_1, \dots ,v_n\in V$ y $v\in \text{span}(v_1, \dots, v_n)$. Por definición, existen escalares $c_1,c_2, \dots , c_n$ en $F$ tales que

\begin{align*}

v=c_1v_1+c_2v_2+\dots + c_nv_n.

\end{align*}

No hay algo en la definición de subespacio generado que nos indique que los escalares deben ser únicos, y en muchas ocasiones no lo son.

Problema. Sean $v_1,v_2,v_3$ tres vectores en $\mathbb{R}^n$ tales que $3v_1+v_2+v_3=0$ y sea $v=v_1+v_2-2v_3$. Encuentra una infinidad de maneras de expresar a $v$ como combinación lineal de $v_1,v_2,v_3$.

Solución. Sea $\alpha \in \mathbb{R}$. Multiplicando por $\alpha$ la igualdad $3v_1+v_2+v_3=0$ y sumando la igualdad $v_1+v_2+v_3=v$ se sigue que

\begin{align*}

v=(3\alpha + 1)v_1 + (\alpha +1)v_2 + (\alpha – 2)v_3.

\end{align*}

Así, para cada $\alpha \in \mathbb{R}$ hay una manera diferente de expresar a $v$ como combinación lineal de $v_1,v_2,v_3$.

$\triangle$

Supongamos ahora que el vector $v$ puede ser escrito como $v=a_1v_1+a_2v_2+ \dots + a_nv_n$. Si $b_1,b_2, \dots, b_n$ son otros escalares tales que $v=b_1v_1+b_2v_2+ \dots + b_nv_n$, entonces al restar la segunda relación de la primera obtenemos

\begin{align*}

0=(a_1-b_1)v_1+ (a_2-b_2)v_2+ \dots + (a_n-b_n)v_n.

\end{align*}

De manera que podríamos concluir que los escalares $a_1,a_2,\dots,a_n$ son únicos si la ecuación

\begin{align*}

z_1v_1+z_2v_2+ \dots + z_nv_n=0

\end{align*}

implica $z_1=z_2=\dots=z_n=0$ (con $z_1,\dots ,z_n\in F$), pero este no siempre es el caso (ejemplo de ello es el problema anterior).

Los vectores $v_1, v_2, \dots, v_n$ que tienen la propiedad de generar a los vectores en $\text{span}(v_1,\ldots,v_n)$ de manera única de suma importancia en el álgebra lineal y merecen un nombre formal.

Definición. Sea $V$ un espacio vectorial sobre el campo $F$.

a) Decimos que los vectores $v_1,v_2, \dots, v_n\in V$ son linealmente dependientes si existe una relación

\begin{align*}

c_1v_1+c_2v_2+\dots+c_nv_n=0

\end{align*}

para la cual $c_1,c_2, \dots,c_n$ son escalares de $F$ y alguno es distinto de cero.

b) Decimos que los vectores $v_1,v_2, \dots, v_n\in V$ son linealmente independientes si no son linealmente dependientes, es decir, si la relación

\begin{align*}

a_1v_1+a_2v_2+\dots+a_nv_n=0

\end{align*}

implica que $a_1=a_2=\dots=a_n=0.$

La discusión previa a la definición muestra que un vector en $\text{span}(v_1,\ldots,v_n)$ puede ser escrito de manera única como combinación lineal de los vectores $v_1,\ldots,v_n$ si y sólo si estos vectores son linealmente independientes.

Ejemplos de dependencia e independencia lineal

Ejemplo 1. Las matrices $A=\begin{pmatrix} 1 & 0 & 0 \\ 1 & 0 & 0 \end{pmatrix}$, $B=\begin{pmatrix} 1 & 0 & 0 \\ 1 & 1 & 0 \end{pmatrix}$ y $C=\begin{pmatrix} 0 & 0 & 0 \\0 & 1 & 1 \end{pmatrix}$ son linealmente independientes en $M_{2,3}(\mathbb{R})$. Verifiquemos esto. Supongamos que hay una combinación lineal de ellas igual a cero, es decir, que existen reales $a,b,c$ tales que $aA+bB+cC=O_{2,3}$. Obtenemos entonces que $$\begin{pmatrix} a+b & 0 & 0 \\ a+b & b+c & c \end{pmatrix} = \begin{pmatrix} 0 & 0 & 0 \\ 0 & 0 & 0 \end{pmatrix}.$$

De la entrada $(2,3)$ obtenemos que $c=0$. Así, de la entrada $(2,2)$ obtenemos que $b=0$ y consecuentemente, de la entrada $(1,1)$ obtenemos que $a=0$. De esta forma, la única combinación lineal de las matrices $A$, $B$ y $C$ que da $0$ es cuando los coeficientes son iguales a cero. Concluimos que $A$, $B$ y $C$ son linealmente independientes.

$\triangle$

Ejemplo 2. Considera el espacio vectorial $V$ de funciones de $[0,1]$ a $\mathbb{R}$. Demuestra que las funciones $f(x)=\sin^2 (x)$, $g(x) = 3\cos^2(x)$, $m(x)=x^2$ y $h(x)=-5$. Veremos que estas funciones son linealmente dependientes. Para ello, debemos encontrar reales $a,b,c,d$ no todos ellos iguales a cero tales que $$af+bg+cm+dh=0,$$ es decir, tales que para todo $x$ en el intervalo $[0,1]$ se cumpla que $$a\sin^2(x) + 3b\cos^2(x) + cx^2 -5d = 0.$$

Proponemos $a=1$, $b=\frac{1}{3}$, $c=0$ y $d=\frac{1}{5}$. Notemos que con esta elección de coeficientes tenemos por la identidad pitagórica que

\begin{align*}

\sin^2(x)+\cos^2(x) – 1 = 0.

\end{align*}

Hemos encontrado coeficientes, no todos ellos iguales a cero, tales que una combinación lineal de las funciones es igual a la función cero. Concluimos que las funciones son linealmente dependientes.

$\square$

Reducción gaussiana e independencia lineal

Ahora estudiaremos una técnica para estudiar la independencia lineal. Esta nos permitirá determinar si dados algunos vectores $v_1,v_2\dots,v_k\in F^n$, estos son linealmente independientes. Veamos que este problema puede ser resuelto de manera sencilla por medio de un algoritmo. En efecto, necesitamos saber si podemos encontrar $x_1, \dots, x_k\in F$ no todos iguales a $0$ y tales que

\begin{align*}

x_1v_1+\dots+x_nv_n=0.

\end{align*}

Sea $A$ de $n\times k$ la matriz cuyas columnas están dadas por los vectores $v_1, \dots, v_k$. Entonces la relación anterior es equivalente al sistema $AX=0$, donde $X$ es el vector columna con coordenadas $x_1, \dots, x_k$.Por lo tanto los vectores $v_1, \dots, v_k$ son linealmente independientes si y sólo si el sistema homogéneo $AX=0$ únicamente tiene a la solución trivial.

Como ya vimos anteriormente, este problema se puede resolver mediante el algoritmo de reducción gaussiana: Sea $A_{red}$ la forma escalonada reducida de $A$. Si existe un pivote en cada columna de $A_{red}$, entonces no hay variables libres y la solución al sistema únicamente es el vector cero. Así, $v_1,\dots, v_k$ son linealmente independientes. De lo contrario son linealmente dependientes. Siguiendo este procedimiento, es posible resolver el problema original de manera algorítimica.

Otra cosa importante que podemos deducir a partir de este análisis es que como un sistema lineal homogéneo con más variables que ecuaciones siempre tiene una solución no trivial, entonces si tenemos más de $n$ vectores en $F^n$, estos nunca serán linealmente independientes.

Problema 1. Considera los vectores

\begin{align*}

v_1&=(1,2,3,4,5)\\

v_2&=(2,3,4,5,1)\\

v_3&=(1,3,5,7,9)\\

v_4&=(3,5,7,9,1)

\end{align*} en $\mathbb{R}^5$. ¿Son linealmente independientes? Si la respuesta es negativa, da una relación no trivial de dependencia lineal entre estos vectores.

Solución. Consideremos la matriz cuyas columnas son los vectores $v_1, \dots, v_4$

\begin{align*}

A=\begin{pmatrix}

1 & 2 & 1 & 3\\

2 & 3 & 3 & 5\\

3 & 4 & 5 & 7\\

4 & 5 & 7 & 9\\

5 & 1 & 9 & 1

\end{pmatrix}.

\end{align*}

Aplicando reducción gaussiana obtenemos

\begin{align*}

A_{red}=\begin{pmatrix}

1 & 0 & 0 & -2\\

0& 1 & 0 & 2\\

0&0 & 1 & 1\\

0 &0 & 0 & 0\\

0& 0 & 0 & 0

\end{pmatrix}.

\end{align*}

Como no hay pivote en la última columna, ésta corresponde a una variable libre. Así, habrá por lo menos una solución no trivial y entonces los vectores $v_1,v_2,v_3,v_4$ son linealmente dependientes.

Para encontrar la relación no trivial de dependencia lineal resolvemos el sistema $AX=0$, el cual es equivalente al sistema $A_{red}X=0$. De la matriz anterior obtenemos las siguientes igualdades

\begin{align*}

x_1=2x_4, \hspace{3mm}, x_2=-2x_4, \hspace{3mm} x_3=-x_4.

\end{align*}

Tomando $x_4=1$ (de hecho podemos asignarle cualquier valor distinto de cero), obtenemos la relación de dependencia lineal

\begin{align*}

2v_1-2v_2-v_3+v_4=0.

\end{align*}

$\triangle$

Hagamos otro problema en el que la técnica anterior nos ayuda a estudiar la independencia lineal.

Problema 2. Demuestra que los vectores

\begin{align*}

v_1=(2,1,3,1), \hspace{2mm} v_2=(-1,0,1,2), \hspace{2mm} v_3=(3,2,7,4), \hspace{2mm} v_4=(1,2,0,-1), \hspace{2mm}

\end{align*}

son linealmente dependientes y encuentra tres de ellos que sean linealmente independientes.

Solución. Sea $A$ la matriz cuyas columnas son los vectores $v_1, \dots , v_4$

\begin{align*}

A=\begin{pmatrix}

2 & -1 & 3 & 1\\

1 & 0 & 2 & 2\\

3 & 1 & 7 & 0\\

1 & 2 & 4 & -1

\end{pmatrix}.

\end{align*}

Aplicando reducción gaussiana obtenemos

\begin{align*}

A_{red}=\begin{pmatrix}

1 & 0 & 2 & 0\\

0& 1 & 1 & 0\\

0&0 & 0 & 1\\

0 &0 & 0 & 0

\end{pmatrix}.

\end{align*}

Como la tercera columna de $A_{red}$ no tiene al pivote de ninguna fila, deducimos que los cuatro vectores son linealmente dependientes.

Si eliminamos la tercera columna, entonces la matriz que queda es la forma escalonada reducida correspondiente al conjunto $\{v_1,v_2,v_4\}$. Como esta matriz sí tiene pivotes de filas en cada columna, concluimos que este es un conjunto de vectores linealmente independientes.

$\square$

Independencia lineal de conjuntos infinitos

Hasta este momento hemos trabajado únicamente con familias finitas de vectores, así que es natural preguntarse qué procede con las familias infinitas. Con la definición que tenemos, si tomamos una familia infinita de vectores $(v_i)_{i\in I}$ no podríamos darle algún significado a la suma infinita $\displaystyle\sum_{i\in I}c_iv_i$ para cualquier toda elección de escalares $c_i$, pues en espacios vectoriales no está en general definido cómo hacer una suma infinita. Sin embargo, si todos salvo una cantidad finita de escalares son $0$, entonces la suma anterior sería una suma finita y ya tendría sentido.

De esta manera, podemos extender la definición como sigue.

Definición. La familia $(v_i)_{i\in I}$ es linealmente dependiente si existe una familia de escalares $(c_i)_{i\in I}$ tales que todos salvo una cantidad finita de ellos son cero, pero al menos uno no es cero y que $\displaystyle\sum_{i\in I}c_iv_i=0$.

De manera equivalente y para simplificar el razonamiento anterior podemos decir que una familia arbitraria de vectores es linealmente dependiente si tiene una subfamilia finita linealmente dependiente. Una familia de vectores es linealmente independiente si toda subfamilia finita es linealmente independiente. Por lo tanto, un conjunto $L$ (posiblemente infinito) es linealmente independiente si dados elementos distintos $l_1,\dots, l_n\in L$ y escalares $a_1,a_2,\dots, a_n$ con $a_1l_1+a_2l_2+\dots+ a_nl_n=0$, entonces $a_1=a_2=\dots=a_n=0.$

Observación. a) Una subfamilia de una familia linealmente independiente es linealmente independiente. En efecto, sea $(v_i)_{i\in I}$ una familia linealmente independiente y sea $J\subset I$. Supongamos que $(v_i)_{i\in J}$ es linealmente dependiente. Entonces existe una subfamilia finita linealmente dependiente $v_{i_1}, \dots, v_{i_n}$ con $i_1, \dots,i_n\in J $, pero $i_1, \dots,i_n\in I $, entonces $v_{i_1}, \dots, v_{i_n}$ es una subfamilia finita y linealmente dependiente de una familia linealmente independiente lo cual es una contradicción.

b) Si dos vectores de una familia son iguales, entonces automáticamente la familia es linealmente dependiente.

$\square$

Más adelante veremos ejemplos de generadores y de independencia lineal con familias infinitas de vectores.

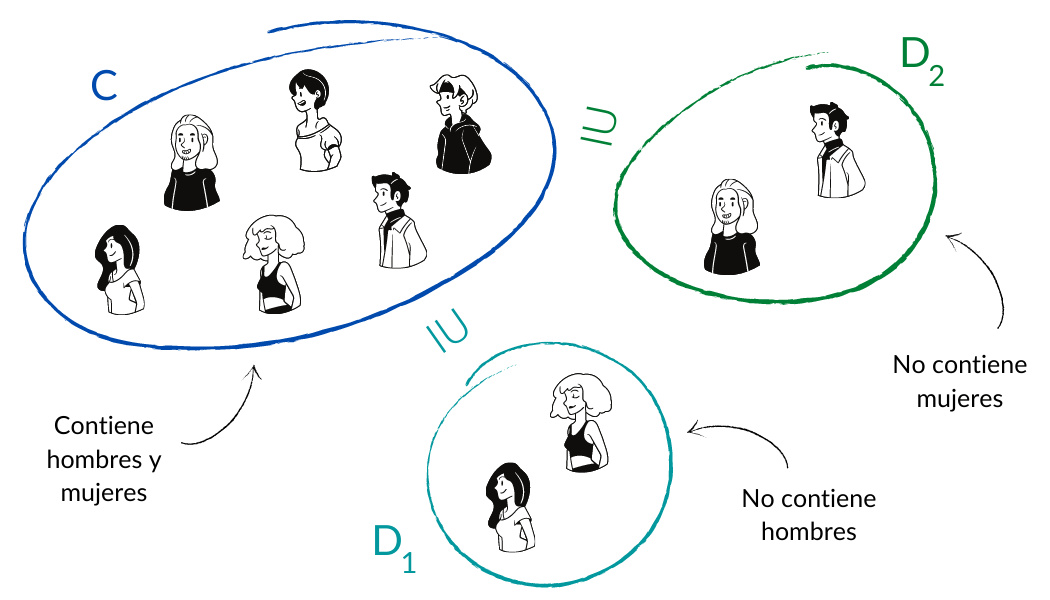

Una relación entre independencia lineal y generados

Podemos relacionar las nociones de subespacio generado y de independencia lineal con la siguiente proposición. Básicamente nos dice que un conjunto $\{v_1, \dots, v_n\}$ es linealmente dependiente si y sólo si alguno sus elementos se puede expresar como combinación lineal de los demás.

Es importante mencionar que usamos la palabra «conjunto» y no «familia», puesto que con la primera nos referimos a que los vectores son distintos dos a dos, mientras que con la segunda sí pueden haber repeticiones.

Proposición. Sea $S$ un conjunto de vectores en algún espacio vectorial $V$. Entonces $S$ es linealmente dependiente si y sólo si existe $v\in S$ tal que $v\in \text{span}(S\backslash \{v\})$.

Demostración. Supongamos que $S$ es linealmente dependiente. Entonces existe una cantidad finita de vectores $v_1,v_2, \dots , v_n\in S$ y algunos escalares $a_1,a_2, \dots, a_n$ no todos iguales a $0$, tales que

\begin{align*}

a_1v_1+a_2v_2+ \dots + a_nv_n=0.

\end{align*}

Notemos que $v_1,\dots , v_n$ son distintos dos a dos, pues estamos suponiendo que los elementos de $S$ también lo son.

Como no todos los escalares son $0$, existe $i\in \{1,2,\dots, n\}$ tal que $a_i\neq 0$. Dividiendo la igualdad anterior entre $a_i$, obtenemos

\begin{align*}

\frac{a_1}{a_i}v_1+ \dots + \frac{a_{i-1}}{a_i}v_{i-1}+ v_i+ \frac{a_{i+1}}{a_i}v_{i+1}+ \dots + \frac{a_n}{a_i}v_n=0,

\end{align*}

por consiguiente

\begin{align*}

v_i=-\frac{a_1}{a_i}v_1- \dots – \frac{a_{i-1}}{a_i}v_{i-1}-\frac{a_{i+1}}{a_i}v_{i+1}-\dots – \frac{a_n}{a_i}v_n.

\end{align*}

De lo anterior se sigue que $v_i$ pertenece al generado de $v_1, \dots , v_{i-1}, v_{i+1}, \dots , v_n$, el cual está contenido en $\text{span}(S \backslash \{v_i\})$, pues $\{v_1, \dots , v_{i-1}, v_{i+1}, \dots , v_n\}\subset S\backslash \{v_i\}$. Esto prueba una implicación.

Para la otra implicación, supongamos que existe $v\in S$ tal que $v\in \text{span}(S\backslash \{v\})$. Esto significa que existen $v_1,v_2, \dots, v_n\in S\backslash \{v\}$ y escalares $a_1,a_2,\dots ,a_n$ tales que

\begin{align*}

v=a_1v_1+a_2v_2+\dots+a_nv_n.

\end{align*}

Pero entonces

\begin{align*}

1\cdot v + (-a_1)v_1+ \dots + (-a_n)v_n=0

\end{align*}

y los vectores $v,v_1,\dots , v_n$ son linealmente dependientes pues por lo menos el primer coeficiente es distinto de cero. Como $v$ no está en $\{v_1, \ldots, v_n\}$, se sigue que $S$ tiene un subconjunto finito que es linealmente dependiente y por lo tanto $S$ también lo es.

$\square$

Más adelante…

Aquí ya hablamos de conjuntos generadores y de linealmente independientes. La entrada teórica que sigue es crucial y en ella se verá y formalizará la intuición de que los conjuntos generadores deben ser «grandes», mientras que los independientes deben ser «chicos». El resultado clave es el lema de intercambio de Steinitz.

Cuando un conjunto de vectores es tanto generador, como linealmente independiente, está en un equilibrio que ayuda a describir una propiedad muy importante de un espacio vectorial: la de dimensión.

Tarea moral

A continuación hay algunos ejercicios para que practiques los conceptos vistos en esta entrada. Te será de mucha utilidad intentarlos para entender más la teoría vista.

- Decide si el conjunto con las matrices $\begin{pmatrix} 0 & 1 \\ 0 & 0\end{pmatrix}$, $\begin{pmatrix} 0 & 1 \\ 0 & 1 \end{pmatrix}$, $\begin{pmatrix} 0 & 1 \\ 1 & 1\end{pmatrix}$ y $\begin{pmatrix} 1 & 1 \\ 1 & 1 \end{pmatrix}$ es un conjunto generador de $M_2(\mathbb{R})$.

- Sean $S_1$ y $S_2$ subconjuntos de un subespacio vectorial $V$ tales que $S_1\subset S_2$. Demuestra que $\text{span}(S_1)\subset \text{span}(S_2)$. Concluye que si $S_1$ es generador, entonces $S_2$ también lo es

- Demuestra la observación b).

- Da un conjunto de $3$ vectores de $\mathbb{R}^3$ linealmente independientes y tales que ninguna de sus entradas es $0$. Haz lo mismo para linealmente dependientes.

- Sean $f,g:\mathbb{R}\longrightarrow \mathbb{R}$ funciones definidas por

\begin{align*}

f(t)=e^{rt}, \hspace{4mm} g(t)=e^{st}

\end{align*}

con $r\neq s$. Demuestra que $f$ y $g$ son linealmente independientes en $\mathcal{F}(\mathbb{R},\mathbb{R})$, el espacio de las funciones de los reales en los reales.

Entradas relacionadas

Agradecimientos

Trabajo realizado con el apoyo del Programa UNAM-DGAPA-PAPIME PE104721 «Hacia una modalidad a distancia de la Licenciatura en Matemáticas de la FC-UNAM»