Introducción

En la entrada anterior estudiamos las representaciones matriciales de una transformación lineal. Vimos cómo dadas ciertas bases del espacio dominio y codominio, existe un isomorfismo entre matrices y transformaciones lineales. Así mismo, planteamos la pregunta de cómo encontrar bases para que dicha forma matricial sea sencilla. Vimos que unos conceptos cruciales para entender esta pregunta son los de eigenvalor, eigenvector y eigenespacio. Lo que haremos ahora es introducir una nueva herramienta que nos permitirá encontrar los eigenvalores de una transformación: el polinomio característico.

A partir del polinomio característico daremos un método para encontrar también a los eigenvectores y, en algunos casos especiales, encontrar una representación de una transformación lineal como matriz diagonal. Todo lo que hacemos es una versión resumida de lo que se puede encontrar en un curso más completo de álgebra lineal. Dentro del blog, te recomendamos consultar las siguientes entradas:

- Eigenvectores y eigenvalores de transformaciones y matrices

- Propiedades del polinomio característico

Polinomio característico

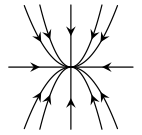

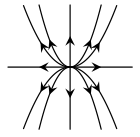

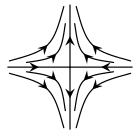

Pensemos en el problema de hallar los eigenvalores de una transformación lineal $T:\mathbb{R}^n\rightarrow \mathbb{R}^n$. Si $\lambda \in \mathbb{R}$ es uno de estos eigenvalores, queremos poder encontrar vectores $\bar{v}\neq \bar{0}$ tales que $T(\bar{v})=\lambda \bar{v}$. Esto sucede si y sólo si $\lambda \bar{v}-T(\bar{v})=\bar{0}$, lo cual sucede si y sólo si $(\lambda \text{Id}-T)(\bar{v})=\bar{0}$, en donde $\text{Id}:\mathbb{R}^n\to \mathbb{R}^n$ es la transformación identidad de $\mathbb{R}^n$ en $\mathbb{R}^n$. Tenemos de esta manera que $\bar{v}$ es un eigenvector si y sólo si $\bar{v}\in \ker(\lambda\text{Id}-T)$.

Si existe $\bar{v}\neq \bar{0}$ tal que $\bar{v}\in \ker(\lambda \text{Id}-T)$; entonces $\ker(\lambda \text{Id}-T)\neq \{ \bar{0}\}$ por lo cual la transformación $\lambda \text{Id}-T$ no es invertible, pues no es inyectiva. Así, en ninguna base $\text{Mat}_\beta(\lambda \text{Id}-T)$ es invertible, y por tanto su determinante es $0$. Estos pasos son reversibles. Concluimos entonces que $\lambda\in \mathbb{R}$ es un eigenvalor de $T$ si y sólo si en alguna base $\beta$ se cumple que $\det(\text{Mat}_\beta(\lambda \text{Id} – T))=0.$ Esto motiva la siguiente definición.

Definición. Sea $T:\mathbb{R}^n\to \mathbb{R}^n$ una transformación lineal. Llamamos a $\det(\text{Mat}_\beta(\lambda \text{Id} – T))$ al polinomio característico de $T$ en la base $\beta$.

Por la discusión anterior, los escalares que cumplen $\det(\text{Mat}_\beta(\lambda \text{Id} – T))=0$ son los eigenvalores $T$. Para obtener los correspondientes eigenvectores, basta con resolver $\text{Mat}_\beta(T)X=\lambda X$, lo cual es un sistema de ecuaciones en el vector de variables $X$. Las soluciones $X$ nos darán las representaciones matriciales de vectores propios $\bar{v}\in \mathbb{R}^n$ en la base $\beta$.

Por el momento parece ser que tenemos mucha notación, pues debemos considerar la base en la que estamos trabajando. Un poco más adelante veremos que en realidad la base no importa mucho para determinar el polinomio característico. Pero por ahora, veamos un ejemplo concreto de las ideas platicadas hasta ahora.

Ejemplo: Consideremos $T:\mathbb{R}^{3}\rightarrow \mathbb{R}^{3}$ dada por $T(x,y,z)=(2x+z,y+x,-z)$. Calculemos su representación matricial con respecto a la base canónica $\beta$. Para ello, realizamos las siguientes evaluaciones:

\begin{align*}

T(1,0,0)&=(2,1,0)\\

T(0,1,0)&=(0,1,0)\\

T(0,0,1)&=(1,0,-1),

\end{align*}

de donde: $$\text{Mat}_\beta=\begin{pmatrix} 2 & 0 & 1 \\ 1 & 1 & 0 \\ 0 & 0 & -1 \end{pmatrix}.$$

Calculando el polinomio característico obtenemos: \[ det\begin{pmatrix} \lambda-2 & 0 & -1 \\ -1 & \lambda-1 & 0 \\ 0 & 0 & \lambda+1 \end{pmatrix}= (\lambda-2)(\lambda-1)(\lambda+1). \]

Las raíces de $(\lambda-2)(\lambda-1)(\lambda+1)$ son $\lambda_{1}=2$, $\lambda_{2}=1$ y $\lambda_{3}=-1$. Pensemos ahora en quiénes son los eigenvectores asociados a cada eigenvalor. Tomemos como ejemplo el eigenvalor $\lambda=2$. Para que $(x,y,z)$ represente a un eigenvector en la base canónica, debe pasar que:

\[ \begin{pmatrix} 2 & 0 & 1 \\ 1 & 1 & 0 \\ 0 & 0 & -1 \end{pmatrix} \begin{pmatrix} x \\ y \\ z \end{pmatrix} = 2\begin{pmatrix} x \\ y \\ z \end{pmatrix},\]

lo cual sucede si y sólo si:

\[\begin{pmatrix} 2 & 0 & 1 \\ 1 & 1 & 0 \\ 0 & 0 & -1 \end{pmatrix} \begin{pmatrix} x \\ y \\ z \end{pmatrix} – 2\begin{pmatrix} x \\ y \\ z \end{pmatrix}= \begin{pmatrix} 0 \\ 0 \\ 0 \end{pmatrix};\]

\[\left[ \begin{pmatrix} 2 & 0 & 1 \\ 1 & 1 & 0 \\ 0 & 0 & -1 \end{pmatrix} – 2\begin{pmatrix} 1 & 0 & 0 \\ 0 & 1 & 0 \\ 0 & 0 & 1 \end{pmatrix}\right] \begin{pmatrix} x \\ y \\ z \end{pmatrix}= \begin{pmatrix} 0 \\ 0 \\ 0 \end{pmatrix};\]

\[\begin{pmatrix} 0 & 0 & 1 \\ 1 & -1& 0 \\ 0 & 0 & -3 \end{pmatrix} \begin{pmatrix} x \\ y \\ z \end{pmatrix} = \begin{pmatrix} 0 \\ 0 \\ 0 \end{pmatrix}.\]

De aquí, podemos llegar a la siguiente forma escalonada reducida del sistema de ecuaciones:

\[\begin{pmatrix} 1 & -1 & 0 \\ 0 & 0 & 1 \\ 0 & 0 & 0 \end{pmatrix} \begin{pmatrix} x \\ y \\ z \end{pmatrix} = \begin{pmatrix} 0 \\ 0 \\ 0 \end{pmatrix}.\]

En esta forma es sencillo leer las soluciones. Tenemos que $z$ es variable pivote con $z=0$, que $y$ es variable libre, y que $x$ es variable pivote dada por $x=y$. Concluimos entonces que todos los posibles eigenvectores para el eigenvalor $2$ son de la forma $(y,y,0)$, es decir $E_2=\{(y,y,0): y \in \mathbb{R}\}$.

Queda como tarea moral que encuentres los eigenvectores correspondientes a los eigenvalores $1$ y $-1$.

$\triangle$

Matrices similares

En la sección anterior definimos el polinomio de una transformación lineal en términos de la base que elegimos para representarla. En realidad, la base elegida no es muy importante. Demostraremos un poco más abajo que dos representaciones matriciales cualesquiera de una misma transformación lineal tienen el mismo polinomio característico. Para ello, comencemos con la siguiente discusión.

Sea $T:\mathbb{R}^n\rightarrow \mathbb{R}^n$ una transformación lineal y sean $\beta_1=\{ \bar{e}_{1}, \dots , \bar{e}_{n}\}$, $\beta_2=\{ \bar{u}_{1}, \dots , \bar{u}_{n}\}$ dos bases (ordenadas) de $\mathbb{R}^n$. Supongamos que:

\begin{align*}

A&=\text{Mat}_{\beta_1}(T)=[a_{ij}]\\

B&=\text{Mat}_{\beta_2}(T)=[b_{ij}].

\end{align*}

Por cómo se construyen las matrices $A$ y $B$, tenemos que:

\begin{align*}

T(\bar{e}_j)&=\sum_{i=1}^n a_{ij} \bar{e}_i\quad\text{para $j=1,\ldots,n$}\\

T(\bar{u}_k)&=\sum_{j=1}^n b_{jk} \bar{u}_j\quad\text{para $k=1,\ldots,n$}.

\end{align*}

Como $\beta_{1}$ es base, podemos poner a cada un de los $\bar{u}_k$ de $\beta_{2}$ en términos de la base $\beta_{1}$ mediante combinaciones lineales, digamos:

\begin{equation}

\bar{u}_{k}=\sum_{j=1}^{n}c_{jk}\bar{e}_{j}

\label{eq:valor-u}

\end{equation}

en donde los $c_{jk}$ son escalares para $j=1,\ldots, n$ y $k=1,\ldots,n$. La matriz $C$ de $n\times n$, con entradas $c_{jk}$ representa a una transformación lineal invertible, ya que es una transformación que lleva uno a uno los vectores de una base a otra. Afirmamos que $CB=AC$. Para ello, tomaremos una $k$ en $[n]$ y expresaremos $T(\bar{u}_k)$ de dos formas distintas.

Por un lado, usando \eqref{eq:valor-u} y por como es cada $T(\bar{e}_k)$ en la base $\beta_{1}$ tenemos que:

\begin{align*}

T(\bar{u}_k)&=\sum_{j=1}^n c_{jk} T(\bar{e}_j)\\

&=\sum_{j=1}^n c_{jk} \sum_{i=1}^n a_{ij} \bar{e}_i\\

&=\sum_{j=1}^n \sum_{i=1}^n (c_{jk} a_{ij} \bar{e}_i)\\

&=\sum_{i=1}^n \sum_{j=1}^n (c_{jk} a_{ij} \bar{e}_i)\\

&=\sum_{i=1}^n \left(\sum_{j=1}^n a_{ij} c_{jk}\right) \bar{e}_i.

\end{align*}

Por otro lado, usando $\eqref{eq:valor-u}$ y por como es cada $T(\bar{u}_k)$ en la base $\beta_{2}$:

\begin{align*}

T(\bar{u}_k)&=\sum_{j=1}^nb_{jk} \bar{u}_j\\

&=\sum_{j=1}^n b_{jk} \sum_{i=1}^{n}c_{ji}\bar{e}_{j} \\

&=\sum_{j=1}^n \sum_{i=1}^n (b_{jk} c_{ij} \bar{e}_i)\\

&=\sum_{i=1}^n \sum_{j=1}^n (b_{jk} c_{ij} \bar{e}_i)\\

&=\sum_{i=1}^n \left(\sum_{j=1}^n c_{ij} b_{jk} \right) \bar{e}_i.

\end{align*}

Comparemos ambas expresiones para $T(\bar{u}_k)$. La primera es una combinación lineal de los $\bar{e}_i$ y la segunda también. Como $T(\bar{u}_k)$ tiene una única expresión como combinación lineal de los $\bar{e}_i$, entonces los coeficientes de la combinación lineal deben coincidir. Concluimos que para cada $i$ se cumple:

$$\sum_{j=1}^n a_{ij} c_{jk}=\sum_{j=1}^n c_{ij} b_{jk}.$$

Pero esto precisamente nos dice que la entrada $(i,k)$ de la matriz $AC$ es igual a la entrada $(i,k)$ de la matriz $CB$. Con esto concluimos que $AC=CB$, como queríamos.

En resumen, obtuvimos que para dos matrices $A$ y $B$ que representan a la misma transformación lineal, existe una matriz invertible $C$ tal que: $B=C^{-1}AC$. Además $C$ es la matriz con entradas dadas por \eqref{eq:valor-u}.

Introduciremos una definición que nos permitirá condensar en un enunciado corto el resultado que hemos obtenido.

Definición. Dos matrices $A$ y $B$ se llamarán similares (o semejantes), cuando existe otra matriz $C$ invertible tal que $B=C^{-1}AC$.

Sintetizamos nuestro resultado de la siguiente manera.

Proposición. Si dos matrices representan a la misma transformación lineal, entonces estas matrices son similares.

El recíproco de la proposición también se cumple, tal y como lo afirma el siguiente resultado.

Proposición. Sean $A$ y $B$ matrices similares. Entonces $A$ y $B$ representan a una misma transformación lineal $T$, quizás bajo distintas bases.

Demostración: Supongamos que las matrices $A$ y $B$ son similares con $B=C^{-1}AC$, donde las matrices $A$, $B$, $C$ están dadas por entradas $A=[a_{ij}]$ $B=[b_{ij}]$, $C=[c_{jk}]$. Tomemos una base ordenada $\beta=\{\bar{e}_{1}, \dots ,\bar{e}_{n}\}$ de $\mathbb{R}^n$. Consideremos la transformación lineal $T\in \mathcal{L}(\mathbb{R}^n,\mathbb{R}^n)$ dada por $$T(\bar{e}_j)=\sum_{i=1}^n a_{ij} \bar{e}_i.$$

De esta manera $T$ tiene forma matricial $A$ en la base $\beta$.

Construyamos ahora una nueva base ordenada de $\mathbb{R}^n$ dada por vectores $\bar{u}_k$ para $k=1,\ldots,n$ construidos como sigue:

$$\bar{u}_{k}=\sum_{j=1}^{n}c_{jk}\bar{e}_{j}.$$

Como $C$ es invertible, en efecto tenemos que $\beta’:=\{\bar{u}_1,\ldots,\bar{u}_n\}$ también es base de $\mathbb{R}^n$. Además, de acuerdo con las cuentas que hicimos anteriormente, tenemos que precisamente la forma matricial de $T$ en la base $\beta’$ será $B$.

Así, hemos exhibido una transformación $T$ que en una base tiene representación $A$ y en otra tiene representación $B$.

$\square$

Juntando ambos resultados en uno solo, llegamos a lo siguiente.

Teorema. Dos matrices $A$ y $B$ en $M_n(\mathbb{R})$ son similares si y sólo si representan a una misma transformación lineal $T:\mathbb{R}^n\to \mathbb{R}^n$, quizás bajo distintas bases.

El polinomio característico no depende de la base

Si dos matrices son similares, entonces comparten varias propiedades relevantes para el álgebra lineal. Veamos un ejemplo de esto.

Teorema. Sea $T:\mathbb{R}^n\to \mathbb{R}^n$ una transformación lineal en un espacio sobre $\mathbb{R}$ de dimensión finita. Sean $\beta$ y $\beta’$ bases de $\mathbb{R}^n$. Entonces se obtiene lo mismo calculando el polinomio característico de $T$ en la base $\beta$, que en la base $\beta’$.

Demostración. Tomemos $A=\text{Mat}_{\beta}(T)$ y $B=\text{Mat}_{\beta’}(T)$. Como $A$ y $B$ representan a la misma transformación lineal $T$, entonces son similares y por lo tanto existe $C$ invertible con $B=C^{-1}AC$.

Para encontrar el polinomio característico de $T$ en la base $\beta$, necesitamos $\Mat_{\beta}(\lambda\text{Id}-T)$, que justo es $\lambda I -A$. Así mismo, en la base $\beta’$ tenemos $\lambda I – B$. Debemos mostrar que el determinante de estas dos matrices es el mismo. Para ello, procedemos como sigue:

\begin{align*}

\det(\lambda I -B) &= \det (\lambda C^{-1}C – C^{-1} A C)\\

&=\det(C^{-1}(\lambda I – A) C)\\

&=\det(C^{-1})\det(\lambda I – A) \det(C)\\

&=\det(C^{-1})\det(C)\det(\lambda I-A)\\

&=\det(I)\det(\lambda I-A)\\

&=\det(\lambda I-A).

\end{align*}

Aquí estamos usando que el determinante es multiplicativo. Cuando reordenamos expresiones con $\det$, lo hicimos pues los determinantes son reales, cuyo producto es conmutativo.

$\square$

Este teorema nos permite hablar del polinomio característico de una transformación lineal.

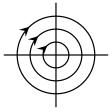

Concluimos esta entrada con un resultado que relaciona al polinomio característico de una transformación lineal, con la posibilidad de que exista una base cuya representación matricial sea diagonal.

Teorema. Sea $T:\mathbb{R}^n\to \mathbb{R}^n$ una transformación lineal. Supongamos que el polinomio característico de $T$ tiene raíces distintas $\lambda_{1}, \dots ,\lambda_{n}$. Entonces se cumple lo siguiente:

- Si tomamos un eigenvector $\bar{u}_i$ para cada eigenvalor $\lambda_i$, entonces $\bar{u}_{1},\dots ,\bar{u}_{n}$ forman una base $\beta$ para $\mathbb{R}^n$.

- Con dicha base $\beta$, se cumple que $\text{Mat}_\beta(T)$ es una matriz diagonal con entradas $\lambda_{1},\dots ,\lambda_{n}$ en su diagonal.

- Si $\beta’$ es otra base de $\mathbb{R}^n$ y $A=\text{Mat}_{\beta’}(T)$, entonces $\text{Mat}_\beta(T) = C^{-1}AC$ para una matriz invertible $C$ con entradas dadas por \eqref{eq:valor-u}.

La demostración de este resultado queda como tarea moral.

Más adelante…

En la entrada planteamos entonces un método para encontrar los eigenvectores de una transformación $T$: 1) la transformamos en una matriz $A$, 2) encontramos el polinomio característico mediante $\det(\lambda I – A)$, 3) encontramos las raíces de este polinomio, 4) cada raíz es un eigenvalor y las soluciones al sistema lineal de ecuaciones $(\lambda I – A) X=0$ dan los vectores coordenada de los eigenvectores.

Como platicamos en la entrada, una condición suficiente para que una transformación de $\mathbb{R}^n$ a sí mismo sea diagonalizable es que tenga $n$ eigenvalores distintos. Otro resultado muy bonito de álgebra lineal es que si la transformación tiene alguna forma matricial simétrica, entonces también es diagonalizable. A esto se le conoce como el teorema espectral para matrices simétricas reales. En otros cursos de álgebra lineal se estudia la diagonalizabilidad con mucho detalle. Aquí en el blog puedes consultar el curso de Álgebra Lineal II.

Otra herramienta de álgebra lineal que usaremos en el estudio de la diferenciabilidad y continuidad de las funciones de $\mathbb{R}^{n}$ a $\mathbb{R}^{m}$ son las formas bilineales y las formas cuadráticas. En la siguiente entrada comenzaremos con estos temas.

Tarea moral

- Encuentra los eigenvectores faltantes del ejemplo de la sección de polinomio característico.

- Considera la transformación lineal $T(x,y,z)=(2x+z,y+x,-z)$ de $\mathbb{R}^3$ en $\mathbb{R}^3$. Nota que es la misma que la del ejemplo de la entrada. Encuentra su representación matricial con respecto a la base $\{(1,1,1),(1,2,3),(0,1,1)\}$ de $\mathbb{R}^3$. Verifica explícitamente que, en efecto, al calcular el polinomio característico con esta base se obtiene lo mismo que con la dada en el ejemplo.

- Demuestra que si $A$ y $B$ son dos representaciones matriciales de una misma transformación lineal $T$, entonces $\det(A)=\det(B)$.

- Sea $T:\mathbb{R}^{3}\to \mathbb{R}^{3}$ dada por $T(x,y,z)=(x+y+z,x,y)$. Encuentra los eigenvalores correspondientes a la transformación, y responde si es posible representarla con una matriz diagonal. En caso de que sí, encuentra explícitamente la base $\beta$ en la cual $\text{Mat}_{\beta}(T)$ es diagonal.

- Demuestra el último teorema de la entrada. Necesitarás usar resultados de la entrada anterior.

Entradas relacionadas

- Ir a Cálculo Diferencial e Integral III

- Entrada anterior del curso: Representaciones matriciales, eigenvalores y eigenvectores

- Entrada siguiente del curso: Formas lineales y formas bilineales