Introducción

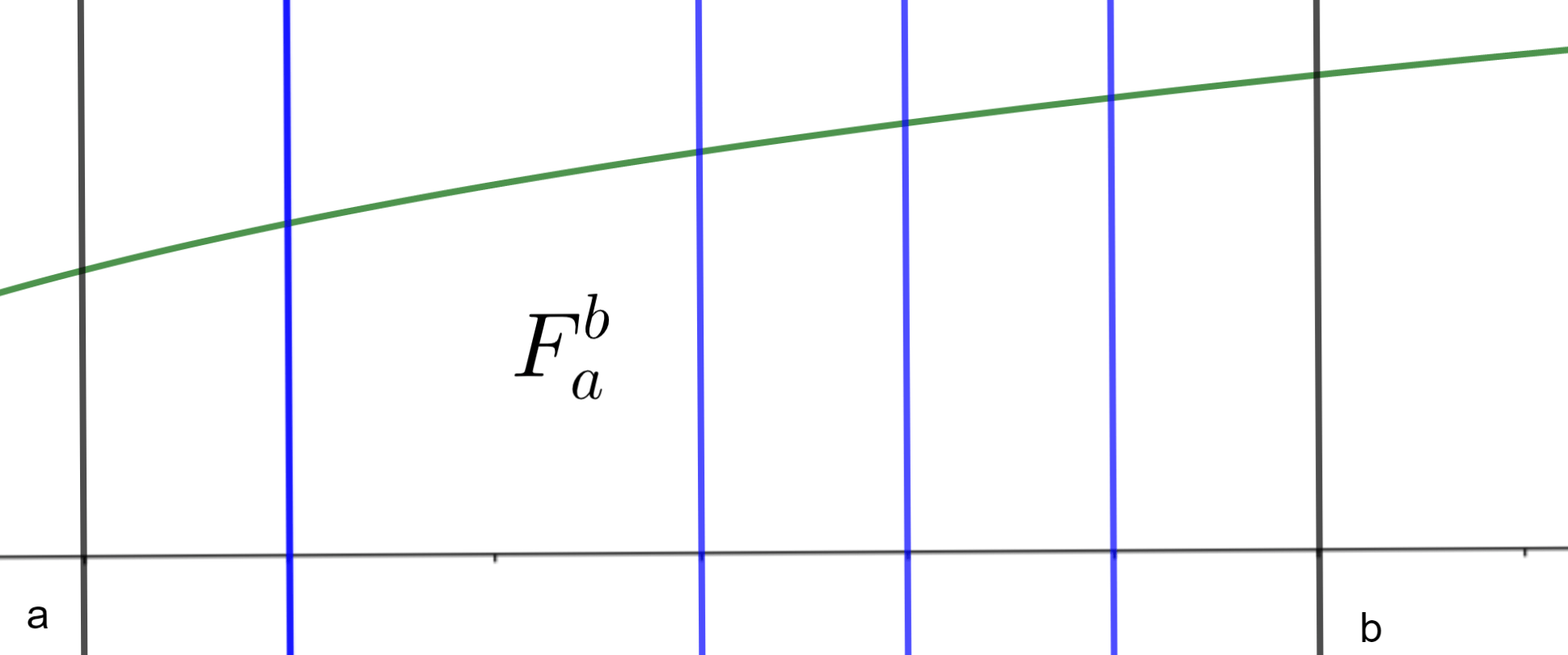

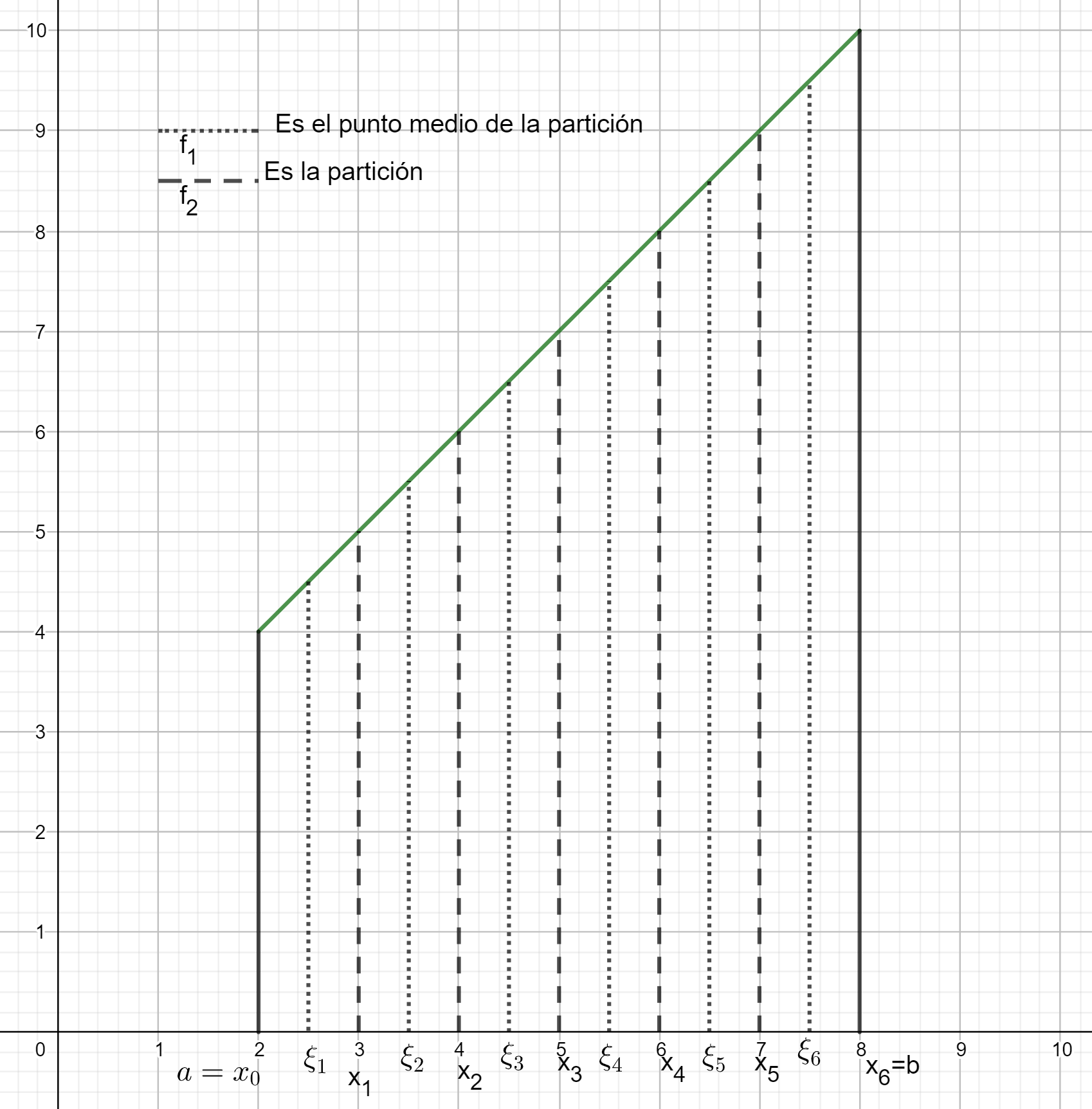

En la entrada anterior se introdujo el problema de calcular el área que se encuentra en una región delimitada por ciertas líneas verticales, el eje $x$ y la gráfica de una función. Hablamos de cómo aproximar esta área cuando la función es «bien portada», pero aún no hemos dicho a qué se refiere esto. En esta entrada haremos una formalización de este concepto mediante la definición de integral definida.

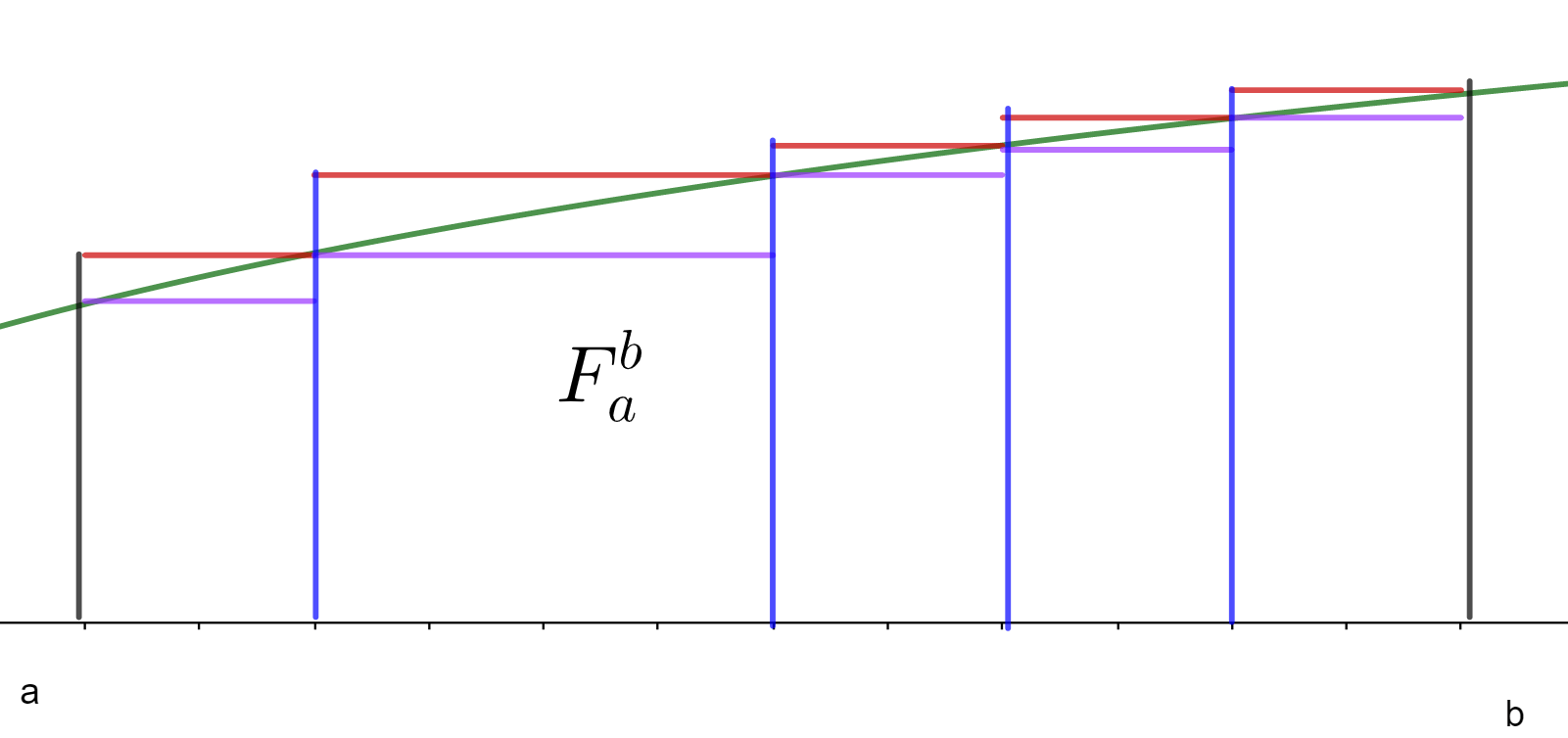

La intuición que puedes tener a lo largo de la entrada es que para poder hablar de que una función sea integrable en cierto intervalo, intuitivamente necesitamos que las sumas de Riemann convergan a un valor conforme hacemos las celdas tender a cero en longitud. Esto diría que sin importar cómo hagamos la partición, las sumas de Riemann deben converger a un mismo valor conforme la partición se hace más y más fina. En particular, necesitaremos que las sumas superiores e inferiores cumplan esto. Como en ellas entendemos bien qué pasa con los refinamientos, entonces nos conviene más dar la definición en términos de ellas. Es lo más conveniente y, en particular, implica lo anterior.

Integral definida de Riemann

La definición clave que estudiaremos es la siguiente.

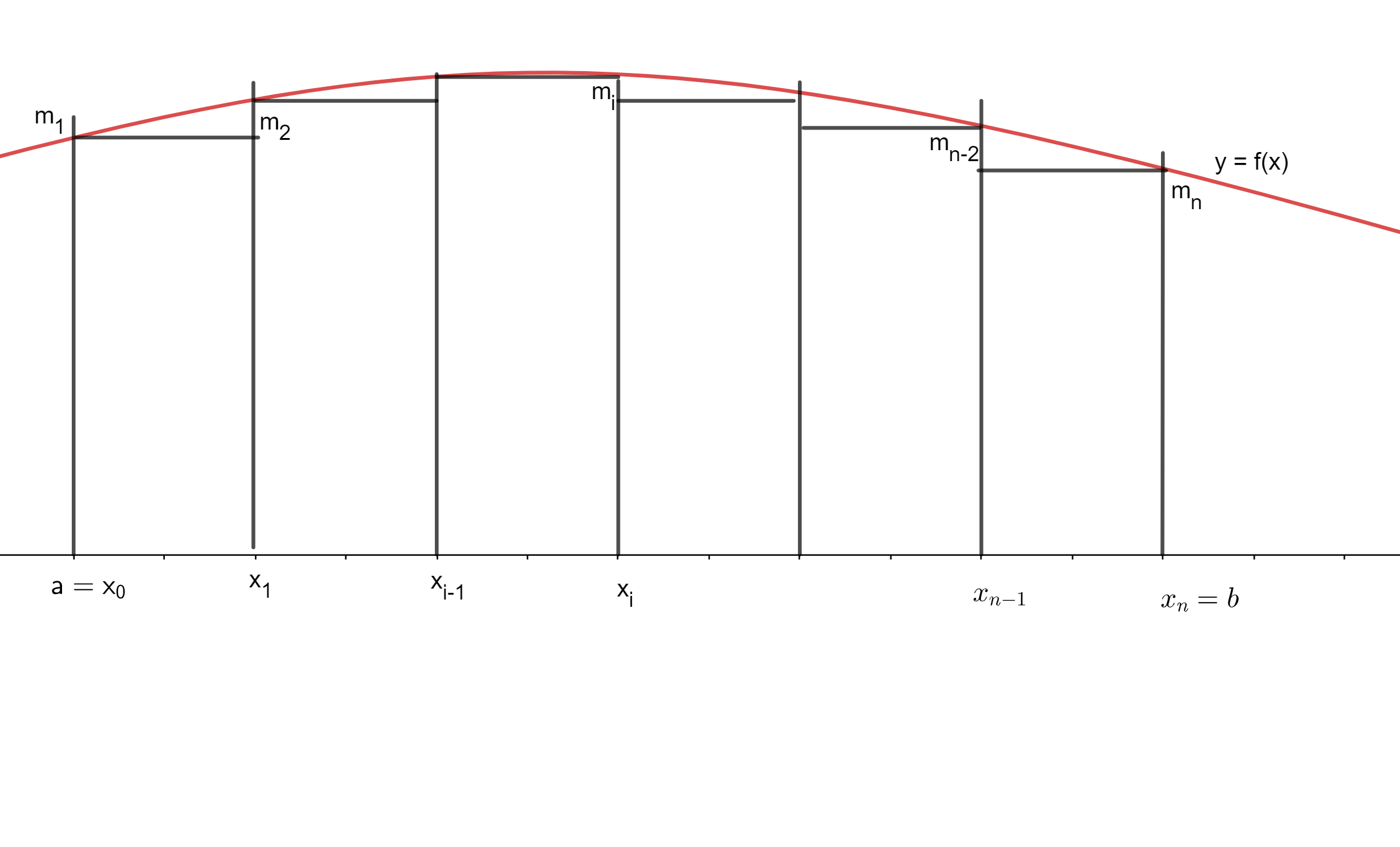

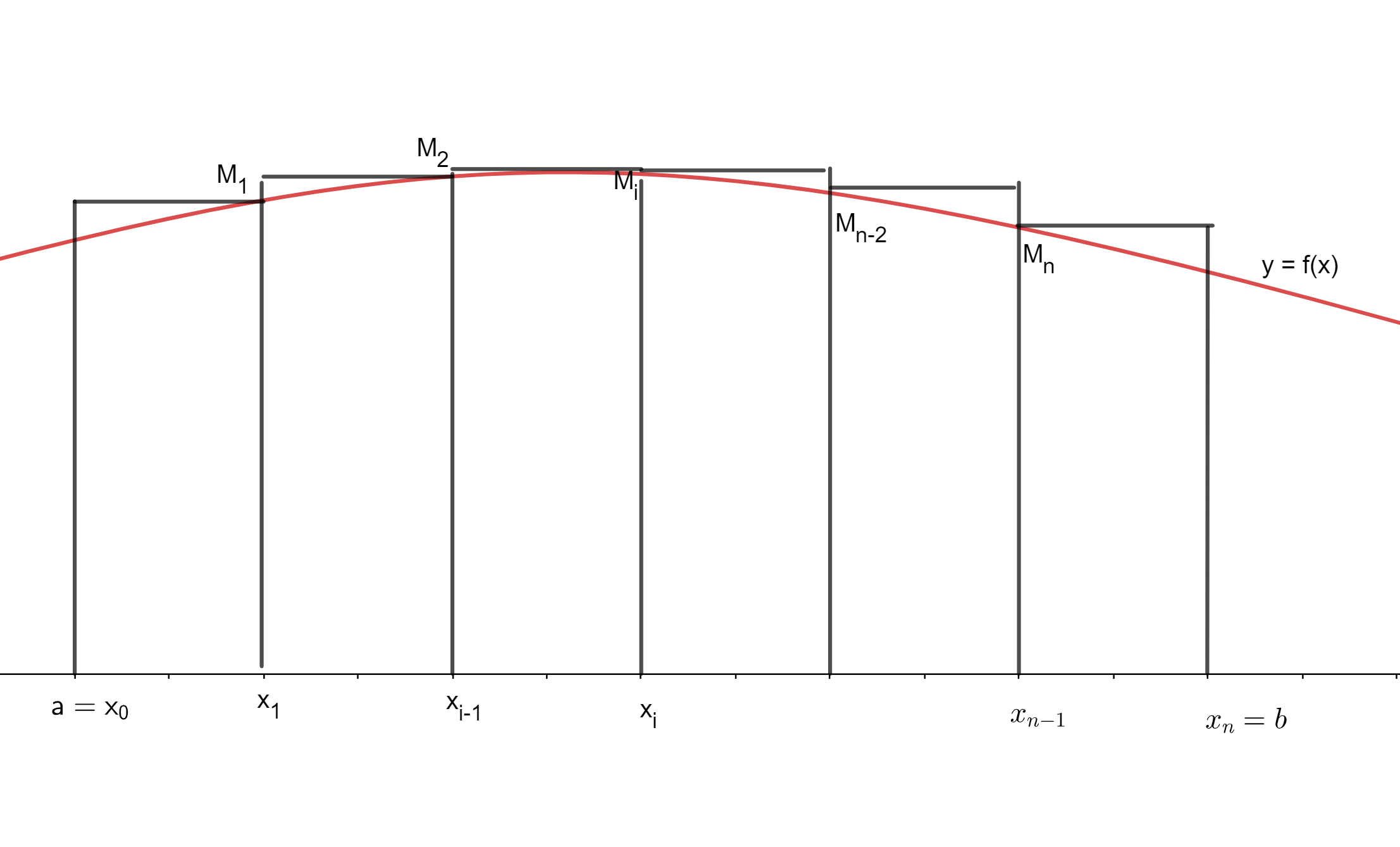

Definición. Sean $f:\mathbb{R}\to \mathbb{R}$ una funcion acotada y $a\leq b$ reales. Sea $\mathbf{P}$ el conjunto de las particiones de $[a,b]$. Definimos

\begin{align*}

\underline{S}(f) & = \sup \lbrace \underline{S(f,P)} \ | P \in \mathbf{P} \rbrace\\

\overline{S}(f) &= \inf \lbrace \overline{S(f,P)} \ | P \in \mathbf{P} \rbrace,

\end{align*}

es decir al supremo de las sumas inferiores y al ínfimo de las sumas superiores sobre todas las particiones posibles de $[a,b]$. Diremos que existe la integral definida de Riemann para $f$ en el intervalo $[a,b]$ si

$$ \underline{S(f)} = \overline{S(f)}.$$

En este caso, a este valor en común lo denotamos por $$\int \limits_{a}^{b} f(x) dx.$$

En otras palabras, para que $f$ sea integrable, necesitamos que el ínfimo de las sumas superiores sea igual al supremo de las sumas inferiores. A veces también decimos que $f$ es Riemann integrable en $[a,b]$ o, si el contexto es claro, simplemente que es integrable.

No todas las funciones son Riemann integrables. Hacia el final de esta unidad daremos ejemplos de funciones que no lo son. Sin embargo, por ahora nos enfocaremos en ver algunos ejemplos que sí son Riemann integrables y probar propiedades de la integral definida en los casos en los que sí exista.

Ejemplo de integral definida

Veamos un ejemplo sencillo de cómo se verifica la definición de integral definida.

Ejemplo. Tomemos la función $f:[0,1]\to \mathbb{R}$ dada por $f(x)=x$. Veamos que dicha función es integrable en el intervalo $[0,1]$. Para ello, demos la partición $P_n$ homogénea del intervalo $[0,1]$ en celdas de longitud $1/n$, con $n$ un entero positivo. Si hacemos esto, las celdas de la partición son

$$[0,1/n],[1/n,2/n],\ldots[(n-1)/n,1].$$

Los supremos de los valores de $f$ en dicho intervalo son

$$1/n, 2/n, \ldots, 1,$$

y los ínfimos son

$$0,1/n, \ldots, (n-1)/n.$$

De este modo, para esta partición la suma superior sería

\begin{align*}

\overline{S} (f,P_n) &= \frac{1}{n}\left(\frac{1}{n}+\frac{2}{n}+\ldots+\frac{n}{n}\right)\\

&=\frac{1}{n^2}(1+2+\ldots+n)\\

&=\frac{n(n+1)}{2n^2}\\

&=\frac{1}{2}+\frac{1}{2n}.

\end{align*}

y la suma inferior sería

\begin{align*}

\underline{S} (f,P_n) &= \frac{1}{n}\left(\frac{0}{n}+\frac{2}{n}+\ldots+\frac{n-1}{n}\right)\\

&=\frac{1}{n^2}(0+1+2+\ldots+(n-1))\\

&=\frac{(n-1)n}{2n^2}\\

&=\frac{1}{2}-\frac{1}{2n}.

\end{align*}

La sucesión de números $\frac{1}{2}+\frac{1}{2n}$ se acerca tanto como queramos a $\frac{1}{2}$ por arriba. Como el ínfimo $\overline{S}(f)$ que estamos buscando es cota inferior de todas las sumas inferiores, en particular es de estas que vienen de particiones homogéneas. Así, $\overline{S}(f)\leq \frac{1}{2}$. Pero además, por una proposición de la entrada anterior sabemos que cualquier suma inferior es cota inferior de todas las sumas inferiores. Como $\overline{S}(f)$ es la mayor cota inferior, tenemos que $\overline{S}(f)\geq \frac{1}{2}-\frac{1}{2n}$ para todo $n$, y entonces $\overline{S}(f)\geq \frac{1}{2}$. Todo esto nos permite concluir que $\overline{S}(f)=\frac{1}{2}$.

De manera totalmente análoga (que te sugerimos argumentar cuidadosamente), se tiene que $\underline{S}(f)=\frac{1}{2}$. Concluimos entonces que $f$ es integrable en $[0,1]$ y que $$\int_0^1 f(x)\, dx = \frac{1}{2}.$$

$\triangle$

Aunque este ejemplo tuvo un intervalo y una función muy sencillas, se volvió algo elaborado justificar la parte de los ínfimos y supremos. Es por ello que nos conviene enunciar y demostrar algunos resultados sobre funciones integrables que nos permitirán determinar la integrabilidad con más comodidad.

Integral definida mediante particiones homogéneas y la condición de Riemann

Lo primero que haremos es demostrar que para que una función sea integrable, nos basta estudiar a las particiones homogéneas.

Teorema. Sean $f:\mathbb{R}\to \mathbb{R}$ una funcion acotada y $a\leq b$ reales. Sea $P_n$ la partición homogéneas del intervalo $[a,b]$ en $n$ partes. Supongamos que se da la siguiente igualdad de límites:

$$\lim_{n\to \infty} \overline{S}(f,P_n) = \lim_{n\to \infty} \underline{S}(f,P_n).$$

Entonces, la integral existe y es igual a ese límite en común.

Demostración. $\Leftarrow)$ La demostración sigue argumentos muy parecidos al ejercicio que presentamos como ejemplo arriba. Supongamos que los límites para las particiones homogéneas existen y son iguales a $L$. Estudiemos $\overline{S}(f)$. Por ser ínfimo de todas las sumas superiores, tendríamos en particular para las particiones homogéneas que $$\overline{S}(f)\leq \overline{S}(f,P_n),$$

para todo entero positivo $n$. Haciendo tender $n$ a infinito, obtenemos $\overline{S}(f) \leq L$. Por otro lado, sabemos que cualquier suma inferior es cota inferior de cualquier suma superior, en particular, cada $\underline{S}(f,P_n)$ es una de estas cotas inferiores. Como $\overline{S}(f)$ es la mayor de las cotas inferiores, tendríamos que $$\overline{S}(f)\geq \underline{S}(f,P_n).$$

Haciendo tender $n$ a infinito, obtenemos $\overline{S}(f)\geq L$. Así, $\overline{S}(f)=L$. Un argumento análogo demuestra que $\underline{S}(f)=L$, y por lo tanto la función es integrable en $[a,b]$.

$\square$

Un siguiente resultado importante es la condición de Riemann, que nos dice que para que una función sea integrable, nos basta encontrar una partición en donde la suma superior y la inferior estén tan cerca como querramos. A esto se le conoce como la condición de Riemann.

Teorema. Sean $f:\mathbb{R}\to \mathbb{R}$ una funcion acotada y $a\leq b$ reales. Se tiene que $f$ es integrable en $[a,b]$ si y sólo si para todo $\epsilon >0$ existe una partición $P_\epsilon$ tal que:

$$\overline{S}(f,P_\epsilon) \ – \ \underline{S}(f,P_\epsilon) < \epsilon .$$

Demostración. $\Rightarrow )$ Sea $f$ integrable. Debemos mostrar que para cada $\epsilon>0$ existe una partición $P_\epsilon$ tal que $$\overline{S}(f,P_\epsilon) \ – \ \underline{S}(f,P_\epsilon) < \epsilon.$$

Para ello, tomemos $\epsilon^*=\epsilon/2$. Como $\overline{S}(f)$ es ínfimo de las sumas superiores, entonces $\overline{S}(f)+\epsilon^\ast$ ya no es cota inferior para dichas sumas superiores, por lo que existe una partición $P$ tal que $\overline{S}(f,P) < \overline{S}(f)+\epsilon^*$. Así mismo, existe una partición $P’$ tal que $\underline{S}(f,P’) > \underline{S}-\epsilon^*$. Si $P_\epsilon$ es un refinamiento mutuo de $P$ y $P’$, tendríamos entonces que

\begin{align*}

\overline{S}(f,P_\epsilon)&<\overline{S}(f,P)<\overline{S}(f)+\epsilon^*\\

\underline{S}(f,P_\epsilon)&>\underline{S}(f,Q)>\underline{S}(f)-\epsilon^*.

\end{align*}

Multiplicando la segunda igualdad por $-1$ y sumando ambas, obtenemos entonces que

\begin{align*}

\overline{S}(f,P_\epsilon) \ – \ \underline{S}(f,P_\epsilon) &< \overline{S}(f) + \epsilon^* \ – \ \underline{S}(f) + \epsilon^* \\

&= 2 \epsilon^* \\

&= \epsilon .

\end{align*}

Aquí usamos que $\overline{S}(f)=\underline{S}(f)$ por ser $f$ integrable.

$\Leftarrow)$ Supongamos ahora que para todo $\epsilon$ se puede encontrar la partición $P_\epsilon$ que satisface $\overline{S}(f,P_\epsilon) \ – \ \underline{S}(f,P_\epsilon) < \epsilon$. Veremos que a partir de esto se puede probar que $ \overline{S}(f) = \underline{S}(f) .$

Por ser $\overline{S}(f)$ el ínfimo de todas las sumas superiores, se tiene que

$$\overline{S}(f,P_\epsilon) > \overline{S}(f) .$$

$$ \underline{S}(f,P_\epsilon) < \underline{S}(f) \Longrightarrow – \underline{S}(f,P_\epsilon) > – \underline{S}(f) .$$

$$\Longrightarrow \epsilon > \overline{S}(f,P_\epsilon) \ – \ \underline{S}(f,P_\epsilon) > \overline{S}(f) \ – \ \underline{S}(f) .$$

Y $\epsilon$ es tan pequeño como lo queramos, por lo tanto.

$$ \overline{S}(f) = \underline{S}(f) .$$

$\square$

Ejemplos de integral definida con los resultados que probamos

Veamos algunos ejemplos de cómo utilizar los resultados que acabamos de mostrar para demostrar que ciertas integrales definidas existen, y para encontrar su valor.

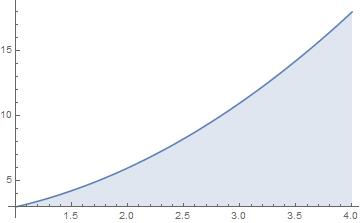

Ejemplo. Calculemos la integral de la función $f(x)=x$ en el intervalo $[3,4]$

Usaremos la técnica de los límites de las particiones homogéneas. Estudiaremos con detalle el caso de las sumas superiores y dejaremos el de las inferiores como ejercicio. Si la partición $P_n$ del intervalo $[a,b]$ es homogénea y en $n$ partes, las celdas tienen longitud $\frac{b-a}{n}$ y entonces son:

$$\left[a,a+\frac{b-a}{n}\right], \left[a+\frac{b-a}{n}, a+2\frac{b-a}{n}\right], \ldots, \left[a+(n-1)\frac{b-a}{n},b\right].$$

La función $f(x)=x$ es creciente, y entonces los máximos se alcanzan al final de cada intervalo. Así, para el intervalo $[3,4]$ tenemos:

\begin{align*}

\overline{S}(f,P_n)&=\sum_{i=1}^{n} f \left( 3+i \cdot \frac{4-1}{n} \right) \frac{4-3}{n}\\

&=\sum_{i=1}^{n} \left(3+ \frac{i}{n}\right) \frac{1}{n}\\

&=\sum_{i=1}^{n} \left(\frac{3}{n}+ \frac{i}{n^2}\right)\\

&=\sum_{i=1}^{n} \left(\frac{3}{n}\right) + \sum_{i=1}^{n} \left(\frac{i}{n^2}\right)\\

&=\frac{3}{n} \cdot n + \frac{1}{n^2} \sum_{i=1}^n i\\

&=3 + \frac{n(n+1)}{2n^2} \\

&=3 + \frac{1}{2} + \frac{1}{2n}\\

&=\frac{7}{2}+\frac{1}{2n}.

\end{align*}

De este modo,

$$\lim_{n\to\infty} \overline{S}(f,P_n) = \lim_{n\to\infty} \left(\frac{7}{2} + \frac{1}{2n}\right) = \frac{7}{2}.$$

Por tu cuenta, revisa que que también se cumple lo siguiente

$$\lim_{n\to\infty} \underline{S}(f,P_n) = \frac{7}{2}.$$

Así, por la proposición que mostarmos arriba, tenemos que la integral en el intervalo $[3,4]$ existe y por lo tanto:

$$ \int \limits_{3}^{4} x \, dx = \frac{7}{2}.$$

$\triangle$

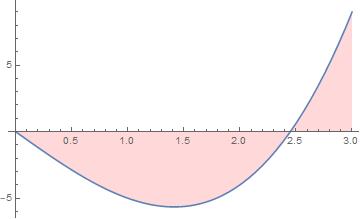

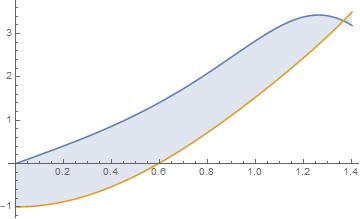

Ejemplo. Ahora calculemos la integral de la función $f(x)=-x^2 + 3$ en el intervalo $[1,3]$ . Al hacer una figura, obtenemos la siguiente gráfica.

Observa que en este caso tenemos 2 áreas: del eje $x$ y otra por debajo del eje $x$. Todo lo que hemos hecho funciona tanto para funciones positivas, como negativas. Pero obtendremos algo interesante de la conclusión de este problema.

Para ver que la integral existe, usaremos nuevamente la técnica de las particiones homogéneas. Ahora haremos las sumas inferiores. Como la función es decreciente, los valores más chicos aparecen al final de cada intervalo. Tenemos entonces que:

\begin{align*}

\underline{S}(f,P)&=\sum_{i=1}^{n} \left( – \ \left( 1+i\cdot \left(\frac{3-1}{n}\right) \right)^2+3 \right) \left(\frac{3-1}{n} \right) \\

&=\sum_{i=1}^{n} \left(- \ \left(1+i\cdot \left(\frac{2}{n}\right)\right)^2+3\right) \left(\frac{2}{n}\right)\\

&=\sum_{i=1}^{n} \left( – \ \left(1+ \frac{4i}{n} + \frac{4 i^2}{n^2}\right)+3\right) \left(\frac{2}{n}\right)\\

&=\sum_{i=1}^{n} \left(\frac{ 4}{n} – \frac{8i} {n^2} – \frac{8 i^2}{n^3}\right)\\

&=\frac{4}{n} \sum_{i=1}^{n} – \frac{8}{n^2} \sum_{i=1}^{n} i – \frac{8}{n^3}\sum_{i=1}^{n} i^2\\

&=\frac{4}{n} \cdot n – \frac{8}{n^2} \frac{n(n+1)}{2} – \frac{8}{n^3} \frac{n(n+1)(2n+1)}{6} \\

&=4 \ – \ \frac{8n^2}{2n^2} \ – \ \frac{8n}{2n^2} \ – \ \frac{8 \cdot 2n^3}{6n^3} \ – \ \frac{8 \cdot 3n^2}{6n^3} \ – \ \frac{8n}{6n^3} \\

&= – \ \frac{8}{3} \ – \ \frac{8n}{2n^2} \ – \ \frac{8 \cdot 3n^2}{6n^3} \ – \ \frac{8n}{6n^3} .

\end{align*}

Así, $$\lim_{n\to\infty} \underline{S}(f,P)=-\frac{8}{3}.$$

Se puede mostrar que el límite de las sumas superiores para las particiones homogéneas también es $-\frac{8}{3}$ (verifícalo), así que la integral buscada tiene este valor. De esta forma,

$$ \int \limits_{1}^{3} -x^2 +3 \, dx = – 8/3 .$$

$\triangle$

¿Áreas negativas?

Se comentó que la integral se utiliza para el cálculo de áreas bajo la curva, entonces, ¿Por qué el resultado del ejemplo anterior es negativo? ¿Hay áreas negativas? Intuitivamente, no debería haber áreas negativas. Sin embargo, el procedimiento que usamos para definir a la integral definida sí nos puede dar números negativos. Puedes pensarlo como sigue: el área que estamos calculando va del eje $x$ a la gráfica de la función $f$. Si esa gráfica está por debajo, entonces estámos yendo en dirección negativa. En el último ejemplo hay tanto una región por encima del eje $x$, como una por debajo. El número que nos salió es la diferencia de ambas áreas: el área por arriba del eje $x$, menos el área por debajo del eje $x$. Como el resultado que obtuvimos fue negativo, entonces el área por debajo del eje $x$ era mayor en magnitud.

Esta es una propiedad un poco antintuitiva, pero es importante preservarla. El cálculo de áreas es sólo una de las aplicaciones que tiene la integral. En otras aplicaciones, es importante que la integral mida qué tanto estuvimos por encima del eje $x$ y qué tanto estuvimos por debajo.

¿Y si queremos realmente entender la suma de las dos áreas de la figura y no la resta? En ese caso, tendremos que hacer una figura para entender cómo hacer las cuentas. Si hay área que está por debajo del eje $x$, deberemos agregar un signo $-$ para contarla correctamente como área positiva. Pero entonces tendremos que partir nuestro intervalo de integración en varios intervalos de acuerdo a cuándo la gráfica de $f$ cruza al eje $x$.

Con esto en mente, retomemos el ejemplo anterior.

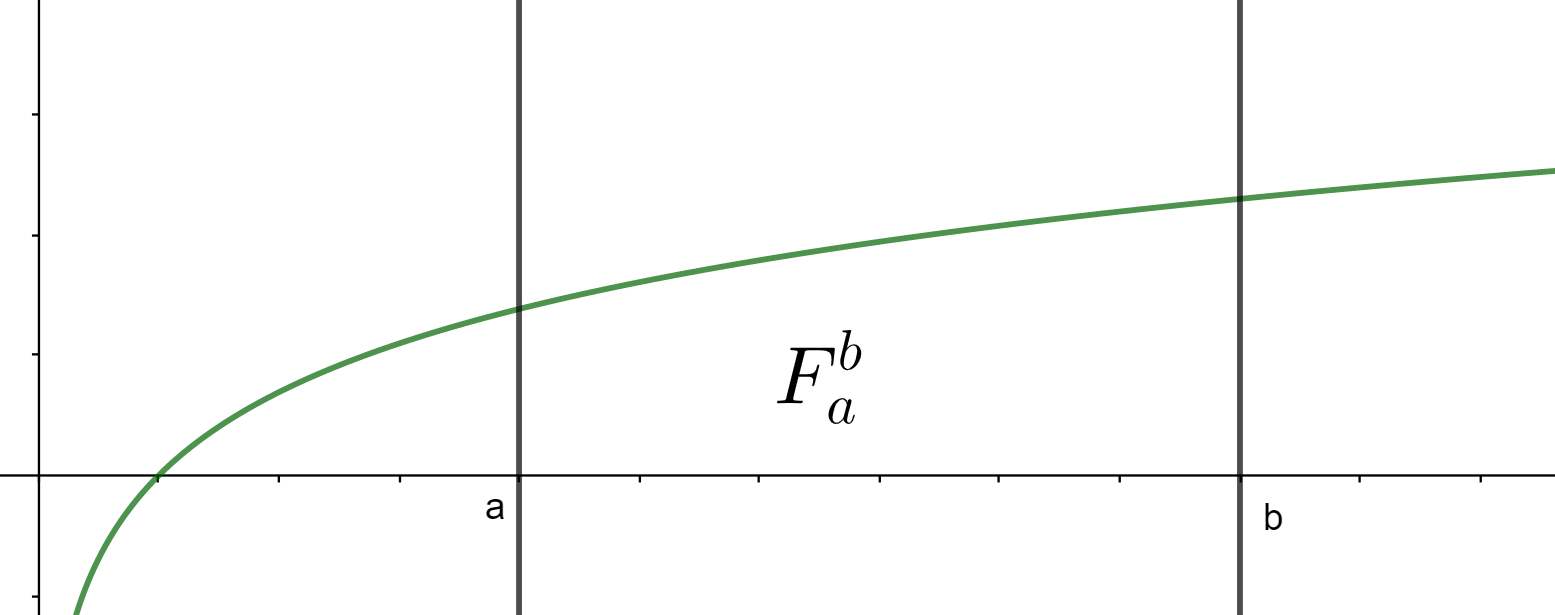

Ejemplo. Encontremos el área en valor absoluto que genera la función $f(x)=-x^2 + 3$ en el intervalo $[1,3]$.

Lo primeo que haremos es obtener el punto donde la función cruza al eje $x$. Para ello, se requiere que $-x^2+3=0$, que en dicho intervalo sucede en $x=\sqrt{3}$.

Una vez encontrado el punto raíz o la raíz de la función, ahora podemos partir el área absoluta que nos interesa en dos intervalos: el $[1,\sqrt{3}]$ y el $[\sqrt{3},3]$.

Pensando en que queremos calcular el área absoluta, necesitamos dividir la formula que se planteó anteriormente en los intervalos correspondientes, y en el intervalo $[\sqrt{3},3]$ será necesario agregar un signo menos para que el área que se calcula como negativa, ahora se cuente de manera positiva. De esta manera, tendríamos:

$$ F_1^3 = \int \limits_{1}^{\sqrt 3} -x^2 +3 \, dx \ – \ \int \limits_{\sqrt 3}^{3} -x^2 +3 \, dx .$$

Ahora queda replicar el proceso que vimos en la suma anterior con estos 2 nuevos intervalos y juntarlos considerando el cambio de signo. Desarrollando los cálculos, se encuentra que el área generada por la función es de:

$$F_1^ 3= 4 \sqrt 3 \ – \ \frac{8}{3}.$$

$\triangle$

Nota. En este ejemplo partimos el intervalo en dos subintervalos, pero el intervalo puede quedar partido tantas veces como la función $f$ lo requiera, de acuerdo a la cantidad de veces que se cruza el eje $x$.

Más adelante…

En esta entrada dimos la definición formal de que una función sea integrable en cierto intervalo. O mejor dicho, que sea Riemann integrable. En cursos más avanzados de matemáticas se definen y estudian otras nociones de integrabilidad, pero por ahora esta es la que nos interesa. Para que la integral de Riemann exista, necesitamos que coindidan el ínfimo de las sumas superiores y el supremo de las sumas inferiores de la función dada. En ese caso, el valor de la integral es ese valor en común.

Ya dada la definición, dimos algunos resultados que nos ayudarán a determinar cuándo una función es integrable. En siguientes entradas daremos más propiedades que nos ayudarán entender mejor la integrabilidad y la integral. Varias entradas despuésse hablará de las integrales indefinidas y del teorema fundamental del cálculo, que daran pie a numerosas técnicas de integración.

Lo último que hicimos en esta entrada es notar que hay casos en donde el valor de la integral que se encuentra es negativo. Esto contradice un poco nuestra intuición de que la integral es un área. Sin embargo, ya platicamos qué hacer en este caso si queremos realmente el «área positiva». Seguiremos explorando esta idea de integrales negativas un poco más adelante. Por ahora, lo que puedes hacer es identificar los intervalos en los que la función tiene determinado signo.

Tarea moral

- Completa las cuentas que quedaron pendientes en cada uno de los ejercicios.

- Expresa la siguiente expresión como una integral en el intervalo $[0,\pi]$. $$\lim_{n \rightarrow \infty} \sum_{i=1}^n (x_i^3 + x_i ~ sin (x_i)) \triangle x .$$

- Encuentra el área delimitada por la curva $f(x)=x^2 +2 $ y el eje $x$ en el intervalo $[1,4]$.

4. Encuentra el valor del área delimitada por la gráfica de la función$f(x)= x^3-6x$ en el intervalo $[0,3]$, que es la zona sombreada. Realiza las cuentas tanto con áreas absolutas, tanto con áreas con signo.

5. Encuentra el área de la función $f(x)=\sqrt {1-x^2}$ en el intervalo $[0,1]$.

Entradas relacionadas

- Página del curso: Cálculo Diferencial e Integral II

- Entrada anterior: Motivación de integral, sumas superiores e inferiores

- Entrada siguiente: Propiedades de la integral definida