(Trabajo de titulación asesorado por la Dra. Diana Avella Alaminos)

Introducción

Lo sé, el título parece un trabalenguas. Pero ten paciencia, en realidad no es tan complicado.

A lo largo de este curso hemos estado trabajando con grupos, ahora vamos a pensar en funciones que respetan de alguna manera la estructura de los grupos.

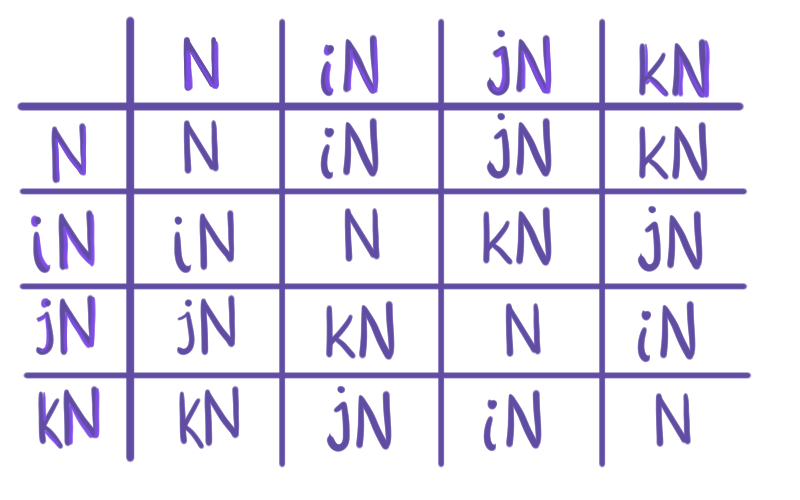

Tomemos por ejemplo el grupo de Klein, $V = \{(0,0), (1,0), (0,1),(1,1)\}$, es un grupo que tiene un neutro $(0,0)$ y los otros tres elementos comparten que: tienen orden 2, si se suman consigo mismos obtenemos el neutro y si sumamos dos, obtenemos el tercero:

\begin{align*}

(1,0) + (1,0) &= (0,0)\quad &(1,0) + (0,1) &= (1,1)\\

(0,1) + (0,1) &= (0,0)\quad &(0,1) + (1,1) &= (1,0)\\

(1,1) + (1,1) &= (0,0)\quad &(1,1) + (1,0) &= (0,1).

\end{align*}

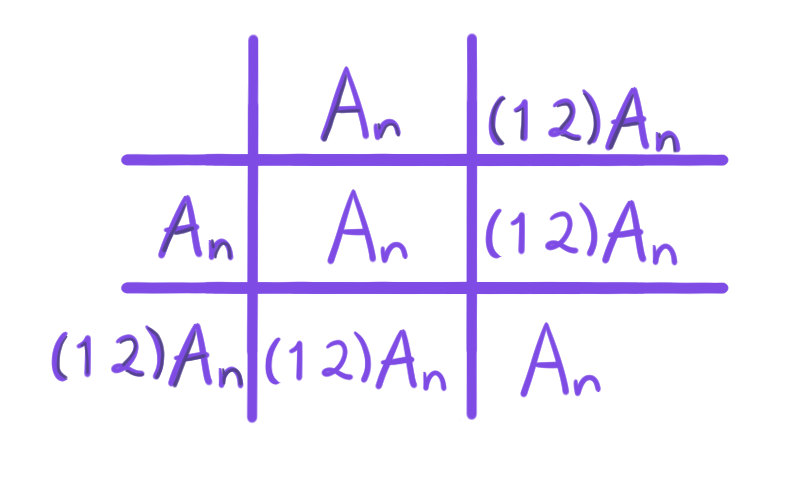

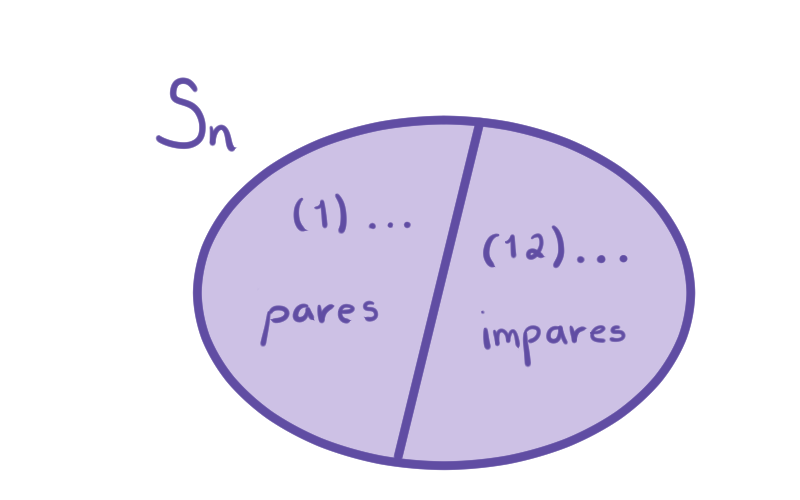

Por otro lado, podemos tomar el conjunto $P = \{(1), (1\, 2)(3\,4), (1\,3)(2\,4), (1\,4)(2\,3)\}$. $P$ es un grupo que tiene un neutro $(1)$ y los otros tres elementos comparten que: tienen orden 2, si se componen consigo mismos obtenemos el neutro y si componemos dos, obtenemos el tercero:

\begin{align*}

(1\, 2)(3\,4)(1\,2)(3\,4) &= (1)\quad &(1\, 2)(3\,4)(1\,3)(2\,4) &= (1\,4)(2\,3)\\

(1\,3)(2\,4)(1\,3)(2\,4) &= (1)\quad &(1\,3)(2\,4)(1\,4)(2\,3) &= (1\, 2)(3\,4)\\

(1\,4)(2\,3)(1\,4)(2\,3) &= (1)\quad &(1\,4)(2\,3)(1\, 2)(3\,4) &= (1\,3)(2\,4).

\end{align*}

¿Suena familiar? Bueno, esto es porque a pesar de que son grupos distintos, con elementos y operaciones muy diferentes, estructuralmente son iguales.

Para formalizar esta idea, nos gustaría observar que existe una correspondencia entre los dos grupos. Esta correspondencia es biyectiva y además tiene que respetar la estructura de las operaciones. Entonces sería algo así:

\begin{align*}

(0,0) &\longrightarrow (1)\\

(1,0) &\longrightarrow (1\, 2)(3\,4)\\

(0,1) &\longrightarrow (1\,3)(2\,4)\\

(1,1) &\longrightarrow (1\,4)(2\,3).

\end{align*}

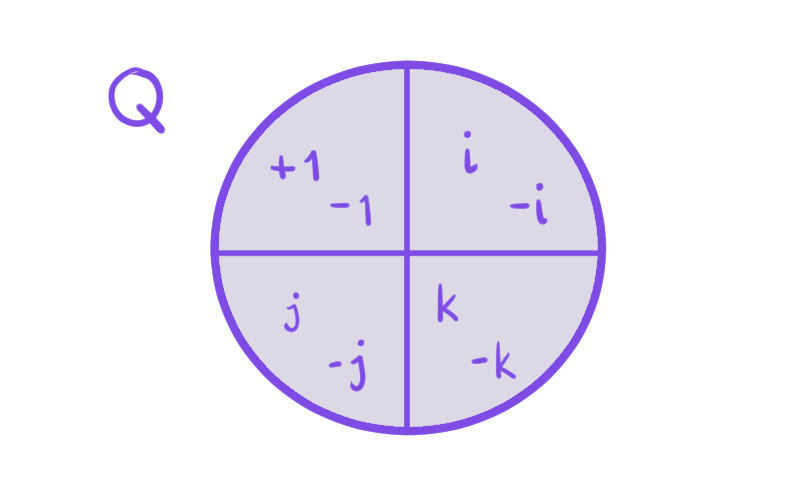

En este caso decimos que $V$ y $P$ son isomorfos. Lo definiremos formalmente más adelante, por ahora es importante que observes que esta correspondencia mantiene la estructura de las operaciones de los grupos. Así, este es el objetivo de la entrada, definir y trabajar con funciones (no necesariamente biyectivas) que mantengan las operaciones de dos grupos. Estas funciones son llamadas homomorfismos.

¿Qué son todos estos homomorfismos?

Primero, comencemos definiendo lo más general. Una función que mantenga las operaciones entre grupos.

Definición. Sean $(G,*), (\bar{G}, \bar{*})$ grupos. Decimos que la función $\varphi:G \to \bar{G}$ (más bien, $\varphi: (G,*)\to (\bar{G},\bar{*})$) es un homomorfismo de grupos si

$$\varphi(a*b) = \varphi(a) \bar{*} \varphi(b) \quad \forall a,b\in G.$$

Se puede decir que $\varphi$ «abre» a la operación.

Definiciones varias.

Ahora, le agregaremos condiciones a $\varphi$. Dependiendo de qué condición extra cumpla, el homomorfismo tomará otro nombre.

- Si el homomorfismo $\varphi$ es inyectivo se llama monomorfismo.

- Si el homomorfismo $\varphi$ es suprayectivo se llama epimorfismo.

- Si el homomorfismo $\varphi$ es biyectivo se llama isomorfismo.

- Un isomorfismo de un grupo en sí mismo se llama automorfismo.

Notación. Si $\varphi$ es un isomorfismo decimos que $G$ es isomorfo a $\bar{G}$ y lo denotamos como $G \cong \bar{G}$.

Puede parecer mucho vocabulario nuevo, así que guarda esta entrada para recordar qué es cada uno.

Ejemplos

Ejemplo 1.Tomemos $\varphi: (\z , +) \to(\z_n,+)$ con $\varphi(a) = \bar{a}$ para toda $a\in \z$. Es decir, $\varphi$ manda a cada entero a su clase módulo $n$.

Veamos qué sucede con la suma :

$\varphi(a+b) = \overline{a+b} = \bar{a} + \bar{b} = \varphi(a) + \varphi(b)$ para toda $a,b \in \z$.

Además, dado $\bar{a} \in \z_n, \bar{a} = \varphi(a)$. Entonces $\varphi$ es suprayectiva.

Por lo tanto $\varphi$ es un epimorfismo.

Ejemplo 2. Sea $n \in \n^+$.

Tomamos $\varphi: (S_n, \circ) \to(S_{n+1}, \circ)$ donde para cada $\alpha \in S_n$ se define $\varphi(\alpha) \in S_{n+1}$ tal que

\begin{align*}

\varphi(\alpha)(i) =

\begin{cases}

\alpha(i) & \text{si } i \in \{1,…,n\} \\

n+1 & \text{si } i = n+1.

\end{cases}

\end{align*}

Es decir, se mantienen las permutaciones de $S_n$ pero se consideran como elementos de $S_{n+1}$ pensando que dejan fijo a $ n+1$.

Ahora veamos qué sucede con el producto. Sean $\alpha, \beta \in S_n$. Entonces

\begin{align*}

\varphi(\alpha)\varphi(\beta) (i) &= \varphi(\alpha)(\varphi(\beta)(i)) \\

& = \begin{cases} \alpha(\beta(i)) & \text{si } i \in \{1, … , n\} \\

n+1 & \text{si } i = n+1

\end{cases} \\

&= \varphi(\alpha\beta)(i).

\end{align*}

Además, si $\varphi(\alpha) = (1)$ entonces $\alpha(i) = i$ para todo $i \in \{1, …, n\}$. Así $\alpha = (1).$ Por lo que $\varphi$ es inyectiva.

En conclusión, $\varphi$ es un monomorfismo.

Ejemplo 3. Sea $\varphi: (\r, +) \to(\r^+, \cdot)$ con $\varphi(x) = e^x$ para todo $x\in\r$.

Entonces, para la suma de dos elementos en el dominio $x,y \in \r$ tendríamos,

$$\varphi(x+y) = e^{x+y} = e^x e^y = \varphi(x) \varphi(y).$$

Sabemos que $\psi: \r^+ \to\r$ con $\psi(y) = \ln(y)$ para toda $y \in \r^+$ es la inversa de $\varphi$, así $\varphi$ es biyectiva.

Por lo tanto $\varphi$ es un isomorfismo.

Ejemplo 4. Veamos un ejemplo más abstracto. Sean $G$ un grupo y $g\in G$. Dados $x,y \in G$, definimos

$\gamma_g(xy) = g(xy) g^{-1} = (gxg^{-1}) (gyg^{-1}) = \gamma_g (x) \gamma_g(y).$

Además, para toda $x \in G$,

\begin{align*}

\gamma_g \circ \gamma_{g^{-1}} (x) &= \gamma_g (g^{-1}x g ) = g(g^{-1} x g) g^{-1} = x \\\\

\gamma_{g^{-1}} \circ \gamma_{g} (x) &= \gamma_{g^{-1}} (g x g^{-1} ) = g^{-1}(g x g^{-1}) g = x .

\end{align*}

Donde, $g^{-1}$ existe porque $G$ es un grupo. Así, lo anterior nos indica que $\gamma_g$ es un homomorfismo invertible, que además tiene como dominio y codominio a $G$.

Por lo tanto $\gamma_g$ es un automorfismo.

Propiedades de los homomorfismos

Proposición. El inverso de un isomorfismo es un isomorfismo.

Demostración.

Sean $(G, *), (\bar{G}, \bar{*})$ grupos, $\varphi:G\to\bar{G}$ es un isomorfismo.

Tomemos $c,d \in\bar{G}$.

Como $\varphi$ es suprayectiva, existen $a,b \in G$ tales que $\varphi(a) = c$ y $\varphi(b) = d$.

\begin{align*}

\varphi^{-1} (c \bar{*}d) &= \varphi^{-1} \left( \varphi(a) \bar{*} \varphi(b) \right) \\

&= \varphi^{-1}\left( \varphi(a * b)\right) & \varphi \text{ es un homomorfismo}\\

& = \varphi^{-1} \circ \varphi (a*b)\\

& = a * b & \text{Composición de inversas}\\

& = \varphi^{-1}(c) * \varphi^{-1}(d) & \text{Pues }\varphi(a) = c,\, \varphi(b) = d.

\end{align*}

Así, $\varphi^{-1}$ es un homomorfismo y como es biyectivo por ser invertible, entonces $\varphi^{-1}$ es un isomorfismo.

$\blacksquare$

Proposición. La composición de homomorfismos es un homomorfismo.

Demostración.

Sean $(G,*), (\bar{G}, \bar{*}), (\tilde{G}, \tilde{*})$ grupos. También, sean $\varphi: G \to\bar{G}$ y $\psi: \bar{G} \to\tilde{G}$ homomorfismos.

Dados $a,b \in G$,

\begin{align*}

\psi \circ \varphi(a*b) &= \psi (\varphi (a*b)) \\

&= \psi(\varphi(a)\,\bar{*}\, \varphi(b)) &\varphi\text{ es homomorfismo}\\

&= \psi(\varphi(a)) \,\tilde{*}\, \psi(\varphi(b)) & \psi\text{ es homomorfismo} \\

&= \psi\circ\varphi(a)\, \tilde{*} \,\psi\circ\varphi(b).

\end{align*}

Por lo tanto $\psi\circ\varphi$ es un homomorfismo.

$\blacksquare$

Observaciones.

- Para todo $G$ grupo, $G\cong G$. (Es decir, $G$ es isomorfo a sí mismo).

- Si $G, \bar{G}$ son grupos y $G \cong \bar{G}$, entonces $\bar{G}\cong G$.

- Si $G, \bar{G}, \tilde{G}$ son grupos, $G \cong \bar{G}$ y $\bar{G} \cong \tilde{G}$, entonces $G\cong \tilde{G}.$

Tarea moral

A continuación hay algunos ejercicios para que practiques los conceptos vistos en esta entrada. Te será de mucha utilidad intentarlos para entender más la teoría vista.

- Sea $D_{2n} = \left<a,b\right>$ el grupo diédrico formado por las simetrías de un $n$-ágono, con $a$ la rotación de $\displaystyle\frac{2\pi}{n}$ y $b$ la reflexión con respecto al eje $x$. Sea $\varphi: D_{2n} \to D_{2n}$ tal que $\varphi(a^ib^j) = b^j$. ¿Es $\varphi$ un homomorfismo?

- Sean $X$ y $Y$ dos conjuntos con la misma cardinalidad. ¿Qué relación hay entre $S_X$ y $S_Y$?

- Sea $V = \{e, (1\,2)(3\,4), (1\,3)(2\,4), (1\,4)(1\,3)\} \leq S_4$. Encuentra $H\leq S_4$, $H\neq V$ pero isomorfo a $V$. ¿Es $H$ normal en $S_4$?

Más adelante…

Los homomorfismos son una parte importante de las matemáticas, porque respetar las operaciones es una característica sencilla a simple vista, pero lo suficientemente compleja para que las funciones que la cumplan sean muy interesantes. Los homomorfismos nos permiten cambiar de espacios de trabajo sin mucho problema.

Por otro lado, tal vez ya sabes que las matemáticas de este curso (y de la mayoría de los cursos en este blog) están fundamentadas en la Teoría de Conjuntos. Esta teoría nos permite construir a los objetos matemáticos a partir de conjuntos. Como curiosidad, tal vez te interese saber que existe otra teoría llamada Teoría de Categorías, que generaliza lo anterior, y en la que la generalización de un homomorfismo es llamado morfismo.

Aunque estén definidos de manera diferente, los homomorfismos de esta entrada y los morfismos de la Teoría de Categorías son, en intuición, lo mismo. Esto refuerza la idea de que los homomorfismos son en realidad más importantes de lo que parecen.

Pero bueno, regresemos a nuestro curso: en la siguiente entrada continuaremos viendo el comportamiento de los homomorfismos.

Entradas relacionadas

- Ir a Álgebra Moderna I.

- Entrada anterior del curso: Subgrupo Conmutador.

- Siguiente entrada del curso: Propiedades de un Homomorfismo.

- Resto de cursos: Cursos.