Introducción

Hasta ahora hemos conocido varias operaciones que involucran escalares, vectores y matrices. En esta entrada aprenderemos sobre una de las operaciones más importantes en el álgebra lineal: el producto de matrices con matrices.

Definición de producto de matrices

Para poder efectuar el producto de dos matrices, hay que asegurarnos de que el número de columnas de la primera matriz sea igual al número de filas de la segunda matriz.

El resultado de una matriz $A$ de tamaño $m \times n$ por una matriz $B$ de tamaño $n \times \ell$ será la matriz $C = AB$ de tamaño $m \times \ell$, donde la entrada $c_{ij}$ de $C$ está dada por la fórmula

\[

c_{ij} = a_{i1}b_{1j} + a_{i2}b_{2j} + \cdots + a_{in}b_{nj}.

\]

A primera vista esta fórmula puede parecer complicada, sin embargo, practicando con algunos ejemplos verás que es muy fácil de implementar.

- Producto de matrices de tamaño $2 \times 2$:

Sean

\[

A

=

\begin{pmatrix}

1 & 3 \\

5 & 7

\end{pmatrix}

\qquad

\text{y}

\qquad

B

=

\begin{pmatrix}

2 & 4 \\

6 & 8

\end{pmatrix}.

\]

Como estamos multiplicando una matriz de tamaño $2 \times 2$ por una matriz de tamaño $2 \times 2$, sabemos que el resultado será otra matriz de tamaño $2 \times 2$. Ahora, iremos calculando una por una sus entradas.

Sea $C = AB$. Para calcular la entrada $c_{11}$ observamos la primera fila de $A$ y la primera columna de $B$, las cuales son

\[

A

=

\begin{pmatrix}

1 & 3\\

\phantom{5} & \phantom{7}

\end{pmatrix}

\qquad

\text{y}

\qquad

B

=

\begin{pmatrix}

2 & \phantom{4} \\

6 & \phantom{8}

\end{pmatrix},

\]

de modo que $c_{11} = (1)(2)+(3)(6) = 20$:

\[

AB

=

\begin{pmatrix}

20 & \phantom{28} \\

\phantom{52} & \phantom{76}

\end{pmatrix}.

\]

Para la entrada $c_{12}$, nos fijamos en la primera columna de $A$ y en la segunda columna de $B$, que son

\[

A

=

\begin{pmatrix}

1 & 3\\

\phantom{5} & \phantom{7}

\end{pmatrix}

\qquad

\text{y}

\qquad

B

=

\begin{pmatrix}

\phantom{2} & 4 \\

\phantom{6} & 8

\end{pmatrix},

\]

obteniendo $c_{12} = (1)(4) + (3)(8) = 28$:

\[

AB

=

\begin{pmatrix}

20 & 28 \\

\phantom{52} & \phantom{76}

\end{pmatrix}.

\]

De manera similar, observemos la segunda fila de $A$ y la primera columna de $B$,

\[

A

=

\begin{pmatrix}

\phantom{1} & \phantom{3} \\

5 &7

\end{pmatrix},

\qquad

B

=

\begin{pmatrix}

2 & \phantom{4} \\

6 & \phantom{8}

\end{pmatrix},

\]

obteniendo $c_{21} = (5)(2) + (7)(6) = 52$, mientras que la segunda fila de $A$ y la segunda columna de $B$ son

\[

A

=

\begin{pmatrix}

\phantom{1} & \phantom{3} \\

5 &7

\end{pmatrix},

\qquad

B

=

\begin{pmatrix}

\phantom{2} & 4 \\

\phantom{6} & 8

\end{pmatrix},

\]

obteniendo $c_{22} = (5)(4) + (7)(8) = 76$.

Por lo tanto,

\[

AB

=

\begin{pmatrix}

20 & 28 \\

52 & 76

\end{pmatrix}.

\]

En general, el resultado del producto de las matrices

\[

A

=

\begin{pmatrix}

a_{11} & a_{12} \\

a_{21} & a_{22}

\end{pmatrix}

\qquad

\text{y}

\qquad

B

=

\begin{pmatrix}

b_{11} & b_{12} \\

b_{21} & b_{22}

\end{pmatrix}

\]

es

\[

AB

=

\begin{pmatrix}

a_{11} & a_{12} \\

a_{21} & a_{22}

\end{pmatrix}

\begin{pmatrix}

b_{11} & b_{12} \\

b_{21} & b_{22}

\end{pmatrix}

=

\begin{pmatrix}

a_{11}b_{11} + a_{12}b_{21} & a_{11}b_{12} + a_{12}b_{22} \\

a_{21}b_{11} + a_{22}b_{21} & a_{21}b_{12} + a_{22}b_{22}

\end{pmatrix}.

\]

- Producto de matriz de $3 \times 2$ por matriz de $2 \times 2$:

Supongamos que

\[

A

=

\begin{pmatrix}

3 & 5 \\

1 & 0 \\

4 & 3

\end{pmatrix}

\qquad

\text{y}

\qquad

B

=

\begin{pmatrix}

7 & 8 \\

5 & 2

\end{pmatrix}.

\]

En este caso, como estamos multiplicando una matriz de tamaño $3 \times 2$ por una matriz de tamaño $2 \times 2$, la matriz resultante tendrá tamaño $3 \times 2$.

Podemos obtener sus entradas de manera similar al caso anterior. Si $C = AB$, entonces la entrada $c_{12}$ la podemos encontrar revisando la primera fila de $A$ y la segunda columna de $B$,

\[

A

=

\begin{pmatrix}

3 & 5 \\

\phantom{1} & \phantom{0} \\

\phantom{4} & \phantom{3}

\end{pmatrix},

\qquad

B

=

\begin{pmatrix}

\phantom{7} & 8 \\

\phantom{5} & 2

\end{pmatrix}.

\]

de modo que $c_{12} = (3)(8) + (5)(2) = 34$. Por su parte, para obtener la entrada $c_{31}$ nos fijamos en la tercera fila de $A$ y la primera columna de $B$,

\[

A

=

\begin{pmatrix}

\phantom{3} & \phantom{5} \\

\phantom{1} & \phantom{0} \\

4 & 3

\end{pmatrix},

\qquad

B

=

\begin{pmatrix}

7 & \phantom{8} \\

5 & \phantom{2}

\end{pmatrix}.

\]

obteniendo $c_{31} = (4)(7) + (3)(5) = 43$.

¿Podrías comprobar que

\[

AB

=

\begin{pmatrix}

46 & 34 \\

7 & 8 \\

43 & 38

\end{pmatrix}?

\]

Así, para el caso general de matrices de $3 \times 2$ por $2 \times 2$, obtendremos

\[

\begin{pmatrix}

a_{11} & a_{12} \\

a_{21} & a_{22} \\

a_{31} & a_{32}

\end{pmatrix}

\begin{pmatrix}

b_{11} & b_{12} \\

b_{21} & b_{22}

\end{pmatrix}

=

\begin{pmatrix}

a_{11}b_{11} + a_{12}b_{21} & a_{11}b_{12} + a_{12}b_{22} \\

a_{21}b_{11} + a_{22}b_{21} & a_{21}b_{12} + a_{22}b_{22} \\

a_{31}b_{11} + a_{32}b_{21} & a_{31}b_{12} + a_{32}b_{22}

\end{pmatrix}.

\]

- Producto de matriz de $4 \times 2$ por matriz de $2 \times 3$:

¿Podrías verificar que la siguiente fórmula es correcta?

\[

\begin{pmatrix}

a_{11} & a_{12} \\

a_{21} & a_{22} \\

a_{31} & a_{32} \\

a_{41} & a_{42}

\end{pmatrix}

\begin{pmatrix}

b_{11} & b_{12} & b_{13} \\

b_{21} & b_{22} & b_{23}

\end{pmatrix}

=

\begin{pmatrix}

a_{11}b_{11} + a_{12}b_{21} & a_{11}b_{12} + a_{12}b_{22} & a_{11}b_{13} + a_{12}b_{23} \\

a_{21}b_{11} + a_{22}b_{21} & a_{21}b_{12} + a_{22}b_{22} & a_{21}b_{13} + a_{22}b_{23} \\

a_{31}b_{11} + a_{32}b_{21} & a_{31}b_{12} + a_{32}b_{22} & a_{31}b_{13} + a_{32}b_{23} \\

a_{41}b_{11} + a_{42}b_{21} & a_{41}b_{12} + a_{42}b_{22} & a_{41}b_{13} + a_{42}b_{23}

\end{pmatrix}.

\]

Propiedades del producto de matrices

A continuación revisaremos algunas de las propiedades que cumple la multiplicación de matrices. Para demostrar las siguientes propiedades, consideraremos la matriz $A$ de tamaño $3 \times 2$ y las matrices $B$ y $C$ de tamaño $2 \times 2$, aunque se pueden probar para matrices de cualesquier otro tamaño entre las cuales se puedan efectuar las operaciones.

Veamos que si efectuamos la multiplicación de una matriz de tamaño $m \times n$ por una matriz de tamaño $n \times 1$ siguiendo el algoritmo descrito anteriormente, el resultado coincide con el de multiplicar la matriz de tamaño $m \times n$ por un vector de tamaño $n$. Por ejemplo, si multiplicamos $A$ por una matriz $U$ de tamaño $2 \times 1$, obtendremos

\[

\begin{pmatrix}

a_{11} & a_{12} \\

a_{21} & a_{22} \\

a_{31} & a_{32}

\end{pmatrix}

\begin{pmatrix}

u_{11} \\

u_{12}

\end{pmatrix}

=

\begin{pmatrix}

a_{11}u_{11} + a_{12}u_{21} \\

a_{21}u_{11} + a_{22}u_{21} \\

a_{31}u_{11} + a_{32}u_{21}

\end{pmatrix}.

\]

Esta es una observación importante pues todo lo que demostremos para el producto de matrices también lo tendremos para el producto de matriz por vector.

Veamos que la multiplicación de matrices es asociativa:

\begin{align*}

(AB)C

&=

\left(

\begin{pmatrix}

a_{11} & a_{12} \\

a_{21} & a_{22} \\

a_{31} & a_{32}

\end{pmatrix}

\begin{pmatrix}

b_{11} & b_{12} \\

b_{21} & b_{22}

\end{pmatrix}

\right)

\begin{pmatrix}

c_{11} & c_{12} \\

c_{21} & c_{22}

\end{pmatrix}

\\[5pt]

&=

\begin{pmatrix}

a_{11}b_{11} + a_{12}b_{21} & a_{11}b_{12} + a_{12}b_{22} \\

a_{21}b_{11} + a_{22}b_{21} & a_{21}b_{12} + a_{22}b_{22} \\

a_{31}b_{11} + a_{32}b_{21} & a_{31}b_{12} + a_{32}b_{22} \\

\end{pmatrix}

\begin{pmatrix}

c_{11} & c_{12} \\

c_{21} & c_{22}

\end{pmatrix}

\\[5pt]

&=

\begin{pmatrix}

(a_{11}b_{11} + a_{12}b_{21})c_{11} + (a_{11}b_{12} + a_{12}b_{22})c_{21}

& (a_{11}b_{11} + a_{12}b_{21})c_{12} + (a_{11}b_{12} + a_{12}b_{22})c_{22} \\

(a_{21}b_{11} + a_{22}b_{21})c_{11} + (a_{21}b_{12} + a_{22}b_{22})c_{21}

& (a_{21}b_{11} + a_{22}b_{21})c_{12} + (a_{21}b_{12} + a_{22}b_{22})c_{22} \\

(a_{31}b_{11} + a_{32}b_{21})c_{11} + (a_{31}b_{12} + a_{32}b_{22})c_{21}

& (a_{31}b_{11} + a_{32}b_{21})c_{12} + (a_{31}b_{12} + a_{32}b_{22})c_{22}

\end{pmatrix}

\\[5pt]

&=

\begin{pmatrix}

a_{11}(b_{11}c_{11} + b_{12}c_{21}) + a_{12}(b_{21}c_{11} + b_{22}c_{21})

& a_{11}(b_{11}c_{12} + b_{12}c_{22}) + a_{12}(b_{21}c_{12} + b_{22}c_{22}) \\

a_{21}(b_{11}c_{11} + b_{12}c_{21}) + a_{22}(b_{21}c_{11} + b_{22}c_{21})

& a_{21}(b_{11}c_{12} + b_{12}c_{22}) + a_{22}(b_{21}c_{12} + b_{22}c_{22}) \\

a_{31}(b_{11}c_{11} + b_{12}c_{21}) + a_{32}(b_{21}c_{11} + b_{22}c_{21})

& a_{31}(b_{11}c_{12} + b_{12}c_{22}) + a_{32}(b_{21}c_{12} + b_{22}c_{22})

\end{pmatrix}

\\[5pt]

&=

\begin{pmatrix}

a_{11} & a_{12} \\

a_{21} & a_{22} \\

a_{31} & a_{32}

\end{pmatrix}

\begin{pmatrix}

b_{11}c_{11} + b_{12}c_{21} & b_{11}c_{12} + b_{12}c_{22} \\

b_{21}c_{11} + b_{22}c_{21} & b_{21}c_{12} + b_{22}c_{22}

\end{pmatrix}

\\[5pt]

&=

\begin{pmatrix}

a_{11} & a_{12} \\

a_{21} & a_{22} \\

a_{31} & a_{32}

\end{pmatrix}

\left(

\begin{pmatrix}

b_{11} & b_{12} \\

b_{21} & b_{22}

\end{pmatrix}

\begin{pmatrix}

c_{11} & c_{12} \\

c_{21} & c_{22}

\end{pmatrix}

\right)

\\[5pt]

&=

A(BC).

\end{align*}

De manera muy similar, si $u$ es un vector de tamaño 2, podemos ver que se cumple que $A(Bu) = (AB)u$. ¿Puedes demostrarlo? Hazlo por lo menos para matrices $A$ y $B$ ambas de $2\times 2$.

Quizás tengas la impresión de que hay que hacer demasiadas cuentas y que sería sumamente difícil demostrar estas propiedades para matrices más grandes. Sin embargo, en cursos posteriores verás cómo trabajar apropiadamente con la notación para poder hacer estas demostraciones más fácilmente.

El producto de matrices es asociativo. Sin embargo, no es conmutativo. Por ejemplo, consideremos las matrices

\[

E=

\begin{pmatrix}

5 & 7 \\

-3 & 0

\end{pmatrix}

\qquad

\text{y}

\qquad

F=

\begin{pmatrix}

1 & 2 \\

9 & -1

\end{pmatrix}.

\]

Veamos que

\[

EF =

\begin{pmatrix}

68 & 3 \\

-3 & -6

\end{pmatrix}

\ne

\begin{pmatrix}

-1 & 7 \\

48 & 63

\end{pmatrix}

=

FE.

\]

En términos de combinar el producto de matrices con otras operaciones, tenemos que el producto de matrices por la izquierda se distribuye sobre la suma de matrices:

\begin{align*}

A(B+C)

&=

\begin{pmatrix}

a_{11} & a_{12} \\

a_{21} & a_{22} \\

a_{31} & a_{32}

\end{pmatrix}

\left(

\begin{pmatrix}

b_{11} & b_{12} \\

b_{21} & b_{22}

\end{pmatrix}

+

\begin{pmatrix}

c_{11} & c_{12} \\

c_{21} & c_{22}

\end{pmatrix}

\right)

\\[5pt]

&=

\begin{pmatrix}

a_{11} & a_{12} \\

a_{21} & a_{22} \\

a_{31} & a_{32}

\end{pmatrix}

\begin{pmatrix}

b_{11}+c_{11} & b_{12}+c_{12} \\

b_{21}+c_{21} & b_{22}+c_{22}

\end{pmatrix}

\\[5pt]

&=

\begin{pmatrix}

a_{11}(b_{11}+c_{11}) + a_{12}(b_{21}+c_{21})

& a_{11}(b_{12}+c_{21}) + a_{12}(b_{22}+c_{22}) \\

a_{21}(b_{11}+c_{11}) + a_{22}(b_{21}+c_{21})

& a_{21}(b_{12}+c_{21}) + a_{22}(b_{22}+c_{22}) \\

a_{31}(b_{11}+c_{11}) + a_{32}(b_{21}+c_{21})

& a_{31}(b_{12}+c_{21}) + a_{32}(b_{22}+c_{22}) \\

\end{pmatrix}

\\[5pt]

&=

\begin{pmatrix}

a_{11}b_{11}+a_{11}c_{11} + a_{12}b_{21}+a_{12}c_{21}

& a_{11}b_{12}+a_{11}c_{11} + a_{12}b_{22}+a_{12}c_{22} \\

a_{21}b_{11}+a_{21}c_{11}+ a_{22}b_{21}+a_{22}c_{21}

& a_{21}b_{12}+a_{21}c_{12}+ a_{22}b_{22}+a_{22}c_{22} \\

a_{31}b_{11}+a_{31}c_{11} + a_{32}b_{21}+a_{32}c_{21}

& a_{31}b_{12}+a_{31}c_{12} + a_{32}b_{22}+a_{32}c_{22}

\end{pmatrix}

\\[5pt]

&=

\begin{pmatrix}

a_{11}b_{11} + a_{12}b_{21} & a_{11}b_{12} + a_{12}b_{22} \\

a_{21}b_{11} + a_{22}b_{21} & a_{21}b_{12} + a_{22}b_{22} \\

a_{31}b_{11} + a_{32}b_{21} & a_{31}b_{12} + a_{32}b_{22}

\end{pmatrix}

+

\begin{pmatrix}

a_{11}c_{11} + a_{12}c_{21} & a_{11}c_{12} + a_{12}c_{22} \\

a_{21}c_{11} + a_{22}c_{21} & a_{21}c_{12} + a_{22}c_{22} \\

a_{31}c_{11} + a_{32}c_{21} & a_{31}c_{12} + a_{32}c_{22}

\end{pmatrix}

\\[5pt]

&=

\begin{pmatrix}

a_{11} & a_{12} \\

a_{21} & a_{22} \\

a_{31} & a_{32}

\end{pmatrix}

\begin{pmatrix}

b_{11} & b_{12} \\

b_{21} & b_{22}

\end{pmatrix}

+

\begin{pmatrix}

a_{11} & a_{12} \\

a_{21} & a_{22} \\

a_{31} & a_{32}

\end{pmatrix}

\begin{pmatrix}

c_{11} & c_{12} \\

c_{21} & c_{22}

\end{pmatrix}

\\[5pt]

&=

AB + AC.

\end{align*}

El producto también se distribuye sobre la suma cuando la suma aparece a la izquierda. ¿Podrías probar que si $D$ es una matriz de tamaño $3 \times 2$, entonces se cumple $(A+D)B = AB + DB$?

En entradas anteriores vimos que $\mathcal{I}_n$ tiene la propiedad de ser neutro al multiplicarla por un vector de tamaño $n$. Resulta que $\mathcal{I}_n$ también tiene esta propiedad al multiplicarla por la izquierda por una matriz de tamaño $n\times m$. Por ejemplo, veamos que al multiplicar $\mathcal{I}_3$ por la izquierda por $A$, obtenemos

\begin{align*}

\mathcal{I}_3 A

&=

\begin{pmatrix}

1 & 0 & 0 \\

0 & 1 & 0 \\

0 & 0 & 1

\end{pmatrix}

\begin{pmatrix}

a_{11} & a_{12} \\

a_{21} & a_{22} \\

a_{31} & a_{32}

\end{pmatrix}

\\[5pt]

&=

\begin{pmatrix}

1a_{11} + 0a_{21} + 0a_{31} & 1a_{12} + 0a_{22} + 0a_{32} \\

0a_{11} + 1a_{21} + 0a_{31} & 0a_{12} + 1a_{22} + 0a_{32} \\

0a_{11} + 0a_{21} + 1a_{31} & 0a_{12} + 0a_{22} + 1a_{32}

\end{pmatrix}

\\[5pt]

&=

\begin{pmatrix}

a_{11} & a_{12} \\

a_{21} & a_{22} \\

a_{31} & a_{32}

\end{pmatrix}

\\[5pt]

&=

A.

\end{align*}

¿Podrías probar que $A\mathcal{I}_2 = A$ (es decir, que $\mathcal{I}_2$ es neutro por la derecha para $A$)?

Habiendo visto que el producto de matrices es asociativo, conmutativo y tiene neutros, probablemente te estarás preguntando si existen inversos en la multiplicación de matrices. Este cuestionamiento lo dejaremos para la siguiente entrada.

Relación con la composición de transformaciones

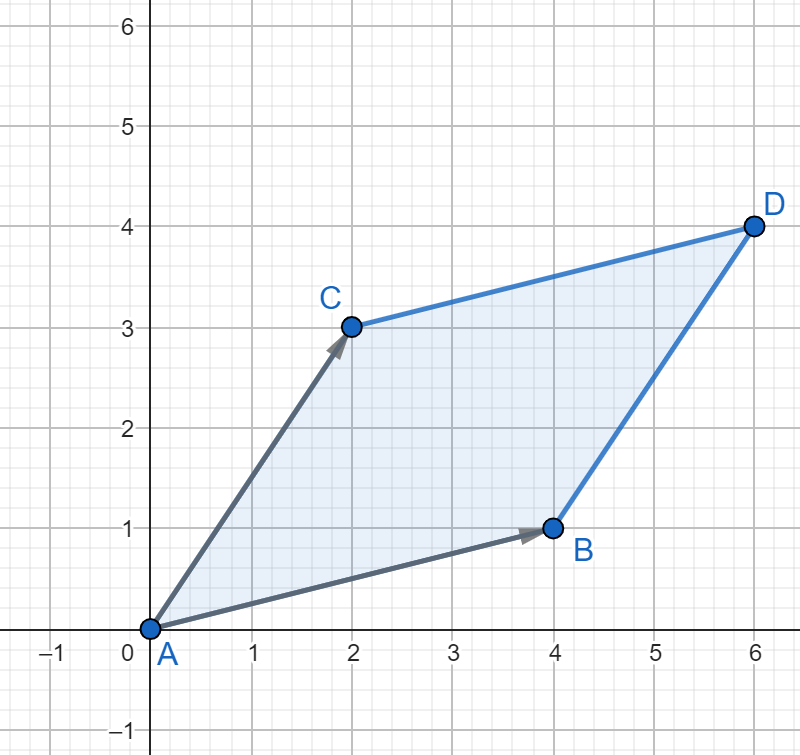

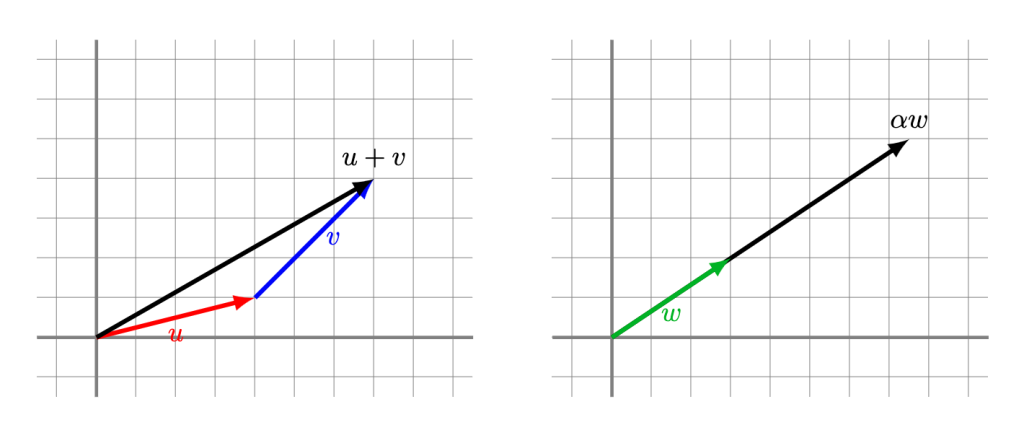

Como vimos en la entrada anterior, una forma de visualzar el producto de una matriz $A$ por un vector $u$ es como una transformación que envía el vector $u$ a un único vector $Au$.

Teniendo en mente esto, veamos que la propiedad de que $A(Bu) = (AB)u$ resulta aún más interesante. Para esto, veamos que el siguiente ejemplo: sean

\[

A

=

\begin{pmatrix}

0 & 2 \\

1 & 1

\end{pmatrix},

\qquad

B

=

\begin{pmatrix}

1 & 2 \\

3 & 0

\end{pmatrix},

\qquad

\text{y}

\qquad

u

=

\begin{pmatrix}

1 \\

2

\end{pmatrix}.

\]

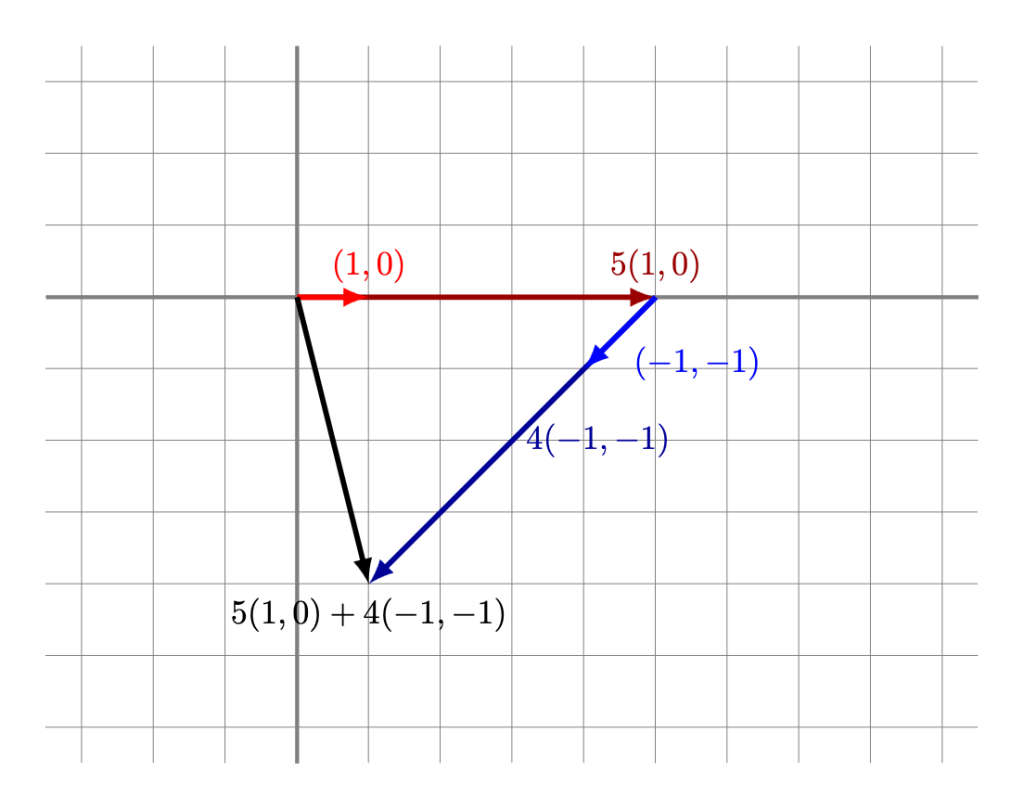

Si multiplicamos $B$ por $u$, vemos que corresponde a la transformación que envía $u = \begin{pmatrix} 1 \\ 2 \end{pmatrix}$ al vector $Bu = \begin{pmatrix} 5 \\ 3 \end{pmatrix}$.

Ahora, si multiplicamos $A$ por el vector $Bu$, vemos que corresponde a la transformación que envía $Bu$ al vector $A(Bu) = \begin{pmatrix} 6 \\ 8 \end{pmatrix}$ (Acabamos de obtener el resultado de aplicar a $u$ la composición de las transformaciones $B$ y $A$).

Por otra parte, si realizamos la multiplicación

\[

AB

=

\begin{pmatrix}

0 & 2 \\

1 & 1

\end{pmatrix}

\begin{pmatrix}

1 & 2 \\

3 & 0

\end{pmatrix}

=

\begin{pmatrix}

6 & 0 \\

4 & 2

\end{pmatrix},

\]

la transformación asociada a $AB$ envía $u$ al vector $(AB)u = \begin{pmatrix} 6 \\ 8 \end{pmatrix}$.

¡La composición de las transformaciones asociadas a $B$ y $A$ aplicada al vector $u$ coincide con la transformación asociada a la matriz $AB$ aplicada al mismo vector!

Si probamos esto para un vector arbitrario, nos daremos cuenta de que en todos los casos se cumple lo mismo. En realidad, esto no es una coincidencia: como aprenderás en tus cursos de álgebra lineal, la composición de transformaciones lineales está directamente asociada al producto de matrices.

Potencias de matrices

Podemos ver que si una matriz $A$ es cuadrada, al tener el mismo número de filas que de columnas, entonces podemos realizar la multiplicaciones $AA$, $AAA$, $AAAA$, etc., que por asociatividad no importa en qué orden multipliquemos. Esto nos sugiere que podemos cacular potencias de matrices.

Para una matriz cuadrada $A$, definiremos de manera recursiva la potencia $A^n$:

- Definimos $A^0 = \mathcal{I}$.

- Dada $A^n$, con $n$ un número natural, definimos $A^{n+1} = A^n A$.

Por ejemplo, si

\[

A

=

\begin{pmatrix}

2 & 1 \\

3 & 4

\end{pmatrix},

\]

calculemos $A^3$ empleando la definición recursiva. Para esto, iremos calculando una por una las potencias de $A$, hasta llegar a $A^3$:

\begin{align*}

A^0

&=

\mathcal{I}

=

\begin{pmatrix}

1 & 0 \\

0 & 1

\end{pmatrix},

\\[5pt]

A^1

&=

A^0A

=

\begin{pmatrix}

1 & 0 \\

0 & 1

\end{pmatrix}

\begin{pmatrix}

2 & 1 \\

3 & 4

\end{pmatrix}

=

\begin{pmatrix}

2 & 1 \\

3 & 4

\end{pmatrix},

\\[5pt]

A^2

&=

A^1 A

=

\begin{pmatrix}

2 & 1 \\

3 & 4

\end{pmatrix}

\begin{pmatrix}

2 & 1 \\

3 & 4

\end{pmatrix}

=

\begin{pmatrix}

(2)(2) + (1)(3) & (2)(1) + (1)(4) \\

(3)(2) + (4)(3) & (3)(1) + (4)(4)

\end{pmatrix}

=

\begin{pmatrix}

7 & 6 \\

18 & 19

\end{pmatrix},

\\[5pt]

A^3

&=

A^2A

=

\begin{pmatrix}

7 & 6 \\

18 & 19

\end{pmatrix}

\begin{pmatrix}

2 & 1 \\

3 & 4

\end{pmatrix}

=

\begin{pmatrix}

(7)(2) + (6)(3) & (7)(1) + (6)(4) \\

(18)(2) + (19)(3) & (18)(1) + (19)(4)

\end{pmatrix}

=

\begin{pmatrix}

32 & 31 \\

93 & 94

\end{pmatrix}.

\end{align*}

Prueba calcular algunas potencias de la matriz \(

\begin{pmatrix}

2 & 0 \\

0 & 3

\end{pmatrix}.

\) ¿Notas algún patrón especial?

Más adelante…

En esta entrada aprendimos sobre el producto de matrices con matrices y conocimos algunas de sus propiedades. En la siguiente entrada abordaremos la pregunta sobre si existen los inversos en la multiplicación de matrices.

Tarea moral

- Realiza el producto de matrices $$\begin{pmatrix} -1 & -2 & -3 \\ 0 & 1 & 2 \\ 1 & -1 & 3 \end{pmatrix}\begin{pmatrix} 1 & -1 & 1 \\ -1 & 1 & -1 \\ 1 & -1 & 1 \end{pmatrix}.$$

- Considera la matriz $A=\begin{pmatrix} 3 & -4 \\ 4 & -5 \end{pmatrix}$. Realiza las siguientes operaciones por separado, sin usar la asociatividad del producto de matrices. ¿Cuál de las dos operaciones te resultó más fácil de hacer?

- $$A\left(A\left(A\left(A\begin{pmatrix} 2 \\ 3 \end{pmatrix}\right)\right)\right).$$

- $$(((AA)A)A)\begin{pmatrix} 2 \\ 3 \end{pmatrix}.$$

- Completa las pruebas faltantes de las propiedades de la multiplicación de matrices.

- Demuestra la siguiente ley de exponentes para matrices: $A^mA^n=A^{m+n}$.

- Prueba que si

\[

A =

\begin{pmatrix}

a_{11} & 0 \\

0 & a_{22}

\end{pmatrix},

\]

y $k$ es un entero mayor o igual que $0$, entonces

\[

A^k

=

\begin{pmatrix}

{a_{11}}^k & 0 \\

0 & {a_{22}}^k

\end{pmatrix}

\]

(Sugerencia: realizarlo por inducción sobre $k$, utilizando la definición recursiva). - Encuentra matrices $A$ y $B$ de $2\times 2$ para las cuales $A^2-B^2\neq (A+B)(A-B)$.

Entradas relacionadas

- Ir a Álgebra Superior I

- Entrada anterior del curso: Producto de matrices con vectores

- Entrada siguiente del curso: Matrices invertibles