Introducción

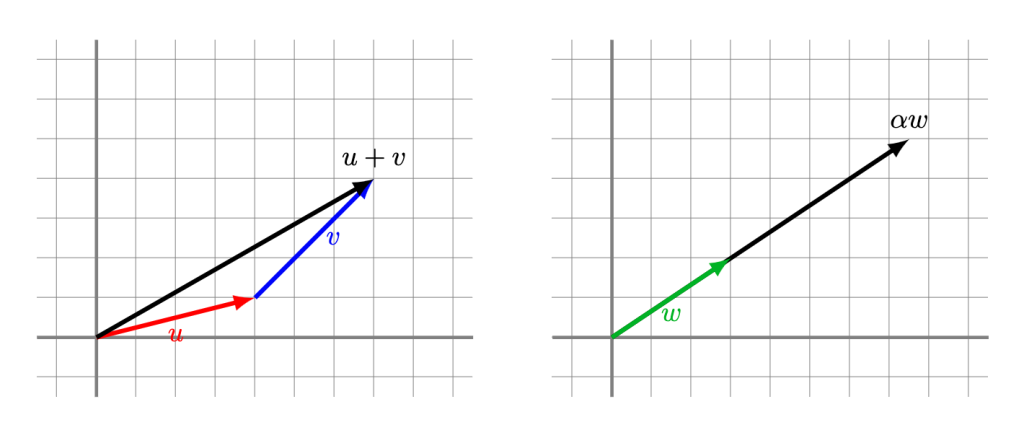

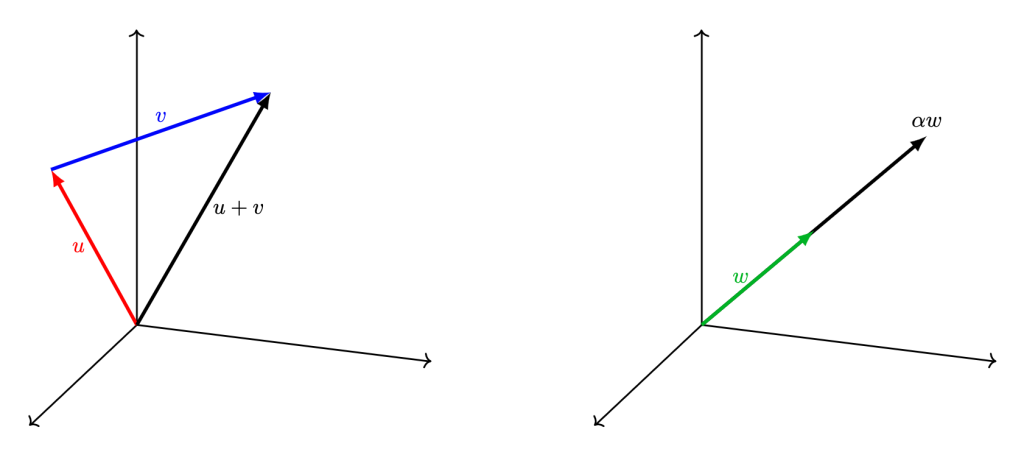

En la entrada anterior introdujimos conceptos relacionados a los espacios vectoriales $\mathbb{R}^2$ y $\mathbb{R}^3$. Hablamos de vectores, combinaciones lineales, espacio generado, independencia lineal y bases. Ahora haremos lo análogo en dimensiones más altas, para lo cual hablaremos de $\mathbb{R}^n$.

La idea es sencilla, queremos extender lo que ya hicimos para vectores con $5$ o $100$ entradas. Sin embargo, visualizar estos espacios y entender su geometría ya no será tan sencillo. Es por esta razón que principalmente nos enfocaremos a generalizar las propiedades algebraicas que hemos discutido. Esta resultará una manera muy poderosa de estudiar los espacios vectoriales, pues nos permitirá generalizar sin mucha dificultad los conceptos aprendidos en la entrada anterior al espacio $\mathbb{R}^n$ para cualquier número natural $n$.

Definición del espacio vectorial $\mathbb{R}^n$

En la entrada anterior vimos cuáles son propiedades que debe cumplir una colección de objetos, en conjunto con una operación de suma y otra de producto escalar, para poder considerarse un espacio vectorial. Como ya vimos, tanto $\mathbb{R}^2$ y $\mathbb{R}^3$ son espacios vectoriales. Podemos definir a $\mathbb{R}^n$ y a sus operaciones como sigue.

Definición. El conjunto $\mathbb{R}^n$ consiste de todas las $n$-adas ordenadas $u=(u_1,u_2,\ldots,u_n)$ en donde cada $u_i$ es un número real, para $i=1,\ldots,n$. A $u_i$ le llamamos la $i$-ésima entrada de $u$. Para dos elementos de $\mathbb{R}^n$, digamos

\begin{align*}

u&=(u_1,u_2,\ldots,u_n)\\

v&=(v_1,v_2,\ldots,v_n),

\end{align*}

definimos la suma $u+v$ como la $n$-áda cuya $i$-ésima entrada es $u_i+v_i$ (decimos que sumamos entrada a entrada). En símbolos, $$u+v=(u_1+v_1,u_2+v_2,\ldots,u_n+v_n).$$

Además, si tomamos un real $r$, definimos el producto escalar de $r$ con $u$ como la $n$-ada cuya $i$-ésima entrada es $r u_i$, es decir, $ru=(ru_1,ru_2,\ldots,ru_n).$

El conjunto $\mathbb{R}^n$ con esta suma y producto escalar cumple ser un espacio vectorial. A continuación probaremos sólo algunas de las propiedades, ¿puedes completar el resto?

1. La suma es asociativa:

\begin{align*}

(u+v)+w

&= ((u_1,u_2,\ldots,u_n) + (v_1,v_2,\ldots,v_n)) + (w_1,w_2,\ldots,w_n) \\

&= (u_1+v_1,u_2+v_2,\ldots,u_n+v_n) + (w_1,w_2,\ldots,w_n) \\

&= ((u_1+v_1)+w_1,(u_2+v_2)+w_2,\ldots,(u_n+v_n)+w_n) \\

&= (u_1+(v_1+w_1),u_2+(v_2+w_2),\ldots,u_n+(v_n+w_n)) \\

&= (u_1,u_2,\ldots,u_n) + (v_1+w_1,v_2+w_2,\ldots,v_n+w_n) \\

&= (u_1,u_2,\ldots,u_n) + ((v_1,v_2,\ldots,v_n) + (w_1,w_2,\ldots,w_n)) \\

&= u + (v+w).

\end{align*}

La cuarta igualdad usa el paso clave de que en $\mathbb{R}$ sí sabemos que la suma es asociativa.

2. La suma es conmutativa:

\[

u+v = v+w.

\]

¡Intenta demostrarlo!

3. Existe un elemento neutro para la suma, que es el elemento de $\mathbb{R}^n$ en donde todas las entradas son iguales al neutro aditivo $0$ de $\mathbb{R}$:

\begin{align*}

u+0

&= (u_1,u_2,\ldots,u_n) + (0,0,\ldots,0) \\

&= (u_1+0,u_2+0,\ldots,u_n+0) \\

&= (u_1,u_2,\ldots,u_n) \\

&= u.

\end{align*}

Para demostrar esta propiedad, necesitaras usar que en $\mathbb{R}$ cada $u_i$ tiene inverso aditivo.

4. Para cada $n$-tupla existe un elemento inverso:

\[

u + (-u) = 0.

\]

5. La suma escalar se distribuye bajo el producto escalar:

\begin{align*}

(r+s)u

&= (r+s)(u_1,u_2,\ldots,u_n) \\

&= ((r+s)u_1,(r+s)u_2,\ldots,(r+s)u_n) \\

&= (ru_1 + su_1, ru_2 + su_2, \ldots, r_n + su_n) \\

&= (ru_1,ru_2,\ldots,ru_n) + (su_1,su_2,\ldots,su_n) \\

&= r(u_1,u_2,\ldots,u_n) + s(u_1,u_2,\ldots,u_n) \\

&= ru + su.

\end{align*}

Una vez más, se está usando una propiedad de $\mathbb{R}$ para concluir una propiedad análoga en $\mathbb{R}^n$. En este caso, se está usando fuertemente que hay una propiedad de distributividad en $\mathbb{R}$.

6. La suma de $n$-tuplas de distribuye bajo el producto de escalares:

\[

r(u+v) = ru + rv.

\]

7. El producto escalar es compatible con el producto de $\mathbb{R}$:

\begin{align*}

(rs)u

&= (rs)(u_1,u_2,\ldots,u_n) \\

&= ((rs)u_1,(rs)u_2,\ldots,(rs)u_n) \\

&= (r(su_1),r(su_2),\ldots,r(su_n)) \\

&= r(su_1, su_2, \ldots, su_n) \\

&= r(s(u_1,u_2,\ldots,u_n)) \\

&= r(su).

\end{align*}

8. El neutro multiplicativo $1$ de $\mathbb{R}$ funciona como neutro para el producto escalar:

\[

1u = u.

\]

De este modo, podemos trabajar con el espacio vectorial $\mathbb{R}^n$ para explorar sus propiedades. La gran ventaja es que lo que demostremos para $\mathbb{R}^n$ en general lo podremos usar para cualquier valor particular de $n$. y poder emplearlas cuando trabajemos con algún número $n$ en particular.

Combinaciones lineales y espacio generado

Al igual que hicimos con $\mathbb{R}^2$ y $\mathbb{R}^3$ podemos definir los conceptos de combinación lineal y espacio generado para el espacio vectorial $\mathbb{R}^n$.

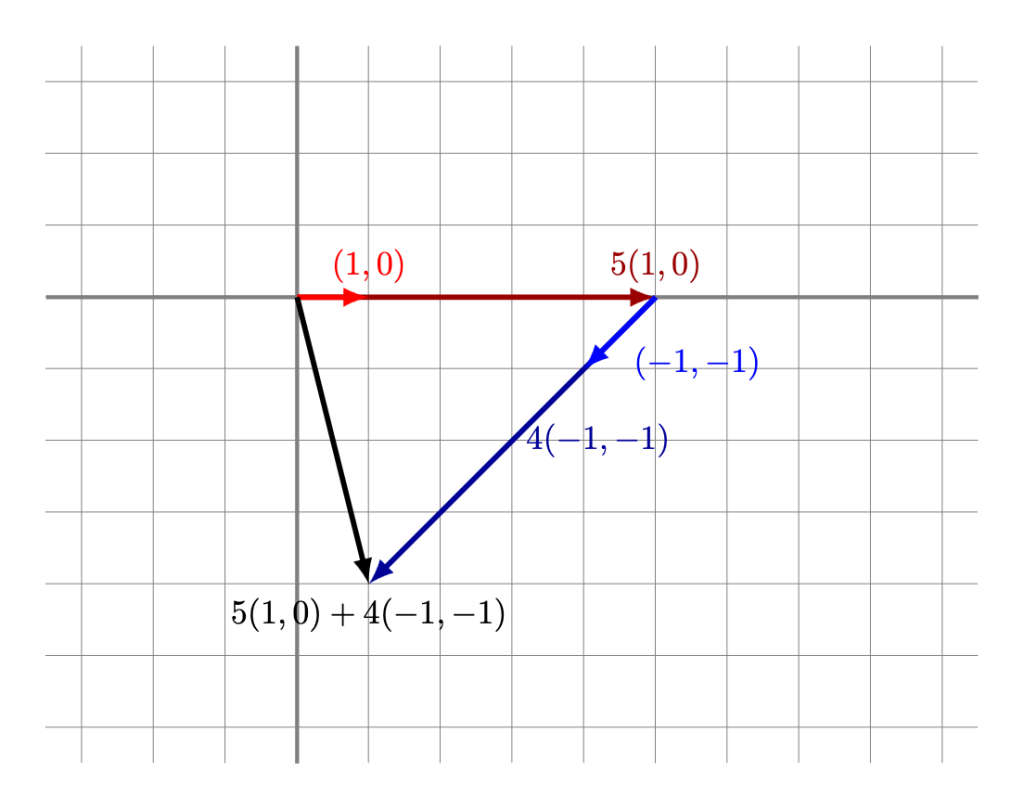

Definición. En $\mathbb{R}^n$, diremos que un vector $u$ es combinación lineal de los vectores $v_1,\ldots,v_k$ si y sólo si existen números reales $r_1,\ldots,r_n$ en $\mathbb{R}$ tales que

\[

u = r_1v_1 + r_2v_2 + \cdots + r_kv_k.

\]

Ejemplo. En $\mathbb{R}^5$, el vector $(3,4,-2,5,5)$ es combinación lineal de los vectores $(2,1,2,0,3)$, $(0,1,-1,3,0)$ y $(1,-1,5,-2,1)$, pues

\[

(3,4,-2,5,5) = 2(2,1,2,0,3) + 1(0,1,-1,3,0) + -1(1,-1,5,-2,1).

\]

$\triangle$

La noción de combinación lineal nos permite hablar de todas las posibles combinaciones lineales, así como en $\mathbb{R}^2$ y $\mathbb{R}^3$.

Definición. Dado un conjunto de vectores $v_1,\ldots,v_n$ en $\mathbb{R}^n$, podemos definir el espacio generado por estos vectores como el conjunto de todas las posibles combinaciones lineales de $v_1,\ldots,v_n$ en $\mathbb{R}^n$.

Es este caso, ya no podremos visualizar geométricamente el espacio generado (aunque con un poco de imaginación, quizás puedas generalizar lo que ya hicimos en dimensiones anteriores: ¿cómo se vería un plano en $\mathbb{R}^4$?, ¿cómo se vería un sub-$\mathbb{R}^3$ de $\mathbb{R}^4$?). De cualquier manera, sí podemos seguir respondiendo preguntas del espacio generado a través de sistemas de ecuaciones.

Ejemplo. ¿El espacio generado por los vectores $(1,1,1,0)$, $(0,3,1,2)$, $(2,3,1,0)$ y $(1,0,2,1)$ es $\mathbb{R}^4$?

Para ver si $\mathbb{R}^4$ es el espacio generado por los vectores propuestos, debemos asegurarnos de que cada vector en $\mathbb{R}^4$ se pueda expresar como combinación lineal de estos. Entonces, seleccionamos un vector $(a,b,c,d)$ arbitrario en $\mathbb{R}^4$, y debemos ver si existen escalares $q$, $r$, $s$ y $t$ tales que

\[

q(1,1,1,0) + r(0,3,1,2) + s(2,3,1,0) + t(1,0,2,1) = (a,b,c,d);

\]

esto es,

\[

(q,q,q,0) + (0,3r,r,2r) + (2s,3s,s,0) + (t,0,2t,t) = (a,b,c,d),

\]

que equivale a

\[

(q+2s+t, q+3r+3s, q+r+s+2t, 2r+t)=(a,b,c,d),

\]

lo cual a su vez equivale al sistema de ecuaciones

\[

\left\{

\begin{alignedat}{4}

q & +{} & & +{} & 2s & +{} & t & = a \\

q & +{} & 3r & +{} & 3s & & & = b \\

q & +{} & r & +{} & s & +{} & 2t & = c \\

& & 2r & & & +{} & t & = d,

\end{alignedat}

\right.

\]

el cual podemos representar como

\[

\begin{pmatrix}

1 & 0 & 2 & 1 \\

1 & 3 & 3 & 0 \\

1 & 1 & 1 & 2 \\

0 & 2 & 0 & 1

\end{pmatrix}

\begin{pmatrix}

q \\ r \\ s \\ t

\end{pmatrix}

=

\begin{pmatrix}

a \\ b \\ c \\ d

\end{pmatrix}.

\]

Además, podemos observar que la matriz en el lado izquierdo tiene determinante distinto de $0$ (para verificar esto, tendrás que calcularlo), lo que nos indica que es invertible, y la igualdad anterior equivale a

\[

\begin{pmatrix}

q \\ r \\ s \\ t

\end{pmatrix}

=

\begin{pmatrix}

1 & 0 & 2 & 1 \\

1 & 3 & 3 & 0 \\

1 & 1 & 1 & 2 \\

0 & 2 & 0 & 1

\end{pmatrix}^{-1}

\begin{pmatrix}

a \\ b \\ c \\ d

\end{pmatrix},

\]

o bien,

\[

\begin{pmatrix}

q \\ r \\ s \\ t

\end{pmatrix}

=

\begin{pmatrix}

-3 & 1 & 3 & -3 \\

-1/2 & 1/4 & 1/4 & 0 \\

3/2 & -1/4 & -5/4 & 1 \\

1 & -1/2 & -1/2 & 1

\end{pmatrix}

\begin{pmatrix}

a \\ b \\ c \\ d

\end{pmatrix},

\]

de donde tenemos la solución para $q,r,s,t$ siguiente:

\[

\left\{

\begin{alignedat}{4}

q & = & -3a & +{} & b & +{} & 3c & -{} & 3d \\

r & = & -\tfrac{1}{2}a & +{} & \tfrac{1}{4}b & +{} & \tfrac{1}{4}c & & \\

s & = & \tfrac{3}{2}a & -{} & \tfrac{1}{4}b & -{} & \tfrac{5}{4}c & +{} & d \\

t & = & a & -{} & \tfrac{1}{2}b & -{} & \tfrac{1}{2}c & +{} & d.

\end{alignedat}

\right.

\]

Este sistema nos da una fórmula para los escalares $q$, $r$, $s$ y $t$ en función del valor de las entradas del vector $(a,b,c,d)$, y estos escalares satisfacen

\[

q(1,1,1,0) + r(0,3,1,2) + s(2,3,1,0) + t(1,0,2,1) = (a,b,c,d).

\]

Como esto se cumple para un vector arbitrario $(a,b,c,d)$ en $\mathbb{R}^4$, entonces se cumple para todos los vectores de $\mathbb{R}^4$; es decir, ¡$\mathbb{R}^4$ es el espacio generado por los vectores $(1,1,1,0)$, $(0,3,1,2)$, $(2,3,1,0)$, $(1,0,2,1)$!

$\triangle$

Nuestra técnica de resolver sistemas de ecuaciones mediante la inversa de la matriz asociada ha resultado muy útil. Hemos tenido un poco de suerte en que la matriz sea invertible. Si no lo fuera, no podríamos haber hecho el procedimiento descrito en el ejemplo. ¿Será que si la matriz no es invertible, entonces el sistema no se podrá resolver? La respuesta es compleja: a veces sí, a veces no. En ese caso hay que entender el sistema de ecuaciones con otro método, como reducción gaussiana.

Independencia lineal

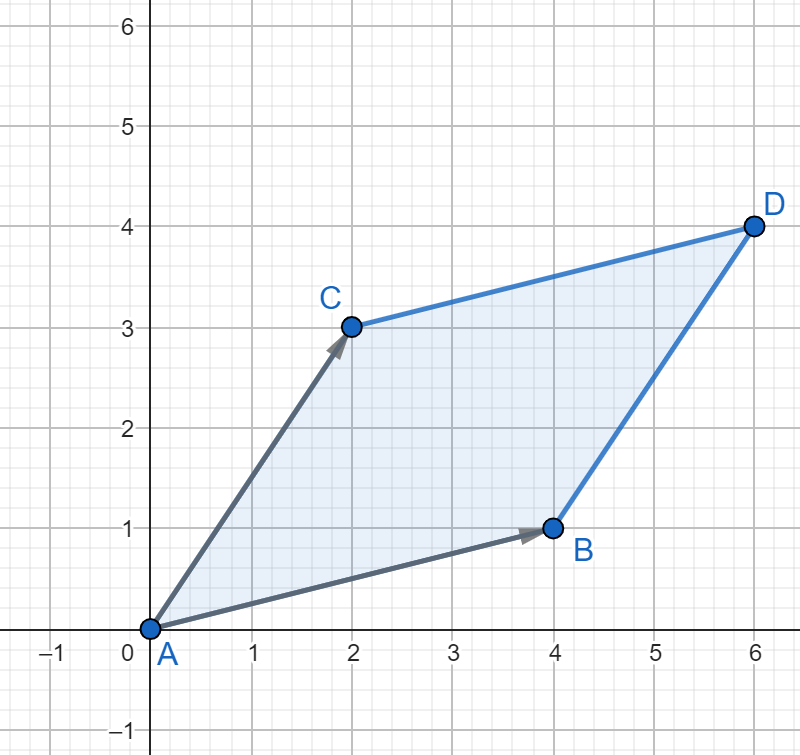

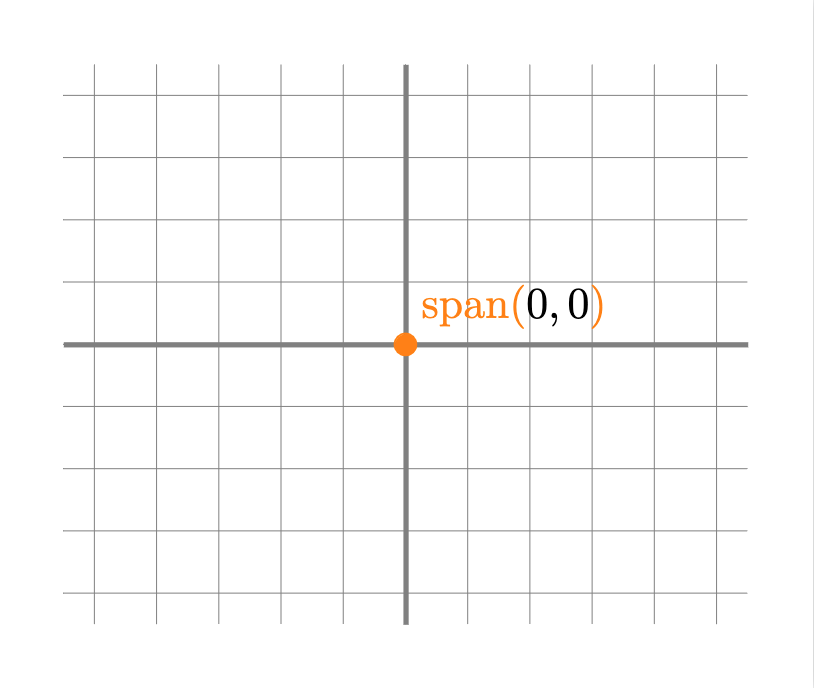

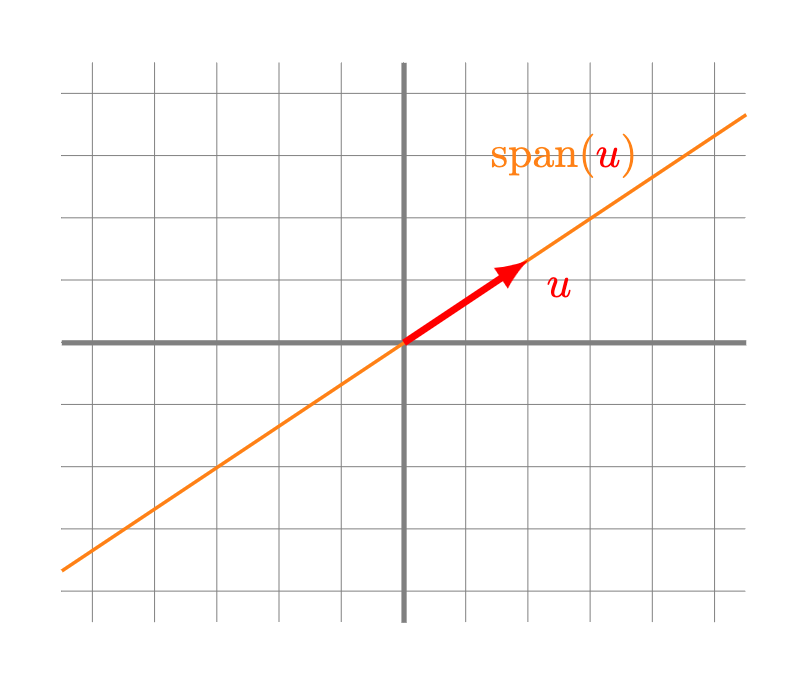

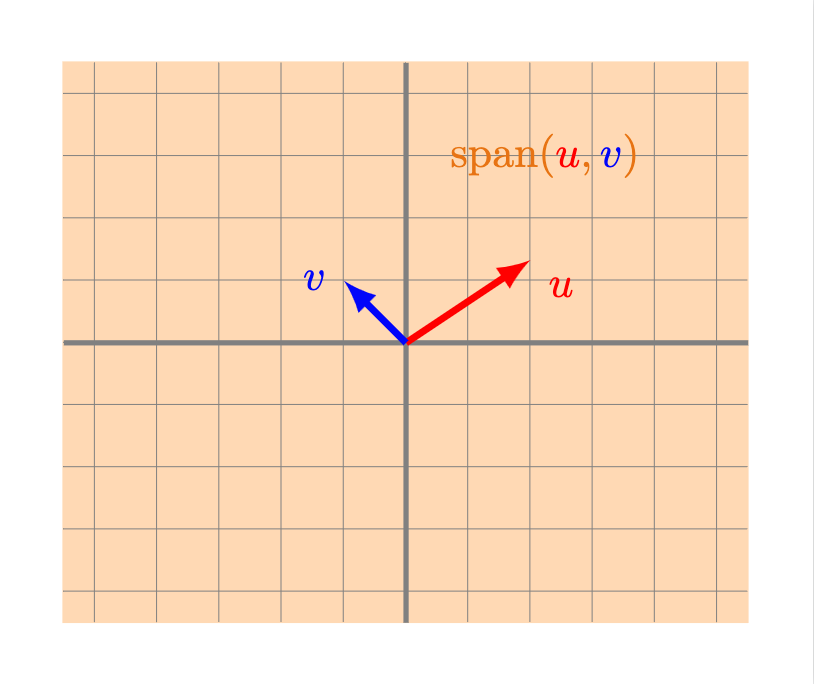

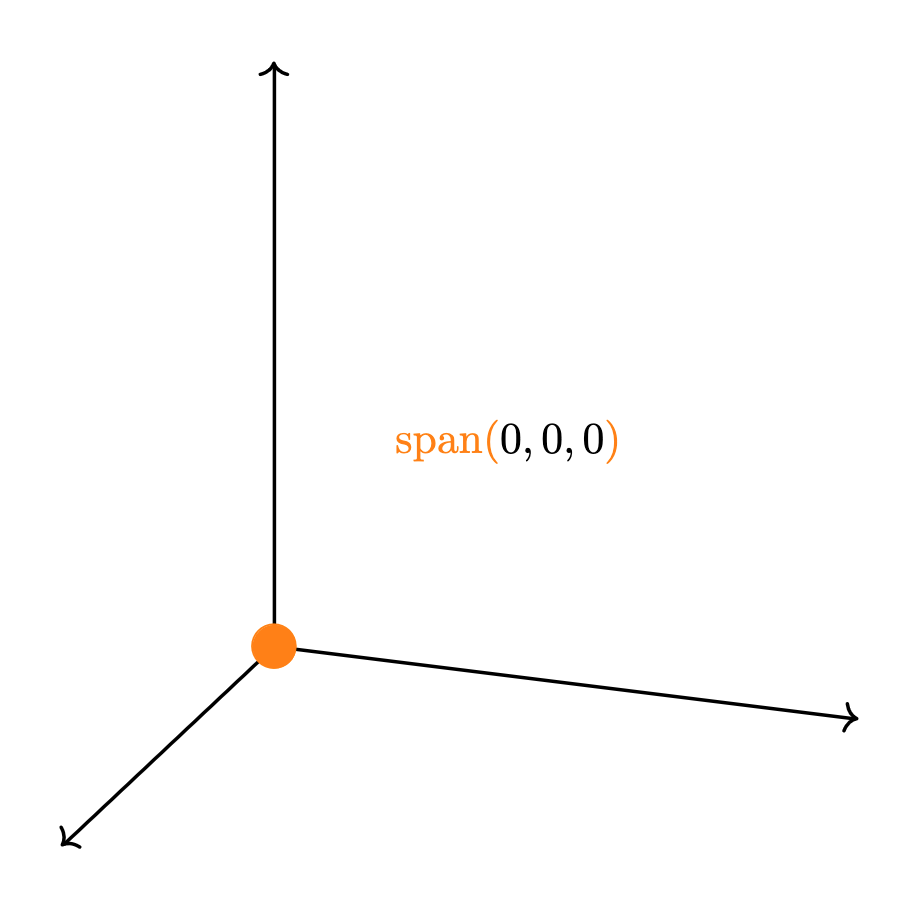

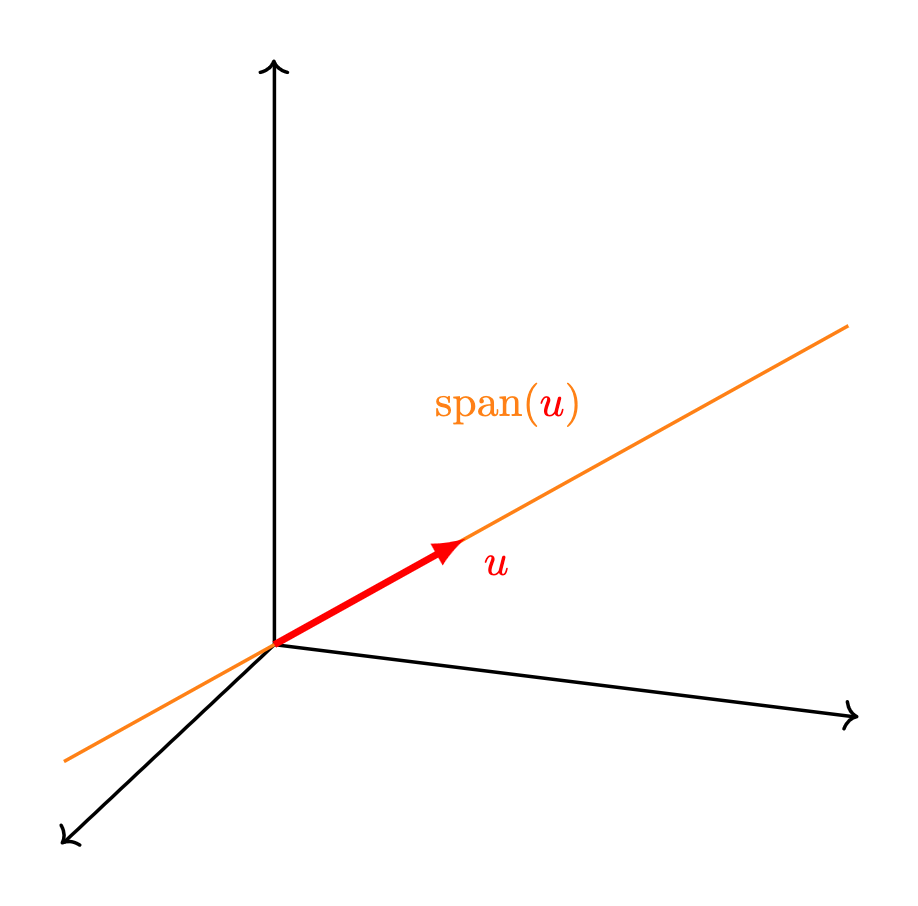

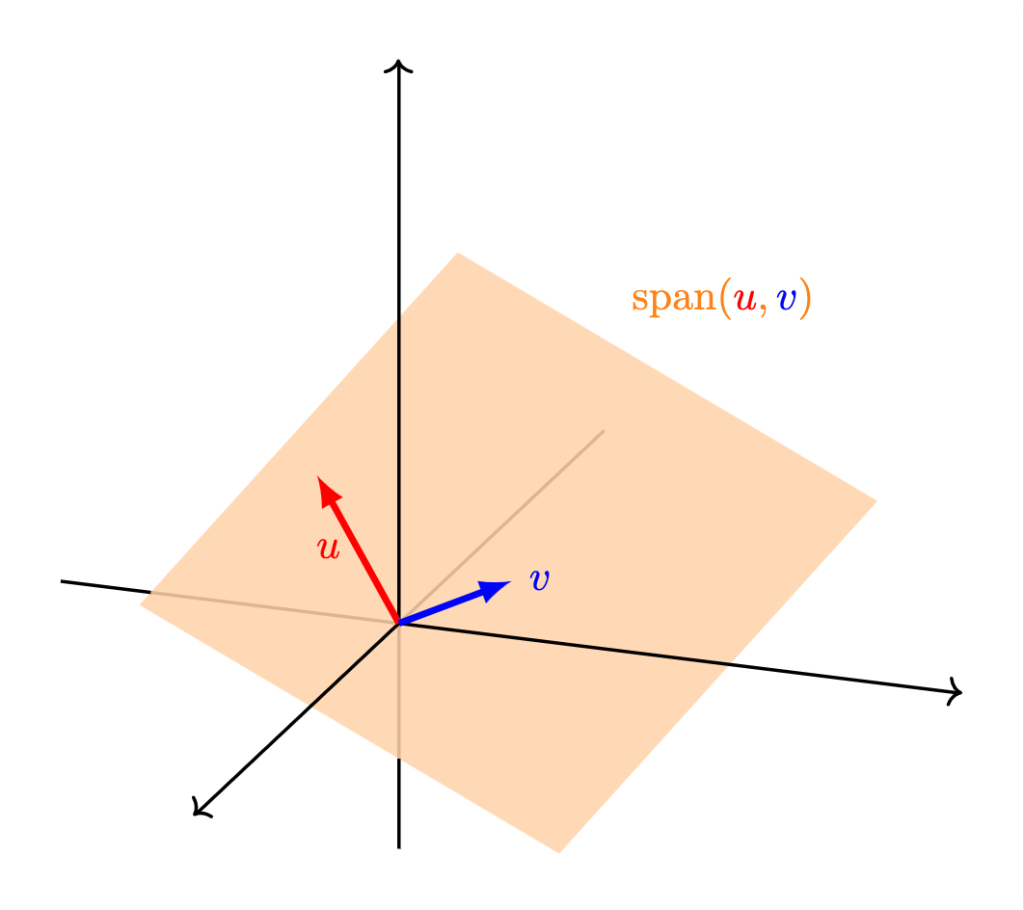

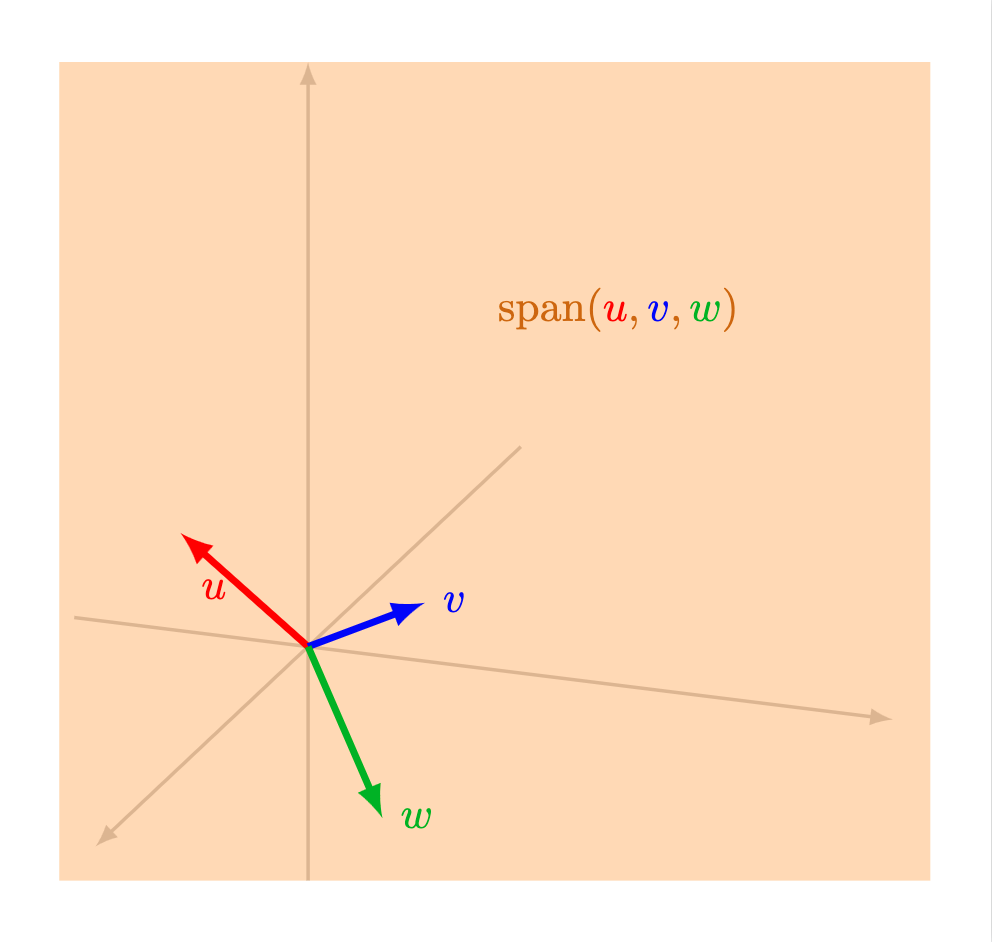

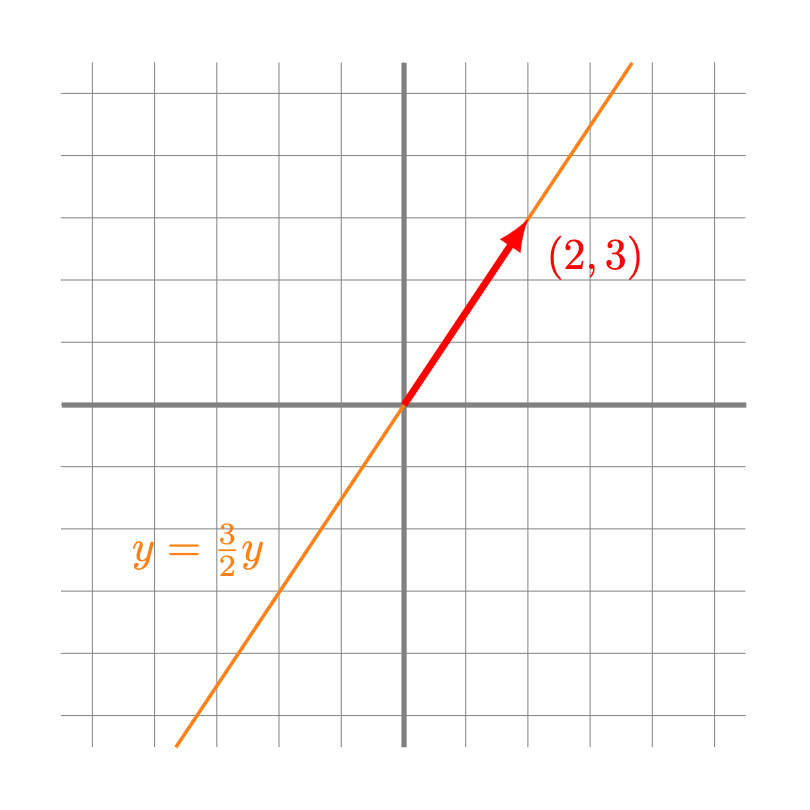

Cuando exploramos las propiedades de $\mathbb{R}^2$ y $\mathbb{R}^3$, observamos que hay ocasiones en las que el espacio generado por un conjunto de vectores es «más chico» de lo que se esperaría de la cantidad de vectores: por ejemplo, dos vectores en $\mathbb{R}^2$ generan una línea (y no todo $\mathbb{R}^2$) cuando estos dos se encuentran alineados con el origen. Cuando tres vectores en $\mathbb{R}^3$ no están alineados, pero se encuentran sobre el mismo plano por el origen, su espacio generado es dicho plano (y no todo $\mathbb{R}^3$).

Aunque el el espacio vectorial $\mathbb{R}^n$ no podamos visualizarlo de manera inmediata, podemos mantener la intuición de que un conjunto de vectores «genera todo lo que puede generar» o «genera algo más chico». Para identificar en qué situación nos encontramos, recurrimos a la siguiente definición.

Definición. Dado un conjunto de $k$ vectores $v_1, v_2, \ldots, v_k$ en $\mathbb{R}^n$ distintos de 0, diremos son linealmente independientes si la única forma de escribir al vector 0 como combinación lineal de ellos es cuando todos los coeficientes de la combinación lineal son igual al escalar 0; es decir, si tenemos que

\[

r_1v_1 + r_2v_2 + \cdots + r_kv_k = 0,

\]

entonces forzosamente $r_1 = r_2 = \cdots = r_n = 0$.

Teniendo esta definición en consideración, se puede mostrar que si un conjunto de vectores es linealmente independiente, entonces ninguno de los vectores se puede escribir como combinación lineal de los otros. De hecho, es únicamente en este caso cuando cuando el espacio generado por los vectores es «todo lo que se puede generar».

La justificación de por qué sucede esto es similar a la que vimos en la entrada anterior: como el primer vector es no genera una línea. Como el segundo vector no se puede escribir como combinación lineal del primero, entonces queda fuera de esta línea y ambos generan un plano. Como el tercer vector no se puede escribir como combinación lineal de los primeros dos, entonces queda fuera del plano, y entre los tres generan un espacio «más grande» («de dimensión $3$»). A partir de este punto, quizá no podamos visualizar inmediatamente la forma geométrica del espacio generado, pero como sabemos que los vectores son linealmente independientes, entonces el cuarto vector no se puede escribir como combinación lineal de los primeros tres. Por ello, queda fuera del espacio generado por los primeros tres, y el espacio generado por los cuatro es aún «más grande» («de dimensión $4$»); y así sucesivamente, para tantos vectores linealmente independientes como tengamos.

Una herramienta que podemos emplear para determinar cuándo un conjunto de vectores es linealmente independiente son nuevamente los sistemas de ecuaciones. Para esto veamos el siguiente ejemplo.

Ejemplo. ¿Son los vectores $(1,5,1,-2)$, $(3,-3,0,-1)$, $(-2,0,4,1)$ y $(0,1,-1,0)$ linealmente independientes en $\mathbb{R}^4$?

Supongamos que para ciertos escalares $a$, $b$, $c$ y $d$, se cumple que

\[

a(1,5,1,-2) + b(3,-3,0,-1) + c(-2,0,4,1) + d(0,1,-1,0) = (0,0,0,0).

\]

Esto es equivalente a decir que

\[

(a,5a,a,-2a) + (3b,-3b,0,-b) + (-2c,0,4c,c) + (0,d,-d,0) = (0,0,0,0)

\]

que equivale a

\[

(a+3b-2c, 5a-3b+d,a+4c-d,-2a-b+c) = (0,0,0,0),

\]

y a su vez equivale al sistema de ecuaciones

\[

\left\{

\begin{alignedat}{4}

a & +{} & 3b & -{} & 2c & & & = 0 \\

5a & -{} & 3b & & & +{} & d & = 0 \\

a & & & +{} & 4c & -{} & d & = 0 \\

-2a & -{} & b & +{} & c & & & = 0

\end{alignedat}

\right.

\]

el cual podemos representar de la forma

\[

\begin{pmatrix}

1 & 3 & -2 & 0 \\

5 & -3 & 0 & 1 \\

1 & 0 & 4 & -1 \\

-2 & 1 & 1 & 0

\end{pmatrix}

\begin{pmatrix}

a \\ b \\ c \\ d

\end{pmatrix}

=

\begin{pmatrix}

0 \\ 0 \\ 0 \\ 0

\end{pmatrix},

\]

y, como notamos que la matriz del lado izquierdo de la ecuación tiene determinante distinto de 0 (¿puedes verificarlo?), entonces es invertible, de modo que

\[

\begin{pmatrix}

a \\ b \\ c \\ d

\end{pmatrix}

=

\begin{pmatrix}

1 & 3 & -2 & 0 \\

5 & -3 & 0 & 1 \\

1 & 0 & 4 & -1 \\

-2 & 1 & 1 & 0

\end{pmatrix}^{-1}

\begin{pmatrix}

0 \\ 0 \\ 0 \\ 0

\end{pmatrix}

=

\begin{pmatrix}

0 \\ 0 \\ 0 \\ 0

\end{pmatrix},

\]

es decir,

\[

a = b = c = d = 0,

\]

lo que nos indica, basándonos en la definición, que los vectores anteriores son linealmente independientes.

$\triangle$

El ejemplo anterior nos da una idea de lo que debe cumplir un conjunto linealmente independiente de $n$ vectores en $\mathbb{R}^n$. En general, podemos mostrar que un conjunto de $n$ vectores $v_1 = (v_{11}, v_{12}, \ldots, v_{1n})$, $v_2 = (v_{21}, v_{22}, \ldots, v_{2n})$, $\ldots$, $v_n = (v_{n1}, v_{n2}, \ldots, v_{nn})$ es linealmente independiente si y sólo si la matriz

\[

\begin{pmatrix}

v_{11} & v_{21} & \cdots & v_{n1} \\

v_{12} & v_{22} & \cdots & v_{n2} \\

\vdots & \vdots & \ddots & \vdots \\

v_{1n} & v_{2n} & \cdots & v_{nn}

\end{pmatrix},

\]

formada por los vectores escritos como columna, es invertible. Esto ya platicamos que está relacionado con que su determinante sea distinto de 0. Pero no en todas las situaciones tendremos tantos vectores como entradas y entonces tendremos que estudiar el sistema de ecuaciones lineales con otras técnicas, como reducción gaussiana.

Ejemplo. ¿Serán los vectores $(1,2,3,4,5)$, $(6,7,8,9,10)$ y $(11,12,13,14,15)$ de $\mathbb{R}^5$ linealmente independientes? Tal y como lo hemos hecho arriba, podemos preguntarnos si hay reales $a,b,c$ tales que $$a(1,2,3,4,5)+b(6,7,8,9,10)+c(11,12,13,14,15)=(0,0,0,0,0),$$ y que no sean todos ellos cero. Tras plantear el sistema como sistema de ecuaciones y luego en forma matricial, lo que se busca es ver si el sistema $\begin{pmatrix} 1 & 6 & 11 \\ 2 & 7 & 12 \\ 3 & 8 & 13 \\ 4 & 9 & 14 \\ 5 & 10 & 15 \end{pmatrix} \begin{pmatrix} a \\ b \\ c \end{pmatrix}=\begin{pmatrix} 0 \\ 0 \\ 0 \\ 0 \\ 0 \end{pmatrix} $ tiene alguna solución no trivial. Esto puede entenderse aplicando reducción gaussiana a $A$, que muestra que toda solución al sistema anterior es solución al sistema $\begin{pmatrix} 1 & 0 & -1\\0 & 1 & 2\\0 & 0 & 0\\0 & 0 & 0\\0 & 0 & 0\end{pmatrix} \begin{pmatrix} a \\ b \\ c \end{pmatrix}=\begin{pmatrix} 0 \\ 0 \\ 0 \\ 0 \\ 0 \end{pmatrix},$ lo cual nos lleva a que el sistema original es equivalente al sistema $$\left\{ \begin{array} \,a – c &= 0\\ b + 2c &= 0\end{array}.\right.$$

De aquí, podemos tomar a $c$ como cualquier valor, digamos $1$, de donde $a=1$ y $b=-2$ es solución. En resumen, hemos detectado que $$(1,2,3,4,5)-2(6,7,8,9,10)+(11,12,13,14,15)=(0,0,0,0,0),$$ que es una combinación lineal de los vectores donde no todos los coeficientes son cero. Por ello, no son linealmente intependientes.

Puedes intentar «imaginar» esto como que son vectores en $\mathbb{R}^5$ (un espacio de «dimensión $5$»), pero no generan dentro de él algo de dimensión $3$, sino algo de dimensión menor. Como $(1,2,3,4,5)$ y $(6,7,8,9,10)$ sí son linealmente independientes (¡demuéstralo!), entonces los tres vectores en realidad generan sólo un plano mediante sus combinaciones lineales.

$\square$

Bases

De manera similar a lo que observamos en la entrada anterior, hay ocasiones en las que un conjunto de vectores no tiene como espacio generado a todo $\mathbb{R}^n$. Por otra parte, hay ocasiones en las que el conjunto de vectores sí genera a todo $\mathbb{R}^n$, pero lo hace de manera «redundante», en el sentido de que, aunque su espacio generado sí es todo $\mathbb{R}^n$, podríamos quitar a algún vector del conjunto y el espacio generado sería el mismo. La siguiente definición se enfoca en los conjuntos en los que no pasa mal ninguna de estas cosas. Es decir, los vectores generan exactamente al espacio: cada vector se genera por una y sólo una combinación lineal de ellos.

Definición. Diremos que un conjunto de vectores $v_1, v_2, \ldots, v_k$ es base del esapacio vectorial $\mathbb{R}^n$ si el conjunto de vectores es linealmente independiente y el espacio generado por estos es exactamente $\mathbb{R}^n$.

Ejemplo. Al igual que en $\mathbb{R}^2$ y $\mathbb{R}^3$, la «base canónica» es el primer ejemplo que seguramente se nos viene a la mente. La base canónica en $\mathbb{R}^n$ consiste en los $n$ vectores $\mathrm{e}_1 = (1,0,0,\cdots,0)$, $\mathrm{e}_2 = (0,1,0,\cdots,0)$, $\mathrm{e}_3 = (0,0,1,\ldots,0)$, $\ldots$, $\mathrm{e}_n = (0,0,0,\cdots,1)$. Es claro que cualquier vector $u = (u_1,u_2,\cdots,u_n)$ es combinación lineal de $\mathrm{e}_1,\ldots,\mathrm{e}_n$ pues podemos expresarlo como

\begin{align*}

u

&= (u_1,u_2,\cdots,u_n) \\

&= (u_1,0,\cdots,0) + (0,u_2,\cdots,0) + \cdots (0,0,\cdots,u_n) \\

&= u_1(1,0,\cdots,0) + u_2(0,1,\cdots,0) + \cdots + u_n(0,0,\cdots,1) \\

&= u_1\mathrm{e}_1 + u_2\mathrm{e}_2 + \cdots + u_n\mathrm{e}_n.

\end{align*}

Además, los vectores $\mathrm{e}_1,\ldots,\mathrm{e}_n$ son linealmente independientes (¿puedes ver por qué?). De este modo, verificamos que la «base canónica» es, en efecto, una base.

$\triangle$

Ejemplo. Más arriba verificamos que los vectores $(1,5,1,-2)$, $(3,-3,0,-1)$, $(-2,0,4,1)$ y $(0,1,-1,0)$ son linealmente independientes. Además, vimos que la matriz formada por estos es invertible. De este modo, verificamos que estos vectores forman una base para $\mathbb{R}^4$.

$\triangle$

Más adelante…

A lo largo de esta unidad nos hemos enfocado en estudiar a vectores, matrices, ecuaciones lineales y espacios vectroriales. En las últimas entradas, vimos que hay ocho condiciones que se deben cumplir para que un conjunto de objetos matemáticos (junto con una operación de suma y una de producto escalar) sean considerados espacio vectorial. Todos los ejemplos de espacio vectorial que vimos son de la forma $\mathbb{R}^n$, sin embargo, puede surgir la pregunta, ¿existen espacios vectoriales que no sean de esta forma?

De hecho, si has estado prestando atención en la formalidad de los resultados, hay muchos resultados que han quedado pendientes:

- ¿Por qué el determinante no depende de la fila o columna en la que se expanda?

- Si tenemos matrices de $n\times n$, ¿por qué son invertibles si y sólo si el determinate es cero?

- En matrices de $n\times n$, ¿por qué el determinante es multiplicativo?

- ¿Cómo se formaliza el proceso de reducción gaussiana y para qué más sirve?

- ¿Será que podemos tener muchos vectores linealmente independientes en $\mathbb{R}^n$? ¿Será posible tener un conjunto generador de menos de $n$ vectores para $\mathbb{R}^n$? ¿Por qué?

Estas dudas no se resuelven en el curso de Álgebra Superior 2, que sigue a este. Sin embargo, en el curso de Álgebra Lineal I sí se resuelven varias de estas dudas.

Además, podrás ver que hay otros tipos de objetos matemáticos distintos a las listas ordenadas y que también forman un espacio vectorial; algunos con los cuales ya hemos trabajado, como lo son las matrices, y otros que se comportan de manera muy poco usual, como son los espacios con dimensión infinita. Asimismo, con las herramientas que hemos desarrollado hasta ahora, podremos aprender nuevos conceptos como transformaciones lineales, eigenvectores y eigenvalores; estos nos permitirán comprender de manera más íntima los espacios vectoriales, y podremos relacionarlos unos con otros.

Tarea moral

- Verifica lo siguiente:

- $(1,1,1,1)$, $(2,2,2,2)$, $(1,1,2,2)$, $(2,2,1,1)$ no es un conjunto linealmente independiente de $\mathbb{R}^4$.

- $(1,2,3,4)$, $(2,3,4,1)$, $(3,4,1,2)$, $(4,1,2,3)$ es un conjunto generador de $\mathbb{R}^4$.

- $(1,1,1,1,1),(1,1,1,1,0),(1,1,1,0,0),(1,1,0,0,0),(1,0,0,0,0)$ es una base de $\mathbb{R}^5$.

- Demuestra las siguientes dos cosas:

- Sea $S$ un conjunto generador de $\mathbb{R}^n$ y $T\supseteq S$. Entonces $T$ es conjunto generador de $\mathbb{R}^n$.

- Sea $T$ un conjunto linealmente independiente de $\mathbb{R}^n$ y $S\subseteq T$. Entonces $S$ es un conjunto linealmente independiente de $\mathbb{R}^n$.

- Sean $v_1,v_2,v_3,\ldots,v_k$ vectores linealmente independientes de $\mathbb{R}^n$. Demuestra que $v_1, v_1+v_2, v_1+v_2+v_3,\ldots,v_1+v_2+v_3+\ldots+v_k$ son también vectores linealmente independientes de $\mathbb{R}^n$. ¿Es esto un si y sólo si?

- En vista de lo que hemos platicado para matrices de $2\times 2$, $3\times 3$, $\mathbb{R}^2$ y $\mathbb{R}^3$, ¿cómo definirías el producto matriz-vector $AX$ donde $A$ es una matriz de $m\times n$ y $X$ un vector en $\mathbb{R}^n$?

- Demuestra que la definición de base tal y como está en la entrada en efecto permite no sólo escribir a cada vector $v$ del espacio como combinación lineal de los elementos de una base $v_1,\ldots,v_n$, sino que también implica que dicha expresión será única.

Entradas relacionadas

- Ir a Álgebra Superior I

- Entrada anterior del curso: Los espacios vectoriales $\mathbb{R}^2$ y $\mathbb{R}^3$