Introducción

Tenemos ya la definición de diferenciabilidad, y su versión manejable: la matriz jacobiana. Seguiremos construyendo conceptos y herramientas del análisis de los campos vectoriales muy importantes e interesantes. A continuación, enunciaremos una nueva versión de la regla de la cadena, que nos permitirá calcular las diferenciales de composiciones de campos vectoriales entre espacios de dimensión arbitraria. Esta regla tiene numerosas aplicaciones y es sorprendentemente fácil de enunciar en términos de producto de matrices.

Primeras ideas hacia la regla de la cadena

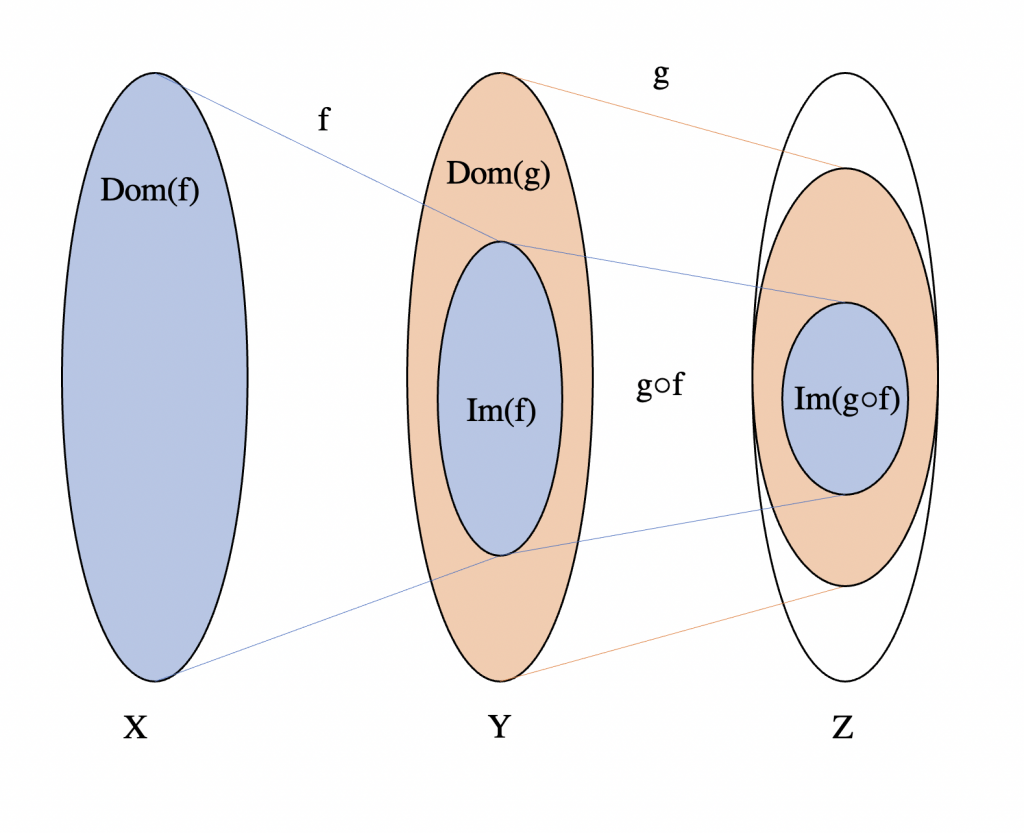

La situación típica de regla de la cadena es considerar dos funciones diferenciables que se puedan componer. A partir de ahí, buscamos ver si la composición también es diferenciable y, en ese caso, intentamos dar la derivada de la composición en términos de las derivadas de las funciones. Veamos qué pasa en campos vectoriales.

Pensemos en $f:S_{f}\subseteq \mathbb{R}^{m}\rightarrow \mathbb{R}^{n}$, $g:S_{g}\subseteq \mathbb{R}^{l}\rightarrow \mathbb{R}^{m}$ y en su composición $h=f\circ g$ definida sobre alguna vecindad $V\subseteq S_g$ de $\bar{a}$ y tal que $g(V)\subseteq S_f$. Pensemos que $g$ es diferenciable en $\bar{a}$ con derivada $G_\bar{a}$ y que $f$ es diferenciable en $\bar{b}:=g(\bar{a})$ con derivada $F_\bar{b}$.

Exploremos la diferenciabilidad de la composición $h$ en el punto $\bar{a}$. Para ello, tomemos un $\bar{y}\in \mathbb{R}^{l}$ tal que $\bar{a}+\bar{y}\in V$ y consideremos la siguiente expresión:

\begin{align*}

h(\bar{a}+\bar{y})-h(\bar{a})=f(g(\bar{a}+\bar{y}))-f(g(\bar{a})).

\end{align*}

Tomando $\bar{v}=g(\bar{a}+\bar{y})-g(\bar{a})$, tenemos $\bar{b}+\bar{v}=g(\bar{a})+\bar{v}=g(\bar{a}+\bar{y})$. De esta forma,

\begin{align*}

f(g(\bar{a}+\bar{y}))-f(g(\bar{a}))=f(\bar{b}+\bar{v})-f(\bar{b}).

\end{align*}

Por la diferenciabilidad de $g$ en $\bar{a}$, tenemos que podemos escribir

$$\bar{v}=G_{\bar{a}}(\bar{y})+||\bar{y}||E_{g}(\bar{a};\bar{y}),$$ con $\lim\limits_{\bar{y}\to \bar{0}}E_{g}(\bar{a};\bar{y})=0$.

Usando la diferenciabilidad de $f$ en $\bar{b}$, y la linealidad de su derivada $F_\bar{b}$, tenemos entonces que:

\begin{align*}

f(\bar{b}+\bar{v})-f(\bar{b})&=F_\bar{b}(\bar{v})+||\bar{v}||E_f(\bar{b};\bar{v})\\

&=F_\bar{b}(G_{\bar{a}}(\bar{y})+||\bar{y}||E_{g}(\bar{a};\bar{y}))+||\bar{v}||E_f(\bar{b};\bar{v})\\

&=(F_{b}\circ G_{\bar{a}})(\bar{y})+||\bar{y}||(F_{\bar{b}}\circ E_{g}(\bar{a};\bar{y}))+||\bar{v}||E_{f}(\bar{b};\bar{v}),

\end{align*}

con $\lim\limits_{\bar{y}\to \bar{0}}E_{f}(\bar{b};\bar{v})=0$.

Concatenando nuestras igualdades, podemos reescribir esto como

\[ h(\bar{a}+\bar{y})-h(\bar{a})=(F_{\bar{b}}\circ G_{\bar{a}})(\bar{y})+||\bar{y}||E_{h}(\bar{a};\bar{y}),\] en donde hemos definido

\[ E_{h}(\bar{a};\bar{y})=(F_{\bar{b}}\circ E_{g})(\bar{a};\bar{y})+\frac{||\bar{v}||}{||\bar{y}||}E_{f}(\bar{b};\bar{v}).\] Si logramos demostrar que $\lim\limits_{\bar{y}\to \bar{0}}E_{h}(\bar{a};\bar{y})=0$, entonces tendremos la diferenciabilidad buscada, así como la derivada que queremos. Dejemos esto en pausa para enunciar y demostrar un lema auxiliar.

Un lema para acotar la norma de la derivada en un punto

Probemos el siguiente resultado.

Lema. Sea $\phi:S\subseteq \mathbb{R}^l\to \mathbb{R}^m$ un campo vectorial diferenciable en un punto $\bar{c}\in S$ y $T_\bar{c}$ su derivada. Entonces, para todo $\bar{v}\in \mathbb{R}^{l}$, se tiene:

$$||T_{\bar{c}}(\bar{v})||\leq \sum_{k=1}^{m}||\triangledown \phi_{k}(\bar{c})||||\bar{v}||.$$

Donde $\phi(\bar{v})=\left( \phi_{1}(\bar{v}),\dots ,\phi_{m}(\bar{v})\right)$

Demostración. Procedemos con desigualdad del triángulo como sigue:

\begin{align*}

||T_{\bar{c}}(\bar{v})||&=\left|\left|\sum_{k=1}^{m}(\triangledown \phi_{k}(\bar{c})\cdot \bar{v})e_{k}\right|\right|\\

&\leq \sum_{k=1}^{m}||(\triangledown \phi_{k}(\bar{c})\cdot \bar{v})e_k||\\

&=\sum_{k=1}^{m}|\triangledown \phi_{k}(\bar{c})\cdot \bar{v}|

\end{align*}

y luego usamos la desigualdad de Cauchy-Schwarz en cada sumando para continuar como sigue

\begin{align*}

\leq \sum_{k=1}^{m}||\triangledown \phi_{k}(\bar{c})||||\bar{v}||,

\end{align*}

que es lo que buscábamos.

$\square$

Conclusión del análisis para regla de la cadena

Retomando el análisis para $E_{h}(\bar{a};\bar{y})$, dividamos el límite en los dos sumandos.

Primer sumando:

Como $F_{\bar{b}}$ es lineal, entonces es continua. También, sabemos que $\lim\limits_{\bar{y}\to \bar{0}}E_{g}(\bar{a};\bar{y})=0$. Así,

\begin{align*}

\lim\limits_{\bar{y}\to \bar{0}}(F_{\bar{b}}\circ E_{g})(\bar{a};\bar{y})&=F_{\bar{b}}\left(\lim\limits_{\bar{y}\to \bar{0}} E_{g}(\bar{a};\bar{y})\right)\\

&=F_\bar{b}(\bar{0})\\

&=0.

\end{align*}

Segundo sumando:

Retomando la definición de $\bar{v}$, aplicando desigualdad del triángulo y el lema que demostramos,

\begin{align*}

||\bar{v}||&=||G_{\bar{a}}(\bar{y})+||\bar{y}||E_{g}(\bar{a};\bar{y})||\\

&\leq ||G_{\bar{a}}(\bar{y})||+||\bar{y}||||E_{g}(\bar{a};\bar{y})||\\

&\leq \left(\sum_{k=1}^{m}||\triangledown g_{k}(\bar{a})||||\bar{y}||\right)+||\bar{y}||||E_{g}(\bar{a};\bar{y})||.

\end{align*}

Dividiendo ambos lados entre $||\bar{y}||$, obtenemos entonces que

$$ \frac{||\bar{v}||}{||\bar{y}||}\leq \sum_{k=1}^{m}||\triangledown g_{k}(\bar{a})||+||E_{g}(\bar{a};\bar{y})||. $$

De aquí se ve que conforme $\bar{y}\to \bar{0}$, la expresión $\frac{||\bar{v}||}{||\bar{y}||}$ está acotada superiormente por la constante $A:=\sum_{k=1}^{m}||\triangledown g_{k}(\bar{a})||.$ Además, si $\bar{y}\to \bar{0}$, entonces $\bar{v}\to \bar{0}$. Así,

\[0\leq \lim\limits_{\bar{y}\to \bar{0}}\frac{||\bar{v}||}{||\bar{y}||}E_{f}(\bar{b},\bar{v})\leq A\lim\limits_{\bar{y}\to \bar{0}}E_{f}(\bar{b},\bar{v})=0 \] pues $\lim\limits_{\bar{y}\to \bar{0}}\bar{v}=\bar{0}$ implica $\lim\limits_{\bar{y}\to \bar{0}}E_{f}(\bar{b},\bar{v})$.

Hemos concluido que $$h(\bar{a}+\bar{y})-h(\bar{a})=(F_{\bar{b}}\circ G_{\bar{a}})(\bar{y})+||\bar{y}||E_{h}(\bar{a};\bar{y}),$$

con $\lim_{\bar{y}\to \bar{0}} E_h(\bar{a};\bar{y})=0$. Esto precisamente es la definición de $h=f\circ g$ es diferenciable en $\bar{a}$, y su derivada en $\bar{a}$ es la transformación lineal dada por la composición de transformaciones lineales $F_\bar{b}\circ G_\bar{a}$.

Recapitulación de la regla de la cadena

Recapitulamos toda la discusión anterior en el siguiente teorema.

Teorema (Regla de la cadena). Sean $f:S_{f}\subseteq \mathbb{R}^{m}\rightarrow \mathbb{R}^{n}$, $g:S_{g}\subseteq \mathbb{R}^{l}\rightarrow \mathbb{R}^{m}$ campos vectoriales. Supongamos que la composición $f\circ g$ está definida en todo un abierto $S\subseteq S_g$. Supongamos que $g$ es diferenciable en un punto $\bar{a}\in S$ con derivada $G_\bar{a}$ y $f$ es diferenciable en $\bar{b}:=g(\bar{a})$ con derivada $F_\bar{b}$. Entonces, $h$ es diferenciable en $\bar{a}$ con derivada $F_\bar{b}\circ G_\bar{a}$.

Dado que la representación matricial de la composición de dos transformaciones lineales es igual al producto de estas, podemos reescribir esto en términos de las matrices jacobianas como el siguiente producto matricial: $$Dh(\bar{a})=Df(\bar{b})Dg(\bar{a}).$$

Usos de la regla de la cadena

Hagamos algunos ejemplos de uso de regla de la cadena. En el primer ejemplo que veremos a continuación, la función $f$ es un campo escalar.

Ejemplo 1. Tomemos $g:S\subseteq \mathbb{R}^{n}\rightarrow \mathbb{R}^{m}$ campo vectorial, y $f:U\subseteq \mathbb{R}^{m}\rightarrow \mathbb{R}$ campo escalar. Consideremos $h=f\circ g$ y supongamos que se satisfacen las hipótesis del teorema de la regla de la cadena. Tenemos: \[ Df(\bar{b})=\begin{pmatrix} \frac{\partial f}{\partial x_{1}}(\bar{b}) & \dots & \frac{\partial f}{\partial x_{m}}(\bar{b}) \end{pmatrix} \] y \[ Dg(\bar{a})=\begin{pmatrix}\frac{\partial g_{1}}{\partial x_{1}}(\bar{a}) & \dots & \frac{\partial g_{1}}{\partial x_{n}}(\bar{a}) \\ \vdots & \ddots & \vdots \\ \frac{\partial g_{m}}{\partial x_{1}}(\bar{a}) & \dots & \frac{\partial g_{m}}{\partial x_{n}}(\bar{a}) \end{pmatrix} . \]

Por la regla de la cadena tenemos $Dh(\bar{a})=Df(\bar{b})Dg(\bar{a})$ esto implica \[ \begin{pmatrix} \frac{\partial h}{\partial x_{1}}(\bar{a}) & \dots & \frac{\partial h}{\partial x_{n}}(\bar{a}) \end{pmatrix}=\begin{pmatrix} \frac{\partial f}{\partial x_{1}}(\bar{b}) & \dots & \frac{\partial f}{\partial x_{m}}(\bar{b}) \end{pmatrix}\begin{pmatrix} \frac{\partial g_{1}}{\partial x_{1}}(\bar{a}) & \dots & \frac{\partial g_{1}}{\partial x_{n}}(\bar{a}) \\ \vdots & \ddots & \vdots \\ \frac{\partial g_{m}}{\partial x_{1}}(\bar{a}) & \dots & \frac{\partial g_{m}}{\partial x_{n}}(\bar{a}) \end{pmatrix}. \]

Así \[ \begin{pmatrix} \frac{\partial h}{\partial x_{1}}(\bar{a}) & \dots & \frac{\partial h}{\partial x_{n}}(\bar{a}) \end{pmatrix}= \begin{pmatrix} \sum_{i=1}^{m}\frac{\partial f}{\partial x_{i}}(\bar{b})\frac{\partial g_{i}}{\partial x_{1}}(\bar{a}) & \dots & \sum_{i=1}^{m}\frac{\partial f}{\partial x_{i}}(\bar{b})\frac{\partial g_{i}}{\partial x_{n}}(\bar{a}) \end{pmatrix}. \]

En otras palabras, tenemos las siguientes ecuaciones para calcular cada derivada parcial de $h$: \[ \frac{\partial h}{\partial x_{j}}(\bar{a})=\sum_{i=1}^{m}\frac{\partial f}{\partial x_{i}}(\bar{b})\frac{\partial g_{i}}{\partial x_{j}}(\bar{a}).\]

$\triangle$

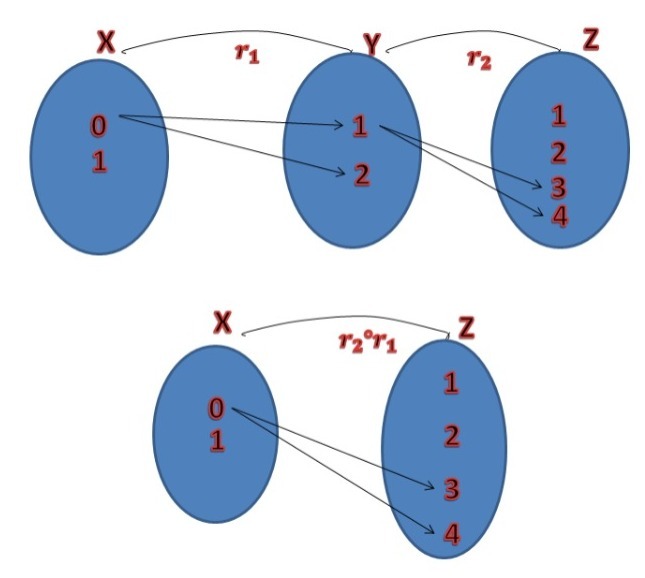

Ejemplo 2. Sean $\bar{a}=(s,t)$ y $\bar{b}=(x,y)$ puntos en $\mathbb{R}^{2}$. Pensemos que las entradas de $\bar{b}$ están dadas en función de las entradas de $\bar{a}$ mediante las ecuaciones $x=g_{1}(s,t)$ y $y=g_{2}(s,t)$. Pensemos que tenemos un campo escalar $f:\mathbb{R}^2\to \mathbb{R}$, y definimos $h:\mathbb{R}^2\to \mathbb{R}$ mediante $$h(s,t)=f(g_{1}(s,t),g_{2}(s,t)).$$

Por el ejemplo anterior \[ \frac{\partial h}{\partial s}=\frac{\partial f}{\partial x}\frac{\partial x}{\partial s}+\frac{\partial f}{\partial y}\frac{\partial y}{\partial s} \] y \[ \frac{\partial h}{\partial t}=\frac{\partial f}{\partial x}\frac{\partial x}{\partial t}+\frac{\partial f}{\partial y}\frac{\partial y}{\partial t}. \] Como tarea moral queda que reflexiones qué significa $\partial x$ cuando aparece en el «numerador» y qué significa cuando aparece en el «denominador».

$\triangle$

Ejemplo 3. Para un campo escalar $f(x,y)$ consideremos un cambio de coordenadas $x=rcos\theta$, $y=rsen\theta$ es decir tomemos la función $\phi (r,\theta)=f(rcos\theta ,rsen\theta )$.

Por el ejemplo anterior tenemos \[ \frac{\partial \phi }{\partial r}=\frac{\partial f}{\partial x}\frac{\partial x}{\partial r}+\frac{\partial f}{\partial y}\frac{\partial y}{\partial r} \] y \[ \frac{\partial \phi }{\partial \theta }=\frac{\partial f}{\partial x}\frac{\partial x}{\partial \theta }+\frac{\partial f}{\partial y}\frac{\partial y}{\partial \theta } \] donde, haciendo las derivadas parciales tenemos: \[ \frac{\partial x}{\partial r}=cos\theta ,\hspace{1cm}\frac{\partial y}{\partial r}=sen\theta \] y \[ \frac{\partial x}{\partial \theta }=-rsen\theta,\hspace{1cm}\frac{\partial y}{\partial \theta }=-rcos\theta. \] Finalmente obtenemos: \[ \frac{\partial \phi }{\partial r }=\frac{\partial f }{\partial x }cos\theta +\frac{\partial f }{\partial y }sen\theta \] y \[ \frac{\partial \phi }{\partial \theta }=-\frac{\partial f }{\partial x }rsen\theta +\frac{\partial f }{\partial y }rcos\theta \] que son las derivadas parciales del cambio de coordenadas en el dominio de $f$.

$\triangle$

Mas adelante…

En la siguiente entrada comenzaremos a desarrollar la teoría para los importantes teoremas de la función inversa e implícita si tienes bien estudiada esta sección disfrutaras mucho de las siguientes.

Tarea moral

- Considera el campo escalar $F(x,y,z)=x^{2}+y sen(z)$. Imagina que $x,y,z$ están dados por valores $u$ y $v$ mediante las condiciones $x=u+v$, $y=vu$, $z=u$. Calcula $\frac{\partial F}{\partial u}$, $\frac{\partial F}{\partial v}$.

- Sea $g(x,y,z)=(xy,x)$, y $f(x,y)=(2x,xy^{2},y)$. Encuentra la matriz jacobiana del campo vectorial $g\circ f$. Encuentra también la matriz jacobiana del campo vectorial $f\circ g$.

- En la demostración del lema que dimos, hay un paso que no justificamos: el primero. Convéncete de que es cierto repasando el contenido de la entrada anterior Diferenciabilidad.

- Imagina que sabemos que la función $f:\mathbb{R}^n\to \mathbb{R}^n$ es invertible y derivable en $\bar{a}$ con derivada $T_\bar{a}$. Imagina que también sabemos que su inversa $f^{-1}$ es derivable en $\bar{b}=f(\bar{a})$ con derivada $S_\bar{b}$. De acuerdo a la regla de la cadena, ¿Qué podemos decir de $T_\bar{a}\circ S_\bar{b}$? En otras palabras, ¿Cómo son las matrices jacobianas entre sí, en términos de álgebra lineal?

- Reflexiona en cómo todas las reglas de la cadena que hemos estudiado hasta ahora son un corolario de la regla de la cadena de esta entrada.

Entradas relacionadas

- Ir a Cálculo Diferencial e Integral III

- Entrada anterior del curso: Diferenciabilidad en campos vectoriales

- Entrada siguiente del curso: Introducción al teorema de la función inversa