Introducción

Anteriormente, platicamos acerca de formas bilineales y de formas cuadráticas. Ahora veremos un tipo de formas bilineales especiales: las positivas y las positivas definidas. Las formas positivas definidas nos ayudan a definir qué es un producto interior. Esta es una noción fundamental que más adelante nos ayudará a definir distancias y ángulos.

Formas bilineales positivas y positivas definidas

Para hablar de geometría en espacios vectoriales, la siguiente noción es fundamental. Es importante notar que es una definición únicamente para formas bilineales simétricas.

Definición. Sea $b:V\times V\to \mathbb{R}$ una forma bilineal simétrica.

- Diremos que $b$ es positiva si $b(x,x)\geq 0$ para todo vector $x$ de $V$.

- Diremos que $b$ es positiva definida si $b(x,x)>0$ para todo vector $x\neq 0$ de $v$.

Tenemos una noción análoga para formas cuadráticas.

Definición. Sea $q:V\to \mathbb{R}$ una forma cuadrática con forma polar $b$. Diremos que $q$ es positiva si $b$ lo es, y diremos que es positiva definida si $b$ lo es.

Ejemplo 1. Como ya vimos antes, el producto punto de $\mathbb{R}^n$ es una forma bilineal simétrica. También es positiva definida, pues si tenemos $x=(x_1,\ldots,x_n)$, tenemos que $$x\cdot x = x_1^2+\ldots+x_n^2\geq 0,$$ y esta es una igualdad si y sólo si $x_1=\ldots=x_n=0$, lo cual sucede si y sólo si $x=0$.

$\triangle$

Ejemplo 2. Considera $V=\mathbb{R}_2[x]$ y consideremos la forma bilineal $b$ dada por $$b(p,q)=p(0)q(1)+p(1)q(0).$$ Esta es una forma bilineal simétrica pues \begin{align*}b(p,q)&=p(0)q(1)+p(1)q(0)\\&=q(0)p(1)+q(1)p(0)\\&=b(q,p).\end{align*} Notemos que $$b(p,p)=2p(0)p(1),$$ que no necesariamente es positivo. Por ejemplo, si tomamos el polinomio $p(x)=x-\frac{1}{2}$, tenemos que \begin{align*}b(p,p)&=2p(0)p(1)\\&=-2\cdot\frac{1}{2}\cdot\frac{1}{2}\\&=-\frac{1}{2}.\end{align*} Así, esta es una forma bilineal simétrica, pero no es positiva (y por lo tanto tampoco es positiva definida).

$\triangle$

Problema. Considera la forma cuadrática $Q$ en $M_{2}(\mathbb{R})$ que suma el cuadrado de las entradas de la diagonal de una matriz, es decir, aquella dada por $$Q\begin{pmatrix} a & b\\c & d\end{pmatrix}=a^2+d^2.$$ Determina su forma polar y si es positiva o positiva definida.

Solución. Para encontrar la forma polar $B$ de $Q$, usamos la identidad de polarización

\begin{align*}

B&\left(\begin{pmatrix}a&b\\c&d\end{pmatrix},\begin{pmatrix} e & f\\ g & h \end{pmatrix}\right)\\

&=\frac{(a+e)^2+(d+h)^2-a^2-e^2-d^2-h^2}{2}\\

&=\frac{2ae+2dh}{2}\\

&=ae+dh.

\end{align*}

Como $Q\begin{pmatrix}a&b\\c&d\end{pmatrix}=a^2+d^2\geq 0$, tenemos que $Q$ (y $B$) son positivas. Sin embargo, $Q$ no es positiva definida (ni $B$), pues por ejemplo, $$Q\begin{pmatrix}0&1\\1&0\end{pmatrix} = 0.$$

Producto interior

Estamos listos para definir aquellos espacios sobre los que podemos hacer geometría.

Definición. Sea $V$ un espacio vectorial sobre $\mathbb{R}$

- Un producto interior en $V$ es una forma bilineal simétrica y positiva definida.

- Decimos que $V$ es un espacio Euclideano si es de dimensión finita y está equipado con un producto interior.

Estamos siguiendo la convención del libro de Titu Andreescu, en donde es importante pedir que $V$ sea de dimensión finita para ser Euclideano.

Cuando estamos hablando de espacios con producto interior, o de espacios Euclideanos, tenemos una forma bilineal simétrica y positiva definida $b$. Sin embargo, en vez de usar constantemente $b(x,y)$, para simplificar la notación usaremos simplemente $\langle x, y\rangle$.

Definición. Si $V$ es un espacio con producto interior $\langle \cdot,\cdot \rangle$, definimos la norma de un vector $x$ como $$\Vert x \Vert =\sqrt{\langle x, x \rangle}.$$

Ejemplo. Como dijimos arriba, el producto punto en $\mathbb{R}^n$ es una forma bilineal simétrica, así que es un producto interior. Como $\mathbb{R}^n$ es de dimensión finita, entonces es un espacio Euclideano.

La norma de un vector $x=(x_1,\ldots,x_n)$ está dada por $\Vert x \Vert = \sqrt{x_1^2+\ldots+x_n^2},$ y geométricamente se interpreta como la distancia de $x$ al origen.

Un ejemplo más concreto es $\mathbb{R}^4$, en donde la norma del vector $(1,2,3,1)$ es $\sqrt{1^2+2^2+3^2+1^2}=\sqrt{15}$.

$\triangle$

La notación de producto interior quizás te recuerde la notación que se usa cuando hablamos de dualidad. Sin embargo, es muy importante que distingas los contextos. En el caso de dualidad, tenemos $$\langle \cdot, \cdot \rangle: V^\ast\times V \to \mathbb{R},$$ y en este contexto de producto interior tenemos $$\langle \cdot, \cdot \rangle: V\times V \to \mathbb{R}.$$ Más adelante, puede que te encuentres en tu preparación matemática con el teorema de representación de Riesz, a partir del cual tendrá sentido que se use la misma notación.

Desigualdad de Cauchy-Schwarz

A continuación presentamos un resultado fundamental es espacios con formas bilineales positivas y positivas definidas.

Teorema (desigualdad de Cauchy-Schwarz). Sea $b:V\times V\to \mathbb{R}$ una forma bilineal simétrica y $q$ su forma cuadrática asociada.

- Si $b$ es positiva, entonces para todo $x$ y $y$ en $V$ tenemos que $$b(x,y)^2\leq q(x)q(y).$$ Si $x$ y $y$ son linealmente dependientes, se alcanza la igualdad.

- Además, si $b$ es positiva definida y $x$ y $y$ son linealmente independientes, entonces la desigualdad es estricta.

Demostración. Supongamos primero solamente que $b$ es positiva. Consideremos la función $f:\mathbb{R}\to \mathbb{R}$ dada por $f(t)=q(x+ty)$. Como $q$ es forma cuadrática positiva, tenemos que $f(t)\geq 0$ para todo real $t$. Por otro lado, expandiendo y usando que $b$ es simétrica, tenemos que

\begin{align*}

f(t)&=q(x+ty)\\

&=b(x+ty,x+ty)\\

&=b(x,x)+2b(x,y)\cdot t + b(y,y) \cdot t^2\\

&=q(x) + 2b(x,y)\cdot t + q(y) \cdot t^2.

\end{align*}

En esta expresión, $q(x)$, $2b(x,y)$ y $q(y)$ son reales, así que $f(t)$ es un polinomio cuadrático en $t$. Como $f(t)\geq 0$ para todo $t$ en $\mathbb{R}$, el discriminante de este polinomio es no positivo, en otras palabras, $$(2b(x,y))^2-4q(x)q(y)\leq 0.$$

Sumando $4q(x)q(y)$ y dividiendo entre $4$ ambos lados de la desigualdad, obtenemos que $$b(x,y)^2\leq q(x)q(y),$$ la cual es la desigualdad que queremos.

Si $x$ y $y$ son linealmente dependientes, podemos despejar a uno en términos del otro. Sin perder generalidad, podemos suponer que $x=\alpha y$. En este caso, $$b(\alpha y,y)^2=\alpha^2 b(y,y)=q(\alpha(y))q(y),$$ así que se da la igualdad.

Ahora, supongamos además que $b$ es positiva definida y que se da la igualdad. Si esto sucede, el discriminante del polinomio cuadrático de arriba es igual a $0$ y por lo tanto el polinomio tiene una raíz $t$. En otras palabras, $q(x+ty)=0$. Pero como $q$ es positiva definida, esto implica que $x+ty=0$, de donde $x$ y $y$ son linealmente dependientes. Así, si $x$ y $y$ son linealmente independientes, tenemos que la desigualdad es estricta.

$\square$

El siguiente caso particular es uno de los más importantes y los más usados, por lo cual amerita que lo enunciemos separadamente.

Corolario. Sea $V$ un espacio vectorial sobre $\mathbb{R}$ equipado con un producto interior $\langle \cdot, \cdot \rangle$. Para cualesquiera $x,y$ en $V$ se cumple $|\langle x, y \rangle| \leq \Vert x \Vert \cdot \Vert y \Vert$.

Puede que te preguntes por qué enfatizamos los resultados de desigualdades. En varias partes de tu formación matemática trabajarás con espacios vectoriales en donde quieres hacer cálculo. Ahí, se define la convergencia y los límites en términos de una norma. Las desigualdades que probemos para espacios vectoriales son útiles para cuando se quiere demostrar la validez de ciertos límites. Más adelante mencionaremos algunas cosas adicionales al respecto.

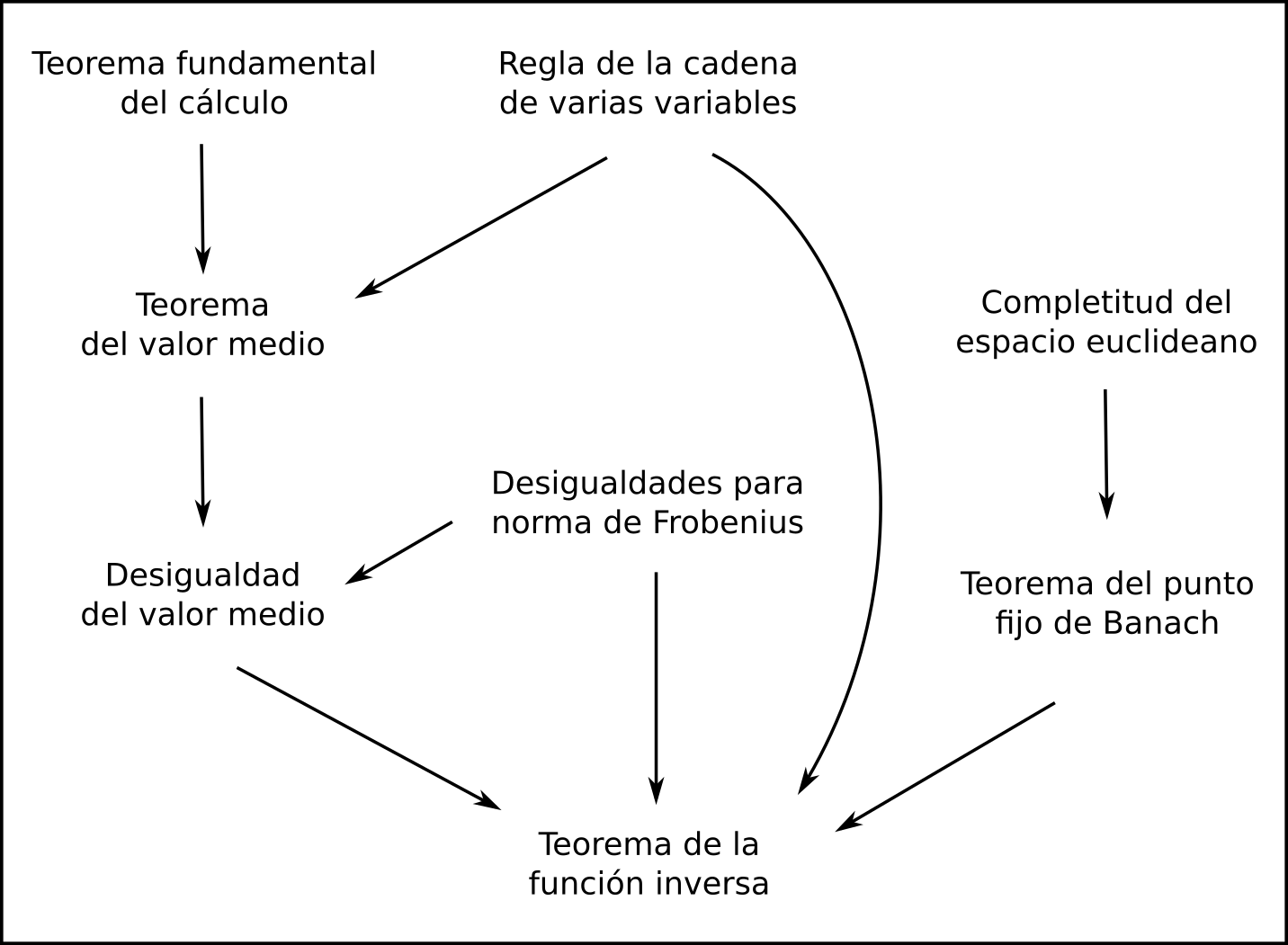

Más adelante…

En esta entrada definimos el concepto de producto interior y vimos cómo el producto interior induce una norma en el espacio vectorial. El concepto de norma nos permite generalizar la noción de distancia y esto nos permitirá ver cómo se puede hacer cálculo en espacios vectoriales.

En las siguientes entradas veremos cómo se define esta norma para diferentes espacios vectoriales con diferentes productos interiores. Podremos ver entonces cómo se generalizan otras nociones que ya hemos visto en cursos anteriores; como el concepto de ángulo.

Tarea moral

A continuación hay algunos ejercicios para que practiques los conceptos vistos en esta entrada. Te será de mucha utilidad intentarlos para entender más la teoría vista.

- Considera la función $q(w,x,y,z)=wx+yz$. Muestra que es una forma cuadrática en $\mathbb{R}^4$. Encuentra su forma polar y determina si es una forma cuadrática positiva y/o positiva definida.

- Muestra que $$q(w,x,y,z)=x^2+y^2+z^2+xy+yz+zx$$ es una forma cuadrática en $\mathbb{R}^4$ y determina si es positiva y/o positiva definida.

- Considera $V=\mathcal{C}[0,1]$ el espacio vectorial de funciones continuas en el intervalo $[0,1]$. Muestra que $$\langle f,g\rangle = \int_0^1 f(x)g(x)\, dx$$ define un producto interior en $V$. ¿Es $V$ un espacio Euclideano? Determina la norma de la función $f(x)=x^3$.

- Sea $V=\mathbb{R}_2[x]$ el espacio vectorial de polinomios con coeficientes reales y de grado a lo más $1$. Muestra que $$\langle p,q\rangle = p(0)q(0)+p(1)q(1)+p(2)q(2)$$ hace a $V$ un espacio Euclideano.

Entradas relacionadas

- Ir a Álgebra Lineal I

- Entrada anterior del curso: Formas cuadráticas, propiedades, polarización y teorema de Gauss

- Siguiente entrada del curso: Problemas de formas cuadráticas y producto interior

Agradecimientos

Trabajo realizado con el apoyo del Programa UNAM-DGAPA-PAPIME PE104721 «Hacia una modalidad a distancia de la Licenciatura en Matemáticas de la FC-UNAM»