Introducción

En las entradas anteriores definimos qué quiere decir que un campo escalar sea diferenciable. Así mismo, definimos las derivadas parciales y el gradiente. Ya usamos estas herramientas para hablar de dirección de cambio máximo y de puntos críticos. Además demostramos una versión del teorema del valor medio para este caso, lo que nos permitió poner un poco de orden a nuestra teoría: una función es diferenciable en un punto cuando existen sus parciales en ese punto y son continuas. Es momento de hablar de derivadas parciales de segundo orden. Cualquiera de las derivadas parciales es por sí misma un campo escalar, así que podemos preguntarnos si tiene o no sus propias derivadas parciales. Exploraremos esta idea.

Derivadas parciales de segundo orden

Las derivadas parciales de un campo escalar $f$ nos originan nuevos campos escalares. Supongamos que $f:S\subseteq \mathbb{R}^{n}\rightarrow \mathbb{R}$ es un campo escalar para el cual existe la $k$-ésima derivada parcial en un conjunto abierto $S’\subseteq S$. Entonces, obtenemos un nuevo campo escalar $\frac{\partial f}{\partial x_{k}}:S’\rightarrow \mathbb{R}$.

Este campo escalar puede o no tener $j$-ésima derivada parcial. Suponiendo que la tiene en algún $U\subseteq S’$ podríamos escribirla como

$$\frac{\partial\left(\frac{\partial f}{\partial x_k}\right)}{\partial x_j}.$$

Sin embargo, esta notación es engorrosa, y por ello optamos o bien por escribir la expresión como sigue

\[ \frac{\partial}{\partial x_{j}}\left( \frac{\partial f}{\partial x_{k}}\right)\]

o todavía más compacto, como

\[ \frac{\partial ^{2}f}{\partial x_{j}\partial x_{k}}.\]

A esto le llamamos una derivada parcial de segundo orden. Si $j=k$, introducimos la notación

\[ \frac{\partial ^{2}f }{\partial x_{k}^{2}}.\]

Las derivadas parciales de segundo orden vuelven a ser, una vez más, cada una de ellas un campo escalar. Esto permite seguir iterando la idea: podríamos hablar de derivadas parciales de segundo, tercero, cuarto, … , $k$-ésimo, … orden. Daremos una definición un poco más formal en una siguente entrada, pero por ahora trabajemos en entender a las derivadas parciales de segundo orden.

Un ejemplo de derivadas parciales de segundo orden

Ejemplo. Consideremos el campo escalar $f(x,y,z)=x^{2}yz$. Para este campo escalar tenemos que sus derivadas parciales con respecto a $x$, $y$ y $z$ son:

\begin{align*}

\frac{\partial f}{\partial x}(x,y,z)&=2xyz,\\

\frac{\partial f}{\partial y}(x,y,z)&=x^{2}z\\

\frac{\partial f}{\partial z}(x,y,z)&=x^{2}y.

\end{align*}

Cada una de estas expresiones es a su vez un campo escalar. Cada una de ellas es derivable con respecto a $x$ en todo $\mathbb{R}^3$. Al derivarlas con respecto a $x$ obtenemos:

\begin{align*}

\frac{\partial ^{2}f}{\partial x^{2}}(x,y,z)&=2yz,\\

\frac{\partial ^{2}f}{\partial x\partial y}(x,y,z)&=2xz,\\

\frac{\partial ^{2}f}{\partial x\partial z}(x,y,z)&=2xy.

\end{align*}

Por otro lado, las derivadas parciales de primer orden también podríamos haberlas derivado con respecto a $y$. En este caso, hubieramos obtenido.

\begin{align*}

\frac{\partial ^{2}f}{\partial y \partial x}(x,y,z)&=2xz,\\

\frac{\partial ^{2}f}{\partial y ^2}(x,y,z)&=0,\\

\frac{\partial ^{2}f}{\partial y\partial z}(x,y,z)&=x^2.

\end{align*}

También podríamos derivar a las derivadas parciales de primer orden con respecto a $z$ para obtener las tres derivadas de orden dos faltantes. En total tenemos tres derivadas parciales de primer orden y nueve derivadas parciales de segundo orden.

$\triangle$

Igualdad de las derivadas parciales de segundo orden mixtas

En numerosos campos escalares de interés tenemos una propiedad muy peculiar: que los operadores «obtener la derivada parcial con respecto a $x$» y «obtener la derivada parcial con respecto a $y$» conmutan. Es decir, varias veces podemos intercambiar el orden de derivación de las parciales y obtener el mismo resultado. En el ejemplo anterior quizás hayas notado que

\[ \frac{\partial ^{2}f}{\partial y\partial x}=2xz=\frac{\partial ^{2}f}{\partial x\partial y}.\]

Esto no siempre pasa, pero hay criterios de suficiencia sencillos de verificar. Por ejemplo, basta que las parciales mixtas existan y sean continuas para que sean iguales. El siguiente teorema formaliza el resultado.

Teorema. Sea $f:S\subseteq \mathbb{R}^{2}\rightarrow \mathbb{R}$ un campo escalar tal que las derivadas parciales $\frac{\partial f}{\partial x}$, $\frac{\partial f}{\partial y}$, $\frac{\partial^{2} f}{\partial y\partial x}$, $\frac{\partial ^{2}f}{\partial x\partial y}$ existen en un conjunto abierto $U$. Si $(a,b)\in U$ es tal que $\frac{\partial^{2} f}{\partial y\partial x}$, $\frac{\partial ^{2}f}{\partial x\partial y}$ son continuas en $(a,b)$, entonces dichas derivadas mixtas de segundo orden son iguales en $(a,b)$.

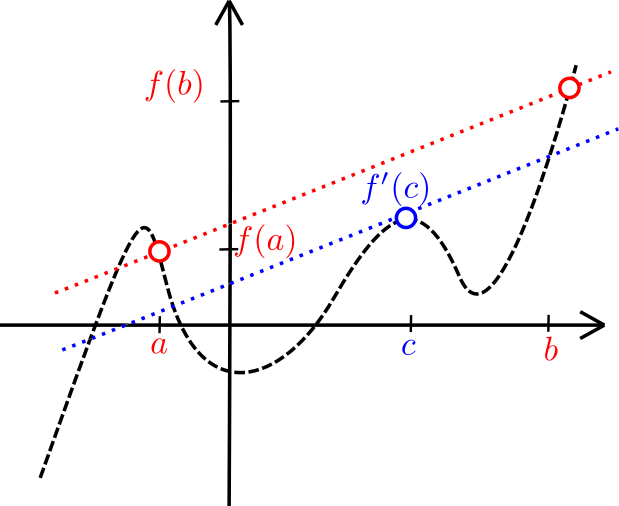

Demostración. Sean $h,k\neq 0$ suficientemente chicos para que los puntos en el plano $(a,b)$, $(a,b+k)$, $(a+h,b)$, y $(a+h,b+k)$ estén en $U$.

Definamos la función $\Gamma (x)=f(x,b+k)-f(x,b)$ para $x\in [a,a+h]$ y definamos

\begin{equation} \Delta (h,k)=\Gamma (a+h)-\Gamma (a).\end{equation}

Notemos que $\Gamma$ es una función de $\mathbb{R}$ en $\mathbb{R}$ cuya derivada es $$\Gamma'(x)=\frac{\partial f}{\partial x}(x,b+k)-\frac{\partial f}{\partial x}(x,b).$$ Así, se le puede aplicar el teorema del valor medio con extremos en $a$ y $a+h$ para concluir que existe $\xi _{1}\in [a,a+h]$ que nos permite escribir $\Delta(h,k)$ de la siguiente manera:

\begin{align*}

\Delta(h,k)&=\Gamma (a+h)-\Gamma (a)\\

&= h\Gamma'(\xi _{1})\\

&=h\left[ \frac{\partial f}{\partial x}(\xi _{1},b+k)-\frac{\partial f}{\partial x}(\xi _{1},b) \right]

\end{align*}

Ahora podemos aplicar el teorema del valor medio en la función $y\mapsto \frac{\partial f}{\partial x} (\xi _{1},y)$ con extremos $b$ y $b+k$. Esto nos permite continuar la cadena de igualdades anterior mediante un $\eta _{1}\in [b,b+k]$ que cumple

\begin{equation}\label{eq:primerdelta} \Delta (h,k)=hk\frac{\partial ^{2}f}{\partial y\partial x}(\xi _{1},\eta _{1}).\end{equation}

Como $(\xi _{1},\eta _{1})\in [a,a+h]\times[b,b+k]$, se tiene que $(\xi _{1},\eta _{1})\to (a,b)$ conforme $(h,k)\to \bar{0}$.

Ahora consideremos análogamente a la función $\varLambda (y)=f(a+h,y)-f(a,y)$. Mediante un procedimiento similar al que acabamos de hacer, pero aplicado a $\varLambda$ en vez de a $\Gamma$, se tiene otra forma de expresar a $\Delta(h,k)$:

\begin{equation}\label{eq:segundodelta}\Delta(h,k)=hk\frac{\partial ^{2} f}{\partial x\partial y}(\xi _{2},\eta _{2}),\end{equation} donde $(\xi _{2},\eta _{2})\in [a,a+h]\times[b,b+k]$. Nuevamente, $(\xi _{2},\eta _{2})\to (a,b)$ conforme $(h,k)\to (0,0)$.

Igualando las expresiones en \eqref{eq:primerdelta} y \eqref{eq:segundodelta}, tenemos lo siguiente:

\[ \frac{\partial f}{\partial y\partial x}(\xi _{1},\eta _{1})=\frac{\partial f}{\partial x\partial y}(\xi _{2},\eta _{2}).\]

El resultado se sigue de hacer tender $(h,k)\to (0,0)$, ya que dado que las derivadas parciales les estamos pidiendo que sean continuas, tenemos que:

\begin{align*}

\frac{\partial ^{2} f}{\partial y\partial x}(a,b)&=\lim\limits_{(h,k)\to (0,0)}\frac{\partial ^{2} f}{\partial y\partial x}(\xi _{1},\eta _{1})\\

&=\lim\limits_{(h,k)\to (0,0)}\frac{\partial ^{2}f}{\partial x\partial y}(\xi _{2},\eta _{2})\\

&=\frac{\partial ^{2}f}{\partial x\partial y}(a,b).

\end{align*}

Así concluimos nuestro resultado.

$\square$

Más adelante…

En esta entrada hablamos de las derivadas parciales de segundo orden y vimos que bajo condiciones razonables podemos elegir las variables de derivación en el orden que queramos. Estas ideas son más generales, y a continuación nos llevarán a definir las derivadas parciales de cualquier orden $k$. Después, usaremos estas derivadas parciales para generalizar otro de los teoremas de cálculo unidimensional: el teorema de Taylor.

Tarea moral

- Para las siguientes funciones calcula $\frac{\partial ^{2}f}{\partial x^{2}}$:

- $f(x,y)=x^{2}+y^{2}cos(xy)$

- $f(x,y)=e^{x}cos(y)$

- $f(x,y,z)=\textup{log}(x^{2}+2y^{2}-3z^{2})$

- En el teorema que afirma que las derivadas parciales mixtas son iguales usamos cuatro veces el teorema del valor medio (¿cuáles 4 son?). Asegúrate de que en verdad lo podamos usar.

- Calcula $\frac{\partial ^{2}f}{\partial y^{2}}$, y $\frac{\partial ^{2}f}{\partial x\partial y}$ para las funciones del punto 1. Explica por qué no es necesario calcular de manera separada $\frac{\partial ^{2}f}{\partial y\partial x}$

- Investiga de un ejemplo en el que las derivadas parciales $\frac{\partial ^{2}f}{\partial x\partial y}$ y $\frac{\partial ^{2}f}{\partial y\partial x}$ no sean iguales. Realiza las cuentas para verificar que en efecto tienen valores distintos en algún punto.

- El teorema que enunciamos está muy limitado. Sólo nos habla de campos escalares de $\mathbb{R}^2$ en $\mathbb{R}$. Sin embargo, debería también funcionar si $f:\mathbb{R}^n\to \mathbb{R}$. Enuncia y demuestra un resultado similar que te permita garantizar que $$\frac{\partial^{2} f}{\partial x_i\partial x_j}=\frac{\partial ^{2}f}{\partial x_j\partial x_i}.$$

Entradas relacionadas

- Ir a Cálculo Diferencial e Integral III

- Entrada anterior del curso: Teorema del valor medio para campos escalares

- Entrada siguiente del curso: Derivadas parciales de orden superior