Introducción

Ya definimos a los determinantes para vectores, para transformaciones y para matrices. Además, mostramos algunas propiedades básicas de determinantes y las usamos para resolver varios problemas. Como hemos discutido, los determinantes guardan información importante sobre una transformación lineal o sobre una matriz. También ayudan a implementar la técnica de diagonalización la cual introdujimos hace algunas entradas y en la cual profundizaremos después. Es por esta razón que es importante tener varias técnicas para el cálculo de determinantes.

Fuera de este curso, los determinantes sirven en muchas otras áreas de las matemáticas. Cuando se hace cálculo de varias variables ayudan a enunciar el teorema del cambio de variable. En combinatoria ayudan a calcular el número de árboles generadores de una gráfica. Más adelante en tu formación matemática es probable que te encuentres con otros ejemplos.

Calculo de determinantes de $2\times 2$

Como ya discutimos anteriormente, una matriz en $M_2(F)$, digamos $A=\begin{pmatrix}a&b\\ c&d\end{pmatrix}$ tiene determinante $ad-bc$.

Problema. Calcula el determinante de la matriz $$\begin{pmatrix} 0 & 1\\ 1 & 1\end{pmatrix}^8.$$

Solución. Por la fórmula para el determinante de las matrices de $2\times 2$, se tiene que $\begin{vmatrix} 0 & 1\\ 1 & 1\end{vmatrix} = 0\cdot 1 – 1\cdot 1 = -1.$

Como el determinante es multiplicativo, $\det(A^2)=\det(A)\det(A)=(\det(A))^2$, e inductivamente se puede mostrar que para todo entero positivo $n$ se tiene que $\det(A^n)=(\det(A))^n$. De esta forma, el determinante que buscamos es $(-1)^8=1$.

$\triangle$

Observa que hubiera tomado más trabajo elevar la matriz a la octava potencia. Aunque esto usualmente no es recomendable, en este problema hay algo interesante que sucede con esta matriz. Llamémosla $A=\begin{pmatrix} 0 & 1\\ 1 & 1\end{pmatrix}$. Haciendo las cuentas para las primeras potencias, se tiene que

\begin{align*}

A&=\begin{pmatrix} 0 & 1\\ 1 & 1\end{pmatrix}\\

A^2&=\begin{pmatrix} 1 & 1\\ 1 & 2\end{pmatrix}\\

A^3&=\begin{pmatrix} 1 & 2\\ 2 & 3\end{pmatrix}\\

A^4&=\begin{pmatrix} 2 & 3\\ 3 & 5\end{pmatrix}\\

A^5&=\begin{pmatrix} 3 & 5\\ 5 & 8\end{pmatrix}

\end{align*}

Aquí aparece la sucesión de Fibonacci, dada por $F_0=0$, $F_1=1$ y $F_{n+2}=F_{n+1}+F_n$ para $n\geq 0$, cuyos primeros términos son $$0,1,1,2,3,5,8,13,21,\ldots.$$ De hecho se puede probar por inducción que $$A^n=\begin{pmatrix} F_{n-1} & F_n\\ F_n & F_{n+1}\end{pmatrix}.$$

Así, por un lado el determinante de la matriz $A^n$ es $F_{n-1}F_{n+1}-F_n^2$, usando la fórmula de determinante de $2\times 2$. Por otro lado, es $(-1)^n$, por el argumento del problema. Con esto hemos demostrado que para cualquier entero $n$ tenemos la siguiente identidad para los números de Fibonacci: $$F_{n-1}F_{n+1}-F_n^2 = (-1)^n.$$

Cálculo de determinantes de $3\times 3$

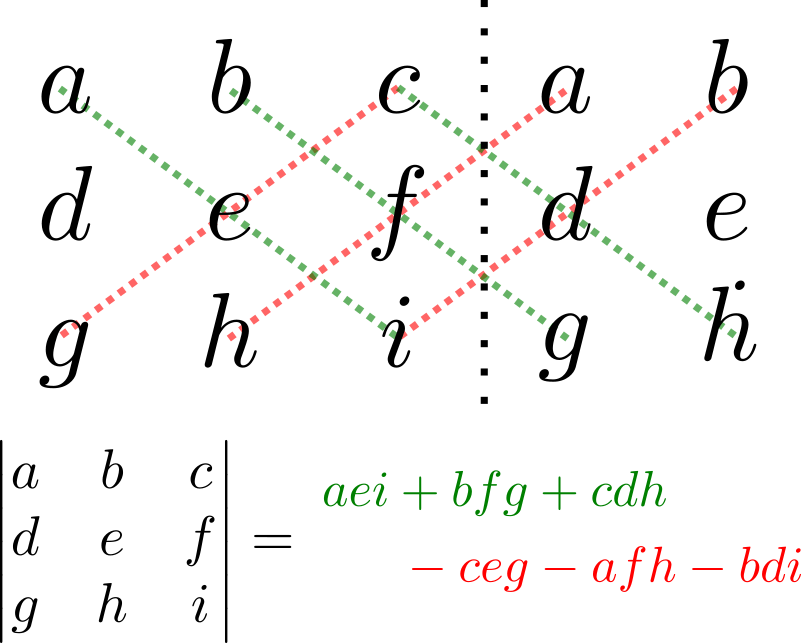

Para calcular el determinante de una matriz en $M_3(F)$ por definición, digamos de $A=\begin{pmatrix}a&b&c\\ d&e&f\\ g&h&i\end{pmatrix}$, tenemos que hacer una suma de $3!=6$ términos. Si se hacen las cuentas de manera explícita, el valor que se obtiene es $$aei+bfg+cdh-ceg-afh-bdi.$$

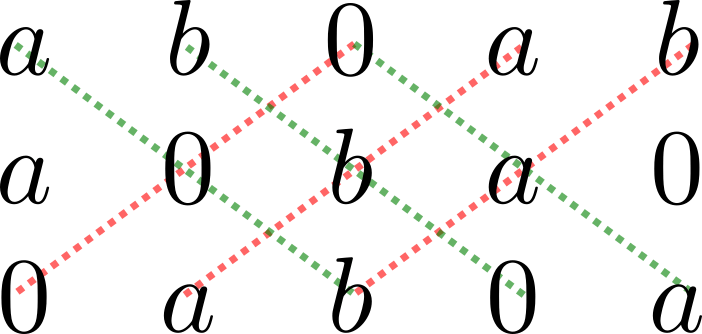

Esto se puede recordar mediante el siguiente diagrama, en el cual se ponen la primera y la segunda columna de nuevo, a la derecha. Las diagonales hacia abajo son términos positivos y las diagonales hacia arriba son términos negativos.

Veamos un ejemplo de un problema en el que se puede aprovechar esta técnica.

Problema. Determina para qué reales $a,b,c$ se tiene que los vectores $(a,b,0)$, $(a,0,b)$ y $(0,a,b)$ son una base de $\mathbb{R}^3$.

Solución. Para que estos vectores sean una base de $\mathbb{R}^3$, basta con que sean linealmente independientes, pues son $3$. Como hemos visto en entradas anteriores, para que sean linealmente independientes, es necesario y suficiente que el determinante de la matriz $\begin{pmatrix}a&b&0\\ a&0&b\\ 0&a&b\end{pmatrix}$ sea distinto de cero.

Usando la técnica de arriba, hacemos siguiente diagrama:

De aquí, vemos que el determinante es $$0+0+0-0-a^2b-ab^2=-ab(a+b).$$ Esta expresión es igual a cero si $a=0$, si $b=0$ o si $a+b=0$. En cualquier otro caso, el determinante no es cero, y por lo tanto los vectores forman una base.

$\triangle$

Ten mucho cuidado. Esta técnica no funciona para matrices de $4\times 4$ o más. Hay una forma sencilla de convencerse de ello. Por ejemplo, el determinante de una matriz de $4\times 4$ debe tener $4!=24$ sumandos. Si intentamos copiar la técnica de arriba, tendremos solamente $8$ sumandos ($4$ en una diagonal y $4$ en otra). Para cuando tenemos matrices de $4\times 4$ o más, tenemos que recurrir a otras técnicas.

Reducción gaussiana para determinantes

Cuando vimos el tema de sistemas de ecuaciones hablamos del algoritmo de reducción gaussiana, y vimos que este siempre lleva una matriz en $M_{m,n}(F)$ a su forma escalonada reducida mediante operaciones elementales. Cuando aplicamos el algoritmo a matrices en $M_n(F)$, siempre llegamos a una matriz triangular, en donde sabemos fácilmente calcular el determinante: es simplemente el producto de las entradas en la diagonal. Nota cómo lo anterior también se cumple para las matrices diagonales, pues son un caso particular de matrices triangulares.

Por esta razón, es fundamental para el cálculo de determinantes saber qué le hacen las operaciones elementales al determinante de una matriz.

Teorema. Las operaciones elementales tienen el siguiente efecto en el determinante de una matriz $A$:

- Si todos los elementos de un renglón o columna de $A$ se multiplican por $\lambda$, entonces el determinante se multiplica por $\lambda$.

- Cuando se intercambian dos renglones o columnas de $A$, el determinante se multiplica por $-1$.

- Si a un renglón de $A$ se le suma un múltiplo escalar de otro renglón, entonces el determinante no cambia. Sucede algo análogo para columnas.

Demostración. El punto $1$ ya lo demostramos en la entrada anterior, en donde vimos que el determinante es homogéneo.

Para los puntos $2$ y $3$, usemos que si $e_1,\ldots e_n$ es la base canónica de $F^n$, el determinante de una matriz con renglones $R_1,\ldots,R_n$ es $$\det_{(e_1,\ldots,e_n)}(R_1,\ldots,R_n).$$

Intercambiar los renglones $i$ y $j$ es hacer $\det_{(e_1,\ldots,e_n)}(R_{\sigma(1)},\ldots,R_{\sigma(n)})$ para la transposición $\sigma$ que intercambia $i$ y $j$. Como el determinante es antisimétrico y $\sigma$ tiene signo $-1$, obtenemos la conclusión.

Hagamos ahora el tercer punto. Tomemos $i\neq j$ y un escalar $\lambda$. Si al $i$-ésimo renglón de $A$ le sumamos $\lambda$ veces el $j$-ésimo renglón de $A$, esto es lo mismo que multiplicar a $A$ por la izquierda por la matriz $B$ que tiene unos en la diagonal y $\lambda$ en la entrada $(i,j)$. La matriz $B$ es triangular, de modo que su determinante es el producto de las entradas, que es $1$. De esta forma, $$\det(BA)=\det(B)\det(A)=\det(A).$$

$\square$

Así, una estrategia para calcular el determinante de una matriz es hacer reducción gaussiana hasta llegar a una matriz diagonal (incluso es suficiente que sea triangular superior) de determinante $\Delta$. Si en el camino se hicieron $r$ intercambios de renglones y se multiplicaron los renglones por escalares $\lambda_1,\ldots,\lambda_s$, entonces el determinante de $A$ será $$\frac{(-1)^r \Delta}{\lambda_1\cdot\ldots\cdot \lambda_s}.$$

Otras propiedades para calcular determinantes

Aquí recolectamos otras propiedades de determinantes que pueden ayudar a calcularlos. Ya mostramos todas ellas, salvo la número $2$. Esta la mostramos después de la lista.

- Si se descompone una columna de una matriz como suma de dos columnas, entonces el determinantes es la suma de los determinantes en los que ponemos cada columna en vez de la original.

- Si $A$ es una matriz en $M_n(\mathbb{C})$, entonces el determinante de la matriz conjugada $\overline{A}$ es el conjugado del determinante de $A$.

- El determinante es multiplicativo.

- Si $A$ es una matriz en $M_n(F)$, el determinante de $\lambda A$ es $\lambda^n$ veces el determinante de $A$.

- El determinante de una matriz triangular es el producto de sus entradas en la diagonal.

- El determinante de una matriz invertible es el inverso multiplicativo del determinante de la matriz.

- Una matriz tiene el mismo determinante que su transpuesta.

Proposición. Si $A$ es una matriz en $M_n(\mathbb{C})$, entonces el determinante de la matriz conjugada $\overline{A}$ es el conjugado del determinante de $A$.

Demostración. La conjugación compleja abre sumas y productos. Aplicando esto repetidas veces obtenemos la siguiente cadena de igualdades:

\begin{align*}

\overline{\det(A)}&=\overline{\sum_{\sigma \in S_n} \text{sign}(\sigma)a_{1\sigma(1)}\cdot\ldots\cdot a_{n\sigma(n)}}\\

&=\sum_{\sigma \in S_n} \overline{\text{sign}(\sigma)a_{1\sigma(1)}\cdot\ldots\cdot a_{n\sigma(n)}}\\

&=\sum_{\sigma \in S_n} \text{sign}(\sigma)\overline{a_{1\sigma(1)}}\cdot\ldots\cdot \overline{a_{n\sigma(n)}}\\

&=\det(\overline{A}).

\end{align*}

$\square$

Hay una última técnica que es fundamental para el cálculo de determinantes: la expansión de Laplace. En algunos textos incluso se usa para definir el determinante. Probablemente la conoces: es la que consiste en hacer el determinante «con respecto a una fila o columna» y proceder de manera recursiva. Hablaremos de ella más adelante y veremos por qué funciona.

Dos problemas de cálculo de determinantes

Problema 1. Considera la matriz $$A=\begin{pmatrix}5& 1 & 2& 0 \\ 0 & 1 & -1 & 2 \\ 0 & 0 & 5 & 2\\ -1 & -3 & 0 & 1\end{pmatrix}.$$ Calcula los siguientes determinantes:

- $\det A$

- $\det(^t A)$

- $\det(A^{-1})$

- $\det(^t A A)$

- $\det(-2A)$

Solución. Hagamos primero el determinante de la matriz $A$. Para ello, haremos operaciones elementales como sigue

\begin{align*}

&\begin{pmatrix}5& 1 & 2& 0 \\ 0 & 1 & -1 & 2 \\ 0 & 0 & 5 & 2\\ -1 & -3 & 0 & 1\end{pmatrix}\\

\to&\begin{pmatrix}5& 1 & 2& 0 \\ 0 & 1 & -1 & 2 \\ 0 & 0 & 5 & 2\\ 0 & -\frac{14}{5} & \frac{2}{5} & 1\end{pmatrix}\\

\to &\begin{pmatrix}5& 1 & 2& 0 \\ 0 & 1 & -1 & 2 \\ 0 & 0 & 5 & 2\\ 0 & 0 & -\frac{12}{5} & \frac{33}{5}\end{pmatrix}\\

\to& \begin{pmatrix}5& 1 & 2& 0 \\ 0 & 1 & -1 & 2 \\ 0 & 0 & 5 & 2\\ 0 & 0 & 0 & \frac{189}{25}\end{pmatrix}.

\end{align*}

En el primer paso sumamos $1/5$ veces el primer renglón al último. Luego, sumamos $14/5$ veces el segundo renglón al último. Finalmente, sumamos $12/25$ veces el tercer renglón al último. De esta forma, nunca cambiamos el determinante de la matriz. Así, del determinante de $A$ es el mismo que el de la matriz final, que por ser triangular superior es el producto de las entradas en su diagonal. De este modo, $$\det(A) = 5\cdot 1 \cdot 5 \cdot \frac{189}{5} = 189.$$

El determinante de una matriz es igual al de su transpuesta, así que $\det(^t A)=\det(A)$. El determinante $\det(A^{-1})$ es el inverso multiplicativo de $\det(A)$, así que es $\frac{1}{189}$.

Como el determinante es multiplicativo, $$\det({^tA}A)=\det({^tA})\det(A)=189\cdot 189=35721.$$

Finalmente, usando que el determinante es homogéneo y que estamos en $M_4(\mathbb{R})$, tenemos que

\begin{align*}

\det(-2A)&=(-2)^4\det(A)\\

&=16\cdot 189\\

&=3024.

\end{align*}

$\triangle$

Problema 2. Sean $a,b,c$ números complejos. Calculando el determinante de la matriz $$A=\begin{pmatrix}a&b&c\\ c&a&b\\ b&c&a\end{pmatrix}$$ en $M_3(\mathbb{C})$ de dos formas distintas, muestra que $$a^3+b^3+c^3-3abc=(a+b+c)(a^2+b^2+c^2-ab-bc-ca).$$

Solución. Usando la técnica para determinantes de $3\cdot 3$ tenemos que por un lado,

\begin{align*}

\det(A) &= a^3 + b^3 + c^3 – abc – bca – cab\\

&=a^3+b^3+c^3-3abc.

\end{align*}

Por otro lado, el determinante no cambia si al primer renglón le sumamos los otros dos, así que el determinante de $A$ también es $$\begin{vmatrix}a+b+c&a+b+c&a+b+c\\ c&a&b\\ b&c&a\end{vmatrix}.$$ Como el determinante es homogéneo, podemos factorizar $a+b+c$ de la primera entrada para obtener que $$\det(A)=(a+b+c)\begin{vmatrix}1&1&1\\ c&a&b\\ b&c&a\end{vmatrix}.$$

Aplicando de nuevo la fórmula de determinantes de $3\times 3$, tenemos que $$\begin{vmatrix}1&1&1\\ c&a&b\\ b&c&a\end{vmatrix} = a^2+b^2+c^2-ab-bc-ca.$$

Concluimos entonces que $$\det(A)=(a+b+c)(a^2+b^2+c^2-ab-bc-ca).$$ Igualando ambas expresiones para $\det(A)$ obtenemos la identidad deseada.

$\triangle$

Más adelante…

En esta entrada vimos varias formas para calcular el determinante de una matriz. Cuando nos enfrentemos con un problema que requiere el cálculo de un determinante, tenemos que elegir la que más nos convenga (o la que requiera menos pasos). La mejor forma de desarrollar un poco de «intuición» al momento de elegir el mejor método para calcular determinantes es haciendo ejercicios.

A continuación pondremos en práctica lo que aprendimos en esta entrada haciendo varios ejercicios de cálculo de determinantes.

Tarea moral

A continuación hay algunos ejercicios para que practiques los conceptos vistos en esta entrada. Te será de mucha utilidad intentarlos para entender más la teoría vista.

- Sea $\alpha$ un número real. Encuentra el determinante de la matriz $$\begin{pmatrix}\sin \alpha & \cos \alpha \\ -\cos \alpha & \sin \alpha \end{pmatrix}.$$

- Determina para qué valores de $a$ la matriz $$\begin{pmatrix} a & 0 & a & 0 & a \\0 & a & 0 & a & 0 \\ 0 & 0 & a & 0 & 0 \\ 0 & a & 0 & a & 0 \\ a & 0 & a & 0 & a \end{pmatrix}$$ es invertible.

- Encuentra el determinante de la matriz $$\begin{pmatrix} 2 & 1 & 0 & 0 & 0 \\0 & 2 & 1 & 0 & 0 \\ 0 & 0 & 2 & 1 & 0 \\ 0 & 0 & 0 & 2 & 1 \\ 1 & 0 & 0 & 0 & 2 \end{pmatrix}.$$

- Sea $x$ un número complejo. Muestra que el determinante de la matriz $$\begin{pmatrix}3x^2-6x+5&2x^2-4x+2&x^2-2x\\ 2x^2-4x+2&2x^2+2x+1&x^2-x\\ x^2-2x&x^2-x&x^2\end{pmatrix}$$ es $x^6$. Sugerencia. Hay una solución simple, factorizando a la matriz como el producto de dos matrices triangulares, una superior y una inferior, una transpuesta de la otra.

- Muestra que si $A=\begin{pmatrix}0& 1 \\ 1 & 1\end{pmatrix}$, entonces $$A^n=\begin{pmatrix} F_{n-1} & F_n\\ F_n & F_{n+1}\end{pmatrix},$$ donde $\{F_n\}$ es la sucesión de Fibonacci. Muestra que para los números de Fibonacci se satisface que $$F_{2n}=F_n(F_{n+1}+F_{n-1}).$$

Entradas relacionadas

- Ir a Álgebra Lineal I

- Entrada anterior del curso: Problemas de definición y propiedades de determinantes

- Siguiente entrada del curso: Problemas de cálculo de determinantes

Agradecimientos

Trabajo realizado con el apoyo del Programa UNAM-DGAPA-PAPIME PE104721 «Hacia una modalidad a distancia de la Licenciatura en Matemáticas de la FC-UNAM»