Introducción

Un ejemplo importante de transformaciones ortogonales

Una clase importante de transformaciones ortogonales es la de las simetrías ortogonales. Sea $V$ un espacio euclidiano y $W$ un subespacio de $V$. Entonces $V=W\oplus W^\bot$, por lo que podemos definir la simetría $s_W$ sobre $W^\bot$ con respecto a $W$. Recuerda que cualquier $v\in V$ se puede escribir como $v=w+w^\bot$, con $(w,w^\bot)\in W\times W^\bot$, entonces $$s_W(v)=w-w^\bot,$$ de manera que $s_W$ fija puntualmente a $W$ y $-s_W$ fija puntualmente a $W^\bot$.

Para garantizar que $s_W$ es una transformación ortogonal, bastará con verificar que $||s_W(v)||=||v||$ para todo $v\in V$, o equivalentemente

$$||w-w^\bot||=||w+w^\bot|| \hspace{1.5mm}\forall (w,w^\bot)\in W\times W^\bot.$$ Pero por el teorema de Pitágoras se tiene que si elevemos ambos lados a cuadrado se obtiene $||w||^2+||w^\bot||^2$ y se sigue el resultado deseado.

Las simetrías ortogonales se pueden distinguir fácilmente entre las transformaciones ortogonales, pues estas son precisamente las transformaciones ortogonales auto-adjuntas.

Caracterización sobre bases ortonormales

Problema. Sea $V$ un espacio euclidiano y $T:V\to V$ una tranformación lineal. Las siguientes afirmaciones son equivalentes:

- $T$ es ortogonal.

- Para cualquier base ortonormal $e_1,\dots ,e_n$ de $V$, los vectores $T(e_1),\dots ,T(e_n)$ forman una base ortonormal de $V$.

- Existe una base ortonormal de $e_1,\dots ,e_n$ de $V$ tal que $T(e_1),\dots ,T(e_n)$ es una base ortonormal de $V$.

Solución. Supongamos que 1. es cierto y sea $e_1,\dots ,e_n$ una base ortonormal de $V$. Entonces para cada $i,j\in[1,n]$ tenemos

$$\langle T(e_i),T(e_j) \rangle =\langle e_i,e_j \rangle.$$

Se sigue que $T(e_1),\dots ,T(e_n)$ es una familia ortonormal, y como $dim V=n$, entonces es una base ortonormal de $V$. Entonces 1. implica 2. y claramente 2. implica 3.

Supongamos que 3. es cierto. Sea $x\in V$ y escribamos $x=x_1e_1+x_2e_2+\dots +x_ne_n$. Como $e_1,\dots ,e_n$ y $T(e_1),\dots ,T(e_n)$ son bases ortonormales de $V$, tenemos

$$||T(x)||^2=||x_1T(e_1)+\dots +x_nT(e_n)||^2=x_1^2+\dots +x_n^2=||x||^2.$$

Por lo tanto $||T(x)||=||x||$ para todo $x\in V$ y $T$ es ortogonal.

$\square$

El grupo de transformaciones ortogonales en el plano

Definición. Diremos que una isometría $T$ es una isometría positiva si $\det T=1$. Por otro lado, diremos que $T$ es una isometría negativa si $\det T=-1$ En términos geométricos, las isometrías positivas preservan la orientación del espacio, mientras que las isometrías negativas la invierten.

Definición. Sea $B=\{e_1,\dots,e_n\}$ una base ortonormal de un espacio euclidiano $V$. Si $B’=\{f_1,\dots,f_n\}$ es otra base ortonormal de $V$, entonces la matriz de cambio de base de $B$ a $B’$ es ortogonal y por lo tanto $\det P\in\{-1,1\}$. Diremos que $B’$ está orientada positivamente con respecto a $B$ si $\det P=1$ y conversamente diremos que $B’$ está orientada negativamente con respecto a $B$ si $\det P=-1$.

Si $V=\mathbb{R}^n$ está equipado con el producto interior usual, entonces siempre tomamos como $B$ a la base canónica y sólo decimos que una base ortonormal es positiva o negativa.

Observación. El polinomio característo de la matriz

$$\begin{pmatrix}

I_p & 0 & 0 & \dots & 0\\

0 & -I_q & 0 & \dots & 0\\

0 & 0 & R_{\theta_1} & \dots & 0\\

\vdots & \vdots & \vdots &\ddots & \vdots\\

0 & 0 & 0 &\dots & R_{\theta_k}

\end{pmatrix}$$

es

$$(x-1)^p(x+1)^q\cdot\displaystyle\prod_{i=1}^k (x^2-2\cos\theta_i x+1).$$

Las raíces complejas del polinomio $x^2-2\cos\theta_i x+1$ son $e^{i\theta}$ y $e^{-i\theta}$, y tienen modulo $1$. Por lo tanto, todos los eigenvalores complejos de una matriz ortogonal tienen módulo $1$.

Estudiando el grupo ortogonal en dimensiones pequeñas

Empezamos analizando el caso de dimensión $2$. Sea $A\in M_2(\mathbb{R})$ una matriz dada por

$$A=\begin{pmatrix}

a & b\\

c & d\end{pmatrix}$$ que satisface $A^tA=I_2$. Sabemos que $\det A\in\{-1,1\}$, así que consideramos ambos casos.

Si $\det A=1$, entonces la inversa de $A$ simplemente es

$$A^{-1}=\begin{pmatrix}

d & -b\\

-c & a\end{pmatrix}$$

y como $A$ es ortogonal, entonces $A^{-1}=\hspace{.5mm}^tA$, por lo que $a=d$ y $b=-c$, lo que nos dice que $A$ es de la forma

$$A=\begin{pmatrix}

a & -c\\

c & a\end{pmatrix}.$$

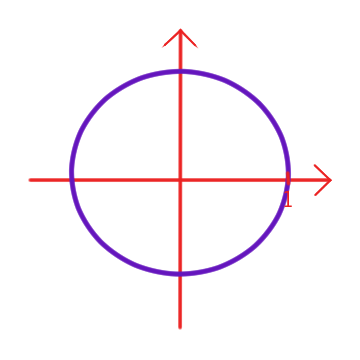

Más aún, tenemos que $a^2+c^2=1$, por lo que existe un único $\theta\in(-\pi,\pi]$ tal que $A=\cos\theta$ y $c=\sin\theta$. Por lo tanto

$$A=R_{\theta}=\begin{pmatrix}

\cos\theta & -\sin\theta\\

\sin\theta & \cos\theta \end{pmatrix}.$$

La transformación lineal correspondiente es

\begin{align*}

T:\mathbb{R}^2&\to\mathbb{R}^2\\

(x,y)&\mapsto (\cos\theta x – \sin\theta y, \sin\theta x+ \cos\theta y)

\end{align*}

y geométricamente corresponde a una rotación de ángulo $\theta$. Además

\begin{equation}\label{rot}

R_{\theta_1}\cdot R_{\theta_2}=R_{\theta_1+\theta_2}=R_{\theta_2}\cdot R_{\theta_1}.

\end{equation}

Una consecuencia importante es que la matriz asociada a $T$ con respecto a cualquier base ortonormal positiva de $\mathbb{R}^2$ aún es $R_\theta$, pues la matriz de cambio de base de la base canónica a la nueva base ortonormal positiva sigue siendo una rotación. Análogamente, si en el argumento anterior tomamos una base ortonormal negativa, entonces la matriz asociada a $T$ es $R_{-\theta}$. La relación \eqref{rot} también muestra que para calcular el ángulo de la composición de dos rotaciones basta con tomar la suma de los ángulos y restar un múltiplo adecuado de $2\pi$ tal que el ángulo obtenido quede en el intervalo $(-\pi,\pi]$.

Si $\det A=-1$. Entonces

$$A^{-1}=\begin{pmatrix}

-d & b\\

c & -a\end{pmatrix}$$ y como $A$ es ortogonal, entonces $d=-a$ y $b=c$. También tenemos que $a^2+b^2=1$, por lo que existe un único número real $\theta\in(-\pi,\pi]$ tal que $a=\cos\theta$ y $b=\sin\theta$. Entonces

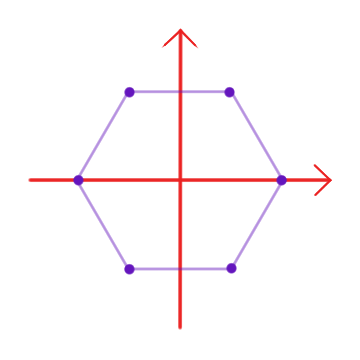

$$A=S_\theta:=\begin{pmatrix}

\cos\theta & \sin\theta\\

\sin\theta & -\cos\theta \end{pmatrix}.$$

Notemos que $S_\theta$ es simétrica y ortogonal, por lo tanto $S_\theta^2=I_2$ y que la transformación correspondiente es

\begin{align*}

T:\mathbb{R}^2&\to\mathbb{R}^2\\

(x,y)&\mapsto (cos\theta x+\sin\theta y, \sin \theta x-\cos\theta y)

\end{align*}

es una simetría ortogonal. Para encontrar la recta con respecto a la cual $T$ es una simetría ortogonal, bastará con resolver el sistema $AX=X$. El sistema es equivalente a

$$\sin\left(\frac{\theta}{2}\right)\cdot x=\cos \left(\frac{\theta}{2}\right)\cdot y$$ y por lo tanto la recta $AX=X$ está generada por el vector

$$e_1=\left( \cos\left(\frac{\theta}{2}\right), \sin\left(\frac{\theta}{2}\right) \right)$$ y la correspondiente recta ortogonal está generada por el vector

$$e_2=\left(-\sin\left(\frac{\theta}{2}\right),\cos\left(\frac{\theta}{2}\right)\right),$$

y los vectores $e_1,e_2$ forman una base ortonormal de $\mathbb{R}^2$ para la cual la matriz asociada a $T$ es

$$\begin{pmatrix}

1 & 0\\

0 & -1\end{pmatrix}$$

y además $$S_{\theta_1}\cdot S_{\theta_2}=R_{\theta_1-\theta_2}$$

lo que significa que la composición de dos simetrías ortogonales es una rotación. Similarmente tenemos que

$$S_{\theta_1}R_{\theta_2}\hspace{3mm} R_{\theta_1}S_{\theta_2}=S_{\theta_1+\theta_2},$$

por lo que la composición de una rotación y una simetría ortogonal es una simetría ortogonal.

Gracias a todo lo anterior, estamos listos para enunciar el siguiente teorema:

Teorema. Sea $A\in M_2(\mathbb{R})$ una matriz ortogonal.

- Si $\det A=1$, entonces

$$A=R_\theta=\begin{pmatrix}

\cos\theta & -\sin\theta\\

\sin\theta &\cos\theta\end{pmatrix}$$

para único número real $\theta\in(-\pi,\pi]$, y la correspondiente transformación lineal $T$ sobre $\mathbb{R}^2$ es una rotación de ángulo $\theta$. Cualesquiera dos matrices de esa forma conmutan y la matriz asociada a $T$ con respecto a cualquier base ortonormal positiva de $\mathbb{R}^2$ es $R_\theta$. - Si $\det A=-1$, entonces

$$A=S_\theta=\begin{pmatrix}

\cos\theta & \sin\theta\\

\sin\theta &-\cos\theta\end{pmatrix}$$

para un único número real $\theta\in(-\pi,\pi]$. La matriz $A$ es simétrica y la correspondiente transformación lineal sobre $\mathbb{R}^2$ es la simetría ortogonal con respecto a la recta generada por el vector $\left(\cos\left(\frac{\theta}{2}\right),\sin\left(\frac{\theta}{2}\right)\right)$.

El grupo de transformaciones ortogonales en el espacio

En la entrada anterior estudiamos el grupo de transformaciones ortogonales en dimensión $2$.

Ahora estudiaremos el caso $\dim V=3$, para esto haremos uso del teorema de clasificación de la entrada anterior, así como el estudio que hicimos para el caso de dimensión $2$. Siguendo la misma idea que desarrollamos en el teorema de clasificiación, consideramos enteros $p,q,k$ tales que $$p+q+2k=3,$$ por lo que necesariamente $p\neq 0$ o $q\neq 0$. También podemos probar esto de manera máss directa, observando que el polinomio caracterísitico de $T$ es de grado $3$, por lo que debe tener una raíz real, y por ende un eigenvalor real, el cual será igual a $1$ o $-1$, pues tiene módulo $1$.

Intercambiando $T$ con $-T$ se tiene que simplemente se intercambian los papeles de $p$ y $q$. Supongamos que $p\geq 1$, esto significa que $T$ tiene al menos un punto fijo $v$. Entonces $T$ fija la recta $D=span (v)$ e induce una isometría sobre el plano ortogonal a $D$. Esta isometría se puede clasificar con el último teorema de la entrada anterior. Por lor tanto, hemos reducido el caso de dimensión $3$ al caso de dimensión $2$. Podemos ser más explicitos si consideramos los siguientes casos.

- $id\in\{T,-T\}$.

- Tenemos que $\dim \ker (T-id)=2$. Si $e_2,e_1$ es una base ortonormal del plano $\ker (T-id)=2$ y completamos a una base ortonormal de $V$ $\{e_1,e_2,e_3\}$, entonces $T$ fija puntualmente al subespacio generado por $e_2,e_3$ y deja invariante a la recta generada por $e_1$. Por lo tanto la matriz asociada a $T$ con respecto a la base ortonormal es

$$ \begin{pmatrix}

t & 0 & 0\\

0 & 1 & 0\\

0 & 0 & 1

\end{pmatrix}$$

para algun número real $t$, el cual forzosamente es $-1$, pues sabemos que debe ser $1$ o $-1$, pero si fuera $1$, entonces $T$ sería la indentidad. Por lo tanto $T$ es una simetría ortogonal con respecto al plano $\ker (T-id)$. Además, $\det T=-1$, por lo que $T$ es una isometría negativa. - Tenemos que $\dim\ker (T-id)$ es la recta generado por algún vector $e_1$ de norma $1$. Completamos $e_1$ a una base ortonormal $\{e_1,e_2,e_3\}$ . Entonces la isometría $T$ inducida sobre es subespacio generado por $\{e_2,e_3\}$ no tiene puntos fijos, ya que todos los puntos fijos de $T$ están sobre $span(e_1)$, por lo tanto $T$ es una rotación de ángulo $\theta$, para un único $\theta\in(-\pi,\pi]$. Además, la matriz asociada a $T$ con respecto a la base ortonormal es

$$ \begin{pmatrix}

1 & 0 & 0\\

0 & \cos\theta & -\sin\theta\\

0 & \sin\theta & \cos\theta

\end{pmatrix}.$$

Diremos que $T$ es la rotación de ángulo $\theta$ alrededor del eje $\mathbb{R}e_1$. Notemos que $\det T=1$, por lo que $T$ es una isometría positiva. Además, el ángulo $\theta$ satisface $$1+2\cos\theta=Tr(A),$$,aunque, al ser el coseno una función par, $-\theta$ también satisface la ecuación anterior. Para encontrar a $\theta$ necesitamos hallar a $\sin\theta$. Para ello verificamos que

$$\det_{(e_1,e_2,e_3)}(e_1,e_2,T(e_2))=\begin{vmatrix}

1 & 0 & 0\\

0 & 1 & \cos\theta\\

0 & 0 & \sin\theta

\end{vmatrix}=\sin\theta.$$ - Supongamos que $\ker(T-id)=\{0\}$. Una posibilidad es que $T=-id$. Supongamos que $T\neq id $. Como $T$ o $-T$ tienen un punto fijo y $T$ tiene puntos fijos, entonces necesariamente $-T$ tiene un punto fijo. Sea $e_1$ un vector de norma $1$ fijado por $-T$, por lo tanto $T(e_1)=-e_1$. Completando $e_1$ a una base ortonormal de $V$ dando un argumento similar al del caso anterior, obtenemos que la matriz asociada a $T$ con respecto a la base ortonormal es

$$\begin{pmatrix}1- & 0 & 0\\

0 & \cos\theta & -\sin\theta\\

0 & \sin\theta & \cos\theta

\end{pmatrix}=R_\theta \cdot \begin{pmatrix}

1 & 0 & 0\\

0 & \cos\theta & -\sin\theta\\

0 & \sin\theta & \cos\theta

\end{pmatrix}$$

para algún $\theta \in (-\pi,\pi]$. Por lo tanto $T$ es la composición de una rotación de ángulo $\theta$ y una simetría ortogonal con respecto al eje de rotación. También notemos que $\det T=-1$, por lo que $T$ es una isometría negativa.

También podemos mirarlo desde el punto de vista de las matrices. Consideremos una matriz ortogonal $A\in M_3(\mathbb{R})$ y la transformación lineal asociada

\begin{align*}

T:V&\to V\\

X&\mapsto AX

\end{align*}, donde $V=\mathbb{R}^3$ está equipado con el producto interior usual. Excluiremos los casos triviales $A=\pm I_3$. Para estudiar la isometría $T$, primero revisamos si esta es positiva o negativa, calculando el determinante.

Supongamos que $T$ es positiva. Ahora veremos si $A$ es simétrica. Para ellos consideremos los siguentes dos casos: - Si $A$ es simétrica, entonces $A^2=I_3$ (pues $A$ es ortogonal y simétrica) y por lo tanto $T$ es una simetría ortogonal. Afirmamos que $T$ es una simetría ortogonal con respecto a una recta. En efecto, como $A^2=I_3$, todos los eigenvalores de $A$ son $1$ o $-1$. Más aún, los eigenvalores no son iguales, ya que estamos excluendo los casos $A=\pm I_3$, y el producto de ellos es 1, pues $\det A=1$. Por lo tanto, un eigenvalor es igual a $1$ y los otros dos son iguales a $-1$. Se sigue que la matriz asociada a $T$ con respecto a la base ortonormal $\{e_1,e_2,e_3\}$ es

$$\begin{pmatrix}

1 & 0 & 0\\

0 & -1 & 0\\

0 & 0 & -1

\end{pmatrix}$$ y $T$ es la simetría ortogonal con respecto a la recta generado por $e_1$. Para encontrar esta recta de manera explícita, necesitamos calcular $\ker(A-I_3)$ resolviendo el sistema $AX=X$. - Si $A$ no es simétrica, entonces $A$ es una rotación de ángulo $\theta$ ara un único $\theta\in(-\pi,\pi]$. Podemos encontrar el eje de rotación resolviendo el sistema $AX=X$: si $Ae_1=e_1$ para algún vector $e_1$, entonces el eje de rotación está generado por $e_1$. Para encontrar el ángulo de rotación usamos la siguiente ecuación

\begin{equation}\label{angulo}

1+2\cos\theta=Tr(A),

\end{equation}

la cual determina a $\theta$ en valor absoluto (pues $\theta$ y $-\theta$ son soluciones por la paridad del coseno). Ahora escogemos un vector $e_2$ ortogonal a $e_1$ y de norma $1$ y definimos $e_3=(u_2v_3-u_3v_2,u_3v_1-u_1v_3,u_1v_2-u_2v_1)$, donde $e_1=(u_1,u_2,u_3)$ y $e_2=(v_1,v_2,v_3)$. Entonces $e_1,e_2,e_3$ es una base ortonormal positiva de $\mathbb{R}^3$ y $\det_{(e_1,e_2,e_3)}(e_1,e_2,Ae_2)$ nos da el valor de $\sin\theta$, con lo cual podremos determinar a $\theta$ de manera única. En la práctica bastará con encontrar el signo de $\det_{(e_1,e_2,e_3)}(e_1,e_2,Ae_2)$, ya que esto nos dará el signo de $\sin\theta$, lo cual determina $\theta$ de manera única gracias a la ecuación \eqref{angulo}.

Finalmente, si se supone que $T$ es negativa, entoces $-T$ es positiva y por lo tanto todo el estudio que acabamos de hacer se puede aplicar a $-T$.

Para finalizar, veremos un ejemplo concreto.

Ejemplo. Demuestra que a matriz

$$A=\frac{1}{3}\begin{pmatrix}

2 & 2 & 1\\

-2 & 1 & 2\\

1 & -2 & 2

\end{pmatrix}$$ es ortogonal y estudia su isometría correspondiente en $\mathbb{R}^3$.

Solución. El cálculo para verificar que $A$ es ortogonal es muy sencillo y se deja como tarea moral. Luego vemos que $\det A=1$, por lo que la isometría asociada es positiva. Como $A$ no es simétrica, se sigue que $T$ es una rotación. Para encontrar el eje necesitamos resolver el sistema $AX=X$, el cual es equivalente a

\begin{align*}

\begin{cases}

2x+2y+z &= 3x\\

-2x+y+2z &=3y\\

x-2y+2z &=3z

\end{cases}

\end{align*} y entonces $x=z$ y $y=0$. Por lo tanto, el eje de rotación está generado por el vector $(1,0,1)$. Normalizandolo obtenemos el vector

$$e_1=\frac{1}{\sqrt{2}}(1,0,1),$$ que genera al eje de $T$.

sea $\theta$ el ángulo de rotación, tal que

$$1+2\cos\theta=Tr(A)=\frac{5}{3},$$ y por lo tanto

$$cos\theta=\frac{1}{3}.$$

Falta determinar el signo de $\sin \theta$. Para ello, escogemos un vector ortogonal a $e_1$, digamos $$e_2=(0,1,0)$$ y calculamos el signo de

$$\det (e_1,e_2,Ae_2)=\frac{1}{3\sqrt{2}}\begin{vmatrix}

1 & 0 & 2\\

0 & 1 & 0\\

1 & 0 & -2

\end{vmatrix}=-\frac{4}{3\sqrt{2}}<0,$$ por lo que $\sin\theta<0$ y finalmente $\theta=-\arccos\frac{1}{3}$.

$\square$

Más adelante…

Tarea moral

- Verifica que la matriz $A$ del ejemplo anterior es ortogonal.

- Encuentra la matriz asociada a la simetría ortogonal en $\mathbb{R}^3$ con respecto a la recta generada por el vector $(1,2,3)$.

- Encuentra la matriz asociada a la simetría ortogonal en $\mathbb{R}^3$ con respecto al plano generad por los vectores $(1,1,1)$ y $(0,1,0)$.

- Sea $V=\mathbb{R}^3$.¿En qué casos una rotación sobre $V$ conmuta con una simetríai ortogonal?

Entradas relacionadas

- Ir a Álgebra Lineal II

- Entrada anterior del curso:

- Siguiente entrada del curso: