Introducción

En entradas anteriores hablamos de transformaciones lineales, cómo actúan en conjuntos especiales de vectores y de cómo se pueden representar con matrices. Hablamos también de cómo cambiar de una base a otra y cómo usar esto para entender transformaciones en varias bases. Estamos listos para introducir un concepto fundamental de álgebra lineal, el de rango de una transformación lineal y de una matriz.

Antes de entrar en las definiciones formales, vale la pena hablar un poco de rango de manera intuitiva. Supongamos que $V$ es un espacio vectorial de dimensión $n$ y que $W$ es un espacio vectorial sobre el mismo campo que $V$. Una transformación lineal $T:V\to W$ puede «guardar mucha independencia lineal» o «muy poquita». Si $T$ es inyectiva, ya vimos antes que $T$ manda linealmente independientes a linealmente independientes. Si $T$ es la transformación $0$, entonces se «pierde toda la independencia».

El rango mide algo intermedio entre estos dos extremos. Mientras mayor sea el rango, más independencia lineal se preserva y viceversa. Si mantienes esta intuición en mente, varias de las proposiciones te resultarán más naturales.

Otro buen ejemplo para tener en mente es tomar una transformación lineal $T:\mathbb{R}^3\to \mathbb{R}^3$. Si es la transformación identidad, la base canónica se preserva. Si es la proyección al plano $xy$, entonces «perdemos» al vector $(0,0,1)$, pues se va al $(0,0,0)$. Si es la proyección al eje $x$, «perdemos» al $(0,1,0)$ y al $(0,0,1)$ pues ambos se van a $(0,0,0)$. Y si es la transformación $0$, perdemos a todos. El rango precisamente va a medir esto, y para estos ejemplos tendremos rango $3$, $2$, $1$ y $0$ respectivamente.

Rango para transformaciones lineales

Como en otras ocasiones, cuando hablemos de transformaciones lineales entre espacios vectoriales, serán sobre un mismo campo $F$.

Definición. Sean $V$ y $W$ espacios de dimensión finita. El rango de una transformación lineal $T:V\to W$ es la dimensión de la imagen de $T$, es decir, $$\rank(T)=\dim\Ima T.$$

Si $B$ es una base de $V$, entonces genera a $V$. La transformación $T$ es suprayectiva de $V$ a $\Ima T$, de modo que $T(B)$ es generador de $\Ima T$. De esta forma, para encontrar el rango de una transformación lineal $T:V\to W$ basta:

- Tomar una base $B$ de $V$.

- Aplicar $T$ a cada elemento de $B$.

- Determinar un conjunto linealmente independiente máximo en $T(B)$.

Para hacer este último paso, podemos poner a los vectores coordenada de $T(B)$ con respecto a una base de $W$ como los vectores fila de una matriz $A$ y usar reducción gaussiana. Las operaciones elementales no cambian el espacio generado por las filas, así que el rango de $T$ es el número de vectores fila no cero en la forma escalonada reducida $A_{\text{red}}$ de $A$.

Ejemplo. Encuentra el rango de la transformación lineal $T:\mathbb{R}^3\to M_{2}(\mathbb{R})$ que manda $(x,y,z)$ a $$\begin{pmatrix}x+y-z & 2x \\ 2y-2z & x+z-y\end{pmatrix}.$$

Solución. Tomemos $e_1,e_2,e_3$ la base canónica de $\mathbb{R}^3$. Tenemos que $T(e_1)=\begin{pmatrix}1 & 2\\ 0 & 1\end{pmatrix}$, $T(e_2)=\begin{pmatrix} 1 & 0 \\ 2 & -1\end{pmatrix}$ y $T(e_3)=\begin{pmatrix}-1 & 0\\ -2 & 1\end{pmatrix}$.

Tomando la base canónica $E_{11},E_{12},E_{21},E_{22}$ de $M_2(\mathbb{R})$, podemos entonces poner a las coordenadas de $T(e_1),T(e_2),T(e_2)$ como vectores fila de una matriz $$\begin{pmatrix}1 & 2 & 0 & 1\\ 1 & 0 & 2 & -1\\ -1& 0 & -2 & 1\end{pmatrix}.$$ Sumando la segunda fila a la tercera, y después restando la primera a la segunda,obtenemos la matriz $$\begin{pmatrix}1 & 2 & 0 & 1\\ 0 & -2 & 2 & -2\\ 0& 0 & 0 & 0\end{pmatrix}.$$ De aquí, sin necesidad de terminar la reducción gaussiana, podemos ver que habrá exactamente dos filas no cero. De este modo, el rango de la transformación es $2$.

$\triangle$

Propiedades del rango

Demostremos ahora algunas propiedades teóricas importantes acerca del rango de una transfromación lineal.

Proposición. Sean $U$, $V$ y $W$ espacios de dimensión finita. Sean $S:U\to V$, $T:V\to W$, $T’:V\to W$ transformaciones lineales. Entonces:

- $\rank(T)\leq \dim V$

- $\rank(T)\leq \dim W$

- $\rank(T\circ S)\leq \rank(T)$

- $\rank(T\circ S)\leq \rank(S)$

- $\rank(T+T’)\leq \rank(T) + \rank(T’)$

Demostración. (1) Pensemos a $T$ como una transformación $T:V\to \Ima(T)$. Haciendo esto, $T$ resulta ser suprayectiva, y por un resultado anterior tenemos que $\dim V\geq \dim \Ima T = \rank (T)$.

(2) Sabemos que $\Ima (T)$ es un subespacio de $W$, así que $\rank(T)=\dim \Ima T \leq \dim W$.

(3) La imagen de $T$ contiene a la imagen de $T\circ S$, pues cada vector de la forma $T(S(v))$ es de la forma $T(w)$ (para $w=S(v)$). Así, \begin{align*}\rank(T) &=\dim \Ima T \geq \dim \Ima T\circ S\\ &= \rank (T\circ S).\end{align*}

(4) La función $T\circ S$ coincide con la restricción $T_{\Ima S}$ de $T$ a $\Ima S$. Por el inciso (1), $\rank(T_{\Ima S})\leq \dim \Ima S = \rank(S)$, así que $\rank (T\circ S) \leq \rank(S)$.

(5) Tenemos que $\Ima (T+T’) \subseteq \Ima T + \Ima T’$. Además, por un corolario de la fórmula de Grassman, sabemos que

\begin{align*}

\dim (\Ima T + \Ima T’)&\leq \dim \Ima T + \dim \Ima T’\\

&= \rank(T) + \rank(T’).

\end{align*}

Así,

\begin{align*}

\rank(T+T’)&\leq \rank(\Ima T + \Ima T’)\\

&\leq \rank(T)+\rank(T’).

\end{align*}

$\square$

Proposición. Sean $R:U\to V$, $T:V\to W$ y $S:W\to Z$ transformaciones lineales con $R$ suprayectiva y $S$ inyectiva. Entonces $$\rank(S\circ T\circ R)=\rank (T).$$

Dicho de otra forma «composición por la izquierda con transformaciones inyectivas no cambia el rango» y «composición por la derecha con transformaciones suprayectivas no cambia el rango». Un corolario es «composición con transformaciones invertibles no cambia el rango».

Demostración. De la proposición anterior, tenemos que $\rank(S\circ T)\leq \rank (T)$. La restricción $S_{\Ima T}$ de $S$ a la imagen de $T$ es una transformación lineal de $\Ima T$ a $\Ima (S\circ T)$ que es inyectiva, de modo que $\dim \Ima T \leq \dim \Ima (S\circ T)$, que es justo $\rank(T)\leq \rank(S\circ T)$, de modo que tenemos la igualdad $\rank(S\circ T)=\rank (T)$.

Como $R$ es suprayectiva, $\Ima R= V$, de modo que $\Ima(S\circ T \circ R)=\Ima(S\circ T)$. Así, \begin{align*}\rank (S\circ T \circ R) &= \rank (S\circ T)\\&=\rank(T).\end{align*}

$\square$

Teorema de rango-nulidad

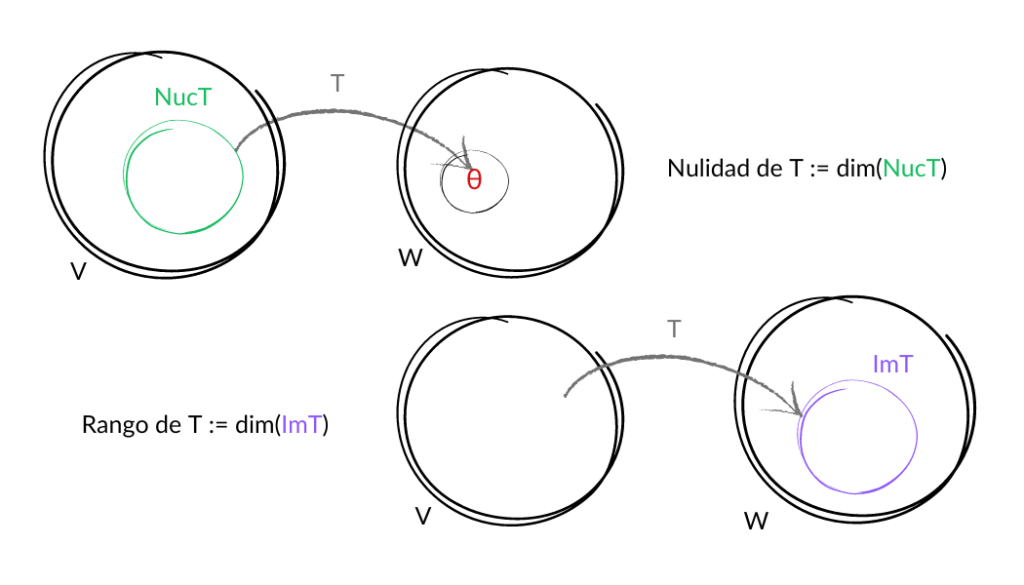

Una transformación lineal $T:V\to W$ determina automáticamente dos subespacios de manera natural: el kernel $\ker T$ y la imagen $\Ima T$. Resulta que las dimensiones de $\ker T$, de $\Ima T$ y de $V$ están fuertemente relacionadas entre sí.

Teorema. Sean $V$ y $W$ espacios de dimensión finita. Sea $T:V\to W$ una transformación lineal. Entonces $$\dim\ker T + \rank(T) = \dim V.$$

Demostración. Supongamos que $\dim V=n$ y $\dim \ker T = k$. Queremos mostrar que $\rank(T)=n-k$. Para ello, tomemos una base $B$ de $\ker T$ y tomemos $B’=\{v_1,\ldots,v_{n-k}\}$ tal que $B\cup B’$ sea base de $V$. Basta mostrar que $T(B’)=\{T(v_1),\ldots,T(v_{n-k})\}\subset \Ima T$ es base de $\Ima T$. Sea $U$ el generado por $B’$, de modo que $V=U \oplus \ker T$.

Veamos que $T(B’)$ es generador de $\Ima T$. Tomemos $T(v)$ en $\Ima T$. Podemos escribir $v=z+u$ con $z\in \ker T$ y $u\in U$. Así, $T(v)=T(z)+T(u)=T(u)$, y este último está en el generado por $T(B’)$.

Ahora veamos que $T(B’)$ es linealmente independiente. Si $$\alpha_1T(v_1)+\ldots+\alpha_{n-k}T(v_{n-k})=0,$$ entonces $T(\alpha_1v_1+\ldots+\alpha_{n-k}v_{n-k})=0$, de modo que $\alpha_1v_1+\ldots+\alpha_{n-k}v_{n-k}$ está en $U$ y en $\ker T$, pero la intersección de estos espacios es $\{0\}$. Como esta combinación lineal es $0$ y $B’$ es linealmente independiente, $\alpha_1=\ldots=\alpha_n=0$.

De esta forma, $T(B’)$ es linealmente independiente y genera a $\Ima T$, de modo que $\rank(T) =|B’|=n-k$.

$\square$

Ejemplo. Consideremos de nuevo la transformación lineal $T:\mathbb{R}^3\to M_{2}(\mathbb{R})$ que manda $(x,y,z)$ a $$\begin{pmatrix}x+y-z & 2x \\ 2y-2z & x+z-y\end{pmatrix}.$$ Muestra que $T$ no es inyectiva.

Solución. Ya determinamos previamente que esta transformación tiene rango $2$. Por el teorema de rango-nulidad, su kernel tiene dimensión $1$. Así, hay un vector $v\neq (0,0,0)$ en el kernel, para el cual $T(v)=0=T(0)$, de modo que $T$ no es inyectiva.

$\square$

Problema. Demuestra que para cualquier entero $n$ existe una terna $(a,b,c)\neq (0,0,0)$ con $a+b+c=0$ y tal que $$\int_0^1 at^{2n}+bt^n+c \,dt = 0.$$

Solución. Podríamos hacer la integral y plantear dos ecuaciones lineales. Sin embargo, daremos argumentos dimensionales para evitar la integral. Consideremos las transformaciones lineales $T:\mathbb{R}^3\to \mathbb{R}$ y $S:\mathbb{R}^3\to \mathbb{R}$ dadas por

\begin{align*}

T(x,y,z)&=\int_0^1 xt^{2n}+yt^n+z \,dt\\

S(x,y,z)&=x+y+z.

\end{align*}

Notemos que $T(0,0,1)=\int_0^1 1\, dt = 1=S(0,0,1)$, de modo que ni $T$ ni $S$ son la transformación $0$. Como su rango puede ser a lo más $\dim\mathbb{R}=1$, entonces su rango es $1$. Por el teorema de rango-nulidad, $\dim \ker S= \dim \ker T = 2$. Como ambos son subespacios de $\mathbb{R}^3$, es imposible que $\ker S \cap \ker T=\{0\}$, de modo que existe $(a,b,c)$ no cero tal que $T(a,b,c)=S(a,b,c)=0$. Esto es justo lo que buscábamos.

$\square$

Rango para matrices

Definición. El rango de una matriz $A$ en $M_{m,n}(F)$ es el rango de la transformación lineal asociada de $F^n$ a $F^m$ dada por $X\mapsto AX$. Lo denotamos por $\rank(A)$.

A partir de esta definición y de las propiedades de rango para transformaciones lineales obtenemos directamente las siguientes propiedades para rango de matrices.

Proposición. Sean $m$, $n$ y $p$ enteros. Sea $B$ una matriz en $M_{n,p}(F)$ y $A$, $A’$ matrices en $M_{m,n}(F)$. Sea $P$ una matriz en $M_{n,p}(F)$ cuya transformación lineal asociada es suprayectiva y $Q$ una matriz en $M_{r,m}(F)$ cuya transformación lineal asociada es inyectiva. Entonces:

- $\rank(A)\leq \min(m,n)$

- $\rank(AB)\leq \min(\rank(A),\rank(B))$

- $\rank(A+A’)\leq \rank(A) + \rank(A’)$

- $\rank(QAP) = \rank(A)$

Como discutimos anteriormente, el rango de una transformación se puede obtener aplicando la transformación a una base y viendo cuál es el máximo subconjunto de imágenes de elementos de la base que sea linealmente independiente. Si tomamos una matriz $A$ en $M_{m,n}(F)$, podemos aplicar esta idea con los vectores $e_1,\ldots,e_n$ de la base canónica de $F^{n}$. Como hemos visto con anterioridad, para cada $i=1,\ldots, n$ tenemos que el vector $Ae_i$ es exactamente la $i$-ésima columna de $A$. Esto nos permite determinar el rango de una matriz en términos de sus vectores columna.

Proposición. El rango de una matriz en $M_{m,n}(F)$ es igual a la dimensión del subespacio de $F^m$ generado por sus vectores columna.

Problema. Determina el rango de la matriz $$\begin{pmatrix} 3 & 1 & 0 & 5 & 0\\ 0 & 8 & 2 & -9 & 0\\ 0 & -1 & 0 & 4 & -2\end{pmatrix}.$$

Solución. Como es una matriz con $3$ filas, el rango es a lo más $3$. Notemos que entre las columnas están los vectores $(3,0,0)$, $(0,2,0)$ y $(0,0,-2)$, que son linealmente independientes. De esta forma, el rango de la matriz es $3$.

$\triangle$

A veces queremos ver que el rango de un producto de matrices es grande. Una herramienta que puede servir en estos casos es la desigualdad de Sylvester.

Problema (Desigualdad de Sylvester). Muestra que para todas las matrices $A$, $B$ en $M_n(F)$ se tiene que $$\rank(AB)\geq \rank(A)+\rank(B)-n.$$

Solución. Tomemos $T_1:F^n\to F^n$ y $T_2:F^n\to F^n$ tales que $T_1(X)=AX$ y $T_2(X)=BX$. Lo que tenemos que probar es que $$\rank(T_1\circ T_2) \geq \rank(T_1) + \rank(T_2) – n.$$

Consideremos $S_1$ como la restricción de $T_1$ a $\Ima T_2$. Tenemos que $\ker S_1 \subset \ker T_1$, así que $\dim \ker S_1 \leq \dim \ker T_1$. Por el teorema de rango-nulidad en $S_1$, tenemos que

\begin{align*}

rank(T_2) &= \dim \Ima T_2 \\

&= \dim \ker S_1 + \rank(S_1) \\

&= \dim \ker S_1 + \rank(T_1\circ T_2)\\

&\leq \dim \ker T_1 + \rank(T_1\circ T_2),

\end{align*} así que $$\rank(T_2)\leq \dim \ker T_1 + \rank(T_1\circ T_2).$$

Por el teorema de rango-nulidad en $T_1$ tenemos que $$\dim \ker T_1 + \rank(T_1)=n.$$

Sumando la desigualdad anterior con esta igualdad obtenemos el resultado.

$\square$

El teorema $PJQ$ (opcional)

El siguiente resultado no se encuentra en el temario usual de Álgebra Lineal I. Si bien no formará parte de la evaluación del curso, recomendamos fuertemente conocerlo y acostumbrarse a usarlo pues tiene amplias aplicaciones a través del álgebra lineal.

Teorema (Teorema PJQ). Sea $A$ una matriz en $M_{m,n}(F)$ y $r$ un entero en $\{0,\ldots,\min(m,n)\}$. El rango de $A$ es igual a $r$ si y sólo si existen matrices invertibles $P\in M_m(F)$ y $Q\in M_n(F)$ tales que $A=PJ_rQ$, en donde $J_r$ es la matriz en $M_{m,n}$ cuyas primeras $r$ entradas de su diagonal principal son $1$ y todas las demás entradas son cero, es decir, en términos de matrices de bloque, $$J_r=\begin{pmatrix}

I_r & 0 \\

0 & 0

\end{pmatrix}.$$

No damos la demostración aquí. Se puede encontrar en el libro de Titu Andreescu, Teorema 5.68. Veamos algunas aplicaciones de este teorema.

Problema 1. Muestra que una matriz tiene el mismo rango que su transpuesta.

Solución. Llamemos $r$ al rango de $A$. Escribimos $A=PJ_rQ$ usando el teorema $PJQ$, con $P$ y $Q$ matrices invertibles. Tenemos que $^tA=^tQ\, ^tJ_r \,^tP$, con $^tQ$ y $^tP$ matrices invertibles. Además, $^t J_r$ es de nuevo de la forma de $J_r$. Así, por el teorema $PJQ$, tenemos que $^t A$ es de rango $r$.

Combinando el problema anterior con el resultado del rango de una matriz en términos de sus vectores columna obtenemos lo siguiente.

Proposición. El rango de una matriz en $M_{m,n}(F)$ es igual a la dimensión del subespacio de $F^n$ generado por sus vectores renglón.

Terminamos esta entrada con una aplicación más del teorema $PJQ$.

Problema 2. Muestra que una matriz $A$ de rango $r$ se puede escribir como suma de $r$ matrices de rango $1$. Muestra que es imposible hacerlo con menos matrices.

Solución. Expresamos $A=PJ_rQ$ usando el teorema $PJQ$. Si definimos $A_i=PE_{ii}Q$ para $i=1,\ldots,r$, donde $E_{ii}$ es la matriz cuya entrada $(i,i)$ es uno y las demás cero, claramente tenemos que $J_r=E_{11}+E_{22}+\ldots+E_{rr}$, por lo que $$A=PJ_rQ=A_1+A_2+\ldots+A_r.$$ Además, como $E_{ii}$ es de rango $1$, por el teorema $PJQ$ cada matriz $A_i$ es de rango $1$.

Veamos que es imposible con menos. Si $B_1,\ldots,B_s$ son matrices de rango $1$, como el rango es subaditivo tenemos que $\rank (B_1+\ldots+B_s)\leq s$. Así, si sumamos menos de $r$ matrices, no podemos obtener a $A$.

$\square$

Más adelante…

Esta entrada es solamente una breve introducción al concepto de rango y a algunas propiedades que pueden ser de utilidad al momento de calcular el rango de una matriz o una transformación lineal. Más adelante, veremos que el rango de una matriz está también relacionado con las soluciones de su sistema lineal homogéneo asociado.

El teorema de rango-nulidad es fundamental para el álgebra lineal. Muchas veces necesitamos calcular el rango de la imagen de una transformación lineal, pero es mucho más fácil calcular la dimensión de su kernel. O viceversa. En estas situaciones es muy importante recordar la forma en la que dicho teorema las relaciona.

Con este tema termina la segunda unidad del curso. Ahora estudiaremos aspectos un poco más geométricos de espacios vectoriales. En la siguiente unidad, hablaremos de dualidad, ortogonalidad, formas bilineales y productos interiores.

Tarea moral

A continuación hay algunos ejercicios para que practiques los conceptos vistos en esta entrada. Te será de mucha utilidad intentarlos para entender más la teoría vista.

- Termina de hacer la reducción gaussiana del primer ejemplo.

- Sea $T$ una transformación de un espacio vectorial $V$ de dimensión finita a si mismo. Usa el teorema de rango-nulidad para mostrar que si $T$ es inyectiva o suprayectiva, entonces es biyectiva.

- Determina el rango de la matriz $$\begin{pmatrix} 0 & 0 & 0 & 8 & 3\\ 7 & 8 & -1 & -2 & 0\\ 3 & -1 & 4 & 4 & -9\end{pmatrix}.$$

- Demuestra que aplicar operaciones elementales a una matriz no cambia su rango.

- Demuestra que matrices similares tienen el mismo rango.

- Demuestra por inducción que para matrices $A_1,\ldots, A_n$ del mismo tamaño tenemos que $$\rank (A_1+\ldots+A_n)\leq \sum_{i=1}^n \rank(A_i).$$

- Escribe la demostración de la última proposición de la sección del teorema $PJQ$

- Revisa la demostración del teorema de descomposición $PJQ$ en el libro de Titu Andreescu.

Entradas relacionadas

Agradecimientos

Trabajo realizado con el apoyo del Programa UNAM-DGAPA-PAPIME PE104721 «Hacia una modalidad a distancia de la Licenciatura en Matemáticas de la FC-UNAM»