No te preocupes por tus dificultades en matemáticas.

Te puedo asegurar que las mías son aún mayores.

– Albert Einstein

Introducción

En la entrada anterior iniciamos con el desarrollo de una teoría preliminar para demostrar el teorema de existencia y unicidad de Picard – Lindelöf. Hasta ahora hemos visto que un problema de valor inicial, en el caso de ecuaciones diferenciales ordinarias de primer orden, se puede escribir de forma equivalente como una ecuación integral. Aprendimos lo que es una función lipschitziana respecto de la segunda variable, demostramos algunos resultados importantes al respecto y concluimos con la demostración del lema de Gronwall.

Continuando con esta teoría preliminar, en esta entrada definiremos las iterantes de Picard, pero antes de ello es importante hacer un breve recordatorio sobre series y sucesiones de funciones.

También enunciaremos el teorema de Picard – Lindelöf para el caso local y resolveremos un ejercicio en el que apliquemos este resultado.

Recordemos el teorema de Picard – Lindelöf para que lo tengamos presente.

En esta situación, para cada $(x_{0}, y_{0}) \in U$, el problema de valores iniciales (PVI)

\begin{align} \dfrac{dy}{dx} = f(x, y); \hspace{1cm} y(x_{0}) = y_{0} \label{1} \tag{1} \end{align} posee una única solución definida en el intervalo $[a, b]$.

Además, las iterantes de Picard $y_{n}: [a, b] \rightarrow \mathbb{R}$ asociadas al PVI (\ref{1}), dadas por

\begin{align} y_{n}(x) = y_{0} + \int_{x_{0}}^{x} f(t, y_{n -1}(t)) dt \hspace{1cm} n= 1,2,3, \cdots \hspace{1cm} y_{0} = y_{0}(x) \label{2} \tag{2} \end{align} convergen uniformemente en el intervalo $[a, b]$ hacia la solución del PVI.

Bien, comencemos con el repaso de series y sucesiones de funciones.

Series y sucesiones de funciones

En cursos anteriores ya se han estudiado series y sucesiones de funciones. Aquí presentaremos, a manera de repaso, el concepto de convergencia puntual, convergencia uniforme y convergencia absoluta, además del criterio mayorante de Weierstrass.

Recordemos que una sucesión $\{f_{n}\}$ de funciones de $D$ a $\mathbb{R}$ converge en un punto $x \in D$ cuando la sucesión de números reales $\{f_{n}(x)\}$ es convergente. Cuando esto ocurre en todos los puntos de un conjunto no vacío $I \subset D$ se dice que $\{f_{n}\}$ converge puntualmente en $I$. En tal caso podemos definir una función $f: I \rightarrow \mathbb{R}$ escribiendo

$$f(x) = \lim_{n \to \infty} f_{n}(x) \label{3} \tag{3}$$

para todo $x \in I$, y decimos que $f$ es el límite puntual de $\{f_{n}\}$ en $I$.

Por otro lado, se dice que la sucesión $\{f_{n}(x)\}$ converge uniformemente a la función $f(x)$ en $I$ si

$$\lim_{n \to \infty} \left( \sup_{x \in I} |f_{n}(x) -f(x)|\right) = 0 \label{4} \tag{4}$$

En la práctica las ecuaciones (\ref{3}) y (\ref{4}) nos serán de mucha utilidad, sin embargo es conveniente tener presente las definiciones formales de convergencia puntual y convergencia uniforme para sucesiones de funciones.

$$\forall x \in I, \forall \varepsilon > 0 \hspace{0.2cm} \exists N \in \mathbb{N}:n \geq N \Rightarrow |f_{n}(x) -f(x)|< \varepsilon \label{5} \tag{5}$$

$$\forall \varepsilon > 0 \hspace{0.2cm} \exists N \in \mathbb{N} : n \geq N \Rightarrow |f_{n}(x) -f(x)|< \varepsilon ,\forall x \in I \label{6} \tag{6}$$

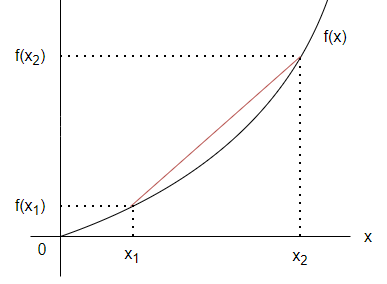

El concepto de convergencia uniforme es un concepto más fuerte que el de convergencia puntual. En el caso de convergencia puntual $N$ puede depender de $\varepsilon$ y de $x$, mientras que en la convergencia uniforme sólo puede depender de $\varepsilon$. Así, toda sucesión que converge uniformemente, converge puntualmente. El enunciado recíproco es falso, realicemos un ejemplo para mostrar esto.

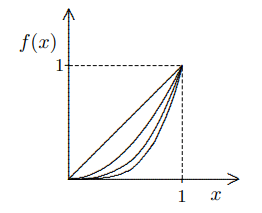

Ejemplo: Mostrar que la sucesión $f_{n}: [0, 1] \rightarrow \mathbb{R}$ definida por $f_{n}(x) = x^{n}$ converge puntualmente pero no uniformemente.

Solución: Para $x \in [0, 1)$ la sucesión $f_{n}(x) = x^{n}$ converge puntualmente a $f(x) = 0$ ya que

$$|f_{n}(x) -f(x)|=|x^{n} -0| = |x^{n}| = x^{n}$$

y

$$\lim_{n \to \infty} x^{n} = 0$$

esto para $x \in [0, 1)$, pero cuando $x = 1$ ocurre que $f_{n}(1) = 1^{n} = 1$, es decir, converge puntualmente a $f(x) = 1$ y así

$$|f_{n}(x) -f(x)|=|x^{n} -1| = |1 -1| = 0$$

Geométricamente podemos observar que, en efecto, todas las gráficas convergen a $f(x) = 0$ para $x \in [0, 1)$ y sólo cuando $x = 1$ es cuando la sucesión converge a $f(x) = 1$.

Sin embargo, la sucesión $f_{n}(x) = x^{n}$ no converge uniformemente, es sencillo darse cuenta que no existe $N \in \mathbb{N}$ para cumplir con (\ref{5}). Por muy pequeña que tomemos a $\varepsilon$ siempre va a haber alguna $n$ para $x \in [0, 1]$ que haga que

$$|f_{n}(x) -f(x)|> \varepsilon$$

Dicho de otra forma,

$$\lim_{n \to \infty} \left( \sup_{x \in I} |f_{n}(x) -f(x)|\right) \neq 0$$

$\square$

Será necesario extender el concepto de convergencia uniforme al caso de series de funciones.

$$\forall \varepsilon > 0, \exists N \in \mathbb{N} : n > N \Rightarrow \left| \sum_{n = N + 1}^{\infty} f_{n}(x) \right |< \varepsilon \label{7} \tag{7}$$

Un resultado importante que utilizaremos más adelante es el criterio de comparación directa. No lo demostraremos.

Para decir que la serie $\sum_{n = 1}^{\infty} a_{n}$ converge es común usar la notación

$$\sum_{n = 1}^{\infty} a_{n} < \infty \label{8} \tag{8}$$

Ahora definamos lo que significa que una serie sea absolutamente convergente.

La convergencia absoluta implica convergencia, pero la afirmación recíproca no es verdadera.

Una propiedad que nos será de mucha utilidad es la siguiente.

$$ \left| \sum_{n=1}^{\infty }a_{n} \right| \leq \sum_{n = 1}^{\infty}|a_{n}| \label{9} \tag{9}$$

Una herramienta más que nos será útil a la hora de demostrar el teorema de Picard – Lindelöf es el criterio mayorante de Weierstrass o mejor conocido como prueba M de Weierstrass. Este criterio nos permite comprobar la convergencia uniforme de una serie infinita cuyos términos son al mismo tiempo funciones de variable real o compleja.

Entonces la serie $\sum_{n=1}^{\infty }f_{n}(x)$ converge uniformemente en $D$.

Demostración: Por hipótesis sabemos que para cada $x$ en $D$

$$\left| \sum_{n = 1}^{\infty} f_{n}(x) \right| \leq \sum_{n = 1}^{\infty}|f_{n}(x)| \leq \sum_{n = 1}^{\infty }M_{n} < \infty \label{10} \tag{10}$$

es decir, la serie $\sum_{n = 1}^{\infty} M_{n}$ converge y como $|f_{n}(x)| \leq M_{n}$ y usando el criterio de comparación directa, entonces $\sum_{n = 1}^{\infty}| f_{n}(x)|$ converge, en consecuencia $\sum_{n = 1}^{\infty}f_{n}(x)$ converge absolutamente, esto significa que existe una función $f$ límite puntual de la serie de funciones tal que

$$f(x) = \sum_{n = 1}^{\infty}f_{n}(x)$$

o bien,

$$|f(x)| = \left| \sum_{n = 1}^{\infty}f_{n}(x) \right| \label{11} \tag{11}$$

Como queremos demostrar la convergencia uniforme tomemos $N \in \mathbb{N}$, tal que para $n > N$ la serie sea convergente. Vemos que podemos escribir lo siguiente.

$$\left|f(x) -\sum_{n = 1}^{N}f_{n}(x) \right| = \left |\sum_{n = N + 1}^{\infty}f_{n}(x) \right| \label{12} \tag{12}$$

sabemos que

$$\left|\sum_{n = N + 1}^{\infty}f_{n}(x) \right | \leq \sum_{n = N + 1}^{\infty} |f_{n}(x)| \label{13} \tag{13}$$

y por hipótesis

$$\sum_{n = N + 1}^{\infty}|f_{n}(x)| \leq \sum_{n = N + 1}^{\infty}M_{n} \label{14} \tag{14}$$

De los resultados (\ref{13}) y (\ref{14}) obtenemos

$$\left| \sum_{n = N + 1}^{\infty}f_{n}(x)\right| \leq \sum_{n = N + 1}^{\infty}M_{n} \label{15} \tag{15}$$

Al ser $\sum_{n = 1}^{\infty }M_{n}$ convergente, el número

$$\varepsilon = \sum_{n = N + 1}^{\infty }M_{n}$$

puede hacerse tan pequeño como se quiera eligiendo $N$ suficiente grande, así

$$\left| \sum_{n = N + 1}^{\infty}f_{n}(x) \right | < \varepsilon \label{16} \tag{16}$$

Por lo tanto, de acuerdo a (\ref{7}), la serie $\sum_{n = 1}^{\infty}f_{n}(x)$ converge uniformemente.

$\square$

Con esto concluimos nuestro repaso sobre series y sucesiones de funciones. Teniendo presente estos resultados definamos las iterantes de Picard.

Iterantes de Picard

El matemático francés Charles Émile Picard (1856 – 1941) desarrolló un método iterativo para obtener una solución de una ecuación diferencial de primer orden. A este método iterativo se le conoce como iterantes de Picard.

$$\dfrac{dy}{dx} = f(x, y), \hspace{1cm} y(x_{0}) = y_{0}$$ en el que se puede asegurar la existencia y unicidad de la solución en un dominio

$$R = \{ (x, y) \in \mathbb{R}^{2} \mid |x -x_{0}| \leq a, |y -y_{0}| \leq b, \hspace{0.2cm} a, b \in \mathbb{R} \}$$ es posible construir una solución de forma iterativa de acuerdo a la expresión

$$y_{n}(x) = y_{0} + \int_{x_{0}}^{x} f(t, y_{n -1}(t)) dt, \hspace{1cm} n= 1,2,3, \cdots \label{17} \tag{17}$$ Donde $y_{0} = y_{0}(x)$. A estas iteraciones se les conocen como iterantes de Picard o aproximaciones sucesivas de Picard.

Las iterantes de Picard de manera desglosada tienen la siguiente forma:

\begin{align*}

y_{0}(x) &= y_{0} \\

y_{1}(x) &= y_{0} + \int_{x_{0}}^{x}f(t,y_{0}(t)) dt \\

y_{2}(x) &= y_{0} + \int_{x_{0}}^{x}f(t,y_{1}(t)) dt \\

y_{3}(x) &= y_{0} + \int_{x_{0}}^{x}f(t,y_{2}(t))dt \\

\vdots \\

y_{n}(x) &= y_{0} + \int_{x_{0}}^{x} f(t, y_{n -1}(t)) dt

\end{align*}

Las iterantes de Picard siempre convergen, en el intervalo adecuado, a la solución del PVI (\ref{1}), esto lo verificaremos al momento de demostrar el teorema de Picard – Lindelöf, pero considerando que es cierto se puede deducir un resultado interesante, para ello consideremos el siguiente teorema.

$$\lim_{n \to \infty} \int_{a}^{b} f(x, y_{n}(x)) dx = \int_{a}^{b} \lim_{n \to \infty} f(x, y_{n}(x))dx = \int_{a}^{b} f(x, y(x)) dx \label{18} \tag{18}$$

La demostración de este resultado también será parte de la demostración del teorema de Picard – Lindelöf, así que por el momento consideremos que es cierto y observemos lo siguiente.

Si las iterantes de Picard satisfacen las hipótesis del teorema anterior y suponiendo que $f(x,y)$ es una función continua en $U$ que contiene a los puntos $(x, y_{n}(x))$, $\forall x \in [a, b]$, $\forall n \in \mathbb{N},$ entonces se tiene lo siguiente.

\begin{align*}

y(x) &= \lim_{n \to \infty } y_{n + 1}(x) \\

&= \lim_{n \to \infty} \left[y_{0} + \int_{x_{0}}^{x} f(t, y_{n}(t)) dt \right] \\

&= y_{0} + \int_{x_{0}}^{x} \lim_{n \to \infty} f(t, y_{n}(t)) dt \\

&= y_{0} + \int_{x_{0}}^{x} f(t, y(t)) dt

\end{align*}

es decir,

$$ y(x) = y_{0} + \int_{x_{0}}^{x} f(t, y(t)) dt \label{19} \tag{19}$$

Este resultado corresponde a la ecuación integral equivalente al problema de valor inicial. Con este método notamos que si las iterantes de Picard convergen a la solución del PVI, entonces $y(x)$ verifica la ecuación integral, tal como lo demostramos en la entrada anterior.

Por otro lado, al definir las iterantes de Picard hemos considerado un conjunto de la forma

$$R = \{ (x, y) \in \mathbb{R}^{2} \mid |x -x_{0}| \leq a, |y -y_{0}| \leq b, \hspace{0.2cm} a, b \in \mathbb{R} \}$$

La forma de este conjunto evita tener problemas para definir las iterantes. En general un conjunto de la forma $U = \delta \times \mathbb{R}$, $\delta = [a, b]$, $a, b \in \mathbb{R}$ conocidos como bandas verticales permite, no solamente que estén bien definidas, sino que además todas las iterantes estén definidas en el intervalo $\delta$.

Realicemos un ejemplo en el que apliquemos las iterantes de Picard para obtener la solución particular de un problema de valor inicial.

Ejemplo: Usando las iterantes de Picard, resolver el siguiente problema de valor inicial.

$$\dfrac{dy}{dx} = y; \hspace{1cm} y(0) = 1$$

Solución: En este caso tenemos la función, $f: \mathbb{R}^{2} \rightarrow \mathbb{R}$ definida por

$$f(x, y(x)) = y(x)$$

Es claro que es una función continua en $\mathbb{R}^{2}$. Por tanto, la ecuación integral equivalente al PVI para este caso es

$$y(x) = y_{0} + \int_{x_{0}}^{x} f(t, y(t)) dt = 1 + \int_{0}^{x} y(t)dt$$

La iterante inicial es la función constante $y_{0}(x) = 1$. Comencemos a calcular el resto de las iterantes de Picard de acuerdo a la relación iterativa (\ref{17}).

\begin{align*}

y_{1}(x) &= 1 + \int_{0}^{x} y_{0}(t) dt = 1 + \int_{0}^{x} 1dt = 1 + x \\

y_{2}(x) &= 1 + \int_{0}^{x} y_{1}(t) dt = 1 + \int_{0}^{x} (1 + t) dt = 1 + x + \dfrac{x^{2}}{2!} \\

y_{3}(x) &= 1 + \int_{0}^{x} y_{2}(t) dt = 1 + \int_{0}^{x} \left(1 + t + \dfrac{t^{2}}{2}\right) dt = 1 + x + \dfrac{x^{2}}{2!} + \dfrac{x^{3}}{3!} \\

\vdots

\end{align*}

La afirmación que hacemos es que para $n$ se obtiene

$$y_{n}(x) = 1 + \int_{0}^{x} y_{n -1}(t) dt = 1 + \dfrac{x}{1!} + \dfrac{x^{2}}{2!} + \dfrac{x^{3}}{3!} + \cdots + \dfrac{x^{n}}{n!} \label{20} \tag{20}$$

Ya lo hemos probado para $n = 1$, supongamos que la afirmación (\ref{20}) es verdadera y probemos para $n + 1$.

\begin{align*}

y_{n + 1}(x) &= 1 + \int_{0}^{x} y_{n}(t)dt \\

&= 1 + \int_{0}^{x} \left(1 + \dfrac{t}{1!} + \dfrac{t^{2}}{2!} + \cdots + \dfrac{t^{n}}{n!} \right) dt \\

&= 1 + x + \dfrac{x^{2}}{2 \cdot 1!} + \dfrac{x^{3}}{3 \cdot 2!} + \cdots + \dfrac{x^{n + 1}}{(n + 1) \cdot n!} \\

&= 1 + \dfrac{x}{1!} + \dfrac{x^{2}}{2!} + \dfrac{x^{3}}{3!} + \cdots + \dfrac{x^{n + 1}}{(n + 1)!}

\end{align*}

Esto es,

$$y_{n + 1}(x) = 1 + \dfrac{x}{1!} + \dfrac{x^{2}}{2!} + \dfrac{x^{3}}{3!} + \cdots + \dfrac{x^{n + 1}}{(n + 1)!}$$

Con esto hemos probado por inducción que las iterantes de Picard corresponden a la serie

$$y_{n}(x) = \sum_{k = 0}^{n} \dfrac{x^{k}}{k!}$$

Para obtener la solución al PVI debemos ver a qué converge esta serie, para ello tomemos el limite $n \rightarrow \infty$ observando que para cada $x \in \mathbb{R}$ existe el límite.

\begin{align*}

y(x) = \lim_{n \to \infty} y_{n}(x) = \lim_{n \to \infty} \sum_{k = 0}^{n} \dfrac{x^{k}}{k!} = \sum_{k = 0}^{\infty}\dfrac{x^{k}}{k!} = e^{x}

\end{align*}

Por lo tanto, la solución del problema de valor inicial

$$\dfrac{dy}{dx} = y; \hspace{1cm} y(0) = 1$$

es

$$y(x) = e^{x}$$

Sólo para verificar el resultado apliquemos el método de separación de variables para resolver el PVI.

\begin{align*}

\dfrac{dy}{dx} &= y \\

\dfrac{1}{y}\dfrac{dy}{dx} &= 1 \\

\int{\dfrac{dy}{y}} &= \int{dx} \\

\ln y &= x + c \\

y &= Ce^{x}

\end{align*}

La solución general de la ecuación diferencial $\dfrac{dy}{dx} = y$ es $y(x) = Ce^{x}$.

Apliquemos la condición inicial $y(0) = 1$.

$$y(0) = Ce^{0} = C = 1$$

En efecto, la solución al PVI es $y(x) = e^{x}$, tal como lo obtuvimos con las iterantes de Picard.

Para garantizar que las iterantes de Picard convergen a la solución del PVI se deben satisfacer las condiciones del teorema de existencia y unicidad, pero las hemos pasado por alto ya que el propósito de este ejercicio es ver cómo calcular las iterantes de Picard, sin embargo cabe mencionar que este PVI si las cumple por lo que la solución obtenida si es única. Más adelante veremos un ejemplo en el que si verificaremos que se cumple el teorema de existencia y unicidad.

$\square$

Con esto concluimos con la teoría preliminar que necesitamos conocer para demostrar el teorema de existencia y unicidad de Picard – Lindelöf. Sin embargo, es necesario hacer algunas aclaraciones.

Anteriormente mencionamos que existe un resultado global y uno local y esto es porque existen dos situaciones. En el teorema de Picard – Lindelöf hemos considerado como hipótesis un conjunto de la forma $U = \delta \times \mathbb{R}$ con $\delta = [a, b]$, $a, b \in \mathbb{R}$ y $f: U \rightarrow \mathbb{R}$ continua en $U$, además de que $f$ sea lipschitziana respecto de la segunda variable en $U$, estas condiciones son suficientes para tener un resultado global en el que siempre tendremos una solución única del problema de valor inicial definida en $\delta$, sin embargo es posible y más común que el conjunto $U$ no sea una banda vertical o siéndolo que $f$ no sea lipschitziana respecto de la segunda variable en $U$ o ambas a la vez. En esta segunda situación, bajo determinadas hipótesis, tendremos un teorema de existencia y unicidad local.

A continuación presentamos el teorema de existencia y unicidad local, este teorema no lo demostraremos pero gran parte de lo que veremos en la demostración del resultado global puede ser adaptado a las condiciones de este teorema.

Teorema de existencia y unicidad local

Es usual encontrarnos con ecuaciones diferenciales donde no se cumplan las tres condiciones del teorema global, sin embargo es posible que se cumplan en un pequeño conjunto $R \subset \mathbb{R}^{2}$ que contenga el punto $(x_{0}, y_{0})$ del PVI, de ahí la localidad del teorema. El conjunto compacto y convexo que más se parece a una banda vertical es el producto cartesiano de dos intervalos compactos en $\mathbb{R}$, es decir, un rectángulo con lados paralelos a los ejes de coordenadas. Un conjunto apropiado sería un rectángulo centrado en el punto $(x_{0}, y_{0})$.

$$R = \{(x, y) \in \mathbb{R}^{2} \mid |x- x_{0}| < a, |y -y_{0}| < b, \hspace{0.2cm} a, b \in \mathbb{R} \} \label{21} \tag{21}$$

El teorema de existencia y unicidad local establece lo siguiente.

En tal situación, para cada $(x_{0}, y_{0}) \in R$, el problema de valor inicial

$$\dfrac{dy}{dx} = f(x, y); \hspace{1cm} y(x_{0}) = y_{0} \label{22} \tag{22}$$ posee una única solución definida en el intervalo $\delta = [x_{0} -h, x_{0} + h]$, donde

$$ h = min \left\{a,\dfrac{b}{M} \right\} \hspace{1cm} y \hspace{1cm} M \geq \max_{(x, y) \in R}|f(x, y)|$$ Además, las iterantes de Picard asociadas al PVI convergen uniformemente en el intervalo $\delta$ hacia la solución del PVI.

En este curso nos enfocamos en el resultado global porque es un resultado general, sin embargo el resultado local nos permite hallar una región cerca del punto $(x_{0}, y_{0})$ donde un problema de valor inicial puede cumplir con las hipótesis del teorema para garantizar la existencia y unicidad de una solución, de esta forma es que, en la práctica, el resultado local puede ser un resultado más útil.

La demostración a detalle de este teorema se puede encontrar en la sección de videos de este mismo curso.

Para concluir esta entrada realicemos un ejemplo de un problema de valor inicial en el que apliquemos el teorema local para garantizar la existencia y unicidad de la solución y resolvamos el PVI aplicando las iterantes de Picard.

Aplicación del teorema de existencia y unicidad

- Verificar las hipótesis del teorema local para el siguiente problema de valor inicial.

$$\dfrac{dy}{dx} = 2x(y -1); \hspace{1cm} y(0) = 2 \label{23} \tag{23}$$

- Resolver este problema usando las iterantes de Picard.

- Hallar el intervalo de solución $\delta$.

Solución: El primer ejercicio consiste en verificar que el PVI satisface las hipótesis del teorema local.

En este caso la función $f$ está dada por

$$f(x, y) = 2x(y -1)$$

la cual está definida en todo $\mathbb{R}^{2}$. Buscamos la solución particular que pasa por el punto $(x_{0}, y_{0}) = (0, 2)$ y como la función es continua en $\mathbb{R}^{2}$, en particular lo es en todo rectángulo de la forma

$$R = \{(x, y) \in \mathbb{R}^{2} \mid |x| \leq a, |y -2| \leq b \}, \hspace{1cm} (a > 0, b > 0) \label{24} \tag{24}$$

Con esto hemos verificado las dos primeras hipótesis del teorema local, veamos ahora si la función es lipschitziana.

Para todo $(x, y_{1}), (x, y_{2})$ puntos de $R$, se tiene

\begin{align*}

|f(x, y_{1}) -f(x, y_{2})| &= |2x(y_{1} -1) -2x(y_{2} -1)| \\

&= 2|x||y_{1} -y_{2}| \\

&= 2|x||(y_{1} -2) + (2 -y_{2})| \\

&\leq 2|x|(|y_{1} -2| + |2 -y_{2}|) \\

\end{align*}

Como $|x| \leq a$ y $|y -2| \leq b$, en particular

$$|y_{1} -2| + |2 -y_{2}| \leq b + b = 2b$$

entonces podemos acotar el último resultado de la siguiente manera.

$$2|x|(|y_{1} -2| + |2 -y_{2}|) \leq 2(a)(2b) = 4ab$$

Si definimos la constante de Lipschitz $L = 4ab$, obtenemos finalmente que

$$|f(x, y_{1}) -f(x, y_{2})| \leq L = 4ab \label{25} \tag{25}$$

probando así que $f$ es Lipschitziana en $U$.

Con esto hemos verificado que se cumplen las hipótesis del teorema local de Picard, por lo tanto podemos concluir que existe una única solución $y = y(x)$ al problema de valor inicial dado. Ahora resolvamos el PVI usando las iterantes de Picard.

Recordemos que las iterantes de Picard $y_{n}(x)$ asociadas al problema de valor inicial son

$$y_{0}(x) = y_{0}, \hspace{1cm} y_{n}(x) = y_{0} + \int_{x_{0}}^{x} f(t, y_{n -1}(t)) dt$$

Ya sabemos que $y_{0} = 2$ y $x_{0} = 0$ y recordemos que la función $f$ es $f(x, y) = 2x(y-1)$, así para $n = 1$, tenemos

$$y_{1}(x) = 2 + \int_{0}^{x} f(t, 2) dt = 2 + \int_{0}^{x} 2t(2 -1) dt = 2 + x^{2}$$

$$\Rightarrow y_{1}(x) = 2 + x^{2}$$

Para $n = 2$, tenemos

$$y_{2}(x) = 2 + \int_{0}^{x} f(t, 2 + t^{2}) dt = 2 + \int_{0}^{x} 2t(1 + t^{2})dt = 2 +x^{2} + \dfrac{x^{4}}{2}$$

$$\Rightarrow y_{2}(x) = 2 +x^{2} + \dfrac{x^{4}}{2}$$

Para $n = 3$, se tiene

$$y_{3}(x) = 2 + \int_{0}^{x} f \left( t, 2 + t^{2} + \dfrac{t^{4}}{2} \right) dt = 2 + \int_{0}^{x} 2t \left( 1 + t^{2} + \dfrac{t^{4}}{2} \right) dt$$

$$\Rightarrow y_{3}(x) = 2 + x^{2} + \dfrac{x^{4}}{2} + \dfrac{x^{6}}{3!}$$

Uno más, para $n = 4$, tenemos

$$y_{4}(x) = 2 + \int_{0}^{x} f \left( t, 2 + t^{2} + \dfrac{t^{4}}{2} + \dfrac{t^{6}}{3!} \right) dt = 2 + \int_{0}^{x} 2t \left( 1 + t^{2} + \dfrac{t^{4}}{2} + \dfrac{t^{6}}{3!} \right) dt$$

$$\Rightarrow y_{4}(x) = 2 + x^{2} + \dfrac{x^{4}}{2} + \dfrac{x^{6}}{3!} + \dfrac{x^{8}}{4!}$$

Estas iteraciones sugieren la siguiente serie.

$$y_{n}(x) = 1 + 1 + x^{2} + \dfrac{x^{4}}{2!} + \dfrac{x^{6}}{3!} + \dfrac{x^{8}}{4!} + \cdots +\dfrac{x^{2n}}{n!}$$

Esta fórmula es cierta para $n = 1,2,3, 4$ y si es cierta para $n$, entonces podemos sustituirla en la formula general de las iterantes de Picard mostrando que es cierta para $n+1$.

\begin{align*}

y_{n + 1}(x) &= 2 + \int_{0}^{x} f(t, y_{n}(t))dt \\

&= 2 + \int_{0}^{x} 2t\left( 1 + t^{2} + \dfrac{t^{4}}{2} + \dfrac{t^{6}}{3!} + \dfrac{t^{8}}{4!} + \cdots + \dfrac{t^{2n}}{n!}\right) dt \\

&= 2 + x^{2} + \dfrac{x^{4}}{2} + \dfrac{x^{6}}{3!} + \dfrac{x^{8}}{4!} + \dfrac{x^{10}}{5!} + \cdots + \dfrac{x^{2(n + 1)}}{(n + 1)!}

\end{align*}

Por lo tanto,

$$y_{n}(x) = 1 + \sum_{k = 0}^{n}\dfrac{x^{2k}}{k!} \label{26} \tag{26}$$

Como el PVI cumple con las hipótesis del teorema de existencia y unicidad entonces el límite $n \rightarrow \infty$ de las iterantes de Picard será la solución al problema de valor inicial. Apliquemos el límite a la serie (\ref{26}).

\begin{align*}

y(x) &= \lim_{n \to \infty} y_{n}(x) \\

&= \lim_{n \to \infty} \left( 1 + \sum_{k = 0}^{n} \dfrac{(x^{2})^{k}}{k!} \right) \\

&= 1 + \lim_{n \to \infty} \left( \sum_{k = 0}^{n} \dfrac{(x^{2})^{k}}{k!} \right) \\

&= 1 +\sum_{k = 0}^{\infty} \dfrac{(x^{2})^{k}}{k!} \\

&= 1 + e^{x^{2}}

\end{align*}

Por lo tanto, la solución al PVI (\ref{23}) es

$$y(x) = 1 + e^{x^{2}} \label{27} \tag{27}$$

Inmediatamente se puede verificar que $y(0)=2$ y que para todo $x \in \mathbb{R}$

$$\dfrac{dy}{dx} = 2xe^{x^{2}} = 2x \left(e^{x^{2}} \right) = 2x (y -1)$$

lo cual implica que la solución es válida en $\delta = (-\infty, \infty)$.

Sólo para verificar el resultado resolvamos rápidamente este PVI aplicando el método de separación de variables.

\begin{align*}

\dfrac{dy}{dx} &= 2x(y -1) \\

\dfrac{1}{y -1} \dfrac{dy}{dx} &= 2x \\

\int {\dfrac{dy}{y -1}} &= \int {2x dx} \\

\ln{(y -1)} &= x^{2} + c \\

y -1 &= e^{x^{2} + c} \\

y &= 1 + Ce^{x^{2}}

\end{align*}

La solución general a la ecuación diferencial

$$\dfrac{dy}{dx} = 2x(y -1)$$

es

$$y(x) = 1 + Ce^{x^{2}}$$

Apliquemos la condición inicial $y(0) = 2$.

$$y(0) = 1 + Ce^{0} = 1 + C = 2$$

De donde $C = 2 -1 = 1$. Con este resultado concluimos que la solución particular es

$$y(x) = 1 + e^{x^{2}}$$

tal como lo obtuvimos con las iterantes de Picard.

$\square$

Ya sea el resultado global o el local, este teorema garantiza completamente la existencia y unicidad de la solución particular a un problema de valor inicial para el caso de una ecuación diferencial de primer orden.

En los métodos de resolución presentados a lo largo de esta unidad hemos pasado por alto las condiciones del teorema de Picard – Lindelöf y hemos tratado de justificar nuestros resultados con los teoremas de existencia y unicidad presentados para el caso de una ED de primer orden y para el caso de una ED de primer orden lineal, se hizo esto debido a la complejidad de la demostración del teorema de Picard – Lindelöf, pero ahora ya contamos con todo lo necesario para demostrarlo y así darle una completa justificación a lo que hemos hecho a lo largo de esta primer unidad.

Tarea moral

Los siguientes ejercicios no forman parte de la evaluación del curso, pero servirán para entender mucho mejor los conceptos vistos en esta entrada, así como temas posteriores.

- Sea la sucesión de funciones $\{f_{n}\}$ donde, para cada $n \in \mathbb{N}$, $f_{n}: \mathbb{R} \rightarrow \mathbb{R}$ es la función dada por $$f_{n}(x) = \dfrac{x^{2n}}{1 + x^{2n}}$$ $\forall x\in \mathbb{R}$. Estudiar la convergencia puntual y uniforme de $\{f_{n}(x)\}$.

- Sea la sucesión de funciones $\{f_{n}\}$ donde, para cada $n \in \mathbb{N}$, $f_{n}: \mathbb{R} \rightarrow \mathbb{R}$ es la función dada por $$f_{n}(x) = \dfrac{x}{1 + nx^{2}}$$ $\forall x\in \mathbb{R}$. Estudiar la convergencia puntual y uniforme de $\{f_{n}(x)\}$.

- Resolver el siguiente problema de valor inicial usando las iterantes de Picard. $$\dfrac{dy}{dx} = x + y; \hspace{1cm} y(0) = 2$$ Verificar el resultado resolviendo el PVI usando algún método visto anteriormente.

- Resolver el siguiente problema de valor inicial usando las iterantes de Picard. $$\dfrac{dy}{dx} = 2(y + 1); \hspace{1cm} y(0) = 0$$ Verificar el resultado resolviendo la ecuación usando algún método visto anteriormente.

Más adelante…

Con esta entrada concluimos con la teoría preliminar necesaria para poder demostrar el resultado global del teorema de existencia y unicidad de Picard – Lindelöf. Hemos hecho un breve repaso sobre convergencia de series y sucesiones de funciones, definimos las iterantes de Picard y presentamos el resultado local del teorema de existencia y unicidad.

Usando lo visto en esta y la anterior entrada concluiremos la primera unidad del curso demostrando el resultado global del teorema de existencia y unicidad de Picard – Lindelöf.

Entradas relacionadas

- Página principal del curso: Ecuaciones Diferenciales I

- Entrada anterior del curso: Teorema de Existencia y Unicidad – Ecuación Integral, Funciones Lipschitzianas y Lema de Gronwall

- Siguiente entrada del curso: Demostración del Teorema de Existencia y Unicidad de Picard – Lindelöf

Agradecimientos

Trabajo realizado con el apoyo del Programa UNAM-DGAPA-PAPIME PE104522 «Hacia una modalidad a distancia de la Licenciatura en Matemáticas de la FC-UNAM – Etapa 2»