Si la gente no cree que las matemáticas son simples, es solo

porque no se dan cuenta de lo complicado que es la vida.

– John Louis von Neumann

Introducción

¡Hemos llegado al final de la primera unidad de este curso!.

Concluiremos con la demostración de uno de los teoremas más importantes dentro del campo de las ecuaciones diferenciales; el teorema de existencia y unicidad de Picard – Lindelöf. Pero antes, un poco de contexto histórico.

Este resultado fue estudiado y desarrollado entre los años 1820 y 1900 por Cauchy, Liouville, Lipschitz, Picard y Lindelöf. Entre 1820 y 1830 Cauchy probó que si $f = f(x, y)$ es una función continua y existe su derivada parcial $\dfrac{df}{dy}$ continua en cierta región $U \subset \mathbb{R}^{2}$ que contiene el punto $(x_{0}, y_{0})$, entonces existe un intervalo $\delta$ en el que un problema de valor inicial posee una única solución definida en $\delta$.

En 1838, Liouville simplificó la prueba de Cauchy introduciendo el método de las aproximaciones sucesivas, que más tarde continuarían siendo desarrolladas por Picard y que se conocerían como iterantes de Picard.

En 1876, Lipschitz mejoraría el resultado de Cauchy, sustituyendo la condición de que exista la derivada continua de $f$ por una menos fuerte, conocida como condición de Lipschitz.

Posteriormente, todo lo anterior fue ligeramente mejorado y generalizado por Picard (1890) y Lindelöf (1893), siguiendo las mismas ideas dadas por Liouville y Lipschitz.

Actualmente el método y los resultados se les atribuyen a Picard conociéndose como método de las iterantes de Picard y teorema de Picard (o más generalmente, teorema de Picard – Lindelöf).

En las dos últimas entradas hemos presentado una teoría preliminar con todas las herramientas necesarias para demostrar el teorema de Picard – Lindelöf, sin más, demostremos el teorema.

Teorema de existencia y unicidad de Picard – Lindelöf

El resultado global del teorema de existencia y unicidad de Picard – Lindelöf es el siguiente.

En esta situación, para cada $(x_{0}, y_{0}) \in U$, el problema de valores iniciales (PVI)

\begin{align} \dfrac{dy}{dx} = f(x, y); \hspace{1cm} y(x_{0}) = y_{0} \label{1} \tag{1} \end{align} posee una única solución definida en el intervalo $[a, b]$.

Además, las iterantes de Picard $y_{n}: [a, b] \rightarrow \mathbb{R}$ asociadas al PVI (\ref{1}), dadas por

\begin{align*} y_{n}(x) = y_{0} + \int_{x_{0}}^{x} f(t, y_{n -1}(t)) dt \hspace{1cm} n= 1,2,3, \cdots \hspace{1cm} y_{0} = y_{0}(x) \end{align*} convergen uniformemente en el intervalo $[a, b]$ hacia la solución del PVI.

Demostración del teorema de Picard – Lindelöf

Sea $\delta = [a, b]$. Como cualquier función $y: \delta \rightarrow \mathbb{R}$ tiene su gráfica en $U$ y por hipótesis $f$ es continua en $U$, tenemos, como consecuencia del teorema sobre la ecuación integral, que $y: \delta \rightarrow \mathbb{R}$ es solución del PVI si y solo si $y(x)$ es una función continua en $\delta$ y para cada $x \in \delta$ verifica la ecuación integral

$$y(x) = y_{0} + \int_{x_{0}}^{x} f(t, y(t))dt \label{2} \tag{2}$$

Necesitamos probar que esta ecuación integral sólo posee una solución continua. Para ello, al ser $U$ una banda vertical, podemos definir sin problema alguno las iterantes de Picard $y_{n}: \delta \rightarrow \mathbb{R}$, las cuales son funciones continuas que verifican $y_{n}(x_{0}) = y_{0}$.

La demostración la dividiremos en tres secciones:

- Primero probaremos que la sucesión de iterantes $\{y_{n}\}$ converge uniformemente en el intervalo $\delta$ hacia una función continua $y: \delta \rightarrow \mathbb{R}$.

- Posteriormente comprobaremos que esta función $y: \delta \rightarrow \mathbb{R}$ verifica la ecuación integral (\ref{2}) y, por tanto, es solución del PVI.

- Finalmente probaremos que el PVI no posee otra solución distinta de $y: \delta \rightarrow \mathbb{R}$.

Con los primeros dos puntos estaremos demostrando la existencia de una solución al problema de valor inicial y con el tercer punto estaremos demostrando la unicidad. Es importante mencionar que en cada uno de los tres puntos anteriores, aparte de la continuidad de $f$, haremos uso de manera esencial de la condición de Lipschitz de $f$ respecto de la segunda variable.

$$|f(x, y_{1}) -f(x, y_{2})| \leq L|y_{1} -y_{2}| \label{3} \tag{3}$$

para cada par de puntos $(x, y_{1}), (x, y_{2}) \in U$. Con $L$ la constante de Lipschitz para $f$ en $U$.

Así mismo, en el primer punto utilizaremos de forma esencial que la convergencia de las iterantes es uniforme, pues no basta con la convergencia puntual.

Demostremos el primer punto.

- Convergencia uniforme de las iterantes de Picard.

Para probar que la sucesión de iterantes $\{y_{n}\}$ converge uniformemente en el intervalo $\delta$ es conveniente expresarlas de la siguiente forma.

$$y_{n}(x) = y_{0}(x) + \sum_{m = 1}^{n}(y_{m}(x) -y_{m -1}(x)) \label{4} \tag{4}$$

Desglosa la serie anterior para que verifiques la equivalencia.

Fijado $x \in \delta$ es evidente que la sucesión numérica $\{y_{n}(x)\}$ es convergente en $\mathbb{R}$ si y sólo si la serie numérica $\sum_{m = 1}^{\infty}(y_{m}(x) -y_{m -1}(x))$ es convergente, para lo cual es suficiente con la convergencia absoluta de la serie para cada $x \in \delta$, es decir

$$\sum_{m = 1}^{\infty }|y_{m}(x) -y_{m -1}(x)|< \infty \label{5} \tag{5}$$

Si la serie (\ref{5}) fuese convergente para cada $x \in \delta$, entonces se tendría que la sucesión de iterantes converge puntualmente en $\delta$, sin embargo no es suficiente con la convergencia puntual; necesitamos algo más fuerte, como lo es la convergencia uniforme.

Para probar que la serie funcional $\sum_{m = 1}^{\infty}(y_{m}(x) -y_{m -1}(x))$ converge uniformemente en $\delta$ y, por tanto, la sucesión de iterantes, vamos a usar el criterio mayorante de Weierstrass para lo cual necesitamos probar que existen unas constantes $M_{m} \in \mathbb{R}^{+}$, tales que

$$|y_{m}(x) -y_{m -1}(x)|\leq M_{m} \label{6} \tag{6}$$

para cada $x \in \delta$, cada $m = 1, 2, 3 \cdots$, y $\sum_{m = 1}^{\infty } M_{m} < \infty$.

Vamos a comenzar con los casos $m = 1$ y $m = 2$, es decir, vamos a hallar las constantes $M_{1}$ y $M_{2}$, tales que

$$|y_{1}(x) -y_{0}(x)| \leq M_{1} \hspace{1cm} y \hspace{1cm} |y_{2}(x) -y_{1}(x)| \leq M_{2}$$

y con estos resultados intentaremos encontrar una relación de recurrencia para las constantes $M_{m}$ para luego corroborar que $\sum_{m = 1}^{\infty } M_{m} < \infty$ y de esta manera probar la convergencia (\ref{5}).

Partiendo de la ecuación de las iterantes de Picard

$$y_{m}(x) = y_{0} + \int_{x_{0}}^{x} f(t, y_{m -1}(t)) dt; \hspace{1cm} y_{0} = y_{0}(x) \label{7} \tag{7}$$

las primeras iterantes son

$$y_{1}(x) = y_{0}(x) + \int_{x_{0}}^{x} f(t, y_{0}(t)) dt \hspace{1cm} y \hspace{1cm} y_{2}(x) = y_{0}(x) + \int_{x_{0}}^{x} f(t, y_{1}(t)) dt$$

de donde,

$$|y_{1}(x) -y_{0}(x)| = \left| \int_{x_{0}}^{x} f(t, y_{0}) dt \right |$$

y

$$|y_{2}(x) -y_{1}(x)| = \left| \int_{x_{0}}^{x} f(t, y_{1}(t)) -f(t, y_{0}(t))dt \right|$$

Al momento de estimar $|y_{1}(x) -y_{0}(x)|$ necesitamos hacer la siguiente consideración. La función $f$ es continua en $U$ y, por tanto, la función

$$g: \delta \rightarrow \mathbb{R}; \hspace{1cm} x \rightarrow g(x) = f(x, y_{0}(x))$$

es continua en $\delta$. Como $\delta$ es compacto, la función $g(x)$ está acotada en $\delta$, es decir, existe una constante $H > 0$, tal que

$$|g(x)| = |f(x, y_{0}(x))| \leq H$$

para cada $x \in \delta$ y, por tanto, se verifica lo siguiente.

\begin{align*}

|y_{1}(x) -y_{0}(x)| &= \left| \int_{x_{0}}^{x} f(t, y_{0}(t)) dt \right | \\

&\leq \int_{x_{0}}^{x}|f(t, y_{0}(t))| dt \\

&\leq \int_{x_{0}}^{x} H dt \\

&= H|x -x_{0}|

\end{align*}

esto es,

$$|y_{1}(x) -y_{0}(x)| \leq H|x -x_{0}| \label{8} \tag{8}$$

Si consideramos todo el intervalo $\delta = [a, b]$ podríamos obtener finalmente la estimación

$$|y_{1}(x) -y_{0}(x)| \leq H (b -a) = M_{1} \label{9} \tag{9}$$

Para poder estimar adecuadamente $|y_{2}(x) -y_{1}(x)|$ consideremos el resultado (\ref{8}), además de las siguientes dos desigualdades.

\begin{align*}

|y_{2}(x) -y_{1}(x)| &= \left| \int_{x_{0}}^{x} f(t, y_{1}(t)) -f(t, y_{0}(t))dt \right| \\

&\leq \int_{x_{0}}^{x}| f(t, y_{1}(t)) -f(t, y_{0}(t))|dt \label{10} \tag{10}

\end{align*}

y la condición de Lipschitz

$$|f(t, y_{1}(t)) -f(t, y_{0})| \leq L |y_{1}(t) -y_{0}(t)| \label{11} \tag{11}$$

Supongamos que $x > x_{0}$. Usando (\ref{10}) y (\ref{11}), además del resultado (\ref{8}), se tiene

\begin{align*}

|y_{2}(x) -y_{1}(x)| &\leq \int_{x_{0}}^{x}|f(t, y_{1}(t)) -f(t ,y_{0}(t))| dt \\

&\leq \int_{x_{0}}^{x} L |y_{1}(t) -y_{0}(t)|dt \\

&\leq LH \int_{x_{0}}^{x}|t- x_{0}|dt \\

&= LH \int_{x_{0}}^{x}(t -x_{0})dt \\

&= LH \dfrac{(x -x_{0})^{2}}{2}

\end{align*}

Por otro lado, para $x < x_{0}$, se tiene

\begin{align*}

|y_{2}(x) -y_{1}(x)| &\leq \int_{x}^{x_{0}}|f(t, y_{1}(t)) -f(t ,y_{0}(t))| dt \\

&\leq L \int_{x}^{x_{0}}|y_{1}(t) -y_{0}(t)|dt \\

&\leq LH \int_{x}^{x_{0}}|t -x_{0}|dt \\

&= LH \int_{x}^{x_{0}}(x_{0} -t)dt \\

&= LH \dfrac{(x_{0} -x)^{2}}{2}

\end{align*}

De ambos resultados, podemos afirmar que para cada $x \in \delta$

$$|y_{2}(x) -y_{1}(x)| \leq HL \dfrac{|x -x_{0}|^{2}}{2!} \label{12} \tag{12}$$

La desigualdad (\ref{8}) la podemos escribir de forma similar a (\ref{12}) de la siguiente forma.

$$|y_{1}(x) -y_{0}(x)| \leq HL^{0} \dfrac{|x -x_{0}|^{1}}{1!}$$

De estas dos relaciones establecemos una relación de recurrencia que vamos a probar por inducción sobre $m$. Proponemos que para cada $m = 1, 2, 3, \cdots$, y para cada $x \in \delta$, se cumple

$$|y_{m}(x) -y_{m -1}(x)| \leq HL^{m -1} \dfrac{|x -x_{0}|^{m}}{m!} \label{13} \tag{13}$$

La desigualdad ha sido probada anteriormente para $m = 1$ y $m = 2$. Supongamos que es cierta para $m$ y vamos a probar que es válida para $m + 1$ siguiendo el mismo razonamiento que en la obtención del caso $m = 2$. Vamos a mostrar el caso $x > x_{0}$, pero la prueba es similar para el caso $x < x_{0}$.

Si $x > x_{0}$, se tiene

\begin{align*}

|y_{m+1}(x) -y_{m}(x)| &\leq \int_{x_{0}}^{x}|f(t, y_{m}(t)) -f(t, y_{m -1}(t))|dt \\

&\leq L \int_{x_{0}}^{x}|y_{m}(t) -y_{m -1}(t)|dt \\

&\leq \dfrac{HL^{m}}{m!} \int_{x_{0}}^{x}(t -x_{0})^{m} dt \\

&= HL^{m} \dfrac{(x -x_{0})^{m + 1}}{(m+1)!}

\end{align*}

De forma similar, si $x < x_{0}$, se tiene

$$|y_{m+1}(x) -y_{m}(x)| \leq HL^{m} \dfrac{(x_{0} -x)^{m + 1}}{(m+1)!}$$

De ambos resultados concluimos que

$$|y_{m+1}(x) -y_{m}(x)| \leq HL^{m} \dfrac{|x -x_{0}|^{m + 1}}{(m+1)!}$$

Es Importante hacer énfasis que en este desarrollo ha sido fundamental que las iterantes $\{y_{n}\}$ tengan sus gráficas en una región $U$ donde $f$ es lipschitziana.

De lo obtenido anteriormente, y considerando el intervalo completo $\delta = [a, b]$, obtenemos finalmente la siguiente desigualdad.

$$|y_{m}(x) -y_{m -1}(x)| \leq \dfrac{H}{L} \dfrac{(L(b -a))^{m}}{m!} = M_{m} \label{14} \tag{14}$$

para cada $x \in \delta$ y cada $m = 1, 2, 3, \cdots$. Como el intervalo $\delta$ es acotado, entonces $M_{m} \in \mathbb{R}^{+}$ y sabemos que

$$\sum_{m = 1}^{\infty} \dfrac{(L(b -a))^{m}}{m!} = e^{L(b -a)} -1< \infty \label{15} \tag{15}$$

En definitiva,

$$\sum_{m=1}^{\infty } M_{m} < \infty$$

es decir la serie es convergente. Con esto queda probada la condición (\ref{5}) y debido a que la prueba se hizo utilizando el criterio mayorante de Weierstrass concluimos que se trata de una convergencia uniforme de las iterantes de Picard en el intervalo $\delta$ hacia una función $y: \delta \rightarrow \mathbb{R}$.

Es bien conocido que si una sucesión $y_{n}: \delta \rightarrow \mathbb{R}$, $n = 1, 2, 3, \cdots$, de funciones continuas sobre $\delta$ que convergen uniformemente en $\delta$ hacia una función $y: \delta \rightarrow \mathbb{R}$, la función límite uniforme $y$ también es continua en $\delta$.

Queda así demostrado el primer punto de la prueba. Ahora verifiquemos que la función límite uniforme $y: \delta \rightarrow \mathbb{R}$ verifica la ecuación integral (\ref{2}) siendo la solución al problema de valor inicial.

- La existencia de la solución.

Sea $y: \delta \rightarrow \mathbb{R}$ la función obtenida anteriormente como límite uniforme de las iterantes de Picard $\{y_{n}\}$. La convergencia uniforme de $\{y_{n}\}$ hacia $y(x)$ en el intervalo $\delta$ significa que dado cualquier $\hat{\varepsilon} > 0$ existe un natural $N = N(\hat{\varepsilon})$, tal que para cada $n > N$ y cada $x \in \delta$

$$|y_{n}(x) -y(x)| < \hat{\varepsilon} \label{16} \tag{16}$$

Sabemos que la convergencia uniforme implica la convergencia puntual (pero no al revés), de manera que para cada $x \in \delta$ se cumple que

$$\lim_{n \to \infty}y_{n}(x) = y(x) \label{17} \tag{17}$$

Fijemos un $x \in \delta$. De acuerdo a (\ref{17}) y usando (\ref{7}), se tiene

$$y(x) = \lim_{n \to \infty} y_{n+1}(x) = y_{0} + \lim_{n \to \infty } \int_{x_{0}}^{x}f(t, y_{n}(t))dt$$

Por otro lado, sabemos que la función solución que satisface el PVI satisface también la ecuación integral (\ref{2}),

$$y(x) = y_{0} + \int_{x_{0}}^{x} f(t, y(t))dt$$

Nuestro objetivo es probar que

$$\lim_{n\rightarrow \infty }\int_{x_{0}}^{x} f(t, y_{n}(t)) dt = \int_{x_{0}}^{x}f(t, y(t))dt \label{18} \tag{18}$$

Pues de esta forma la función límite uniforme $y$ verificaría la ecuación integral y, por tanto sería solución del PVI en el intervalo $\delta$, quedando así probada la existencia de la solución.

Demostrar la relación (\ref{18}) es equivalente a probar que $\forall \varepsilon > 0$ existe $N = N(\varepsilon) \in \mathbb{N}$, tal que para cada $n > N$ y cada $x \in \delta$

$$\left|\int_{x_{0}}^{x}f(t, y_{n}(t))dt -\int_{x_{0}}^{x} f(t, y(t))dt \right| < \varepsilon \label{19} \tag{19}$$

Para probar la relación (\ref{19}) de nuevo haremos uso de la condición de Lipschitz (\ref{3}) y de la convergencia uniforme de las iterantes hacia $y$ en $\delta$ (\ref{16}).

\begin{align*}

\left|\int_{x_{0}}^{x}f(t, y_{n}(t))dt -\int_{x_{0}}^{x} f(t, y(t))dt\right| &\leq \int_{x_{0}}^{x}|f(t, y_{n}(t)) -f(t, y(t))|dt \\

&\leq \int_{a}^{b}|f(t, y_{n}(t)) -f(t, y(t))|dt \\

&\leq L \int_{a}^{b}|y_{n}(t) -y(t)|dt

\end{align*}

Dado $\varepsilon > 0$, definimos

$$\hat{\varepsilon} = \dfrac{\varepsilon }{L(b -a)} \label{20} \tag{20}$$

Con esto, la desigualdad (\ref{16}) se puede escribir como

$$|y_{n}(t) -y(t)|< \dfrac{\varepsilon }{L(b -a)} \label{21} \tag{21}$$

Usando esta desigualdad notamos que, para cada $n > N$ y cada $x \in \delta$

\begin{align*}

\left|\int_{x_{0}}^{x}f(t, y_{n}(t))dt -\int_{x_{0}}^{x} f(t, y(t))dt\right| &\leq L \int_{a}^{b}|y_{n}(t) -y(t)|dt \\

&\leq \dfrac{L}{L(b -a)} \int_{a}^{b} \varepsilon dt \\

&= \dfrac{L}{L(b -a)} \varepsilon (b -a) \\

&= \varepsilon

\end{align*}

Por lo tanto, $ \forall \varepsilon > 0$ existe $N = N(\varepsilon) \in \mathbb{N}$, tal que para cada $n > N$ y cada $x \in \delta$

$$\left|\int_{x_{0}}^{x}f(t, y_{n}(t))dt -\int_{x_{0}}^{x} f(t, y(t))dt \right| < \varepsilon$$

lo que confirma la relación (\ref{18}) que es lo que queríamos demostrar. De esta forma queda demostrada la existencia de la solución $y: \delta \rightarrow \mathbb{R}$ para el problema de valor inicial. Finalmente demostremos la unicidad de esta solución.

- Demostración de la unicidad.

Con los dos puntos anteriores estamos convencidos de la existencia de una solución $y: \delta \rightarrow \mathbb{R}$ que satisface el problema de valor inicial (\ref{1}), así como la ecuación integral (\ref{2}). La prueba de la unicidad se basa en la suposición de la existencia de otra solución $\hat{y}: \delta \rightarrow \mathbb{R}$ que igualmente cumple con los dos puntos anteriores y el objetivo será demostrar que $\hat{y}(x) = y(x)$.

De tarea moral demostrarás que la solución $\hat{y}(x)$ es también una función límite uniforme de las mismas iterantes de Picard para cada $x \in \delta$, esto es

$$\lim_{n \to \infty}y_{n}(x) = \hat{y}(x) \label{22} \tag{22}$$

o, lo que es equivalente, mostrar que

$$\lim_{n \to \infty} |\hat{y}(x) -y_{n}(x)| = 0 \label{23} \tag{23}$$

y por la ecuación (\ref{17}) concluir que $\hat{y}(x) = y(x)$.

En esta situación se procede de manera muy similar a la prueba del primer punto en el que debemos encontrar una relación de recurrencia que acote a la cantidad $|\hat{y}(x) -y_{n}(x)|$ para cada $x \in \delta$ de la siguiente manera

$$0 \leq |\hat{y}(x) -y_{n}(x)| \leq B_{n} \label{24} \tag{24}$$

y si se prueba que

$$\lim_{n \to \infty}B_{n} = 0$$

entonces quedará probada la relación (\ref{23}).

A continuación te damos algunos hints y resultados que deberás obtener a lo largo de tu demostración.

Estudia lo que sucede con $n = 1$ y $n = 2$ y con los resultados encuentra la relación de recurrencia general para cada $n \in \mathbb{N}$, para ello considera la máxima distancia entre $\hat{y}$ y $y_{0}$, esto es

$$A = \max_{x \in \delta} |\hat{y} -y_{0}|$$

El máximo $A \in \mathbb{R}^{+}$ esta asegurado gracias a la continuidad de la función $\hat{y}$ en el intervalo compacto $\delta$. Como la gráfica de la función $\hat{y}(x)$ está contenida en $U$ y $f = f(x, \hat{y})$ es una función lipschitziana, demuestra que para cada $x \in \delta$

$$|\hat{y}(x) -y_{1}(x)| \leq L \int_{x_{0}}^{x}|\hat{y}(t) -y_{0}(t)|dt \leq AL|x -x_{0}| \label{25} \tag{25}$$

Usando este resultado demuestra que

$$|\hat{y}(x) -y_{2}(x)| \leq AL^{2} \int_{x_{0}}^{x}|t -x_{0}|dt \leq AL^{2} \dfrac{|x -x_{0}|^{2}}{2!} \label{26} \tag{26}$$

Demuestra por inducción que en general, para cada $n = 1, 2, 3, \cdots,$ y $x \in \delta$

$$|\hat{y}(x) -y_{n}(x)| \leq AL^{n} \dfrac{|x -x_{0}|}{n!} \label{27} \tag{27}$$

Este resultado te permite concluir que para cada $x \in \delta = [a, b]$

$$|\hat{y}(x) -y_{n}(x)| \leq A \dfrac{(L(b -a))^{n}}{n!} = B_{n} \label{28} \tag{28}$$

Prueba que

$$\lim_{n \to \infty} B_{n} = \lim_{n \to \infty} \dfrac{(L(b -a))^{n}}{n!} = 0 \label{29} \tag{29}$$

Así finalmente queda demostrada la relación (\ref{23}) y por lo tanto $\hat{y}(x) = y(x)$ para cada $x \in \delta$.

Realizar este ejercicio te servirá para consolidar mucho mejor lo que hemos realizado a lo largo de la demostración. Sin embargo, la demostración de la unicidad puede ser mucho más simple si aplicamos el lema de Gronwall. Demostremos la unicidad por esta opción.

Sean $y: \delta \rightarrow \mathbb{R}$ y $\hat{y}: \delta \rightarrow \mathbb{R}$ soluciones al PVI (\ref{1}) y la ecuación integral (\ref{2}).

$$y(x) = y_{0} + \int_{x_{0}}^{x}f(t, y(t)) dt \hspace{1cm} y \hspace{1cm} \hat{y}(x) = y_{0} + \int_{x_{0}}^{x}f(t, \hat{y}(t)) dt$$

Restemos las dos ecuaciones anteriores y consideramos su valor absoluto.

\begin{align*}

|y(x) -\hat{y}(x)| &= \left|\int_{x_{0}}^{x}f(t, y(t))dt -\int_{x_{0}}^{x}f(t, \hat{y}(t))dt \right|\\

&= \left|\int_{x_{0}}^{x}f(t, y(t)) -f(t, \hat{y}(t))dt \right| \\

&\leq \int_{x_{0}}^{x}|f(t, y(t)) -f(t,\hat{y}(t))|dt

\end{align*}

Como $f$ es una función lipschitziana respecto de la segunda variable, entonces

$$\int_{x_{0}}^{x}|f(t, y(t)) -f(t, \hat{y}(t))|dt \leq \int_{x_{0}}^{x} L|y(t) -\hat{y}(t)|dt = L \int_{x_{0}}^{x}|y(t) -\hat{y}(t)|dt$$

es decir,

$$|y(x) -\hat{y}(x)| \leq L \int_{x_{0}}^{x}|y(t) -\hat{y}(t)|dt \label{30} \tag{30}$$

Para que este resultado nos sea más familiar definamos lo siguiente.

$$h(x) = |y(x) -\hat{y}(x)| \hspace{1cm} y \hspace{1cm} \alpha = 0, \hspace{0.2cm} \beta = L$$

Usando esto reescribimos a la ecuación (\ref{30}) como

$$0 \leq h(x) \leq \alpha + \beta \int_{x_{0}}^{x} h(t) dt \label{31} \tag{31}$$

Estamos en las condiciones del lema de Gronwall, pero en el caso especial en el que $\alpha = 0$, así que aplicando el corolario del lema de Gronwall podemos concluir que para cada $x \in \delta$

$$h(x) = |y(x) -\hat{y}(x)| = 0$$

lo que significa que $\forall x \in \delta$, $y(x) = \hat{y}(x)$, es decir, la solución al problema de valor inicial es única.

Con esto quedan demostrados los tres puntos de la prueba, por lo tanto concluimos que el problema de valor inicial (\ref{1}) posee una única solución en $\delta = [a, b]$ y además, las iterantes de Picard asociadas al PVI convergen uniformemente en $\delta$ hacia la solución $y: \delta \rightarrow \mathbb{R}$ del PVI.

$\square$

¡Listo!. Hemos demostrado el teorema de existencia y unicidad de Picard – Lindelöf.

Apliquemos este resultado al caso de las ecuaciones diferenciales lineales.

Existencia y unicidad en ecuaciones lineales

Apliquemos el teorema de Picard – Lindelöf al caso de las ecuaciones diferenciales lineales de primer orden.

$$\dfrac{dy}{dx} = P(x) y + Q(x); \hspace{1cm} y(x_{0}) = y_{0} \label{32} \tag{32}$$

Donde las funciones $P(x)$ y $Q(x)$ son continuas en un intervalo compacto $\delta = [a, b]$, $x_{0} \in \delta$ y $y_{0} \in \mathbb{R}$.

En este caso $U = \delta \times \mathbb{R}$ y

$$f(x, y) = P(x) y + Q(x)$$

Notemos que se verifica lo siguiente:

- $U$ es una banda vertical de base compacta, pues $\delta$ es un intervalo compacto.

- Como $P(x)$ y $Q(x)$ son continuas en $\delta$, entonces $f$ es continua en $U$.

- Como $P(x)$ es continua en el intervalo $\delta$ y éste es compacto, entonces la función $P(x)$ es acotada, así que podemos fijar $L > 0$, tal que $|P(x)|< L$ para todo $x \in \delta$. Considerando esto tenemos que

\begin{align*}

|f(x, y_{1}) -f(x, y_{2})| &= |(P(x) y_{1} + Q(x)) -(P(x) y_{2} + Q(x))| \\

&= |P(x) y_{1} -P(x) y_{2}| \\

&= |P(x) ||y_{1} -y_{2}| \\

&\leq L|y_{1} -y_{2}|

\end{align*}

esto es

$$|f(x, y_{1}) -f(x, y_{2})| \leq L|y_{1} -y_{2}| \label{33} \tag{33}$$

para cada par de puntos $(x, y_{1}), (x, y_{2}) \in U$ es decir, $f$ es una función lipschitziana.

Por tanto, se cumplen las condiciones del teorema de existencia y unicidad global. En consecuencia ratificamos el resultado visto anteriormente en el que se asegura que cualquier problema de valor inicial asociado a una ecuación lineal posee solución única en el intervalo $\delta$. Además, ahora podemos afirmar que las iterantes de Picard asociadas convergen uniformemente hacia la solución del PVI.

$\square$

Un resultado importante que debemos revisar es que si dos problemas de valor inicial tienen valores iniciales muy cercanos entre sí, entonces las soluciones a cada PVI serán funciones muy próximas. A esto le llamamos dependencia continua de las soluciones respecto a condiciones iniciales. Revisemos este resultado. En la demostración será de uso esencial el lema de Gronwall.

Dependencia continua de la condición inicial

$$R = \{(x, y) \in \mathbb{R} \mid |x -x_{0}| \leq a, |y -y_{0}| \leq b, \hspace{0.2cm} a, b \in \mathbb{R} \}$$ siendo $f$ una función lipschitziana respecto de la segunda variable en $R$. Si $y(x)$ y $\hat{y}(x)$ son soluciones a los problemas de condición inicial

$$\dfrac{dy}{dx} = f(x, y); \hspace{1cm} y(x_{0}) = y_{0}$$ y

$$\dfrac{d\hat{y}}{dx} = f(x, \hat{y}); \hspace{1cm} \hat{y}(x_{0}) = \hat{y_{0}}$$ respectivamente, entonces

$$|y(x) -\hat{y}(x)| \leq |y_{0} -\hat{y}_{0}| e^{L |x -x_{0}|} \label{34} \tag{34}$$

Demostración: Como $y(x)$ y $\hat{y}(x)$ son solución de sus respectivos PVI, entonces cada solución verifica una ecuación integral.

$$y(x) = y_{0} + \int_{x_{0}}^{x}f(t, y(t)) dt \hspace{1cm} y \hspace{1cm} \hat{y}(x) = \hat{y}_{0} + \int_{x_{0}}^{x}f(t, \hat{y}(t)) dt$$

Vemos que

\begin{align*}

|y(x) -\hat{y}(x)| &= \left| y_{0} -\hat{y}_{0} + \int_{x_{0}}^{x} f(t, y(t)) dt -\int_{x_{0}}^{x}f(t, \hat{y}(t)) dt \right| \\

&\leq |y_{0} -\hat{y}_{0}| + \left| \int_{x_{0}}^{x} f(t, y(t)) -f(t, \hat{y}(t)) dt \right | \\

&\leq |y_{0} -\hat{y}_{0}| + \int_{x_{0}}^{x}\left| f(t, y(t)) -f(t, \hat{y}(t)) \right| dt

\end{align*}

Sabemos que $f$ es una función lipschitziana respecto de la segunda variable en $R$ de manera que

$$|f(x, y(x)) -f(x, \hat{y}(x)) | \leq L | y(x) -\hat{y}(x)| \label{35} \tag{35}$$

con $L$ la constante de Lipschitz para $f$ en $R$. Entonces,

$$|y(x) -\hat{y}(x)| \leq |y_{0} -\hat{y}_{0} | + L \int_{x_{0}}^{x} |y(t) -\hat{y}(t)|dt \label{36} \tag{36}$$

Definamos

$$0 < g(x) = |y(x) -\hat{y}(x)|, \hspace{1cm} \alpha = |y_{0} -\hat{y}_{0}| \hspace{1cm} y \hspace{1cm} \beta = L$$

Con esto la desigualdad (\ref{36}) la podemos reescribir como

$$0 < g(x) \leq \alpha +\beta \int_{x_{0}}^{x}g(t) dt$$

Ahora podemos aplicar el lema de Gronwall.

$$g(x) \leq \alpha e^{\beta (x -x_{0})}$$

es decir,

$$|y(x) -\hat{y}(x)| \leq |y_{0} -\hat{y}_{0}| e^{L(x -x_{0})}$$

Que es lo que queríamos demostrar.

$\square$

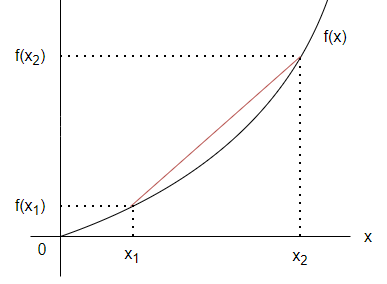

De este resultado observamos que si

$$y_{0} \rightarrow \hat{y}_{0} \hspace{1cm} \Rightarrow \hspace{1cm} |y_{0} -\hat{y}_{0}| \rightarrow 0$$

Entonces las soluciones de los PVI serán funciones muy próximas

$$|y(x) -\hat{y}(x)| \rightarrow 0 \hspace{1cm} \Rightarrow \hspace{1cm} y(x) \rightarrow \hat{y}(x)$$

Para concluir la entrada hagamos un breve comentario sobre el resultado local del teorema de Picard y realicemos unos ejemplos al respecto.

Teorema de existencia y unicidad local

Recordemos que el resultado local del teorema de existencia y unicidad de Picard – Lindelöf establece lo siguiente.

En tal situación, para cada $(x_{0}, y_{0}) \in R$, el problema de valor inicial

$$\dfrac{dy}{dx} = f(x, y); \hspace{1cm} y(x_{0}) = y_{0} \label{37} \tag{37}$$ posee una única solución definida en el intervalo $\delta = [x_{0} -h, x_{0} + h]$, donde

$$ h = min \left\{a,\dfrac{b}{M} \right\} \hspace{1cm} y \hspace{1cm} M \geq \max_{(x, y) \in R}|f(x, y)|$$ Además, las iterantes de Picard asociadas al PVI convergen uniformemente en el intervalo $\delta$ hacia la solución del PVI.

La demostración a este teorema corresponde a una adaptación de la demostración vista para el caso global, teniendo en cuenta que las gráficas de las iterantes de Picard, así como la de cualquier posible solución, definidas en el intervalo $\delta = [x_{0} -h, x_{0} + h]$, están dentro del rectángulo $R$ donde la función $f$ es continua y lipschitziana respecto de la segunda variable. Los pasos claves a seguir y las técnicas son prácticamente una repetición de lo visto anteriormente cambiando la banda vertical $U = [a, b] \times \mathbb{R}$ por el rectángulo

$$R = \{(x, y) \in \mathbb{R} \mid |x -x_{0}| \leq a, |y -y_{0}| \leq b, \hspace{0.2cm} a, b \in \mathbb{R} \}$$

Para conocer sobre los detalles puedes revisar la demostración del teorema local en los videos de este mismo curso.

Finalmente, resolvamos algunos ejemplos.

Ejemplo: Mostrar que el problema de valor inicial

$$\dfrac{dy}{dx} = \sin^{2}{(x -y)}; \hspace{1cm} y(0) = 0$$

posee una única solución definida en $\mathbb{R}$.

Solución: En este caso tenemos la función $f: U = \mathbb{R} \times \mathbb{R} \rightarrow \mathbb{R}$ definida como

$$f(x, y) = \sin^{2}{(x -y)}$$

Es claro que $f$ es continua en la región $U = \mathbb{R} \times \mathbb{R}$. La función derivada parcial $\dfrac{\partial f}{\partial y}: U \rightarrow \mathbb{R}$ está dada como

$$\dfrac{\partial f}{\partial y} = -2 \sin{(x -y) \cos{(x -y)}}$$

Como

$$|\sin{(x -y)}| \leq 1 \hspace{1cm} y \hspace{1cm} |\cos{(x -y)}| \leq 1$$

para todo $(x, y) \in U$, entonces

$$\left| \dfrac{\partial f}{\partial y} (x, y) \right| \leq 2$$

para todo $(x, y) \in U$. En consecuencia $f$ es una función lipschitziana en $U$ respecto de la segunda variable. Con esto hemos probado que se satisfacen las hipótesis del teorema de existencia y unicidad global por lo que podemos asegurar que el PVI posee una única solución definida en $\mathbb{R}$.

$\square$

Calcular las iterantes no siempre será sencillo. En el ejemplo anterior las iterantes pueden no ser fácil de desarrollar, pero debido a que satisface el teorema de Picard – Lindelöf podemos asegurar que dichas iterantes van a converger a la solución del PVI.

Ejemplo: Mostrar que aplicando el resultado global del teorema de Picard – Lindelöf al problema de valor inicial

$$\dfrac{dy}{dx} = y^{2}; \hspace{1cm} y(0) = 1$$

no es posible asegurar la existencia y unicidad de la solución.

Solución: La función $f: U = \mathbb{R} \times \mathbb{R} \rightarrow \mathbb{R}$ definida como

$$f(x, y) = y^{2}$$

es continua en $U = \mathbb{R} \times \mathbb{R}$, sin embargo su derivada parcial

$$\dfrac{\partial f}{\partial y} = 2y$$

no está acotada en $U$ por lo que $f$ no es una función lipschitziana en $U$.

Una observación más es que la solución al PVI dada por

$$y(x) = \dfrac{1}{1 -x}$$

no está definida en $\mathbb{R}$ si no en el intervalo $(-\infty, 1)$.

En definitiva, como no se cumple la tercera condición del teorema global, entonces no podemos asegurar nada sobre la existencia y unicidad de la solución del PVI.

$\square$

Veamos ahora la importancia del resultado local del teorema de existencia y unicidad de Picard – Lindelöf . Resolvamos de nuevo el ejemplo anterior, pero ahora considerando una región $R$ alrededor del punto dado por la condición inicial.

Ejemplo: Mostrar que aplicando el resultado local del teorema de Picard – Lindelöf, el problema de valor inicial

$$\dfrac{dy}{dx} = y^{2}; \hspace{1cm} y(0) = 1$$

posee una única solución. Encontrar el intervalo de existencia y unicidad.

Solución: Es claro que la función

$$f(x, y) = y^{2}$$

es continua en $\mathbb{R}^{2}$ por lo que $f$ será una función lipschitziana en cualquier conjunto $R$ convexo y compacto. Consideremos el rectángulo centrado en el valor inicial $(0, 1)$ de dimensiones $a = 2$ y $b = 1$, es decir

$$R = \{(x, y) \in \mathbb{R} \mid |x| \leq 2, |y -1| \leq 1\} = [-2, 2] \times [0, 2]$$

En la región $R$ la función $f$ si es lipschitziana y continua por lo que se satisfacen las condiciones del teorema local de existencia y unicidad de Picard. Este teorema nos dice que existe una única solución definida en el intervalo $\delta = [x_{0} -h, x_{0} + h]$ donde

$$ h = \min \left\{a,\dfrac{b}{M} \right\} \hspace{1cm} y \hspace{1cm} M \geq \max_{(x, y) \in R}|f(x, y)|$$

En este caso, como el máximo valor que puede tomar $y$ en el rectángulo $R$ es $y = 2$, entonces

$$M = \max_{(x, y) \in R}|f(x, y)| = \max_{(x, y) \in R}|y^{2}| = 4$$

Usando este resultado, se tiene

$$h = \min \left\{a,\dfrac{b}{M} \right\} = \min \left\{2,\dfrac{1}{4} \right\} = \dfrac{1}{4}$$

Por lo tanto, podemos asegurar la existencia y unicidad de la solución del PVI en el intervalo

$$\delta = [x_{0} -h, x_{0} + h] = \left[ -\dfrac{1}{4}, \dfrac{1}{4} \right]$$

Además podemos asegurar que las iterantes de Picard convergen uniformemente en el intervalo $\delta$ hacia la solución única del PVI. A saber, convergen a

$$y(x) = \dfrac{1}{1 -x}$$

$\square$

Con esto concluimos la primera unidad del curso.

Tarea moral

Los siguientes ejercicios no forman parte de la evaluación del curso, pero servirán para entender mucho mejor los conceptos vistos en esta entrada, así como temas posteriores.

- Completar la demostración de la unicidad de la solución a un problema de valor inicial que cumple con las hipótesis del teorema global de existencia y unicidad. Recuerda que el objetivo es demostrar que $$\lim_{n \to \infty} |\hat{y}(x) -y_{n}(x)| = 0$$

- Comprobar que el problema de valor inicial $$\dfrac{dy}{dx} = \dfrac{y}{x}; \hspace{1cm} y(0) = 0$$ posee infinitas soluciones en cualquier intervalo $\delta$ en el que $0 \in \delta$.

¿Porqué no contradice esto al teorema de existencia y unicidad local?.

- Determinar, por el método de iterantes de Picard, la solución del siguiente problema de valor inicial: $$\dfrac{dy}{dx} = 2y(1 + x); \hspace{1cm} y(-1) = 1$$

- Comprobar que el mayor intervalo que proporciona el teorema local de existencia y unicidad de Picard para el problema de valor inicial $$\dfrac{dy}{dx} = 1 + x^{2}; \hspace{1cm} y(0) = 0$$ donde se asegura la existencia y unicidad de la solución, es $\delta = \left[-\dfrac{1}{2}, \dfrac{1}{2} \right]$.

Más adelante…

Con la demostración del teorema de existencia y unicidad de Picard – Lindelöf justificamos la teoría realizada a lo largo de esta primera unidad.

En la siguiente entrada comenzaremos la unidad 2 del curso. En dicha unidad estudiaremos las ecuaciones diferenciales de orden mayor a uno, en particular estudiaremos con mayor detalle las ecuaciones diferenciales de segundo orden.

Entradas relacionadas

- Página principal del curso: Ecuaciones Diferenciales I

- Entrada anterior del curso: Teorema de Existencia y Unicidad – Iterantes de Picard y Convergencia

- Siguiente entrada del curso: Ecuaciones diferenciales de orden superior

- Video relacionado al tema: Teorema de Existencia y Unicidad de Picard

Agradecimientos

Trabajo realizado con el apoyo del Programa UNAM-DGAPA-PAPIME PE104522 «Hacia una modalidad a distancia de la Licenciatura en Matemáticas de la FC-UNAM – Etapa 2»