Introducción

En la entrada anterior revisamos el teorema de la función implícita formalmente enunciado y demostrado. En ésta lo que haremos será reflexionar sobre él y observar con más detalle su propósito y usos.

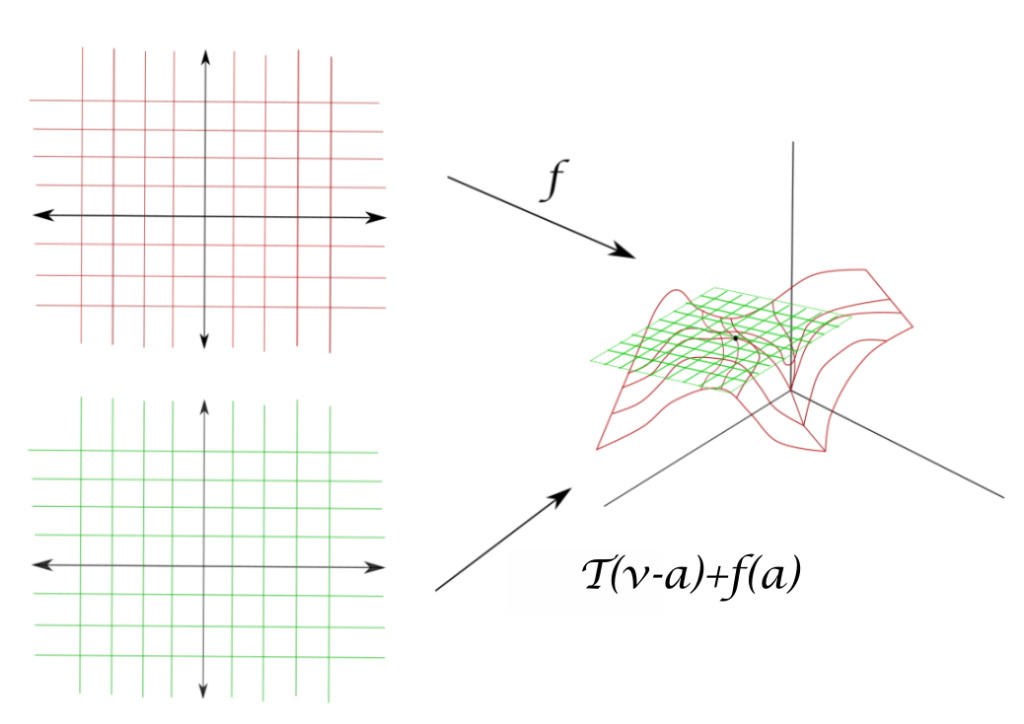

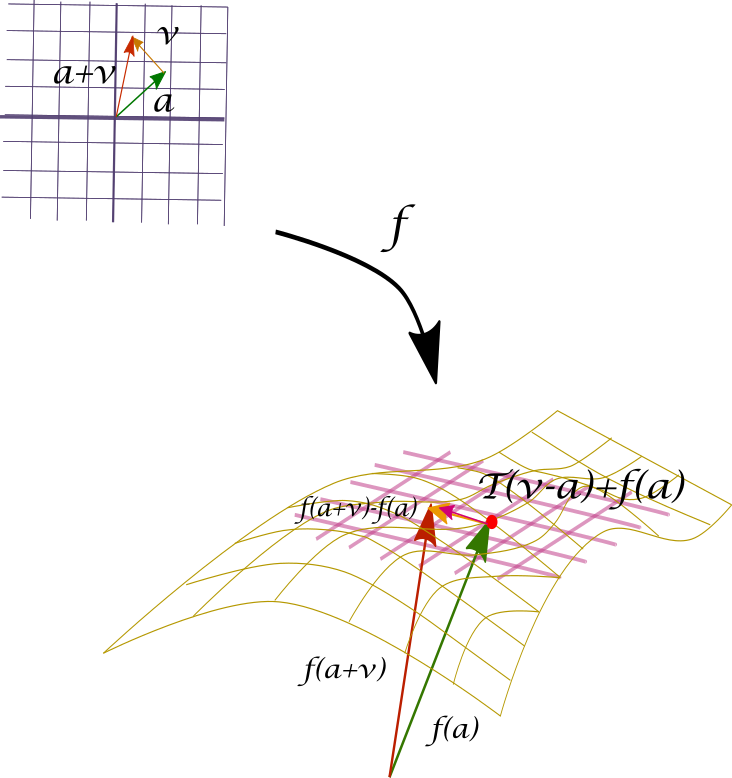

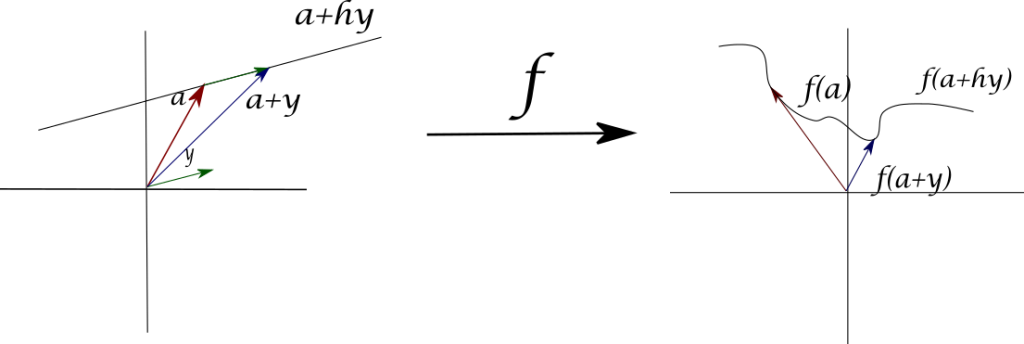

Dicho de forma simplista pero resaltando su objetivo principal el teorema de la función implícita busca establecer las condiciones bajo las cuales podemos despejar unas variables en término de otras. Da una condición en términos de cierta diferenciabilidad. Como esbozamos en la entrada anterior, lo que el teorema nos dice es cuándo es posible despejar las variables de un sistema de ecuaciones (o funciones coordenadas de un campo vectorial) en función de ciertas las variables libres, y alrededor de una vecindad. Para hacer esto, básicamente hay que resolver un sistema de ecuaciones en donde ciertos coeficientes vienen de ciertas derivadas parciales. El teorema de la función implícita también habla de cómo derivar una función definida implícitamente respecto de cualquiera de sus derivables.

¿Por qué teorema de la función implícita?

¿Por qué este nombre? En numerosos problemas matemáticos derivados de aplicaciones diversas se utilizan modelos geométricos. Estos modelos geométricos usualmente se construyen a partir de restringir ciertas variables con ciertas ecuaciones. Pensemos en objetos geométricos en tres dimensiones. Tenemos variables $x,y,z$. Definamos $G(x,y,z):=x^{2}+y^{2}+z^{2}-1$. Podemos preguntarnos por el objeto geométrico descrito por la ecuación $G(x,y,z)=0.$ Sabemos que las ternas $(x,y,z)$ que satisfacen esto justo conforman una esfera de radio 1 centrada en el origen. Decimos que esta ecuación proporciona una representación implícita de la superficie.

Pero quizás nuestra aplicación nos lleva a preguntarnos si alguna coordenada está en términos de las otras para los puntos que están en dicha esfera. En afortunadas ocasiones es posible despejar en la ecuación $G(x,y,z)$ algunas de las variables en términos de las otras. Esto nos lleva a una o varias ecuaciones de la forma $z=g(x,y)$, en nuestro caso particular tenemos:

\begin{align*}z=\sqrt{1-x^{2}-y^{2}} && \textup{y} && z=-\sqrt{1-x^{2}-y^{2}}.\end{align*}

El teorema de la función inversa nos dice que si ciertas derivadas existen y son invertibles como transformaciones lineales, entonces podemos hacer estos despejes. De hecho, nos dice algo mejor: que podemos hacerlos alrededor de toda una vecindad donde no se anule dicha derivada. De aquí sale la idea de «función implícita». Algunas ecuaciones, aunque no permitan despejar variables, sí lo permiten «localmente» y entonces ahí hay una «función oculta».

En la gran mayoría de los casos es difícil lograr estos despejes mediante expresiones algebraicas sencillas por ejemplo en una superficie representada por la ecuación $y^{3}+z^{2}-xz+e^{zx}-4=0$ suena muy difícil que podamos despejar $z$. Sin embargo el teorema de la función implícita nos garantiza que, aunque no sepamos cómo, la variable $z$ sí se puede poner en función de las variables $x$ y $y$.

La derivada de la función implícita

Otra buena notica es que aunque no conozcamos explícitamente el despeje que nos interesa, con el teorema de la función implícita sí podemos encontrar las derivadas parciales de la función implícita que aparece. Si pensaste los problemas de la tarea moral de la entrada anterior, quizás ya hayas llegado al siguiente resultado.

Corolario. Sea $F:S\subseteq \mathbb{R}^{n}\rightarrow \mathbb{R}$ un campo escalar diferenciable con $S$ abierto. Supongamos que la ecuación $F(x_{1},\dots ,x_{n})=0$ define implícitamente a $x_{n}$ como función diferenciable de $x_{1},\dots ,x_{n-1}$ como $x_{n}=f(x_{1},\dots ,x_{n-1})$, para todos los puntos $(x_{1},\dots ,x_{n-1})\in S’\subseteq \mathbb{R}^{n-1}$, entonces para cada $k=1,2,\dots ,n-1$ la derivada parcial $\frac{\partial f}{\partial x_{k}}$ está dada por la fórmula:

\[ \begin{equation}\frac{\partial f}{\partial x_{k}}=-\frac{\frac{\partial F}{\partial x_{k}}}{\frac{\partial F}{\partial x_{n}}}\end{equation} \]

en los puntos en los que $\frac{\partial F}{\partial x_{n}}\neq 0$. Las derivadas parciales de $F$ están calculadas en el punto $(x_{1},\dots ,x_{n-1},f(x_{1},\dots ,x_{n}))$.

Demostración. Pensemos $F:\mathbb{R}^{n-1}\times \mathbb{R} \to \mathbb{R}$. Si $(x_{1},\dots x_{n})$ es tal que $F(x_{1},\dots ,x_{n})=0$, por el teorema de la función implícita tenemos a una única función $f:\mathbb{R}^{n-1}\rightarrow \mathbb{R}$ tal que $F(x_{1},\dots ,x_{n-1},f(x_{1},\dots ,x_{n-1}))=0$.

(Nota. En la entrada anterior teníamos entradas de la forma $(y,x)$ y $y$ quedaba en función de $x$. De manera totalmente análoga podemos intercambiar los papeles de $x$ y $y$, pidiendo las hipótesis correctas. De hecho, usualmente se piensa en parejas $(x,y)$ y las variables de $y$ son las que quedan en términos de las variables $x$)

Ahora, pensemos en el campo vectorial $G:S’\subseteq \mathbb{R}^{n-1}\rightarrow \mathbb{R}^{n}$ dado por $G(x_{1},\dots ,x_{n-1})=(x_{1},\dots ,x_{n-1},f(x_{1},\dots ,x_{n-1}))$. Así $(F\circ G)(x_{1},\dots ,x_{n-1})=0$. Por regla de la cadena, $DFDG=0$. Tenemos así $0=\triangledown F\cdot DG$, lo cual explícitamente es:

\[ 0=\begin{bmatrix} \frac{\partial F}{\partial x_{1}} & \dots & \frac{\partial F}{\partial x_{n}} \end{bmatrix} \begin{bmatrix} 1 & 0 & \dots & 0 \\ 0 & 1 & \dots & 0 \\ \vdots & \vdots & \vdots & \vdots \\ 0 & 0 & \dots & 1 \\ \frac{\partial f}{\partial x_{1}} & \frac{\partial f}{\partial x_{2}} & \dots & \frac{\partial f}{\partial x_{n-1}} \end{bmatrix}= \]

\[ \begin{bmatrix} \frac{\partial F}{\partial x_{1}}+\frac{\partial F}{\partial x_{n}}\frac{\partial f}{\partial x_{1}} & \frac{\partial F}{\partial x_{2}}+\frac{\partial F}{\partial x_{n}}\frac{\partial f}{\partial x_{2}} & \dots & \frac{\partial F}{\partial x_{n-1}}+\frac{\partial F}{\partial x_{n}}\frac{\partial f}{\partial x_{n-1}} \end{bmatrix}.\]

Por ello, para cada $i$ tenemos:

\[ \frac{\partial F}{\partial x_{i}}+\frac{\partial F}{\partial x_{n}}\frac{\partial f}{\partial x_{i}}=0.\]

De esta ecuación se deduce la $(1)$.

$\square$

Un primer ejemplo del teorema de la función inversa

Pasemos ahora a hacer algunas cuentas concretas para entender mejor lo que uno tiene que hacer para aplicar el teorema de la función implícita en funciones particulares.

Ejemplo. Consideremos la ecuación $y^{2}+xz+z^{2}-e^{z}-c=0$. Expresaremos a $z$ en función de $x$ e $y$, es decir, $z=f(x,y)$. Nos gustaría encontrar un valor de la constante $c$ tal que $f(0,e)=2$. Para dicha $c$, queremos calcular las derivadas parciales con respecto a $x$ y $y$ en el punto $(x,y)=(0,e)$.

Para la primera parte sustituimos $x=0$, $y=e$ y $z=2$. Tenemos $$e^{2}+0\cdot 2+2^{2}-e^{2}-c=0,$$ que es lo mismo que $4-c=0$, y esto implica $c=4$. De esta manera, estudiaremos la función $$F(x,y,z)=y^{2}+xz+z^{2}-e^{z}-4.$$

Notemos que

\begin{align*}\frac{\partial F}{\partial z}=x+2z-e^{z},&&\frac{\partial F}{\partial x}=z,&&\frac{\partial F}{\partial y}=2y,\end{align*}

por lo cual

\begin{align*} \frac{\partial f}{\partial x}=-\frac{z}{x+2z-e^{z}},&&\frac{\partial f}{\partial y}=-\frac{2y}{x+2z-e^{z}}.\end{align*}

Así para $x=0$, $y=e$ y $z=2$ al sustituir resulta

\begin{align*} \frac{\partial f}{\partial x}(0,e)=\frac{2}{e^{2}-4}&&\textup{y}&&\frac{\partial f}{\partial y}(0,e)=\frac{2e}{e^{2}-4}. \end{align*}

$\triangle$

En este ejemplo vemos cómo hemos podido calcular las derivadas parciales de $z=f(x,y)$ usando el valor de $f$ en el punto $(0,e)$, sin conocer quién es la función $f(x,y)$.

Un repaso chiquito de la demostación del teorema de la función implícita

Ahora repasaremos la demostración del teorema de la función implícita pero para un caso muy particular: Dos superficies $S_{1}$ y $S_{2}$ en el espacio con las siguientes representaciones implícitas:

$$ \textup{para}\hspace{0.3cm}S_{1}:\Psi (x,y,z)=0\hspace{1cm}\textup{y}\hspace{1cm}\textup{para}\hspace{0.3cm}S_{2}:\Gamma (x,y,z)=0.$$

Supongamos que las superficies se cortan en la curva $\mathfrak{C}$. En otras palabras, $\mathfrak{C}$ es el conjunto solución para el siguiente sistema de ecuaciones:

\[ \left \{\begin{matrix} \Psi (x,y,z)=0 \\ \Gamma (x,y,z)=0. \end{matrix} \right.\]

Supongamos que podemos despejar $x$ y $y$ en estas ecuaciones en términos de $z$ de la siguiente manera:

\[ \begin{equation}x=X(z),\hspace{1cm}y=Y(z)\hspace{0.3cm}\textup{para todo}\hspace{0.1cm}z\in (a,b).\end{equation} \]

Aquí, al reemplazar $x$ y $y$ por $X(z)$ y $Y(z)$ (respectivamente), el sistema $(2)$ se satisface. Por tanto tenemos $\Psi (X(z),Y(z),z)=0$ y $\Gamma (X(z),Y(z),z)=0$ para todo $z\in (a,b)$. Podemos calcular las derivadas $X^{\prime}(z)$, $Y^{\prime}(z)$, sin un conocimiento explícito de $X(z)$ y $Y(z)$.

¿Cómo hacemos esto? Consideramos las siguientes funciones auxiliares:

\begin{align*}

\psi (z)&=\Psi (X(z),Y(z),z),\\

\gamma (z)&=\Gamma (X(z),Y(z),z).

\end{align*}

Tenemos $\psi (z)=\gamma (z)=0$ y en consecuencia $\psi^{\prime}(z)=\gamma^{\prime}(z)=0$.

Derivando con la regla de la cadena tenemos:

\begin{align*}

\psi^{\prime}(z)&=\frac{\partial \Psi}{\partial x}X'(z)+\frac{\partial \Psi}{\partial y}Y'(z)+\frac{\partial \Psi}{\partial z},\\

\gamma^{\prime}(z)&=\frac{\partial \Gamma}{\partial x}X'(z)+\frac{\partial \Gamma}{\partial y}Y'(z)+\frac{\partial \Gamma}{\partial z}

\end{align*}

Dado que $\psi^{\prime} (z)=\gamma^{\prime}(z)=0$ tenemos el siguiente sistema de dos ecuaciones con dos incógnitas $X^{\prime}(z)$, $Y^{\prime}(z)$:

\[ \left \{\begin{matrix}\frac{\partial \Psi}{\partial x}X^{\prime}(z)+\frac{\partial \Psi}{\partial y}Y^{\prime}(z)=-\frac{\partial \Psi}{\partial z}\\ \frac{\partial \Gamma}{\partial x}X^{\prime}(z)+\frac{\partial \Gamma}{\partial y}Y^{\prime}(z)=-\frac{\partial \Gamma}{\partial z} \end{matrix} \right.\]

En los puntos en los cuales el determinante del sistema no es cero, usamos la regla de Cramer para obtener las soluciones como sigue:

\[ X^{\prime}(z)={\Large -\frac{\begin{vmatrix}\frac{\partial \Psi}{\partial z} & \frac{\partial \Psi}{\partial y}\\ \frac{\partial \Gamma}{\partial z} & \frac{\partial \Gamma }{\partial y}\end{vmatrix}}{\begin{vmatrix}\frac{\partial \Psi}{\partial x} & \frac{\partial \Psi}{\partial y} \\ \frac{\partial \Gamma}{\partial x} & \frac{\partial \Gamma}{\partial z} \end{vmatrix}} },\hspace{0.5cm}Y^{\prime}(z)={\Large -\frac{\begin{vmatrix}\frac{\partial \Psi}{\partial x} & \frac{\partial \Psi}{\partial z}\\ \frac{\partial \Gamma}{\partial x} & \frac{\partial \Gamma }{\partial z}\end{vmatrix}}{\begin{vmatrix}\frac{\partial \Psi}{\partial x} & \frac{\partial \Psi}{\partial y} \\ \frac{\partial \Gamma}{\partial x} & \frac{\partial \Gamma}{\partial z} \end{vmatrix}} }.\]

Otro ejemplo para encontrar derivadas de funciones implícitas

Veamos un último ejemplo en donde pondemos usar las ideas anteriores.

Ejemplo. Consideremos las ecuaciones $y=uv^{2}$, y $x=u+v$. Queremos ver que podemos determinar una función $h$ tal que $v=h(x,y)$ y para la cual:

\[ \frac{\partial h}{\partial x}(x,y)= \frac{h(x,y)}{3h(x,y)-2x}.\]

Además, queremos encontrar una fórmula análoga para $\frac{\partial h}{\partial y}$.

Primero, en la ecuación $x=u+v$ despejamos $u$ y sustituimos en $y=uv^{2}$, tenemos $y=(x-v)v^{2}$. De aquí $$xv^{2}-v^{3}-y=0.$$ Esto nos sugiere pensar en la función $$F(x,y,v):=xv^{2}-v^{3}-y,$$ pues nos permite representar nuestra ecuación como $F(x,y,v)=0$. Por el teorema de la función implícita (¡verifica las hipótesis!), esta ecuación define implícitamente a $v$ como función de $x$ e $y$, digamos, como $v=h(x,y)$. Aplicando las fórmulas que conocemos para las derivadas de la función implicita, tenemos lo siguiente:

\[ \frac{\partial h}{\partial x}= -\frac{\partial F /\partial x}{\partial F /\partial v}\hspace{0.5cm}\textup{y}\hspace{0.5cm}\frac{\partial h}{\partial y}=-\frac{\partial F /\partial y}{\partial F /\partial v} \]

Donde $\frac{\partial F}{\partial x}=v^{2}$, $\frac{\partial F}{\partial v}=2xv-3v^{2}$ y $\frac{\partial F}{\partial y}=-1$. Luego tenemos:

\begin{align*} \frac{\partial h}{\partial x}(x,y)&=-\frac{v^{2}}{2xv-3v^{2}}\\ &=-\frac{v}{2x-3v}\\ &=\frac{h(x,y)}{3h(x,y)-2x}.\end{align*}

Esto muestra la primera parte. Para encontra la fórmula análoga, volvemos a usar las fórmulas para derivadas de la función implícita:

\begin{align*}\frac{\partial h}{\partial y}(x,y)&=-\frac{-1}{2xv-3v^{2}}\\ &=\frac{1}{2xh(x,y)-3h^{2}(x,y)}.\end{align*}

$\triangle$

Más adelante…

Hemos cubierto el teorema de la función inversa y el teorema de la función implícita. Estos son temas teóricos profundos e importantes que tienen muchas consecuencias. Tienen también otras versiones en contextos más amplios como variedades, geometría diferencial, etc. Por el momento, dejaremos hasta aquí nuestro estudio de estos temas, pero te recomendamos de vez en cuando repasarlos, pues cada vez entenderás más de sus demostraciones y lo que significan.

Nuestra atención se enfocará ahora en otros conceptos que se pueden definir en términos de funciones de varias variables: la divergencia, el laplaciano y el rotacional. Después, hablaremos un poco de cómo la teoría que hemos desarrollado nos ayudará a encontrar puntos críticos para funciones de varias variables.

Tarea moral

- Las ecuaciones $x+y=uv$ y $xy=u-v$ definen $x$ y $y$ como funciones implícitas de $u$ y $v$, sean éstas $x=X(u,v)$ y $y=Y(u,v)$. Demuestra que $\partial X/\partial u=(xv-1)/(x-y)$ si $x\neq y$, y halla las fórmulas para $\partial X/\partial v$, $\partial Y/\partial v$, $\partial Y/\partial u$.

- Las tres ecuaciones \[ \left\{\begin{matrix} x^{2}-y\hspace{0.1cm}cos\hspace{0.1cm}(uv)+z^{2}=0, \\ x^{2}+y^{2}-\hspace{0.1cm}sen\hspace{0.1cm}(uv)+2z^{2}=2, \\ xy-\hspace{0.1cm}sen\hspace{0.1cm}u\hspace{0.1cm}cos\hspace{0.1cm}v+z=0 \end{matrix}\right.\] definen $x$, $y$, y $z$ como funciones de $u$ y $v$. Calcula las derivadas parciales $\partial x/\partial u$ y $\partial x/\partial v$ en el punto $x=y=1$, $u=\pi /2$, $v=0$, $z=0$.

- Las ecuaciones $x+y=uv$ y $xy=u-v$ definen $x$ y $v$ como funciones de $u$ y $y$, sean éstas $x=X(u,v)$ y $v=V(u,y)$. Demuestra que $\partial X/\partial u=(u+v)/(1+yu)$ si $1+yu\neq 0$ y halla las fórmulas de $\partial X/\partial y$, $\partial V /\partial u$, $\partial V /\partial y$.

- Sigue las ideas de los resultados de la entrada anterior para escribir una calca de ella pero ahora para $f:S\subseteq \mathbb{R}^{m} \times \mathbb{R}^{l}$, en donde la función que se busca tiene ahora dominio en $\mathbb{R}^{m}$ que pone a las variables del dominio $\mathbb{R}^l$ en términos de las de $\mathbb{R}^m$.

- Haz un esfuerzo extra, y medita nuevamente en el teorema de la función implícita tratando de escribir una demostración de como sería el asunto para $f$ con dominio en $\mathbb{R}^{m}\times \mathbb{R}^{l}\times \mathbb{R}^{k}$. ¿Se podrá hallar la función $h$, pero ahora con dominio en $\mathbb{R}^{l}$?

Entradas relacionadas

- Ir a Cálculo Diferencial e Integral III

- Entrada anterior del curso: Teorema de la función inversa y demostración

- Entrada siguiente del curso: Divergencia, laplaciano y rotacional