(Trabajo de titulación asesorado por la Dra. Diana Avella Alaminos)

Introducción

En esta nota deduciremos propiedades importantes que tienen los determinantes, para ello usaremos la definición dada en la nota anterior. Sería conveniente que, si no lo has hecho, revisaras los ejemplos de la nota anterior para que sea más natural su deducción.

Propiedades

Sean $n$ un natural positivo, $k\in\{1,\dots ,n\}$, $A, A’, A^{\prime\prime}\in \mathscr M_{n\times n}(\mathbb R)$ y $\lambda\in \mathbb{R}.$

$1.$ Si $R_k^{\prime}$ y $R_k^{\prime\prime}$ son los renglones $k$ de $A’$ y $A^{\prime\prime}$ respectivamente, el renglón $k$ de $A$ es $R_k^{\prime}+R_k^{\prime\prime}$, y el resto de los renglones de $A, A’$ y $ A^{\prime\prime}$ coinciden, entonces:

$det\,A=det\,A’+det\,A^{\prime\prime}.$

$2.$ Si $A$ se obtiene de $A’$ multiplicando el renglón $k$ por $\lambda$, entonces:

$det\,A=\lambda det\,A’.$

$3.$ Si $A$ se obtiene de $A’$ intercambiando dos renglones, entonces:

$det\,A=- det\,A’.$

$4.$ Si $A$ tiene dos renglones iguales, entonces:

$det\,A=0.$

$5.$ Si $A$ se obtiene de $A’$ sumando a un renglón un múltiplo de otro, entonces:

$det\,A= det\,A’.$

$6.$ Si $A$ tiene un renglón de ceros, entonces:

$det\,A=0$

$7.$ $det\,A^t=det\,A.$

Ve el siguiente video con las demostraciones de las propiedades $1$ y $2$:

Demostración de las propiedades

Sean $n$ un natural positivo, $k,s\in\{1,\dots ,n\}$, $A, A’, A^{\prime\prime}\in \mathscr M_{n\times n}(\mathbb R)$ y $\lambda\in \mathbb{R}.$

Demostración de la propiedad 1

Supongamos que $a_{ij}=a_{ij}^{\prime}=a_{ij}^{\prime\prime}$ para todo $i\neq k$ y para todo $j$, supongamos también que $a_{kj}=a_{kj}^{\prime}+a_{kj}^{\prime\prime}$ para todo $j$. Por definición de determinante:

$\det\,A=\displaystyle\sum_{\sigma\in S_n}sgn\,\sigma\,a_{1\sigma(1)}\cdots a_{k\sigma(k)}\cdots a_{n\sigma(n)},$

y entonces por hipótesis $a_{k\sigma(k)}=a_{k\sigma(k)}^{\prime}+a_{k\sigma(k)}^{\prime\prime}.$

Así:

$\det\,A=\displaystyle\sum_{\sigma\in S_n}sgn\,\sigma\,a_{1\sigma(1)}\cdots ( a_{k\sigma(k)}^{\prime}+a_{k\sigma(k)}^{\prime\prime} )\cdots a_{n\sigma(n)}.$

Aplicando la propiedad distributiva de los reales tenemos que:

$\det\,A=\displaystyle\sum_{\sigma\in S_n}sgn\,\sigma\,a_{1\sigma(1)}\cdots a_{k\sigma(k)}^{\prime}\cdots a_{n\sigma(n)} + \displaystyle\sum_{\sigma\in S_n}sgn\,\sigma\,a_{1\sigma(1)}\cdots a_{k\sigma(k)}^{\prime\prime}\cdots a_{n\sigma(n)}$

y por hipótesis $a_{ij}=a_{ij}^{\prime}=a_{ij}^{\prime\prime}$ para todo $i\neq t$ y para todo $j$, por lo tanto:

$\det\,A=\displaystyle\sum_{\sigma\in S_n}sgn\,\sigma\,a_{1\sigma(1)}^{\prime}\cdots a_{k\sigma(k)}^{\prime}\cdots a_{n\sigma(n)}^{\prime} + \displaystyle\sum_{\sigma\in S_n}sgn\,\sigma\,a_{1\sigma(1)}^{\prime\prime}\cdots a_{k\sigma(k)}^{\prime\prime}\cdots a_{n\sigma(n)}^{\prime\prime}.$

Entonces por definición determinante tenemos que:

$det\,A=det\,A’+det\,A^{\prime\prime}.$

Demostración de la propiedad 2

Supongamos que $a_{ij}=a_{ij}^{\prime}$ para toda $ i\neq k$ y para toda $ j$, y que $a_{kj}=\lambda a_{kj}^{\prime}$ para toda $j$.

Por definición de determinante tenemos que:

$\det\,A=\displaystyle\sum_{\sigma\in S_n}sgn\,\sigma\,a_{1\sigma(1)}\cdots a_{k\sigma(k)}\cdots a_{n\sigma(n)}$

pero, por hipótesis, $a_{k\sigma(k)}=\lambda a_{k\sigma(k)}^{\prime}$, así:

$\det\,A=\displaystyle\sum_{\sigma\in S_n}sgn\,\sigma\,a_{1\sigma(1)}\cdots \lambda a_{k\sigma(k)}^{\prime}\cdots a_{n\sigma(n)}.$

También por hipótesis $a_{ij}=a_{ij}^{\prime}$ para toda $i\neq t$, entonces:

$\det\,A=\displaystyle\sum_{\sigma\in S_n}sgn\,\sigma\,a_{1\sigma(1)}^{\prime}\cdots \lambda a_{k\sigma(k)}^{\prime}\cdots a_{n\sigma(n)}^{\prime},$ y factorizando $\lambda$:

$\det\,A= \lambda \displaystyle\sum_{\sigma\in S_n}sgn\,\sigma\,a_{1\sigma(1)}^{\prime}\cdots a_{k\sigma(k)}^{\prime}\cdots a_{n\sigma(n)}^{\prime},$

entonces por definición:

$det\,A=\lambda det\,A’.$

Ve el siguiente video con las demostraciones de las propiedades $3$ y $4$

Demostración de la propiedad 3

Supongamos que $A$ se obtiene de $A’$ intercambiando los renglones $k$ y $s$.

Por definición tenemos que:

$\det\,A=\displaystyle\sum_{\sigma\in S_n}sgn\,\sigma\,a_{1\sigma(1)}\cdots a_{k\sigma(k)}\cdots a_{s\sigma(s)}\cdots a_{n\sigma(n)}$

Al intercambiar los renglones $k$ y $s$ tenemos que:

$a_{k\sigma(k)}=a_{s\sigma(k)}^{\prime}$ y $a_{s\sigma(s)}=a_{k\sigma(s)}^{\prime}$, y además $a_{i\sigma(i)}=a_{i\sigma(i)}^{\prime}$ para toda $i$ distinta de $k$ y de $s$.

Entonces:

$\det\,A=\displaystyle\sum_{\sigma\in S_n}sgn\,\sigma\,a_{1\sigma(1)}^{\prime}\cdots a_{s\sigma(k)}^{\prime}\cdots a_{k\sigma(s)}^{\prime}\cdots a_{n\sigma(n)}^{\prime}$

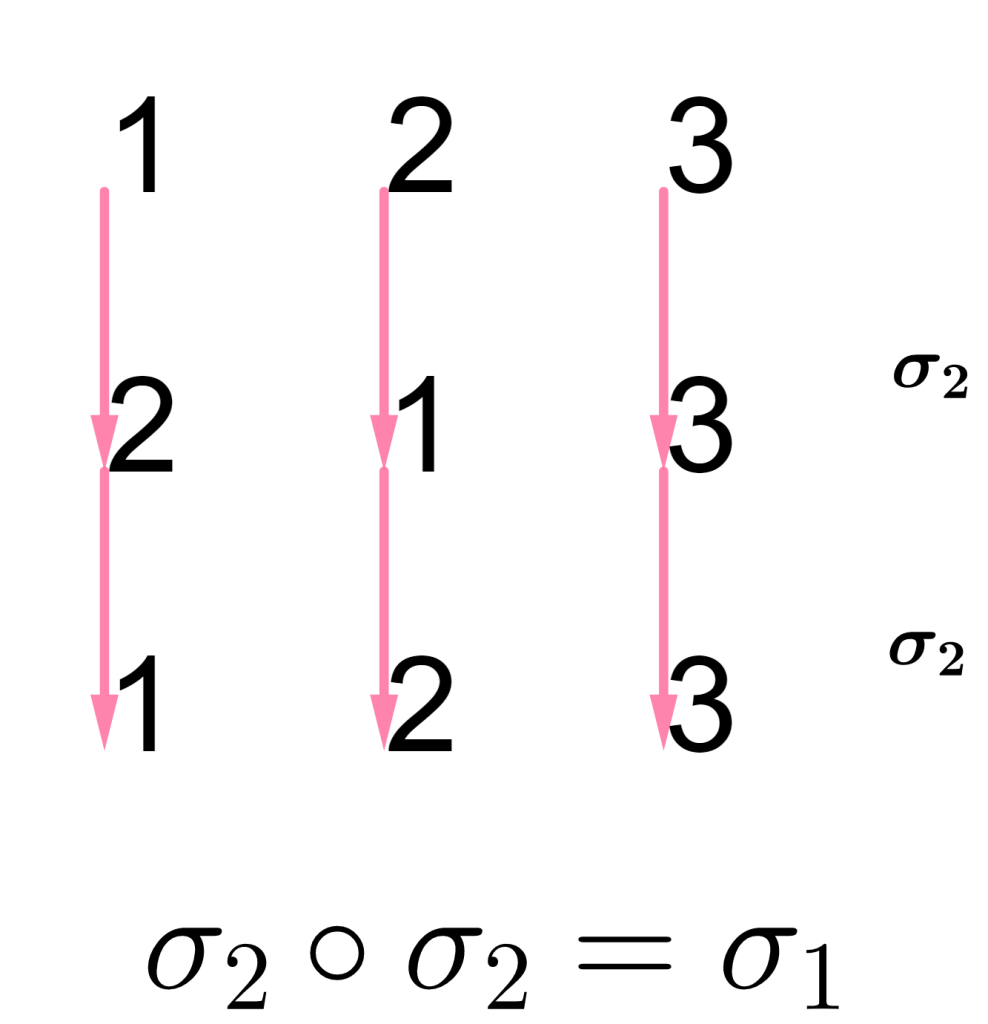

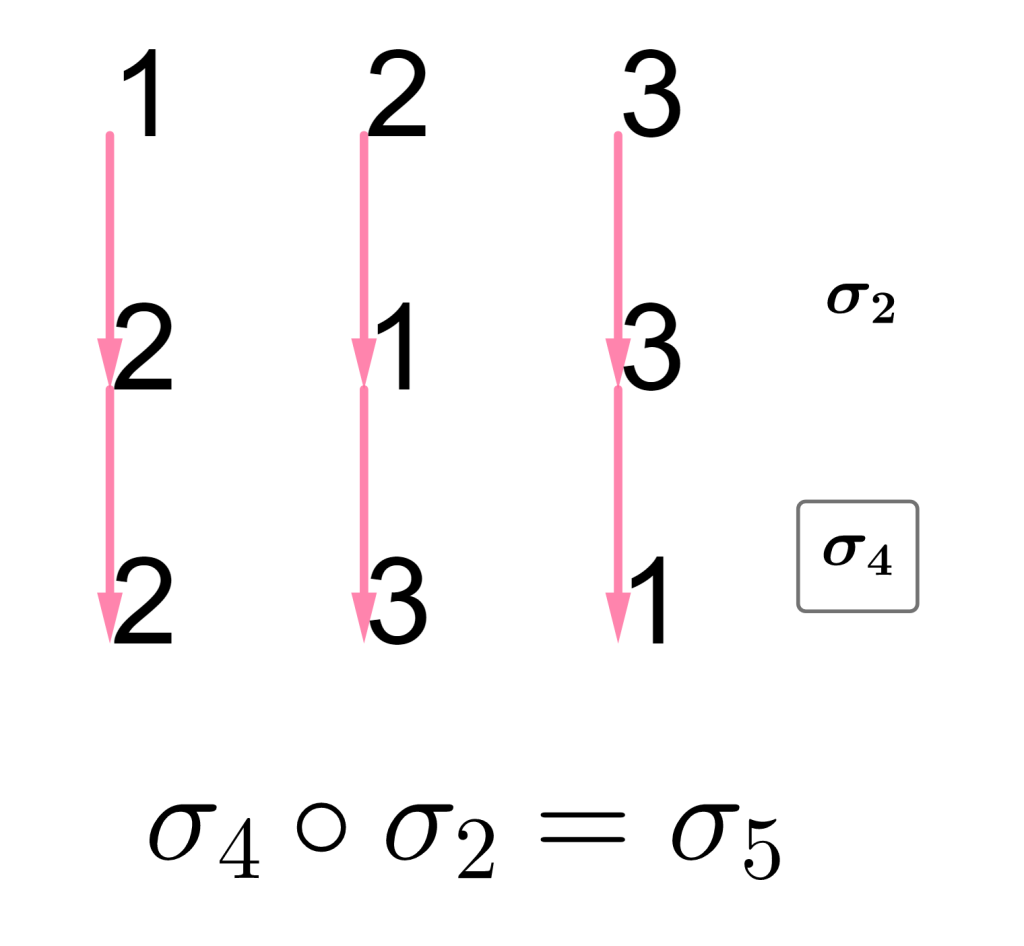

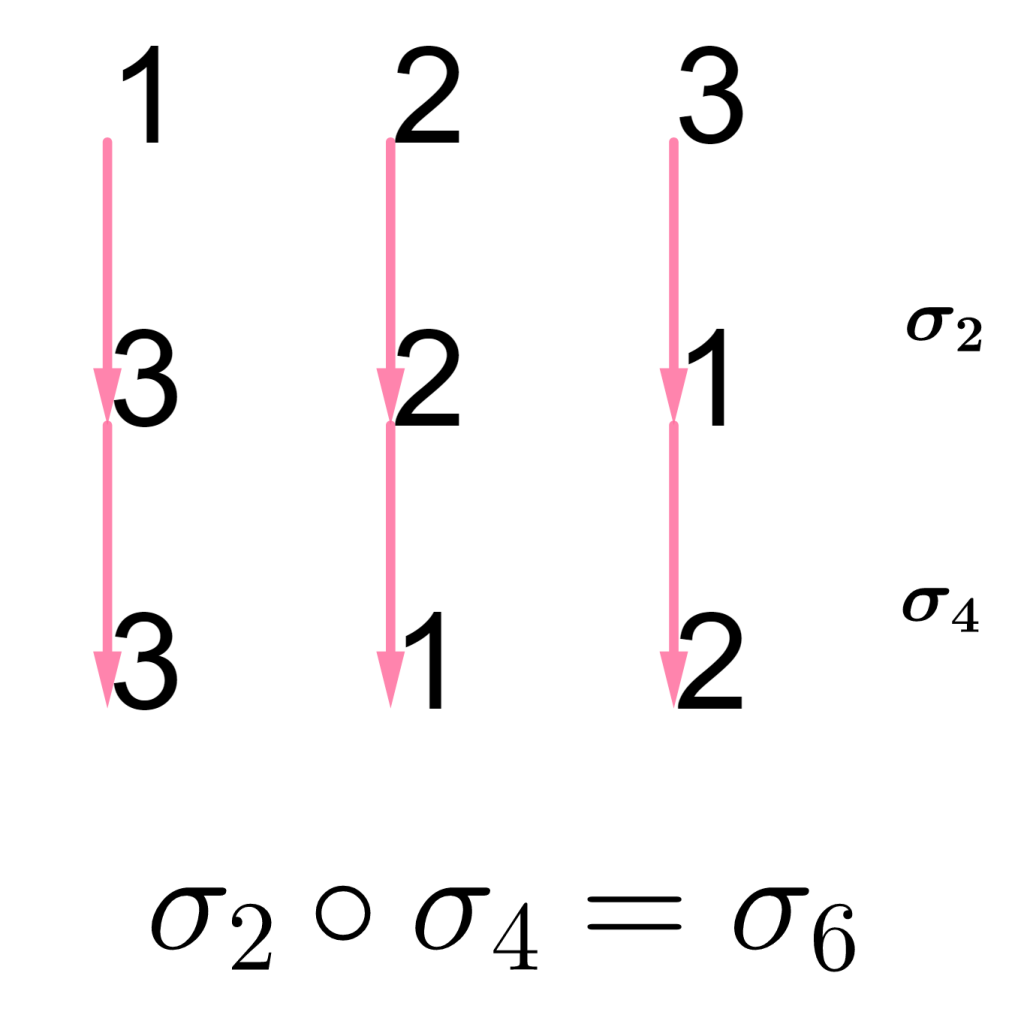

Observa que la permutación $\gamma = \begin{equation*} \left(\begin{array}{rrrrrrr} 1 & \cdots & k & \cdots & s & \cdots & n\\ \sigma(1) & \cdots & \sigma(s) & \cdots & \sigma(k) & \cdots & \sigma(n) \end{array}\right) \end{equation*}$ es muy parecida a $\sigma$ salvo en su evaluación en $k$ y en $s$. De modo más preciso $\tau\circ \sigma=\gamma$, con $\tau$ la transposición que intercambia a $\sigma(k)$ y a $\sigma(s)$. Entonces difieren sólo en una transposición y por lo tanto $sgn\,\sigma=-sgn\,\gamma$. Vamos a reescribir el determinante en términos de la permutación $\gamma$, y entonces:

$\det\,A=\displaystyle\sum_{\gamma\in S_n} – sgn\,\gamma\,a_{1\gamma(1)}^{\prime}\cdots a_{s\gamma(s)}^{\prime}\cdots a_{k\gamma(k)}^{\prime}\cdots a_{n\gamma(n)}^{\prime},$

entonces por definición tenemos que:

$det\,A=- det\,A’.$

Demostración de la propiedad 4

Supongamos que los renglones $k$ y $s$ de $A$ son iguales . Sea $A’$ la matriz que se obtiene de $A$ intercambiado sus renglones $k$ y $s$, entonces $A’=A$. Por la propiedad $3$ tenemos que $det\,A’=-det\,A$. Así:

$det\,A=- det\,A’=-det\,A,$

entonces $det\,A=-det\,A$. De aquí tenemos que $2det\,A=0$ y por lo tanto:

$det\,A=0$.

Ve el siguiente video con las demostraciones de las propiedades $5,6,7.$

Demostración de la propiedad 5

Supongamos que $A$ se obtiene de $A’$ sumando al renglón $s$, $\lambda$ veces el renglón $k.$

Entonces si:

$A’=\begin{equation*} \left(\begin{array}{ccccccc} a_{11}^{\prime} & && \cdots & && a_{1n}^{\prime}\\ \vdots & && \cdots & && \vdots\\a_{k1}^{\prime} & && \cdots & && a_{kn}^{\prime}\\ \vdots & && \cdots & && \vdots\\ a_{s1}^{\prime} & && \cdots & && a_{sn}^{\prime}\\ \vdots & && \cdots & && \vdots\\ a_{n1}^{\prime} & && \cdots & && a_{nn}^{\prime} \end{array}\right) \end{equation*}.$

Entonces $A$ es:

$A=\begin{equation*} \left(\begin{array}{ccccccc} a_{11}^{\prime} & &&\cdots &&& a_{1n}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\a_{k1}^{\prime} &&& \cdots &&& a_{kn}^{\prime}\\ \vdots &&& \cdots && &\vdots\\ a_{s1}^{\prime}+\lambda a_{k1}^{\prime} &&& \cdots &&& a_{sn}^{\prime}+\lambda a_{kn}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\ a_{n1}^{\prime} &&& \cdots &&& a_{nn}^{\prime} \end{array}\right) \end{equation*}.$

Por la propiedad $1$ tenemos que:

$detA=$ $det \begin{equation*} \left(\begin{array}{ccccccc} a_{11}^{\prime} & &&\cdots &&& a_{1n}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\a_{k1}^{\prime} &&& \cdots &&& a_{kn}^{\prime}\\ \vdots &&& \cdots && &\vdots\\ a_{s1}^{\prime}+\lambda a_{k1}^{\prime} &&& \cdots &&& a_{sn}^{\prime}+\lambda a_{kn}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\ a_{n1}^{\prime} &&& \cdots &&& a_{nn}^{\prime} \end{array}\right) \end{equation*}$ $=det \begin{equation*} \left(\begin{array}{ccccccc} a_{11}^{\prime} &&& \cdots &&& a_{1n}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\a_{k1}^{\prime} &&& \cdots &&& a_{kn}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\ a_{s1}^{\prime} &&& \cdots &&& a_{sn}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\ a_{n1}^{\prime} &&& \cdots &&& a_{nn}^{\prime} \end{array}\right) \end{equation*}$ $+det \begin{equation*} \left(\begin{array}{ccccccc} a_{11}^{\prime} &&& \cdots &&& a_{1n}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\a_{k1}^{\prime} &&& \cdots &&& a_{kn}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\ \lambda a_{k1}^{\prime} &&& \cdots &&& \lambda a_{kn}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\ a_{n1}^{\prime} &&& \cdots &&& a_{nn}^{\prime} \end{array}\right) \end{equation*},$

y por la propiedad $2$ tenemos que:

$det\,A=$ $det \begin{equation*} \left(\begin{array}{ccccccc} a_{11}^{\prime} &&& \cdots &&& a_{1n}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\a_{k1}^{\prime} &&& \cdots &&& a_{kn}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\ a_{s1}^{\prime} &&& \cdots &&& a_{sn}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\ a_{n1}^{\prime} &&& \cdots &&& a_{nn}^{\prime} \end{array}\right) \end{equation*}$ $+$ $\lambda det \begin{equation*} \left(\begin{array}{ccccccc} a_{11}^{\prime} &&& \cdots &&& a_{1n}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\a_{k1}^{\prime} &&& \cdots &&& a_{kn}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\ a_{k1}^{\prime} &&& \cdots &&& a_{kn}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\ a_{n1}^{\prime} &&& \cdots &&& a_{nn}^{\prime} \end{array}\right) \end{equation*},$

y como la matriz que aparece en el segundo sumando tiene dos renglones repetidos, su determinante es cero. Por lo tanto:

$det\,A=$ $det \begin{equation*} \left(\begin{array}{ccccccc} a_{11}^{\prime} &&& \cdots &&& a_{1n}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\a_{k1}^{\prime} &&& \cdots &&& a_{kn}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\ a_{s1}^{\prime} &&& \cdots &&& a_{sn}^{\prime}\\ \vdots &&& \cdots &&& \vdots\\ a_{n1}^{\prime} &&& \cdots &&& a_{nn}^{\prime} \end{array}\right) \end{equation*}=det A’$

Demostración de la propiedad 6

Si el renglón $k$ de $A$ es un renglón de ceros, al multiplicar el renglón $k$ por cero obtenemos $A$, así por la propiedad $2$:

$det\,A=0det\,A=0.$

Observación

Sea $\sigma\in S_n,\,\,sgn\,\sigma=sgn\,\sigma^{-1}$ ya que si $\sigma=\tau_m\circ\cdots\circ\tau_1$ es un producto de transposiciones entonces tenemos que $\sigma^{-1}=\tau_1\circ\cdots\circ\tau_m.$

Demostración de la propiedad 7

Sea $A^t=(b_{ij})$, entonces de la definición de determinante

$\det\,A^t=\displaystyle\sum_{\sigma\in S_n}sgn\,\sigma\,b_{1\sigma(1)}\cdots b_{n\sigma(n)}.$

Por la definición de transpuesta tenemos que $b_{i\sigma(i)}=a_{\sigma(i)i}$ para toda $i$, entonces:

$\det\,A^t=\displaystyle\sum_{\sigma\in S_n}sgn\,\sigma\,a_{\sigma(1)1}\cdots a_{\sigma(n)n}.$

Por la observación tenemos que:

$\det\,A^t=\displaystyle\sum_{\sigma\in S_n}sgn\,\sigma^{-1} \,a_{\sigma(1)\sigma^{-1}(\sigma(1))}\cdots a_{\sigma(n)\sigma^{-1}(\sigma(n))}.$

Observemos que cada factor $a_{\sigma(i)\sigma^{-1}(\sigma(i))}$, es de la forma $a_{j\sigma^{-1}(j)}$ con $j\in\{1,2,\dots ,n\}$, entonces reacomodando dichos factores en orden creciente de acuerdo al valor de $j$ tenemos:

$\det\,A^t=\displaystyle\sum_{\sigma\in S_n}sgn\,\sigma^{-1}\,a_{1\sigma^{-1}(1)}\cdots a_{n\sigma^{-1}(n)}.$

Si denotamos $\gamma=\sigma^{-1}$, al reescribir en términos de $\gamma$ tenemos que:

$\det\,A^t=\displaystyle\sum_{\gamma\in S_n}sgn\,\gamma\,a_{1\gamma(1)}\cdots a_{n\gamma(n)}=\det\,A.$

$\square$

Gracias a la propiedad 7 tenemos que:

Corolario

Todas las propiedades antes mencionadas de renglones se cumplen también para las columnas.

Tarea Moral

$1.$ Sean $A=\begin{equation*} \left(\begin{array}{cc} a & b \\ c & d \\ \end{array}\right) \end{equation*}$, $B=\begin{equation*} \left(\begin{array}{cc} e & f \\ c & d \\ \end{array}\right) \end{equation*},$ $C=\begin{equation*} \left(\begin{array}{cc} a+e & b+f \\ c & d \\ \end{array}\right) \end{equation*}\in \mathscr M_{2\times 2}(\mathbb R).$

Si $det\,A=7$ y $det\,B=\pi$, ¿cuánto es el determinante de $C$?

$2.$ Sean $B_1=\begin{equation*} \left(\begin{array}{cc} a_{11} & 0 \\ a_{21} & a_{22} \\ \end{array}\right) \end{equation*}$, $B_2=\begin{equation*} \left(\begin{array}{cc} 0 & a_{12} \\ a_{21} & a_{22} \\ \end{array}\right) \end{equation*},$ $A=\begin{equation*} \left(\begin{array}{cc} a_{11} & a_{12} \\ a_{21} & a_{22} \\ \end{array}\right) \end{equation*}\in \mathscr M_{2\times 2}(\mathbb R)$.

$i)$ Calcula el determinante de $A$ en términos de los determinantes de $B_1$ y $B_2$.

$ii)$ ¿Cómo podrías generalizar el resultado del inciso anterior a matrices de $n\times n$ para $n$ un natural positivo?

$3.$ Sean $A\in \mathscr M_{n\times n}(\mathbb R)$ y $\lambda \in \mathbb R$. ¿Cómo es el determinante de $\lambda A$ en términos del determinante de $A$?

$4.$ Sean $A=\begin{equation*} \left(\begin{array}{rrr} a & b & c \\ d & e & f \\ g & h & i \end{array}\right) \end{equation*}$ y $B=\begin{equation*} \left(\begin{array}{rrr} g & h & i \\ a & b & c \\ d & e & f \end{array}\right) \end{equation*}\in \mathscr M_{3\times 3}(\mathbb R).$

¿Cómo es el determinante de $B$ comparado con el determinante de $A$?

$5.$ Sean $n$ un natural positivo y $A\in \mathscr M_{n\times n}(\mathbb R)$. Si un renglón de $A$ es múltiplo de otro. ¿Qué ocurre con el determinante de $A$?

Más adelante

En la siguiente nota deduciremos una fórmula para el calculo del determinante.

Enlaces relacionados

Enlace a la nota anterior. Nota 40. Determinantes.

Enlace a la nota siguiente. Nota 42. Formula para obtener el determinante.