Introducción

En esta entrada veremos un concepto que se relaciona cercanamente con el valor esperado: la varianza. Así como el valor esperado, la varianza será una cantidad numérica que tiene la intención de resumir numéricamente otro aspecto del comportamiento probabilístico de una variable aleatoria. En este caso, lo que intentaremos resumir será la variabilidad respecto al valor esperado. Es decir, en promedio, ¿qué tanto se aleja una variable aleatoria del «centro» de su distribución?

Además, con las herramientas que tenemos hasta ahora, podemos desarrollar algunas propiedades de la varianza, que no serán difíciles de demostrar utilizando las herramientas de las últimas entradas sobre valor esperado.

Motivación y definición

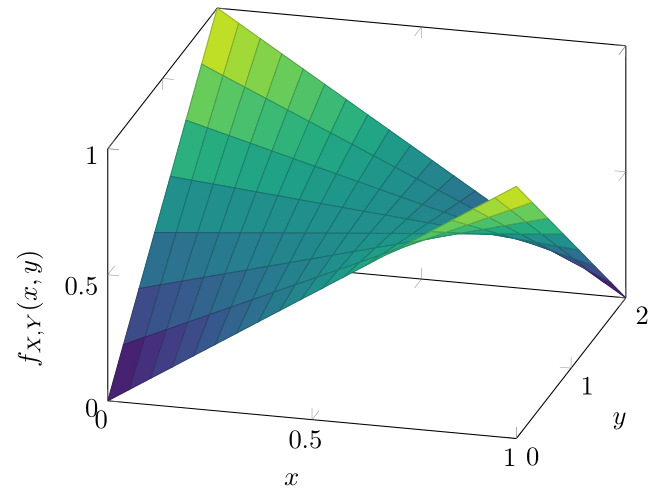

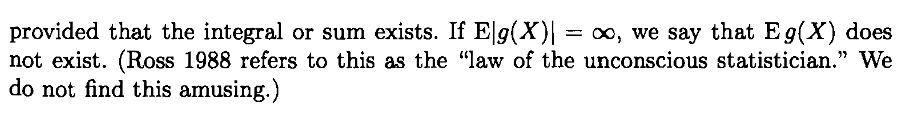

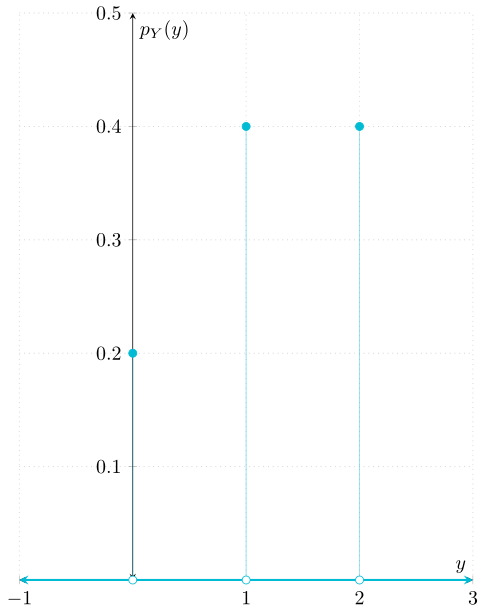

Dada una v.a. \(X\colon\Omega\to\RR\), vimos que el valor esperado de \(X\), \(\Esp{X}\), es el valor promedio (a la larga) de \(X\). Es decir, que si observamos muchas veces a \(X\), el promedio de esas observaciones debe de acercarse a \(\Esp{X}\). Además, gracias a la ley del estadístico inconsciente, podemos calcular \(\Esp{g(X)}\), que es el valor promedio de \(g(X)\).

La varianza de una v.a. \(X\) se define como el valor esperado de una transformación particular de \(X\), y lo que busca cuantificar la dispersión promedio que tiene \(X\) con respecto a su valor esperado. Por ello, se propone la transformación \(v\colon\RR\to\RR\) dada por

\begin{align*} v(x) &= {\left(x − \Esp{X}\right)}^{2} & \text{para cada \(x\in\RR\).} \end{align*}

Así, observa que \(v(X) = {\left(X − \Esp{X}\right)}^{2}\) es una v.a. cuyo valor tiene un significado especial: \(v(X)\) es la distancia entre \(X\) y su valor esperado, elevada al cuadrado. Por ello, \(\Esp{v(X)}\) es la distancia cuadrada promedio entre \(X\) y su valor esperado. Esta discusión da lugar a la definición de varianza.

Definición. Sea \(X\) una variable aleatoria. La varianza de \(X\), denotada con \( \mathrm{Var}(X) \), se define como sigue:

\begin{align*} \mathrm{Var}(X) &= \Esp{{\left(X − \Esp{X} \right)}^{2}},\end{align*}

siempre que \({\left(X − \Esp{X} \right)}^{2}\) sea una v.a. con valor esperado finito. En tal caso, se dice que \(X\) tiene varianza finita.

Definiciones para el caso discreto y el caso continuo

Debido a la distinción entre valores esperados de v.a.’s discretas y continuas, la varianza tiene dos formas de calcularse directamente. Sin embargo, veremos más adelante en esta entrada que no es necesario hacer el cálculo directo, y puede hacerse mediante una expresión más sencilla.

Varianza (Caso discreto). Si \(X\) es una v.a. discreta, entonces la varianza de \(X\) tiene la siguiente expresión:

\begin{align*} \mathrm{Var}(X) &= \sum_{x\in X[\Omega]} (x − \Esp{X})^{2} \Prob{X = x}, \end{align*}

siempre que esta serie sea absolutamente convergente.

Varianza (Caso continuo). Si \(X\) es una v.a. continua con función de densidad \(f_{X}\), entonces la varianza de \(X\) puede escribirse de la siguiente manera:

\begin{align*} \mathrm{Var}(X) &= \int_{-\infty}^{\infty} (x − \Esp{X})^{2} f_{X}(x) \, \mathrm{d}x.\end{align*}

Es importante observar que, independientemente del caso en el que nos encontremos, para calcular la varianza de \(X\) es necesario conocer el valor esperado de \(X\).

Terminología y notación usual

Existe cierta notación especial para la varianza que encontrarás en la literatura referente a probabilidad y estadística. Si \(X\) es una v.a., entonces suele denotarse a la varianza de \(X\) con \(\sigma^{2}\), o con \(\sigma_{X}^{2}\), en caso de que sea necesario saber qué v.a. es la varianza. Además, a la raíz cuadrada (positiva) de la varianza (que bajo esta notación sería \(\sigma\) o \(\sigma_{X}\)) se le conoce como desviación estándar. En resumen, si \(X\) es una v.a., entonces podrías encontrarte con fuentes que adoptan la siguiente notación:

- \(\sigma_{X}^{2} := \mathrm{Var}(X)\) para denotar a la varianza.

- \(\sigma_{X} := \sqrt{\mathrm{Var}(X)}\) para denotar a la desviación estándar.

Nostros no adoptaremos esta notación en general, pero hay una distribución de probabilidad en particular en la que sí la utilizaremos.

Propiedades de la varianza

Debido a que la varianza se define como un valor esperado, tiene algunas propiedades que son consecuencia de lo que hemos estudiado en las últimas entradas.

La primera propiedad es muy elemental, y establece que la varianza de cualquier v.a. es no-negativa.

Propiedad 1. Sea \(X\) una variable aleatoria. Entonces se cumple que

\begin{align*} \mathrm{Var}(X) \geq 0. \end{align*}

Demostración. Te la dejamos como tarea moral.

$\square$

Por su parte, la siguiente propiedad establece que la varianza de una constante debe de ser \(0\).

Propiedad 2. Sea \(c\in\RR\) y \(f_{c}\) la v.a. constante igual a \(c\). Entonces se cumple que

\begin{align*} \mathrm{Var}(f_{c}) &= 0. \end{align*}

Si abusamos un poco de la notación, lo anterior quiere decir que si \(c\in\RR\) es un valor constante, entonces \( \mathrm{Var}(c) = 0\).

Demostración. Sea \(v\colon\RR\to\RR\) la transformación que define a la varianza (en este caso, para cada \(x\in\RR\), \(v(x) = x − \Esp{f_{c}}\)). Como \(\Esp{f_{c}} = c\), entonces se tiene que \(v(x) = x − c\). Así, \(v(f_{c})\) es la v.a. dada por

\begin{align*} v(f_{c}(\omega)) &= f_{c}(\omega) − c & \text{para cada \(\omega\in\Omega\).} \end{align*}

Además, como \(f_{c}(\omega) = c\) para cualquier \(\omega\in\Omega\), entonces se tiene que \(v(f_{c})\) es la v.a. constante igual a \(0\). En consecuencia,

\begin{align*} \mathrm{Var}(f_{c}) &= \Esp{v(f_{c})} = \Esp{0} = 0, \end{align*}

que es justamente lo que queríamos demostrar.

$\square$

La propiedad 2 tiene sentido, pues la dispersión promedio de una v.a. que puede tomar un único valor debe de ser \(0\).

La propiedad siguiente nos dice que la varianza es invariante ante traslaciones.

Propiedad 3. Sean \(X\) una variable aleatoria y \(c \in \RR\). Entonces

\begin{align*} \mathrm{Var}(X + c) &= \mathrm{Var}(X) . \end{align*}

Demostración. Podemos obtener este resultado directamente desarrollando la expresión de la varianza de \(X + c\), recordando que \(\Esp{X + c} = \Esp{X} + c\):

\begin{align*} \mathrm{Var}(X + c) &= \Esp{(X + c − \Esp{X + c})^{2}} \\[1em] &= \Esp{(X + c − (\Esp{X} + c))^{2}} \\[1em] &= \Esp{(X + c − \Esp{X} − c))^{2}} \\[1em] &= \Esp{(X − \Esp{X})^{2}} \\[1em] &= \mathrm{Var}(X) ,\end{align*}

que es precisamente lo que queríamos demostrar.

\(\square\)

La propiedad 3 quiere decir que si trasladamos una v.a. sumándole una constante, su dispersión promedio no se ve afectada, pues el comportamiento probabilístico sigue siendo el mismo, lo único que se cambia es el «centro» de la distribución. Es decir, la v.a. trasladada tiene el mismo comportamiento, pero centrado alrededor de un valor distinto, por lo que su variabilidad con respecto a ese nuevo centro será la misma.

La propiedad que sigue establece que la varianza saca constantes multiplicando al cuadrado.

Propiedad 4. Sean \(X\) una variable aleatoria y \(c\in\RR\). Entonces

\begin{align*} \mathrm{Var}(cX) &= c^{2} \mathrm{Var}(X). \end{align*}

Demostración. Al igual que la propiedad 1, te dejamos esta como tarea moral.

\(\square\)

La siguiente propiedad establece una expresión más sencilla para el cálculo de la varianza de una v.a. \(X\).

Propiedad 5. Sea \(X\) una variable aleatoria con varianza finita. Entonces se cumple que

\begin{align*} \mathrm{Var}(X) &= \Esp{X^{2}} − {\left(\Esp{X}\right)}^{2}.\end{align*}

Demostración. Podemos hacer el siguiente desarrollo de la expresión que vimos en la definición de la varianza.

\begin{align*} \mathrm{Var}(X) &= \Esp{{\left(X − \Esp{X}\right)}^{2}} \\[0.5em] &= \Esp{X^{2} − 2 X \Esp{X} + {\left(\Esp{X}\right)}^{2}} \\[0.5em] &= \Esp{X^{2}} + \Esp{−2 X \Esp{X}} + \Esp{\left(\Esp{X}\right)^{2}} \tag{\(*\)} \\[0.5em] &= \Esp{X^{2}} − 2\Esp{X}\Esp{X} + {\left(\Esp{X}\right)}^{2} \tag{\(**\)} \\[0.5em] &= \Esp{X^{2}} − 2{\left(\Esp{X}\right)}^{2} + {\left(\Esp{X}\right)}^{2} \\[0.5em] &= \Esp{X^{2}} − {\left(\Esp{X}\right)}^{2}.\end{align*}

Observa que al pasar de \((*)\) a \((**)\) usamos que \(−2\Esp{X} \in \RR\) es constante, por lo que «sale multiplicando».

$\square$

La propiedad 5 nos otorga una manera alternativa de calcular la varianza de una v.a. que nos será muy útil más adelante, en especial cuando hayamos visto el tema de la entrada siguiente.

¿La varianza «abre» la suma? ¡No siempre!

Como una última «propiedad», vamos a demostrar que, en general, la varianza no es lineal respecto a la suma. Esto es, en general se tiene que

\begin{align*} \mathrm{Var}(X + Y) &\neq \mathrm{Var}(X) + \mathrm{Var}(Y) . \end{align*}

Para confirmarlo, veamos la siguiente proposición.

Proposición 1. Sean \(X\), \(Y\) variables aleatorias. Entonces se tiene que

\begin{align*} \mathrm{Var}({X + Y}) &= \mathrm{Var}({X}) + \mathrm{Var}({Y}) + 2\Esp{(X − \Esp{X})(Y − \Esp{Y})}.\end{align*}

Demostración. Podemos desarrollar la varianza de \(X + Y\) directamente para obtener el resultado:

\begin{align*} \mathrm{Var}(X + Y) &= \Esp{(X + Y − \Esp{X + Y})^{2}} \\[1em] &= \Esp{(X + Y − (\Esp{X} + \Esp{Y}))^{2}} \\[1em] &= \Esp{(X + Y − \Esp{X} − \Esp{Y})^{2}} \\[1em] &= \Esp{((X − \Esp{X}) + (Y − \Esp{Y}))^{2}} \\[1em] &= \Esp{(X − \Esp{X})^{2} − 2(X − \Esp{X})(Y − \Esp{Y}) + (Y − \Esp{Y})^{2}} \\[1em] &= \Esp{(X − \Esp{X})^{2}} + 2\Esp{(X − \Esp{X})(Y − \Esp{Y})} + \Esp{(Y − \Esp{Y})^{2}} \\[1em] &= \Esp{(X − \Esp{X})^{2}} + \Esp{(Y − \Esp{Y})^{2}} + 2\Esp{(X − \Esp{X})(Y − \Esp{Y})} \\[1em] &= \mathrm{Var}(X) + \mathrm{Var}(Y) + 2\Esp{(X − \Esp{X})(Y − \Esp{Y})}, \end{align*}

lo cual concluye la demostración.

\(\square\)

Con lo anterior, es evidente que no siempre \(\mathrm{Var}(X+Y) = \mathrm{Var}(X) + \mathrm{Var}(Y)\), pues hay muchas v.a.’s para las cuales el valor \(\Esp{(X − \Esp{X})(Y − \Esp{Y})}\) es distinto de \(0\). Sin embargo, un caso en el que sí se cumple que la varianza abre la suma es cuando \(X\) y \(Y\) son independientes. En tal caso, basta con demostrar que si \(X\) y \(Y\) son independientes, entonces

\begin{align*} \Esp{(X − \Esp{X})(Y − \Esp{Y})} &= 0. \end{align*}

De hecho, en el futuro verás que el valor \( \Esp{(X − \Esp{X})(Y − \Esp{Y})}\) es conocido como la covarianza entre \(X\) y \(Y\), que generalmente se denota con \(\mathrm{Cov}(X,Y)\), y busca cuantificar la relación que existe entre \(X\) y \(Y\). De este modo, el resultado de la Proposición 1 puede reescribirse como sigue:

\begin{align*} \mathrm{Var}({X + Y}) &= \mathrm{Var}({X}) + \mathrm{Var}({Y}) + 2\mathrm{Cov}(X,Y).\end{align*}

Compendio de propiedades de la varianza

Antes de terminar, incluimos una lista de las propiedades vistas (y demostradas) en esta entrada. Todas estarán disponibles para que las uses en tus tareas y exámenes, a menos que tu profesor o profesora indique lo contrario.

Propiedades de la Varianza. Sean \(X\) y \(Y\) variables aleatorias con varianza finita, y sea \(c\in\RR\). Entonces se cumplen las siguientes propiedades:

- La varianza es no-negativa: \begin{align*}\mathrm{Var}(X) \geq 0,\end{align*}

- La varianza de una constante es \(0\): \begin{align*}\mathrm{Var}(c) = 0,\end{align*}

- Es invariante ante traslaciones: \begin{align*}\mathrm{Var}(X+c) = \mathrm{Var}{X},\end{align*}

- Saca constantes multiplicando al cuadrado: \begin{align*}\mathrm{Var}(cX) = c^{2}\mathrm{Var}(X),\end{align*}

- Expresión alternativa para la varianza: \begin{align*}\mathrm{Var}(X) = \Esp{X^{2}} − {\left(\Esp{X}\right)}^{2},\end{align*}

- Varianza de la suma de dos v.a.’s:\begin{align*}\mathrm{Var}({X + Y}) &= \mathrm{Var}({X}) + \mathrm{Var}({Y}) + 2\Esp{(X − \Esp{X})(Y − \Esp{Y})}.\end{align*}

Tarea moral

Los siguientes ejercicios son opcionales. Es decir, no formarán parte de tu calificación. Sin embargo, te recomiendo resolverlos para que desarrolles tu dominio de los conceptos abordados en esta entrada.

- Demuestra la Propiedad 1 de la varianza.

- Demuestra también la Propiedad 4 de la varianza.

- Usando la Proposición 1, demuestra que si \(X\) y \(Y\) son v.a.’s independientes, entonces\begin{align*} \mathrm{Var}({X + Y}) &= \mathrm{Var}({X}) + \mathrm{Var}({Y}). \end{align*}Sugerencia: En la entrada pasada vimos que cuando \(X\) y \(Y\) son independientes, \(\Esp{XY}\) se puede «abrir». Utilíza eso para ver que \(\Esp{(X − \Esp{X})(Y − \Esp{Y})} = 0\).

Más adelante…

Así como el valor esperado, la varianza es un concepto ubicuo en la probabilidad y la estadística. En conjunto, el valor esperado y la varianza son valores numéricos que resumen dos características del comportamiento de una variable aleatoria: la tendencia central y la variabilidad respecto a esa tendencia central. Por ello, incluso sin visualizar la densidad o masa de probabilidad de una v.a., estas cantidades pueden utilizarse para «darse una idea» de su aspecto y de su comportamiento.

En la entrada que sigue veremos un conjunto de valores asociados a la distribución de una variable aleatoria, conocidos como momentos.

Entradas relacionadas

- Ir a Probabilidad I

- Entrada anterior del curso: Más Propiedades del Valor Esperado

- Siguiente entrada del curso: Momentos de una Variable Aleatoria