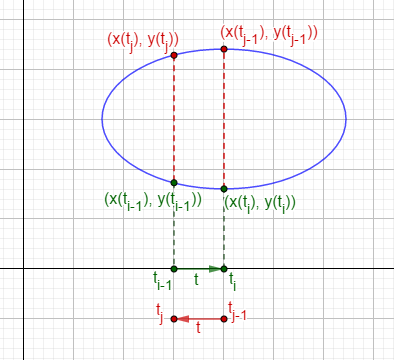

Ejemplo: Una elipse $\dfrac{x^2}{a^2} + \dfrac{y^2}{b^2} = 1$

$\alpha (t) = (a \cos t, b \sin t )$

$\alpha (t) = \big( x (t), y (t) \big)$

Fórmula para calcular la curvatura $$ \mathcal{K} (t) = \dfrac{ \begin{equation*} \begin{vmatrix} x’ & {x}^{\prime \prime }\\ y’ & {y}^{\prime \prime } \end{vmatrix} \end{equation*} }{\| {\alpha}’ (t) \|^3}$$

$x (t) = a \cos t \; \; \; \; \; \; \; \; \; \; \; \; \; \; \; \; y (t) = b \sin t$

$x’ (t) = – a \sin t \; \; \; \; \; \; \; \; \; \; \; \; \; \; \; y’ (t) = b \cos t$

${x}^{\prime \prime } (t) = – a \cos t \; \; \; \; \; \; \; \; \; \; \; \; \; \; {y}^{\prime \prime } (t) = – b \sin t$

$\begin{equation*}\begin{vmatrix} x’ & {x}^{\prime \prime } \\ y’ & {y}^{\prime \prime } \end{vmatrix} = \begin{vmatrix} – a \sin t & – a \cos t\\ b \cos t & – b \sin t \end{vmatrix}\end{equation*}$

$\begin{equation*}\begin{vmatrix} x’ & {x}^{\prime \prime }\\ y’ & {y}^{\prime \prime } \end{vmatrix} \end{equation*} = ab \sin^2 t + ab \cos^2 t $

$\begin{equation*}\begin{vmatrix} x’ & {x}^{\prime \prime }\\ y’ & {y}^{\prime \prime } \end{vmatrix} \end{equation*} = ab $

Luego

$\| {\alpha}’ (t) \| = \sqrt{ (- \, a \sin t)^2 + ( b \cos t )^2}$

$\| {\alpha}’ (t) \| = \sqrt{a^2 \sin^2 t + b^2 \cos^2 t }$

$$\mathcal{K} (t) = \dfrac{ab}{\Big( a^2 \sin^2 t + b^2 \cos^2 t \Big)^{\frac{3}{2}}}$$

Si $a > b$ entonces $b^2 \cos^2 t = b^2 ( 1 \, – \, \sin^2 t)$

Entonces $a^2 \sin^2 t + b^2 \cos^2 t = a^2 \sin^2 t + b^2 \, b^2 (1 \, – \, \sin^2 t) = (a^2 \, – \, b^2) \sin^2 t + b^2$

Luego $\| {\alpha}’ (t) \| = (a^2 \, – \, b^2) \sin^2 t + b^2$

Como $0 \leq \sin^2 t \leq 1$ el valor máximo de $\| {\alpha}’ (t) \| = a$ y el mínimo $\| {\alpha}’ (t) \| = b$

Por lo que la $\mathcal{K}$ máxima es $\dfrac{b}{a^2}$ y la $\mathcal{K}$ mínima es $\dfrac{a}{b^2}$

(a) Puntos donde la elipse está más curva $(\pm a, 0)$, son cuando $t = 0,\, \pi,\, 2\pi,\, \Rightarrow \mathcal{K} = \dfrac{a}{b^2}$. Y el radio de curvatura es $\dfrac{b^2}{a}$

(b) Puntos donde la elipse está menos curva $(0, \pm b)$, son cuando $t = \dfrac{\pi}{2},\, \dfrac{3\pi}{2},\, \dotsc \Rightarrow \mathcal{K} = \dfrac{b}{a^2}$. Y el radio de curvatura es $\dfrac{a^2}{b}$

Los puntos anteriores son los vértices de la elipse.

En el siguiente enlace puedes observar la animación de una elipse y su círculo osculador.

https://www.geogebra.org/classic/ehmeatmw

Observación: la curvatura está dada por la derivada del vector tangente unitario $T$ con respecto al parámetro longitud de arco $s$.

$\dfrac{dT}{ds}$, que no es lo mismo que $\dfrac{dT}{dt}$. La relación es $\dfrac{dT}{ds}= \dfrac{dT}{dt} \dfrac{dt}{ds}$

Si la curva es plana

$T (s) = (\cos (\phi (s)), \sin (\phi (s)))$

$\dfrac{dT}{ds} = ( \, – \, \sin (\phi (s)) {\phi}’ (s) , \cos (\phi (s)) {\phi}’ (s))$

$\dfrac{dT}{ds} = {\phi}’ (s) N (s)$

$\mathcal{K} (s) = \dfrac{d \phi}{ds}$

$\Bigg\| \dfrac{dT}{ds}\Bigg\| = \big| \mathcal{K}\big|$

${}$

Para curvas en $\mathbb{R}^3$ tenemos el concepto de contacto con superficies (planos, esferas)

$s \rightarrow \alpha (s) \in \mathbb{R}^3$

Podemos estudiar $f (s) = F \, \circ \, \alpha (s)$

Donde $\alpha (s) = \big( x (s), y (s), z (s) \big)$ y $F : (x, y, z)$ es $F : \mathbb{R}^3 \rightarrow \mathbb{R}$

entonces $ F \big( x (s), y (s), z (s) \big) = f (s)$

si $f (s_0) = 0$ , $f’ (s_0) = 0$ y ${f }^{\prime \prime} (s_0) \neq 0$ enotnces la curva $\alpha$ tiene contacto de orden 2 con la superficie $F^{-1} (0)$ en el punto $\alpha (s_0).$

si $f (s_0) = 0$ , $f’ (s_0) = 0$ , ${f }^{\prime \prime} (s_0) = 0$ y ${f }^{\prime \prime \prime} \neq 0$ enotnces la curva $\alpha$ tiene contacto de orden 3 con la superficie $F^{-1} (0)$ en el punto $\alpha (s_0).$

${}$

Contacto de la curva con la esfera

Sea $\alpha$ una curva parametrizada con rapidez unitaria $ \alpha = \alpha (s).$

Sea $F ( \vec{x}) = \| \vec{x} \, – \, \vec{u} \|^2 \, – \, \| \vec{\alpha}(s_0) \, – \, \vec{u} \|^2$ que cumpla que $F^{-1} (0) $ es la esfera con centro en $\vec{u}$ y que pasa por el punto $\vec{\alpha} (s_0)$

Además

$\vec{x} \, – \, \vec{u}$ es el vector que empieza un $\vec{u}$ y acaba en $\vec{x}.$

$\| \vec{x} \, – \, \vec{u} \|$ es la distancia de $\vec{x}$ a $\vec{u}.$

$\vec{\alpha}(s_0) \, – \, \vec{u}$ es el vector que empieza un $\vec{u}$ y acaba en $\alpha (s_0).$

$\| \vec{\alpha}(s_0) \, – \, \vec{u} \|$ radio de la esfera $ = r$

Ecuación de la esfera

$\| \vec{x} \, – \, \vec{u} \| = r $

$\| \vec{x} \, – \, \vec{u} \|^2 = r^2$

$\| \vec{x} \, – \, \vec{u} \|^2 \, – \, r^2 = 0 $

Luego

$f (s) = \| \vec{\alpha}(s) \, – \, \vec{u} \|^2 \, – \, \| \vec{\alpha}(s_0) \, – \, \vec{u} \|^2$ cumple que $f (s_0) = 0 $

¿Cuáles esferas tienen contacto $\geq 2$?

$f (s_0) = 0 $ y $f’ (s_0) = 0 $

$ f (s) = \langle \alpha (s) \, – \, u , \alpha (s) \, – \, u \rangle \, – \, r^2$

$ f’ (s) = 2 \langle \alpha (s) \, – \, u , {\alpha}’ (s) \rangle $

$ \dfrac{1}{2} f’ (s) = \langle \alpha (s) \, – \, u , {\alpha}’ (s) \rangle = 0 $ si y sólo si $\alpha (s_0) \, – \, u \, \perp \, T (s_0) $ si y solo si $ u \, – \, \alpha (s_0) \, \perp \, T (s_0).$

El plano norma a $T (s_0)$ está generado por el $N (s_0)$ y el $B (s_0)$ entonces, $$u \, – \, \alpha (s_0) = \lambda N (s_0) + \mu B (s_0)$$

Pidamos que $f (s_0) = 0$, $f’ (s_0) = 0$ y ${f}^{\prime \prime} (s_0) = 0$, es decir, contacto $\geq 3$

${f}^{\prime \prime} (s_0) = 0 \iff \dfrac{1}{2} {f}^{\prime \prime} (s_0) = 0$

Como $\dfrac{1}{2} {f’} (s_0) = \langle \alpha \, – \, u , {\alpha}’ \rangle$

Entonces $\dfrac{1}{2} {f’} (s_0) = \langle \alpha \, – \, u , T \rangle$ y $\dfrac{1}{2} {f}^{\prime \prime} (s_0) = \langle {\alpha}’ , T \rangle + \langle \alpha \, – \, u , T’ \rangle$

Entonces $\dfrac{1}{2} {f}^{\prime \prime} (s_0) = \langle T , T \rangle + \langle \alpha \, – \, u , \mathcal{K} N \rangle = 1 + \langle \lambda N (s_0) + \mu B (s_0) , \mathcal{K} N \rangle = 0$

Entonces $ 1 = \mathcal{K} \lambda \langle N (s_0), N (s_0)\rangle + \mu \mathcal{K} \langle B (s_0), N (s_0) \rangle$

Por lo tanto $1 = \lambda \mathcal{K} (s_0) $ es decir que $$ \lambda = \dfrac{1}{\mathcal{K} (s_0)}$$

Ahora pidamos además ${f}^{\prime \prime \prime} (s_0) = 0$, es decir, contacto $\geq 4.$

${f}^{\prime \prime \prime} (s_0) = 0 \iff \dfrac{1}{2} {f}^{\prime \prime \prime} (s_0) = 0$

Como $\dfrac{1}{2} {f}^{\prime \prime } (s_0) = 1 + \langle \alpha \, – \, u , \mathcal{K} N \rangle$

Entonces $\dfrac{1}{2} {f}^{\prime \prime \prime} (s) = \langle {\alpha}’ , \mathcal{K} N \rangle + \langle \alpha \, – \, u , \mathcal{K}’ N \rangle + \langle \alpha \, – \, u , \mathcal{K} N’ \rangle$

Evaluamos en $(s_0)$ y obtenemos que:

$\dfrac{1}{2} {f}^{\prime \prime \prime} (s_0) = \Bigg\langle T (s_0) , \mathcal{K} (s_0) N (s_0) \Bigg\rangle + \Bigg\langle \dfrac{- 1}{\mathcal{K} (s_0)} N (s_0) \, – \, \mu B (s_0) , \mathcal{K}’ (s_0) N (s_0) \Bigg\rangle + \Bigg\langle \dfrac{- 1}{\mathcal{K} (s_0) } N (s_0) \, – \, \mu B (s_0) , \mathcal{K} (s_0) N’ (s_0) \Bigg\rangle$

Entonces que $\dfrac{1}{2} {f}^{\prime \prime \prime} (s_0) = 0$ significa que

$0 = \dfrac{- 1}{\mathcal{K} (s_0)} \mathcal{K}’ (s_0) \, – \, \mu \mathcal{K} (s_0) \Bigg\langle B (s_0) , N’ (s_0) \Bigg\rangle$

Si $N’ (s_0) = – \, \mathcal{K} (s_0) T (s_0) + \tau (s_0) B (s_0)$

Entonces $$ \dfrac{ \mathcal{K}’ (s_0) }{\mathcal{K} (s_0) } = – \, \mu \mathcal{K} (s_0) \Big( B (s_0), \Big\langle \, – \, \mathcal{K} (s_0) T (s_0) + \tau (s_0) B (s_0)\Big\rangle \Big)$$

Por lo tanto $ \dfrac{ \mathcal{K}’ (s_0) }{\mathcal{K} (s_0) } = – \, \mu \mathcal{K} (s_0) \tau (s_0)$

Es decir $$\mu = \dfrac{ \mathcal{K}’ (s_0)}{\mathcal{K}^2 (s_0) \tau (s_0)}$$

Si $ \mathcal{K} (s_0) \neq 0$ y $\tau (s_0) \neq 0$ entonces existe una esfera única que tiene contacto al menos 4 (esfera osculatriz).

Si $ \mathcal{K}’ (s_0) = 0$ y $\tau (s_0) = 0$ pero $\mathcal{K} (s_0) \neq 0$ también existe dicha esfera, pero no es única, ya que $\mu$ es libre.