La educación en matemáticas es mucho más complicada que lo que esperabas,

incluso si esperabas que es más complicada que lo que esperabas.

– Edward Griffith Begle

Introducción

Nos acercamos al final de este curso. Para concluir estudiaremos un último tema que tiene que ver con los sistemas autónomos de ecuaciones diferenciales no lineales.

Resolver de forma analítica sistemas de ecuaciones diferenciales no lineales puede ser una tarea sumamente complicada y en algunos casos hasta imposible, es por ello que en muchas ocasiones se opta por resolverlos con métodos numéricos. En este curso no veremos métodos numéricos y mucho menos métodos analíticos para resolver sistemas de ecuaciones diferenciales no lineales debido a que requerimos de más teoría que queda fuera de este primer curso de ecuaciones diferenciales. Pero lo que si podemos hacer es un análisis cualitativo como lo hemos estado haciendo en esta unidad.

Recordemos que el espacio fase de un sistema de ecuaciones diferenciales aporta la suficiente información como para conocer de forma completa el comportamiento de los soluciones a diferentes tiempos, incluso esta información puede ser suficiente para describir el fenómeno que estemos estudiando sin la necesidad de conocer explícitamente las soluciones del sistema.

En esta y las próximas entradas comenzaremos a desarrollar métodos cualitativos que nos permitirán construir el espacio fase de sistemas no lineales y por tanto conocer el comportamiento de sus soluciones a diferentes tiempos y diferentes condiciones iniciales.

En estos momentos ya conocemos métodos analíticos y geométricos que nos permiten entender completamente a los sistemas lineales, es posible combinar estos métodos con algunas otras técnicas cualitativas adicionales para describir a los sistemas no lineales. Comenzaremos desarrollando el método de linealización, el cual nos mostrará cómo es que puede aproximarse un sistema no lineal a un punto de equilibrio por medio de un sistema lineal.

Trayectorias de los sistemas no lineales

Consideremos el siguiente sistema no lineal.

\begin{align*}

x^{\prime} &= y \\

y^{\prime} &= -x + (1 -x^{2})y \label{1} \tag{1}

\end{align*}

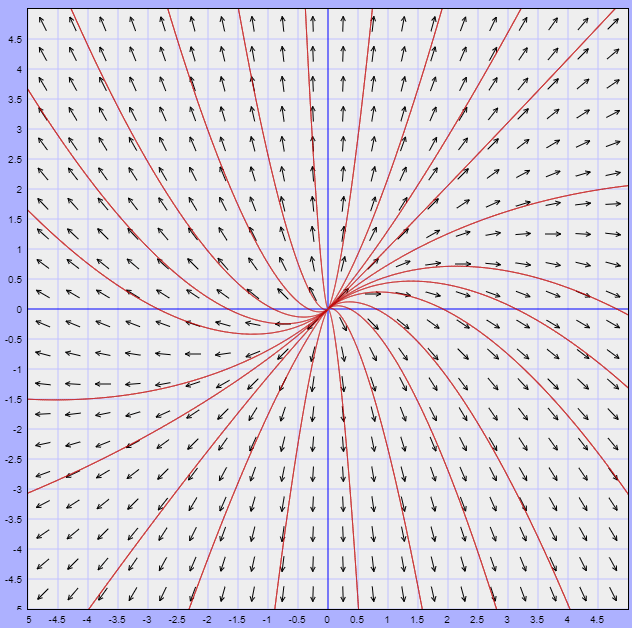

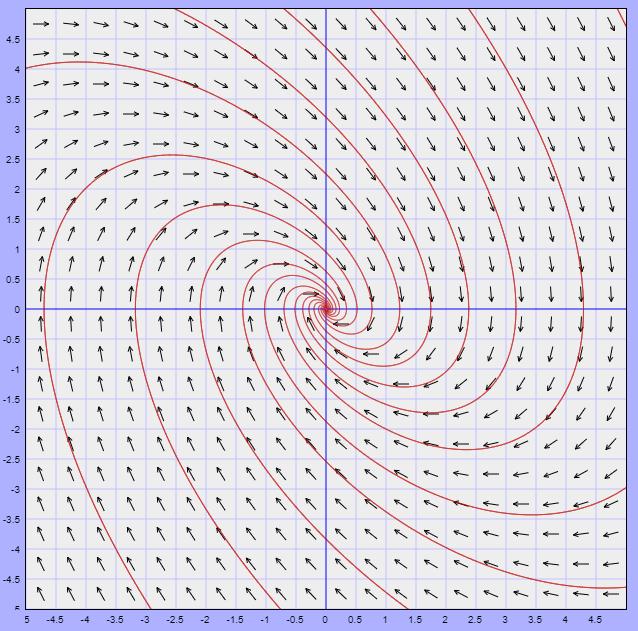

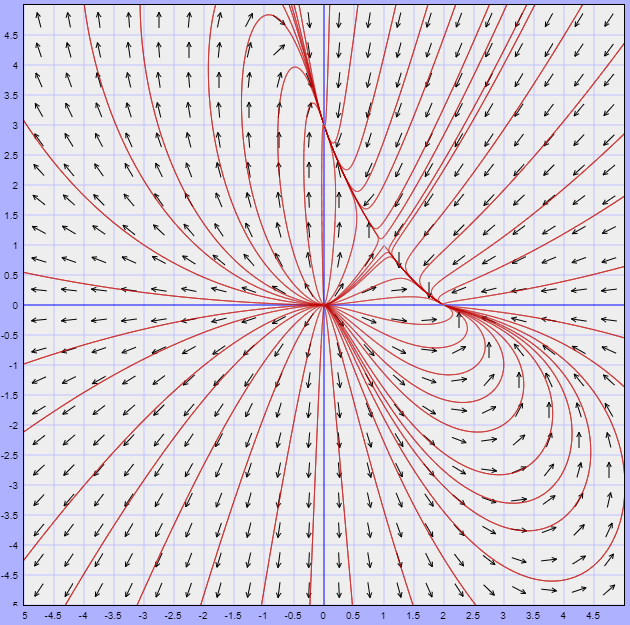

Enseguida podemos darnos cuenta de que el único punto de equilibrio del sistema es el origen. Usando la herramienta que hemos estado utilizando a lo largo de esta unidad podemos visualizar el plano fase del sistema acompañado del campo vectorial asociado.

Las trayectorias en general no muestran un comportamiento parecido a alguno de los sistemas estudiados en las entradas anteriores y claro que debe ser así, ya que en este caso se trata de un sistema no lineal. Sin embargo, se puede notar que alrededor del punto de equilibrio, es decir del origen, si hay un comportamiento que nos parece familiar, pues se trata de una espiral que se aleja del origen (parecido a foco inestable).

Lo que haremos será aproximar el sistema (\ref{1}) con un sistema que sea mucho más fácil de analizar. Observemos que el término que hace que el sistema no sea lineal es $x^{2}y$ en la ecuación para $y^{\prime}$. Si $x$ y $y$ son pequeñas (cercanas al punto de equilibrio), entonces el término $x^{2}y$ es aún mucho más pequeño, de manera que para valores pequeños de $x$ y de $y$ es posible aproximar el sistema (\ref{1}) en un sistema lineal en el que no aparece el término $x^{2}y$, dicho sistema es

\begin{align*}

x^{\prime} &= y \\

y^{\prime} &= -x + y \label{2} \tag{2}

\end{align*}

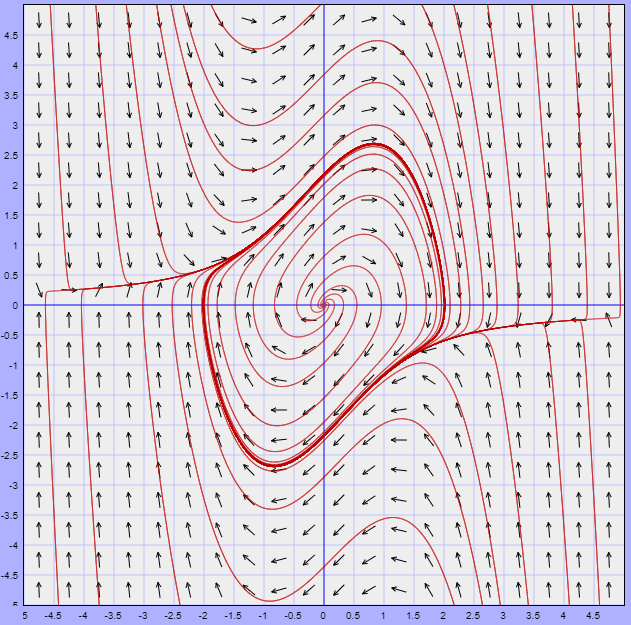

Ambos sistemas deben ser muy similares en una vecindad muy próxima al punto de equilibrio, en este caso en el origen. Veamos el plano fase del sistema lineal (\ref{2}).

Si observamos con cuidado ambos planos fase vemos que efectivamente son muy similares alrededor del origen, ya que ambos corresponden a espirales que se alejan del origen.

El plano fase del sistema (\ref{2}) corresponde a un sistema con valores propios complejos. Prueba que efectivamente los valores propios son

$$\lambda_{1} = \dfrac{1 + i \sqrt{3}}{2} \hspace{1cm} y \hspace{1cm} \lambda_{2} = \dfrac{1 -i \sqrt{3}}{2}$$

Como son complejos con parte real positiva, sabemos que las soluciones del sistema lineal se mueven en espiral alejándose del origen.

Lo que hemos hecho se conoce como linealización del punto de equilibrio. Cerca del punto de equilibrio aproximamos el sistema no lineal por medio de un sistema lineal apropiado. Para condiciones iniciales cerca del punto de equilibrio las soluciones del sistema no lineal y de la aproximación lineal permanecen cercanas entre sí, por lo menos en algún intervalo.

El sistema no lineal (\ref{1}) se conoce como ecuación de Van der Pol y más adelante volveremos a él.

Veamos cómo sería hacer una linealización de un sistema no polinomial. Consideremos el sistema no lineal

\begin{align*}

x^{\prime} &= y \\

y^{\prime} &= -y -\sin(x) \label{3} \tag{3}

\end{align*}

El término no lineal corresponde a la función seno. Este modelo bien puede representar el movimiento de un péndulo amortiguado.

Los puntos de equilibrio del sistema son $Y_{0} = (0, 0), (\pm \pi, 0), (\pm 2\pi, 0)$, etcétera. Concentrémonos sólo en el origen.

Sabemos que

$$\sin(x) = x -\dfrac{x^{3}}{3!} + \dfrac{x^{5}}{5!} – \cdots \label{4} \tag{4}$$

Entonces podemos escribir al sistema (\ref{3}) como

\begin{align*}

x^{\prime} &= y \\

y^{\prime} &= -y -\left( x -\dfrac{x^{3}}{3!} + \dfrac{x^{5}}{5!} – \cdots \right) \label{5} \tag{5}

\end{align*}

Para $x$ muy pequeña los términos con potencia son aún más pequeños, así que los podemos omitir aproximándonos al siguiente sistema lineal.

\begin{align*}

x^{\prime} &= y \\

y^{\prime} &= -y -x \label{6} \tag{6}

\end{align*}

Los valores propios de este sistema son

$$\lambda_{1} = \dfrac{-1 + i \sqrt{3}}{2} \hspace{1cm} y \hspace{1cm} \lambda_{2} = \dfrac{-1 -i \sqrt{3}}{2}$$

Como estos números son complejos con parte real negativa, esperamos que el correspondiente punto de equilibrio para el sistema no lineal sea un foco estable.

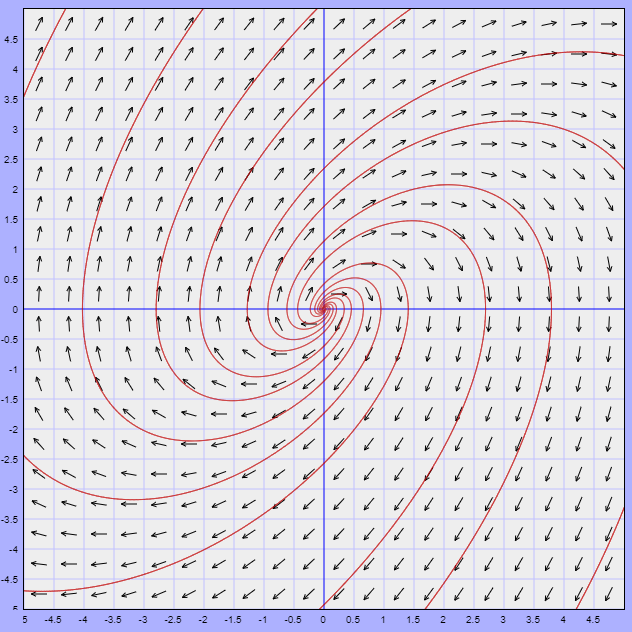

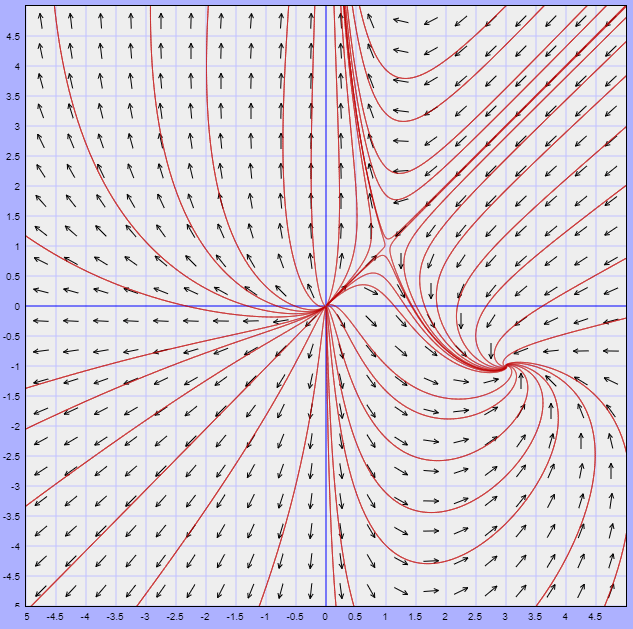

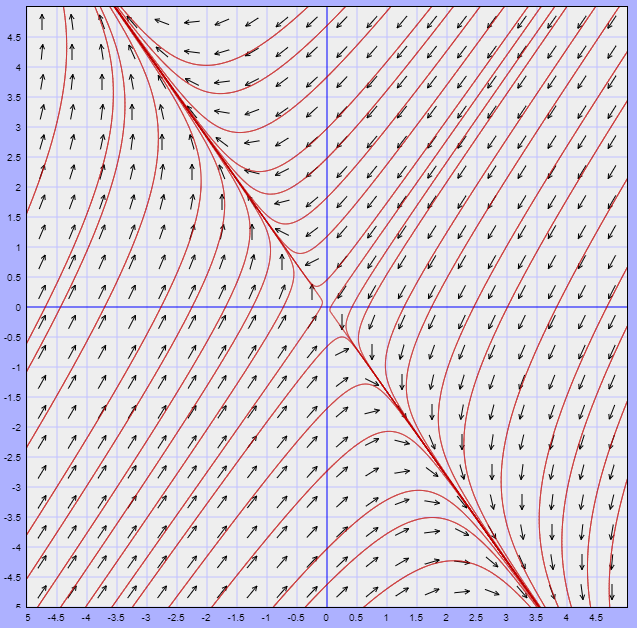

A continuación se muestra el plano fase del sistema no lineal (\ref{3}) y posteriormente el plano fase del sistema linealizado (\ref{6}) y observemos en ambos el comportamiento de las trayectorias alrededor del punto de equilibrio $Y_{0} = (0, 0)$.

Efectivamente, en ambos planos fase alrededor del origen presentan el mismo comportamiento correspondiente a un foco estable.

El proceso de linealización puede ser directo independientemente del sistema no lineal que tengamos, pero debemos apoyarnos de una herramienta del cálculo diferencial conocida como matriz Jacobiana.

Linealización de los puntos de equilibrio

Consideremos el siguiente sistema autónomo no lineal.

\begin{align*}

x^{\prime} &= F_{1}(x, y) \\

y^{\prime} &= F_{2}(x, y) \label{7} \tag{7}

\end{align*}

Supongamos que $Y_{0} = (x_{0}, y_{0})$ es un punto de equilibrio de este sistema (no necesariamente el origen). Queremos entender qué sucede con las soluciones cerca de $Y_{0}$, es decir, linealizar el sistema cerca de $Y_{0}$. Introducimos nuevas variables.

\begin{align*}

u &= x -x_{0} \\

v &= y -y_{0} \label{8} \tag{8}

\end{align*}

Lo que hacen estas variables es mover el punto de equilibrio al origen. Si $x$ y $y$ están cerca del punto de equilibrio $(x_{0}, y_{0})$, entonces $u$ y $v$ tienden a $0$.

Como los números $x_{0}$ y $y_{0}$ son constantes y además

$$x = u + x_{0} \hspace{1cm} y \hspace{1cm} y = v + y_{0}$$

entonces el sistema (\ref{7}) escrito en términos de $u$ y $v$ es

\begin{align*}

\dfrac{du}{dt} &= \dfrac{d(x -x_{0})}{dt} = \dfrac{dx}{dt} = F_{1}(x, y) = F_{1}(x_{0} + u, y_{0} + v) \\

\dfrac{dv}{dt} &= \dfrac{d(y -y_{0})}{dt} = \dfrac{dy}{dt} = F_{2}(x, y) = F_{2}(x_{0} + u, y_{0} + v)

\end{align*}

Esto es,

\begin{align*}

u^{\prime} &= F_{1}(x_{0} + u, y_{0} + v) \\

v^{\prime} &= F_{2}(x_{0} + u, y_{0} + v) \label{9} \tag{9}

\end{align*}

Si $u = v = 0$, entonces

\begin{align*}

u^{\prime} &= F_{1}(x_{0}, y_{0}) \\

v^{\prime} &= F_{2}(x_{0}, y_{0})

\end{align*}

Pero,

$$F_{1}(x_{0}, y_{0}) = 0 \hspace{1cm} y \hspace{1cm} F_{2}(x_{0}, y_{0}) = 0$$

ya que $Y_{0} = (x_{0}, y_{0})$ es un punto de equilibrio, esto nos muestra que hemos movido el punto de equilibrio al origen en el plano $UV$.

Lo que haremos a continuación es apoyarnos de algunos resultados del curso de Cálculo III. Necesitamos eliminar los términos de orden superior o no lineales del sistema (\ref{9}). Como esas expresiones pueden incluir funciones exponenciales, logarítmicas y trigonométricas, no siempre es claro cuáles son los términos lineales. En este caso es necesario estudiar a $F_{1}$ y $F_{2}$ con más atención.

De cálculo sabemos que es posible estudiar una función analizando su mejor aproximación lineal, la cual está dada por el plano tangente para funciones de dos variables, es decir

$$F_{1}(x_{0} + u, y_{0} + v) \approx F_{1}(x_{0}, y_{0}) + \left[ \dfrac{\partial F_{1}}{\partial x}(x_{0}, y_{0}) \right]u + \left[ \dfrac{\partial F_{1}}{\partial y}(x_{0}, y_{0}) \right]v \label{10} \tag{10}$$

El lado derecho es la ecuación para el plano tangente a la gráfica de $F_{1}$ en $Y_{0} = (x_{0}, y_{0})$. Recordemos que la expresión (\ref{10}) es también la aproximación polinomial de primer grado de Taylor para $F_{1}$.

Podemos, entonces, reescribir el sistema (\ref{9}) como

\begin{align*}

u^{\prime} &= F_{1}(x_{0}, y_{0}) + \left[ \dfrac{\partial F_{1}}{\partial x}(x_{0}, y_{0}) \right]u + \left[ \dfrac{\partial F_{1}}{\partial y}(x_{0}, y_{0}) \right]v + \vartheta_{F_{1}} \\

v^{\prime} &= F_{2}(x_{0}, y_{0}) + \left[ \dfrac{\partial F_{2}}{\partial x}(x_{0}, y_{0}) \right]u + \left[ \dfrac{\partial F_{2}}{\partial y}(x_{0}, y_{0}) \right]v + \vartheta_{F_{2}} \label{11} \tag{11}

\end{align*}

Donde $\vartheta_{F_{1}}$ y $\vartheta_{F_{2}}$ son los términos que forman la diferencia entre el plano tangente y las funciones $F_{1}$ y $F_{2}$, respectivamente, y son precisamente los términos que deseamos ignorar al formar la aproximación lineal del sistema.

Como $Y_{0} = (x_{0}, y_{0})$ es un punto de equilibrio, entonces

$$F_{1}(x_{0}, y_{0}) = 0 \hspace{1cm} y \hspace{1cm} F_{2}(x_{0}, y_{0}) = 0$$

Así, las funciones (\ref{11}) se pueden aproximar como

\begin{align*}

u^{\prime} &\approx \left[ \dfrac{\partial F_{1}}{\partial x}(x_{0}, y_{0}) \right]u + \left[ \dfrac{\partial F_{1}}{\partial y}(x_{0}, y_{0}) \right]v \\

v^{\prime} &\approx \left[ \dfrac{\partial F_{2}}{\partial x}(x_{0}, y_{0}) \right]u + \left[ \dfrac{\partial F_{2}}{\partial y}(x_{0}, y_{0}) \right]v \label{12} \tag{12}

\end{align*}

Si usamos la notación matricial podemos escribir el sistema anterior como

$$\begin{pmatrix}

u^{\prime} \\ v^{\prime}

\end{pmatrix} \approx \begin{pmatrix}

\dfrac{\partial F_{1}}{\partial x}(x_{0}, y_{0}) & \dfrac{\partial F_{1}}{\partial y}(x_{0}, y_{0}) \\ \dfrac{\partial F_{2}}{\partial x}(x_{0}, y_{0})

& \dfrac{\partial F_{2}}{\partial y}(x_{0}, y_{0})

\end{pmatrix} \begin{pmatrix}

u \\ v

\end{pmatrix} \label{13} \tag{13}$$

La matriz de $2 \times 2$ de las derivadas parciales en esta expresión se llama matriz Jacobiana del sistema en $Y_{0} = (x_{0}, y_{0})$.

$$\mathbf{J}(x_{0}, y_{0}) = \begin{pmatrix}

\dfrac{\partial F_{1}}{\partial x}(x_{0}, y_{0}) & \dfrac{\partial F_{1}}{\partial y}(x_{0}, y_{0}) \\ \dfrac{\partial F_{2}}{\partial x}(x_{0}, y_{0})

& \dfrac{\partial F_{2}}{\partial y}(x_{0}, y_{0})

\end{pmatrix} \label{14} \tag{14}$$

Por lo tanto, el sistema linealizado en el punto de equilibrio $Y_{0} = (x_{0},y_{0})$ es

$$\begin{pmatrix}

u^{\prime} \\ v^{\prime}

\end{pmatrix} = \mathbf{J} \begin{pmatrix}

u \\ v

\end{pmatrix} \label{15} \tag{15}$$

Una observación importante de este proceso es que para crear el sistema linealizado sólo es necesario conocer las derivadas parciales de las componentes $F_{1}$ y $F_{2}$ del campo vectorial en el punto de equilibrio $Y_{0}$, no es necesario hacer el cambio de variable moviendo el punto de equilibrio al origen. Más adelante veremos ejemplos para mostrar este hecho.

Clasificación de los puntos de equilibrio

El método de linealización tiene como propósito usar un sistema lineal para predecir el comportamiento de las soluciones de un sistema no lineal cerca de un punto de equilibrio. En una vecindad de dicho punto, las soluciones de los sistemas lineales y no lineales están cercanas entre sí, por lo menos en un intervalo corto. Para la mayor parte de los sistemas, la información ganada al estudiar la linearización es suficiente para determinar el comportamiento a largo plazo de las soluciones del sistema no lineal cerca del punto de equilibrio.

Esta vez no seremos explícitos, pero es posible hacer una clasificación de los puntos de equilibrio en base a los valores propios de la matriz Jacobiana (\ref{14}).

Si todos los valores propios de $\mathbf{J}$ son números reales negativos o números complejos con parte real negativa, entonces $(u, v) = (0, 0)$ es un nodo atractor para el sistema lineal y todas las soluciones se acercan a $(u, v) = (0, 0)$ cuando $t \rightarrow \infty$. Para el sistema no lineal, las soluciones que empiezan cerca del punto de equilibrio $(x, y) = (x_{0}, y_{0})$ se acercan a éste cuando $t \rightarrow \infty$. Por tanto, decimos que $(x_{0}, y_{0})$ es un nodo atractor. Si los valores propios son complejos, entonces $(x_{0}, y_{0})$ es un foco estable.

De modo similar, si $\mathbf{J}$ sólo tiene valores propios positivos o complejos con parte real positiva, entonces las soluciones con condiciones iniciales cerca del punto de equilibrio $(x_{0}, y_{0})$ tienden a alejarse de éste cuando $t$ crece. Decimos entonces que para un sistema no lineal el punto $(x_{0}, y_{0})$ es una nodo repulsor. Si los valores propios son complejos, entonces $(x_{0}, y_{0})$ es un foco inestable.

Si $\mathbf{J}$ tiene un valor propio positivo y uno negativo, entonces el punto de equilibrio $(x_{0}, y_{0})$ es un punto silla.

Es importante mencionar que esta clasificación de los puntos de equilibrio para los sistemas no lineales no nos dice nada acerca del comportamiento de las soluciones con posiciones iniciales lejanas del punto de equilibrio $(x_{0}, y_{0})$.

Para concluir con esta entrada realicemos algunos ejemplos.

Ejemplo: Linealizar el siguiente sistema no lineal.

\begin{align*}

x^{\prime} &= x(2 -x -y) \\

y^{\prime} &= -x + 3y -2xy

\end{align*}

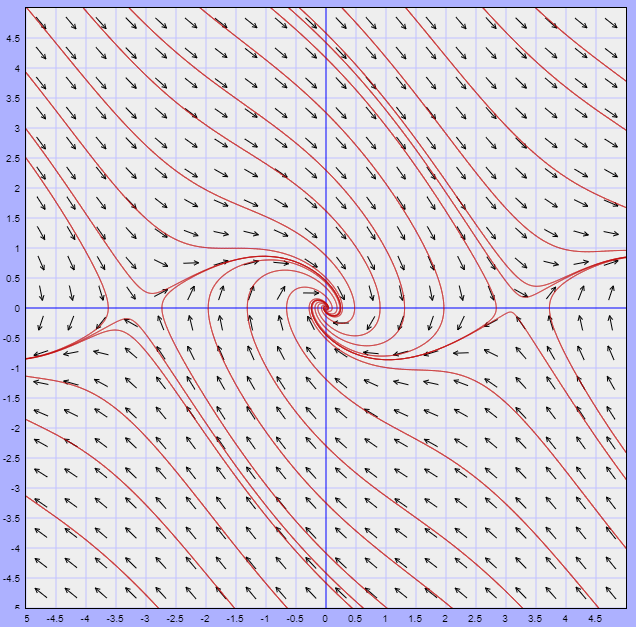

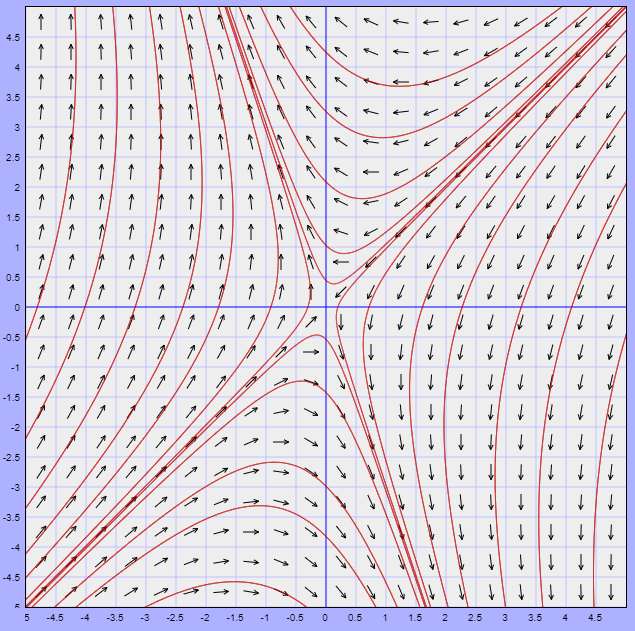

Solución: Comencemos por observar el plano fase de este sistema no lineal.

Nota: Cuando estudiamos las propiedades cualitativas de las trayectorias vimos que es posible esbozar el plano fase de un sistema no lineal si resolvemos la ecuación diferencial

$$\dfrac{dy}{dx} = \dfrac{F_{2}(x, y)}{F_{1}(x, y)} \label{16} \tag{16}$$

pero no siempre obtendremos una ecuación sencilla de resolver. En general, aún no sabemos cómo esbozar el plano fase de un sistema no lineal, lo ideal es que nosotros lo pudiéramos hacer a mano. Por ahora sólo nos estaremos apoyando de un programa que nos permite obtenerlo, más adelante veremos cómo esbozarlo no sólo cerca de los puntos de equilibrio.

Continuemos con el ejemplo. Del plano fase podemos observar que los puntos de equilibrio son

$$Y_{0} = (0, 0), \hspace{1cm} Y_{1} = (1, 1) \hspace{1cm} y \hspace{1cm} Y_{2} = (3, -1)$$

Veamos que es así analíticamente y linealicemos cada uno de ellos.

La función vectorial $F(x, y)$ que define al campo vectorial es

$$F(x, y) = (x(2 -x -y), -x + 3y -2xy)$$

Vemos que las funciones $F_{1}(x, y)$ y $F_{2}(x, y)$ son

\begin{align*}

F_{1}(x, y) &= x(2 -x -y) \\

F_{2}(x, y) &= -x + 3y -2xy

\end{align*}

No es necesario hacer algún tipo de cambio de variable, directamente podemos determinar la matriz Jacobiana para obtener una expresión similar a (\ref{15}). Calculemos las derivadas parciales de $F_{1}(x, y)$ y $F_{2}(x, y)$.

$$\dfrac{\partial F_{1}}{\partial x} = 2 -2x -y, \hspace{1cm} \dfrac{\partial F_{1}}{\partial y} = -x, \hspace{1cm} \dfrac{\partial F_{2}}{\partial x} = -1 -2y, \hspace{1cm} \dfrac{\partial F_{2}}{\partial y} = 3 -2x$$

Por lo tanto, la matriz Jacobiana es

$$\mathbf{J}(x, y) = \begin{pmatrix}

2 -2x -y & -x \\ -1 -2y & 3 -2x

\end{pmatrix}$$

Por otro lado, determinemos los puntos de equilibrio. Buscamos los valores de $x$ y $y$, tal que

$$F_{1}(x, y) = 0 \hspace{1cm} y \hspace{1cm} F_{2}(x, y) = 0$$

es decir,

\begin{align*}

x(2 -x -y) &= 0 \\

-x + 3y -2xy &= 0

\end{align*}

De la primer ecuación obtenemos que $x = 0$ y $2 -x -y = 0$, de este segundo resultado vemos que $x = 2 -y$, sustituyamos ambos valores en la segunda ecuación.

Para $x =0$ obtenemos $3y =0$, de donde $y =0$. Por lo tanto, el origen es un punto de equilibrio.

Para $x =2 -y$, tenemos

$$-(2 -y) + 3y -2(2 -y)y =y^{2} -1 = 0$$

De donde $y_{1} = 1$ y $y_{2} = -1$, sustituyendo ambas raíces en $x = 2 -y$, se tiene

\begin{align*}

x_{1} &= 2 -1 = 1 \\

x_{2} &= 2 -( -1) = 3

\end{align*}

Por lo tanto, los puntos de equilibrio son

$$Y_{0} = (0, 0), \hspace{1cm} Y_{1} = (1, 1) \hspace{1cm} y \hspace{1cm} Y_{2} = (3, -1)$$

tal como lo indica el plano fase.

Linealicemos el sistema, para ello evaluemos cada punto de equilibrio en la matriz Jacobiana.

$$\mathbf{J}(0, 0) = \begin{pmatrix}

2 & 0 \\ -1 & 3

\end{pmatrix}, \hspace{1cm} \mathbf{J}(1, 1) = \begin{pmatrix}

-1 & -1 \\ -3 & 1

\end{pmatrix}, \hspace{1cm} \mathbf{J}(3, -1) = \begin{pmatrix}

-3 & -3 \\ 1 & -3

\end{pmatrix}$$

Por lo tanto, alrededor del punto de equilibrio $Y_{0} = (0, 0)$ el sistema no lineal puede ser descrito por el sistema lineal

$$\mathbf{Y}^{\prime} = \begin{pmatrix}

2 & 0 \\ -1 & 3

\end{pmatrix}\mathbf{Y}$$

Alrededor del punto de equilibrio $Y_{0} = (1, 1)$ el sistema no lineal puede ser descrito por el sistema lineal

$$\mathbf{Y}^{\prime} = \begin{pmatrix}

-1 & -1 \\ -3 & 1

\end{pmatrix} \mathbf{Y}$$

Y finalmente el sistema no lineal, alrededor del punto de equilibrio $Y_{0} = (3, -1)$, puede ser descrito por el sistema lineal

$$\mathbf{Y}^{\prime} = \begin{pmatrix}

-3 & -3 \\ 1 & -3

\end{pmatrix} \mathbf{Y}$$

Por su puesto que se puede aplicar todo lo que sabemos sobre sistemas lineales, podemos determinar los valores propios y los vectores propios para obtener las soluciones generales, podemos también determinar la traza, el determinante, el discriminante y determinar la estabilidad de los puntos de equilibrio, etcétera.

Lo que estamos obteniendo es una descripción local del comportamiento de las soluciones del sistema no lineal alrededor de los puntos de equilibrio.

Una aclaración importante es que los planos fase de los sistemas lineales obtenidos están siendo graficados en el plano $UV$, es por ello que cada uno se encuentra centrado en el origen, en el origen de dicho plano.

$\square$

Finalicemos esta entrada con un ejemplo de especies en competencia.

Un modelo de especies en competencia

El sistema Volterra – Lotka es un conocido sistema para especies en competencia y es de la forma

\begin{align*}

x^{\prime} &= x(-Ax -By + C) \\

y^{\prime} &= y(-Dx -Ey + F) \label{17} \tag{17}

\end{align*}

donde $x$ y $y$ son mayores o igual a cero y los parámetros $A -F$ son siempre positivos.

Consideremos un ejemplo particular del sistema Volterra – Lotka. Sean $x$ y $y$ las poblaciones de dos especies que compiten por recursos, un incremento en cualquier especie tiene un efecto adverso sobre la razón de crecimiento de la otra. El modelo es el siguiente.

\begin{align*}

x^{\prime} &= 2x \left( 1 -\dfrac{x}{2} \right) -xy \\

y^{\prime} &= 3y \left( 1 -\dfrac{y}{3} \right) -2xy

\end{align*}

Para un valor dado de $x$, si $y$ se incrementa entonces el término $-xy$ ocasiona que $x^{\prime}$ decrezca. De forma similar, para un valor dado de $y$, si $x$ crece entonces $-2xy$ provoca que $y^{\prime}$ disminuya. Un aumento en la población de cualquiera de las especies ocasiona una disminución en la razón de crecimiento de la otra.

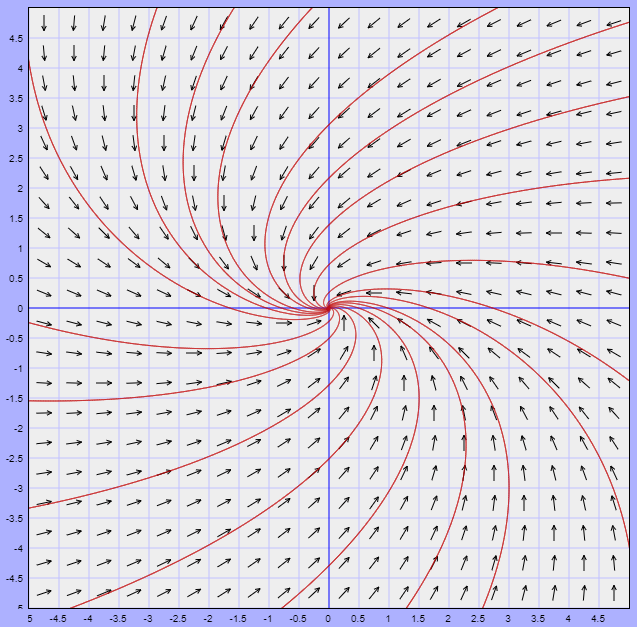

El plano fase del sistema no lineal es

Nota: El plano fase se ilustra para $x$ y $y$ en $\mathbb{R}$, sin embargo, recordemos que el sistema Volterra – Lotka sólo esta definido en el primer cuadrante en el que $x, y \geq 0$, esto debido a que no existen poblaciones negativas. Se puede observar que los cuatro puntos de equilibrio del sistema si pertenecen al primer cuadrante. Sólo consideraremos esta zona.

La funciones $F_{1}(x, y)$ y $F_{2}(x, y)$ son

\begin{align*}

F_{1}(x, y) &= 2x \left( 1 -\dfrac{x}{2} \right) -xy \\

F_{2}(x, y) &= 3y \left( 1 -\dfrac{y}{3} \right) -2xy

\end{align*}

Calculemos las derivadas parciales.

$$\dfrac{\partial F_{1}}{\partial x} = 2 -2x -y, \hspace{1cm} \dfrac{\partial F_{1}}{\partial y} = -x, \hspace{1cm} \dfrac{\partial F_{2}}{\partial x} = -2y, \hspace{1cm} \dfrac{\partial F_{2}}{\partial y} = 3 -2y -2x$$

Por lo tanto, la matriz Jacobiana es

$$\mathbf{J}(x, y) = \begin{pmatrix}

2 -2x -y & -x \\ -2y & 3 -2y -2x

\end{pmatrix}$$

Determinemos los puntos de equilibrio.

\begin{align*}

x(2 -x -y) &= 0 \\

y(3 -y-2x) &= 0

\end{align*}

La primer ecuación se satisface si $x = 0$ o si $2 -x -y = 0$, y la segunda se cumple si $y = 0$ o si $3 -y -2x = 0$.

Supongamos primero que $x = 0$. Entonces la ecuación $y = 0$ da un punto de equilibrio en el origen y $3 -y -2x = 0$ lo proporciona en $(0, 3)$.

Digamos ahora que $2 -x -y = 0$. Entonces la ecuación $y = 0$ da un punto de equilibrio en $(2, 0)$ y $3 -y -2x = 0$ lo da en $(1, 1)$.

Por lo tanto, los puntos de equilibrio son

$$Y_{0} = (0, 0), \hspace{1cm} Y_{1} = (0, 3), \hspace{1cm} Y_{2} = (2, 0) \hspace{1cm} y \hspace{1cm} Y_{3} = (1, 1)$$

Consideremos el punto de equilibrio $Y_{3} = (1,1)$, el cual nos indica que es posible para las dos especies coexistir en equilibrio (como las flores y las abejas que se ayudan a sobrevivir y prosperar mutuamente).

Linealizamos el sistema alrededor del punto de equilibrio $Y_{3} = (1, 1)$, para ello evaluemos en la matriz Jacobiana.

$$\mathbf{J}(1,1) = \begin{pmatrix}

-1 & -1 \\ -2 & -1

\end{pmatrix}$$

Por lo tanto, el sistema lineal que describe al sistema no lineal alrededor del punto de equilibrio $Y_{3} = (1, 1)$, es

$$\mathbf{Y}^{\prime} = \begin{pmatrix}

-1 & -1 \\ -2 & -1

\end{pmatrix}\mathbf{Y}$$

Los valores propios del sistema son

$$\lambda_{1} = -1 + \sqrt{2} \hspace{1cm} y \hspace{1cm} \lambda_{2} = -1 -\sqrt{2}$$

como uno es positivo y otro negativo concluimos que el punto de equilibrio es un punto silla. El plano fase del sistema lineal es

Sólo hay dos trayectorias que tienden hacia el punto de equilibrio $Y_{3} = (1, 1)$ cuando $t$ crece, de modo que bajo cualquier perturbación en las condiciones iniciales provocará que una especie domine sobre la otra, sin embargo, este modelo de especies es muy simplificado que no esperamos ver soluciones que conduzcan al punto de equilibrio $(1, 1)$ en la naturaleza.

De tarea moral linealiza el sistema para el resto de puntos de equilibrio.

$\square$

Ahora sabemos como estudiar las soluciones de un sistema no lineal alrededor de sus puntos de equilibrio, esto sólo nos dará información local, de manera que no es suficiente si lo que queremos es describir las soluciones para tiempos grandes. En la siguiente entrada veremos una técnica que nos permite describir las soluciones lejos de los puntos de equilibrio.

Tarea moral

Los siguientes ejercicios no forman parte de la evaluación del curso, pero servirán para entender mucho mejor los conceptos vistos en esta entrada, así como temas posteriores.

- Considerar los siguientes tres sistemas no lineales:

- $x^{\prime} = 2x + y$

$y^{\prime} = -y + x^{2}$

- $x^{\prime} = 2x + y$

$y^{\prime} = y + x^{2}$

- $x^{\prime} = 2x + y$

$y^{\prime} = -y -x^{2}$

Los tres sistemas tienen un punto de equilibrio en $(0,0)$. ¿Cuáles dos sistemas tienen planos fase similares cerca de $(0,0)$?. Justificar la respuesta.

- Considerar los siguientes tres sistemas no lineales:

- $x^{\prime} = 3 \sin(x) + y$

$y^{\prime} = 4x + \cos(y) -1$

- $x^{\prime} = -3 \sin(x) + y$

$y^{\prime} = 4x + \cos(y) -1$

- $x^{\prime} = -3 \sin(x) + y$

$y^{\prime} = 4x + 3 \cos(y) -3$

Los tres sistemas tienen un punto de equilibrio en $(0,0)$. ¿Cuáles son los dos sistemas que tienen planos fase similares cerca de $(0,0)$?. Justificar la respuesta.

- Dado el siguiente sistema no lineal:

$x^{\prime} = -2x + y$

$y^{\prime} = -y + x^{2}$

- Encontrar el sistema linealizado para el punto de equilibrio $(0, 0)$.

- Clasificar el punto de equilibrio.

- Esbozar el plano fase para el sistema no lineal cerca del origen $(0, 0)$.

- Repetir los puntos anteriores para el punto de equilibrio $(2, 4)$.

- Para el modelo de población de especies en competencia

$x^{\prime} = 2x \left( 1 -\dfrac{x}{2} \right) -xy$

$y^{\prime} = 3y \left( 1 -\dfrac{y}{3} \right) -2xy$

mostramos que el punto de equilibrio $(1, 1)$ es un punto silla.

- Encontrar el sistema linealizado cerca de cada uno de los otros puntos de equilibrio.

- Clasificar cada punto de equilibrio.

- Esbozar el plano fase de cada sistema linealizado.

- Dar una breve descripción del plano fase cerca de cada punto de equilibrio del sistema no lineal.

- Considerar el siguiente sistema no lineal:

$x^{\prime} = y -(x^{2} + y^{2})x$

$y^{\prime} = -x-(x^{2} + y^{2})y$

- Visualizar el plano fase del sistema.

- Determinar los puntos de equilibrio.

- Linealizar el sistema con respecto al punto de equilibrio $(0, 0)$.

- Visualizar el plano fase del sistema linealizado.

¿Los planos fase de ambos sistemas alrededor del punto de equilibrio $(0, 0)$ son similares?.

¿Qué puede estar sucediendo?.

Más adelante…

Una propiedad interesante del campo vectorial

$$F(x, y) = (F_{1}(x, y), F_{2}(x, y))$$

es que en un punto el vector $F$ puede ser totalmente vertical si la componente $F_{1}$ es cero, o bien puede ser totalmente horizontal se la componente $F_{2}$ es cero. Esta propiedad resultará sumamente útil a la hora de estudiar las trayectorias de un sistema no lineal lejos de un punto de equilibrio.

Al conjunto de puntos en los que alguna de las componentes de la función vectorial $F$ es cero se les denomina nulclinas.

Entradas relacionadas

- Página principal del curso: Ecuaciones Diferenciales I

- Entrada anterior del curso: El plano Traza – Determinante

- Siguiente entrada del curso: Las nulclinas en el estudio cualitativo de los sistemas no lineales

- Video relacionado al tema: Sistemas de ecuaciones no lineales. Linealización de puntos de equilibrio

Agradecimientos

Trabajo realizado con el apoyo del Programa UNAM-DGAPA-PAPIME PE104522 «Hacia una modalidad a distancia de la Licenciatura en Matemáticas de la FC-UNAM – Etapa 2»