Introducción

Hoy es la última clase del curso. Ha sido un semestre difícil para todas y todos. El quedarnos en casa, obligados a buscar alternativas digitales que sean de fácil acceso para la mayoría de las personas, aprender a realizar toda nuestra rutina diaria en un mismo espacio; sin dudarlo, un semestre lleno de retos que de una u otra manera, haciendo prueba y error, hemos aprendido a sobrellevar.

El día de hoy terminaremos con el tema de teoría espectral. Veremos algunos problemas donde usaremos las técnicas de búsqueda de eigenvalores y eigenvectores, así como aplicaciones de uno de los teoremas más importante: el Teorema Espectral.

Matrices simétricas, matrices diagonalizables

En entradas anteriores hemos discutido sobre qué condiciones me garantizan que una matriz $A$ es diagonalizable. No volveremos a repetir cuál es la definición de matriz diagonalizable ya que en múltiples ocasiones lo hicimos.

Sabemos que una matriz simétrica en $M_n(\mathbb{R})$ siempre es diagonalizable, gracias al teorema espectral, pero el siguiente problema nos ilustra que si cambiamos de campo $F$, no tenemos la garantía de que las matrices simétricas en $M_n(F)$ también lo sean.

Problema 1. Demuestra que la matriz simétrica con coeficientes complejos

$A=\begin{pmatrix} 1 & i \\ i & -1 \end{pmatrix}$

no es diagonalizable.

Solución. Por la primera proposición de la clase «Eigenvalores y eigenvectores de transformaciones y matrices», si $A$ fuese diagonalizable, es decir, que existe una matriz invertible $P$ y una diagonal $D$ tal que $A=P^{-1}DP$, entonces $A$ y $D$ tienen los mismos eigenvalores. Entonces, encontremos los eigenvalores de $A$: buscamos $\lambda \in \mathbb{C}$ tal que $\text{det}(\lambda I-A)=0$,

\begin{align*}

\text{det}(\lambda I-A)&=\begin{vmatrix} \lambda -1 & i \\ i & \lambda +1 \end{vmatrix} \\

&=(\lambda-1)(\lambda+1)-i^2=\lambda^2 -1+1 \\

&=\lambda^2=0.

\end{align*}

Por lo tanto, el eigenvalor con multiplicidad 2 de $A$ (y también el eigenvalor de $D$) es $\lambda =0$. Si $D$ es de la forma

$D=\begin{pmatrix} a & 0 \\ 0 & b \end{pmatrix}$,

es fácil ver (y calcular) que sus eigenvalores son $a$ y $b$, pero por lo anterior, podemos concluir que $a=b=0$, y por lo tanto $D$ es la matriz cero. Si fuese así, $A=P^{-1}DP=0$, contradiciendo la definición de $A$.

$\square$

Problema 2. Sea $A$ una matriz simétrica con entradas reales y supongamos que $A^k=I$ para algún entero positivo $k$. Prueba que $A^2=I$.

Solución. Dado que $A$ es simétrica y con entradas reales, todos sus eigenvalores son reales. Más aún son $k$-raíces de la unidad, entonces deben ser $\pm 1$. Esto implica que todos los eigenvalores de $A^2$ son iguales a 1. Dado que $A^2$ también es simétrica, es diagonalizable y, dado que sus eigenvalores son iguales a 1, por lo tanto $A^2=I$.

$\square$

Más propiedades de transformaciones lineales y bases ortogonales

En otras clases como Cálculo, Análisis, hablamos de funciones continuas, discontinuas, acotadas, divergentes; mientras que en este curso nos hemos enfocado únicamente en la propiedad de linealidad de las transformaciones. Si bien no es interés de este curso, podemos adelantar que, bajo ciertas condiciones del espacio $V$, podemos tener una equivalencia entre continuidad y acotamiento de una transformación.

Decimos que la norma de una transformación está definida como

$\norm{T}=\sup_{x\in V\setminus{0}} \frac{\norm{T(x)}}{\norm{x}}$.

Por ende, decimos que una transformación es acotada si su norma es acotada, $\norm{T}<\infty$.

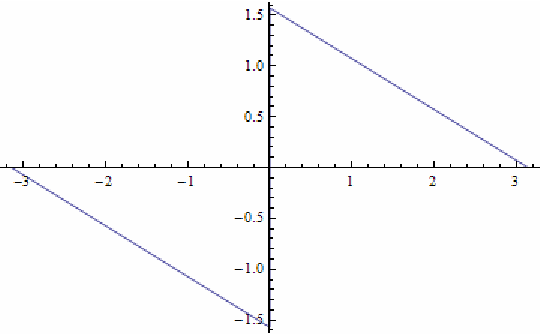

Problema 1. Sea $V$ un espacio euclideano y sea $T$ una transformación lineal simétrica en $V$. Sean $\lambda_1,\ldots,\lambda_n$ los eigenvalores de $T$. Prueba que

$\sup_{x\in V\setminus{0}} \frac{\norm{T(x)}}{\norm{x}} =\max_{1\leq i\leq n} |\lambda_i|.$

Solución. Renumerando a los eigenvalores, podemos decir que $\max_i |\lambda_i|=|\lambda_n|$. Sea $e_1,\ldots,e_n$ una base ortonormal de $V$ tal que $T(e_i)=\lambda_i e_i$ para todo $i$. Si $x\in V\setminus {0}$, podemos escribirlo como $x=x_1e_1+\ldots+x_n e_n$ para algunos reales $x_i$. Entonces, por linealidad de $T$,

$T(x)=\sum_{i=1}^n \lambda_i x_ie_i.$

Dado que $|\lambda_i|\leq |\lambda_n|$ para toda $i$, tenemos que

$\frac{\norm{T(x)}}{\norm{x}}=\sqrt{\frac{\sum_{i=1}^n \lambda_i^2 x_i^2}{\sum_{i=1}^n x_i^2}}\leq |\lambda_n|,$

por lo tanto

\begin{align*}

\max_{1\leq i\leq n} |\lambda_i|&=|\lambda_n|=\frac{\norm{T(e_n)}}{\norm{e_n}}\\

&\leq \sup_{x\in V\setminus{0}} \frac{\norm{T(x)}}{\norm{x}}\\

&\leq |\lambda_n|= \max_{1\leq i\leq n} |\lambda_i|.

\end{align*}

Obteniendo lo que queremos.

$\square$

Para finalizar, no olvidemos que una matriz es diagonalizable si y sólo si el espacio tiene una base de eigenvectores, y que está íntimamente relacionado con el teorema espectral.

Problema 2. Encuentra una base ortogonal consistente con los eigenvectores de la matriz

$A=\frac{1}{7}\begin{pmatrix} -2 & 6 & -3 \\ 6 & 3 & 2 \\ -3 & 2 & 6 \end{pmatrix}.$

Solución. Para encontrar los eigenvectores, primero encontrar los eigenvalores y, después, para cada eigenvalor, encontrar el/los eigenvectores correspondientes.

Calculemos:

\begin{align*}

0&=\text{det}(\lambda I-A)=\begin{vmatrix} \lambda+2/7 & -6/7 & 3/7 \\ -6/7 & \lambda-3/7 & -2/7 \\ 3/7 & -2/7 & \lambda-6/7 \end{vmatrix} \\

&= \lambda^3-\lambda^2-\lambda+1 \\

&= (\lambda -1)(\lambda^2 -1),

\end{align*}

entonces los eigenvalores de $A$ son $1,-1$, ($\lambda=1$ tiene multiplicidad 2).

Ahora, hay que encontrar los vectores $v=(x,y,z)$ tal que $Av=\lambda v$, para todo eigenvalor $\lambda$.

Si $\lambda=-1$,

$(\lambda I-A)v=\frac{1}{7}\begin{pmatrix} -5 & -6 & 3 \\ -6 & -10 & -2 \\ 3 & -2 & -13 \end{pmatrix}v=0, $

reduciendo, obtenemos que $v=(3\alpha, -2\alpha, \alpha)$ para todo $\alpha\in \mathbb{R}$.

Si $\lambda=1$, resolviendo de la misma manera $(\lambda I-A)v=(I-A)v=0$, tenemos que $v=(\beta,\gamma,-3\beta+2\gamma)$ para todo $\beta,\gamma$. Entonces el conjunto de eigenvectores es

$B=\{ v_1=(3,-2,1), \quad v_2=(1,0,-3), \quad v_3=(0,1,2) \}.$

Es fácil ver que el conjunto $B$ es linealmente independiente, más aún $\text{dim}(\mathbb{R}^3)=3=|B|$, por lo tanto, $B$ es la base consistente con los eigenvectores de $A$.

$\triangle$

Agradecemos su esfuerzo por llegar hasta el final a pesar de todas las adversidades. Esperamos pronto volver a ser sus profesores/ayudantes. Mucha suerte en la última parcial, es el último esfuerzo. Pero también les deseamos mucho éxito en su proyecto de vida. ¡Gracias!

Entradas relacionadas

- Ir a Álgebra Lineal I

- Entrada anterior del curso: Teorema espectral para matrices simétricas reales

Agradecimientos

Trabajo realizado con el apoyo del Programa UNAM-DGAPA-PAPIME PE104721 «Hacia una modalidad a distancia de la Licenciatura en Matemáticas de la FC-UNAM»